2. 材料领域知识工程北京市重点实验室(北京科技大学),北京 100083;

3. 北京科技大学 计算机与通信工程学院,北京 100083;

4. 北京科技大学 新材料技术研究院,北京 100083

2. Beijing Key Laboratory of Knowledge Engineering for Materials Science (University of Science and Technology Beijing), Beijing 100083, China;

3. School of Computer and Communication Engineering, University of Science and Technology Beijing, Beijing 100083, China;

4. Institute for Advanced Materials and Technology, University of Science and Technology Beijing, Beijing 100083, China

成分-工艺-组织结构-性能的构效关系是材料性能提升、质量控制和新材料研发的基础。近年来,机器学习在材料成分、工艺、性能等结构化数据的分析和挖掘中取得了明显的进展[1-3]。依赖于有效的特征提取能力,机器学习方法可挖掘出材料数据的显著特征,准确构建成分与性能间的相关关系,提升材料研发的效率[4]。材料的组织结构通常以非结构化图像数据的形式展现,例如,高分辨率透射电镜反映出材料的原子结构和分布,透射电镜和扫描电镜的形貌图像反映了材料位错、晶体、夹杂等缺陷和相结构特征等,金相照片反映了材料晶粒和相分布的特征[5-6]。但是,由于图像分析技术手段的限制,多年来材料图像数据在科学研究中的应用主要依赖于人工经验性的分析和信息提取,遗漏了大量的材料学信息和隐含的知识,缺乏科学定量的描述,成为构建材料本构关系的短板。

随着计算机运算能力的提高及人工智能理论和技术的发展,以深度学习(Deep Learning, DL)[7]为代表的机器学习方法取得了许多重要突破,在语音识别、自然语言处理、图像与视频分析、多媒体等诸多领域的应用中取得了巨大成功。尤其在图像处理与分析领域,深度学习快速推动了图像识别[8]、目标检测[9]和图像分割[10]等图像信息挖掘应用的发展,同时为光学字符识别[11]、人脸识别[12]、自动驾驶[13]、手势识别[14]等智能化产业带来了新的解决方案。

近年来,深度学习在材料显微图像分析中取得了明显进展,为材料学的研究提供了新的手段和技术,有效地弥补了材料传统研究手段的不足[15]。本文概述了材料图像处理与信息挖掘的主要研究内容和关键技术,综述了深度学习在材料显微图像识别、分割和生成等图像分析任务中的应用,探讨了深度学习方法在材料显微图像领域的挑战与对策。

1 深度学习发展与应用1973年,Rosenblatt提出了感知机(Perceptron)的概念,构建了人工神经网络(Artificial Neural Network, ANN)的理论原型[16]。Hinton于1986年提出梯度下降方法,使得网络模型在学习过程中可根据目标函数优化模型中的各项参数,最终驱使输出结果逐渐接近于目标值[17]。由此,人工神经网络初具雏形,随着网络层数的逐渐加深,以及网络结构的不断优化,其特征表达能力逐步提高,人工神经网络逐渐发展成为学习能力显著提高的深度神经网络[18]。欧盟拟计划在2020年26亿欧元预算的基础上每年追加10亿欧元用于支持人工智能“燃料”,并重点强调了卷积神经网络(Convolutional Neural Network, CNN)、循环神经网络(Recurrent Neural Network, RNN)和生成对抗网络(Generative Adversarial Network, GAN)在(人工)神经网络中的重要作用[19]。美国2021财政预算提案拟投入1 422亿美元联邦资金用于人工智能和量子计算,美国国防高级研究计划局拟投入4.59亿美元用于人工智能研发,分别比2020年提高6%和约12%[20-21]。此外,在材料显微图像分析应用中,以CNN和GAN为代表的深度神经网络应用较为广泛[22-23]。

LeCun于1989年提出卷积神经网路[24],通过在网络中引入卷积层和池化层,进而通过局部连接和权值共享的方式减少人工神经网络的参数量,使之可以高效地学习到图像中区域和区域间的相关关系,并成功应用到手写邮政编码的识别任务中。Hinton小组于2012年提出AlexNet[8]在超大型数据集ImageNet上将图像识别的Top-5错误率降低至16.4%,该成绩远远超过了传统方法。而后,大量的改进版本相继被提出,如VGG[25], GoogleNet[26], ResNet[18], DenseNet[27],截至2017年最后一届ImageNet图像识别竞赛,SENet[28]将图像识别的Top-5错误率降低至2.991%,已远低于人类水平5.1%。随后,各种改进版本依然不断迭代,模型的预测性能进一步提高。2015年,全卷积神经网络(Fully Convolutional Network, FCN)[29]将深度神经网络中的全连接层改为全卷积层,首次将深度神经网络引入图像分割领域,并将原本输入和输出间的图像-标签映射模式转变为图像-图像映射模式,显著扩大了卷积神经网络的应用范围。后续科研工作者将FCN及其变体用于图像去噪、增强、融合和修复等处理任务中,其性能均超过了传统的图像处理方法。

Goodfellow于2014年提出生成对抗网络[30],通过构建生成器和判别器进行相互博弈,即可在博弈过程中学习到数据的分布特征。生成器能够捕捉到真实数据样本的分布,进而生成新的数据样本。判别器为一个二分类器,判别生成数据与真实数据的相似程度。当前,生成对抗网络GAN在图像和视觉领域发展较为广泛[31],通过GAN可以生成逼真的人物头像、街道场景、艺术绘画和材料显微图像[32]。

2015年,深度学习的3位顶尖学者(LeCun, Bengio和Hinton)在Nature上联合撰文将深度学习方法定义为:把原始数据通过一些简单,但非线性的模型转变成为更高层次的,更加抽象表达的一种特征学习方法[7]。并且,由于在深度学习上的卓越贡献,LeCun, Bengio和Hinton 3位学者于2018年共同获得图灵奖。

由此可见,深度学习可包括任何以层级形式衔接的特征提取模型,如深度森林和深度神经网络等。鉴于深度神经网络性能较优且应用最为广泛,本文将深度学习特指深度神经网络。

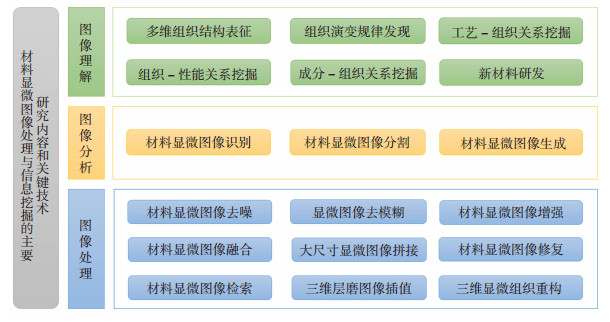

2 材料显微图像处理与信息挖掘的内涵材料显微图像的计算机处理和信息挖掘[33]通常分为图像处理、图像分析和图像理解3个层次[34],主要研究内容和关键技术如图 1所示。

|

图 1 材料显微图像处理与信息挖掘的主要研究内容和关键技术 Fig.1 Main research contents and key technologies of material microscopic image processing and information mining |

材料显微图像处理。指对材料显微图像进行像素级的局部处理,如去噪、去模糊、增强、融合(如采用多聚焦图像融合方法解决拍摄中材料表面高低不平造成模糊的问题[35])、拼接(提取图像的高维特征,辅助大尺寸显微图像拼接[36])、修复、检索、三维层磨图像插值和三维显微组织重构。

材料显微图像分析。指对材料显微图像整体或局部的处理,可根据像素之间的相关关系分析和提取组织图像中的材料学信息,包括材料显微图像识别、材料显微图像分割和材料显微图像生成。

材料显微图像理解。指在材料显微图像处理和分析基础上,对显微图像中蕴含的材料学信息进行分析和整合。如二维或三维组织结构表征、组织演变规律发现、成分-工艺-组织-性能关系的挖掘,最终依据获得的材料学规律辅助新材料设计。

近年来,由于深度学习在图像相关的各项任务中均展现出超越传统算法的优越性,为材料显微图像的自动化分析提供了新的解决方案。材料科研工作者开始尝试将深度学习应用到图 1所述的材料显微图像处理与信息挖掘的各项相关任务中。

而在所有研究任务中,材料显微图像识别、图像分割和图像生成等3种材料显微图像分析任务与材料学信息挖掘,以及材料显微图像理解具有紧密的联系,且已取得了富有成效的研究成果[22]。下文将针对材料显微图像分析任务中3种应用进行详细介绍。

3 深度学习在材料显微图像分析中的应用材料显微图像分析包括图像识别、分割和生成等任务。本章首先对图像识别、图像分割和图像生成3个容易混淆的应用展开对比说明,见图 2,然后对上述3个应用展开详细叙述。

|

图 2 图像识别、图像分割和图像生成任务示意 Fig.2 Schematic diagram of image recognition, image segmentation, and image generation tasks |

图像识别。该应用指向模型输入单张图像,模型对图像整体分析后,输出单个评估结果。该结果若为离散值,则模型执行分类任务,如判断该图像属于哪种合金组织。若该结果为连续值,则该模型执行回归任务,如预测该图像的宏观性能或成分组成。

图像分割。该应用指向模型输入单张图像,模型对图像每个区域分析后,输出每个像素的分类结果,该结果可进一步用于组织比例统计以及形状尺寸表征。图像分割和图像识别模型均可得到图像的相关信息,但图像分割得到的结果更为直观,有利于定量地表征微观组织结构特征。

图像生成。该应用指向模型输入材料学信息(参数、语义图、线段图等),模型生成与该材料学信息相关的合成图像。生成的图像可以作为数据增广策略扩充现有的材料显微图像数据,进而在训练过程中提高深度学习算法的泛化能力。

3.1 材料显微图像识别随着深度学习在自然场景图像识别任务中取得了突破进展,材料科研人员尝试将传统由人类专家人工主观对图像识别的任务交给深度学习进行处理,旨在用深度学习自动提取图像中可用于显微组织识别的强有效特征,进而消除人工识别的不确定性,有效、快速且自动地对材料显微图像进行识别。

Adachi等首先将卷积神经网络引入钢的微观结构识别任务中,实验证明该方法具有极高的识别鲁棒性[37]。Yamamoto提出一种神经网络GCNN,可对每一种测试材料的形成能、单位晶胞体积、带隙、总磁化率等特征进行预测,进而使用上述特征对金属-绝缘体和非磁性-磁性体进行二元分类[38]。Ruelas等使用人工神经网络识别高温条件下导体材料的不同物理状态(如球化、脱碳还是石墨化)。实验表明,所提出的识别算法与人类专家相比获得了96.83%的准确率,且效率更高[39]。Wang等通过实验证明深度卷积神经网络对X射线散射图像进行分类的准确率超过人工识别结果[40]。

上述方法直接向深度学习模型输入图像,并训练深度学习模型输出图像识别结果。由于深度学习的强有效特征提取能力,该方法已成功应用于多种材料识别任务中,并取得有成效的效果。但由于深度学习的黑盒特性,科研人员尚不能通过简单的数学公式表征深度学习所识别的特征,对特征理解与优化提出了挑战。

3.2 材料显微图像分割随着深度学习在自然场景图像分割任务中取得的突破,Ronneberger于2015年提出了U-Net网络, 并成功用于电子显微镜下生物细胞图像的分割,取得了当年ISBI细胞识别竞赛的冠军[41]。经过在不同数据集上的重复性实验,Falk等于2019年在Nature子刊发表文章,称U-Net被证明在生物医学和材料科学领域的图像处理任务中具有极强的鲁棒性[42]。

在材料显微图像分析应用中,相对于图像识别任务,对材料显微组织进行像素级别的图像分割,可定量地对图像中不同相的组成进行统计和分析,进而为宏微观内禀关系分析提供数据支撑。因此,图像分割模型在材料显微图像分析中得到了较为广泛的应用。

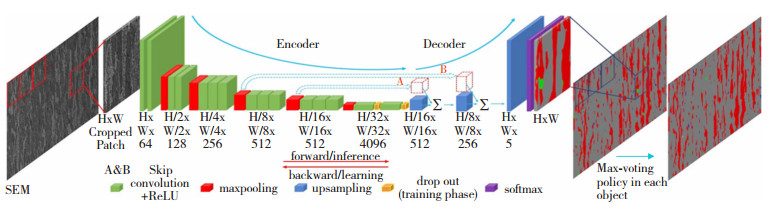

Azimi等首先对FCN深入研究并结合材料组织的特性,将FCN与最大表决法相结合,提出了一种新型的针对材料显微组织的分割算法MVFCNN[15],与当时最先进的材料显微组织分割技术相比,将精确度从48.89%提高到93.94%,取得了显著的进步,其示意图如图 3所示。Decost等提出一种深度卷积神经网络,可以实现复杂微观结构的分割,能够从含有多种微观成分的复杂的微观图中获得水灰石粒度和变质区宽度的分布[43]。Li等结合卷积神经网络和图像局部分析方法开发了一套适用于不同对比度、亮度和磁化的组织图像中缺陷的自动检测工具[44]。Maksov等提出了基于深度学习的动态STEM成像分析模型,可在几秒内从原始的STEM数据中提取出数千个晶格缺陷[45]。

在此基础上,部分科研工作者通过深入分析材料显微图像数据的特殊性,对深度学习的各个组件进行修正,并取得了富有成效的研究成果。Boyuan等采用一种基于对称重叠平铺策略的局部处理方法,使深度学习方法在推理过程摈弃对高显存机器的依赖,进而使得卷积神经网络能够对大尺寸显微图像进行分析[22]。Boyuan等针对纯铁多晶粒组织图像分割任务中的不平衡分割问题, 提出了一种基于自适应边缘加权的损失函数,该损失函数提高了深度网络对于边界提取的准确度[46]。

上述图像分割模型采用基于监督学习的深度学习方法,在显微图像材料学信息提取任务中取得了优异的性能。但由于监督学习方法需要大量标注数据进行训练,阻碍了该方法的广泛应用。

3.3 材料显微图像生成由于实验数据采集时间长、难度大以及计算精度低等问题,在材料科学研究中,尤其是新材料研发中,仍然面临着缺乏高质量数据的困境。在实际应用中,也缺乏具有像素级别标注的大数据集来训练图像分割等材料学信息提取任务。

伴随着GAN的出现,图像生成模型在性能上得到了质的飞越。材料科研工作者开始尝试用GAN来缓解缺乏数据的困境。材料显微图像生成主要有两种应用。

1) 作为数据增广策略增加模型所需的训练数据。针对图像分割任务所需训练数据不足的问题,Boyuan等提出一种基于风格迁移的数据增广方法,技术路线如图 4(a)所示[47],将真实实验图像(图 4(b))的风格迁移到蒙特卡洛模型生成的模拟图像(图 4(c))中获得合成图像(图 4(d)),该方法通过结合材料计算模型数据生成速度快的特点,能在极短时间内生成大量合成图像,该合成图像的晶粒尺寸分布与原图相同,表观纹理特征与原图相似,可作为数据增广辅助图像分割任务。在仅有少量数据的前提下,在图像分割任务上,增广方式提高近8%的性能,解决了数据量不足的问题。

|

图 4 数据增广示意图[47] Fig.4 The demonstration of data augmentation[47]: (a) the flow chart; (b) real images produced by experiment; (c) simulated images generated by Monte Carlo model; (d) synthetic images generated by style transfer model |

2) 填补因实验复杂造成的数据缺失。Luo等提出了一种基于先验知识和注意力机制的生成对抗性模型,以实现材料辐照图像的生成和相应的工业性能预测模型的构建。通过提出的模型,研究人员可以跳过危险复杂的辐照实验,只需输入一些实验参数即可直接获得辐照图像和工业性能参数[23]。

4 深度学习在材料显微图像分析中的挑战 4.1 面向材料显微图像识别的特征可解释性分析当前,深度学习技术大多属于黑盒方法,该方法采用非线性映射将数据映射到高维特征空间,并在该空间内寻找问题对应的最优解。虽然该方法在与任务相关的性能上取得优异的效果,但这样的黑盒方法难以被科研人员理解。

具体地,传统数据挖掘模型可通过具有可解释性的数学公式展现材料成分与相应特性间的关系,而在图像分析任务中,传统图像处理算法也可通过数学表征的方法解释算法执行原理。虽然深度学习方法在处理性能上优于传统图像处理方法,但缺乏可解释性的黑盒模型, 为模型优化和机理解释带来了困难。尤其在材料显微图像识别任务中,目前科研人员无法了解深度学习究竟提取了怎样的结构特征,以对图像中的材料学信息进行精准的识别。

因此,如何构建具有可解释性的材料图像特征提取模型是当前的研究难点。

4.2 面向材料显微图像分割的小样本数据高效分析问题在基于深度学习的人工智能领域中,数据的数量和数据的质量决定着模型性能的上限。相较于自然图像数据,由于材料组织的不透明性造成图像获取过程复杂繁琐,需经过抛光、侵蚀、研磨、拍摄等工序的反复操作才可获得小批量数据。并且,当前多数深度学习算法属于有监督学习方法,尤其针对图像分割任务,需耗费大量人工对图像数据进行标注供模型进行训练,提高了算法应用的数据成本。因此,在大多数材料图像分析任务中仅能获得小样本数据,如何有效利用迁移学习、半监督学习、自监督学习和无监督学习等手段,提高模型在小样本数据情况下的特征提取能力是今后研究的重点。

4.3 面向材料显微图像分割的三维或四维精准高效重构问题在材料研究领域中,研究人员通常采用系列截面法获得材料组织的多层截面,并从截面中构建材料的三维结构。当前,基于深度学习的图像特征提取技术在二维图像数据分析中取得了初步成果。但是,由于深度卷积网络模型常具有极高的空间复杂度,在有限的硬件资源前提下难以直接对大尺寸三维数据进行分析和处理,如何有效利用材料截面的三维信息,对大尺寸三维材料显微组织精准且高效的分析是研究难点。同时,材料显微组织在外力作用下会产生一定的蠕变,如高温合金在不同压力和温度下将发生微观组织演变,从而影响合金的使用寿命。因此,如何设计复杂且有效的图像分析方法对四维组织图像数据进行分析和建模是未来的研究挑战。

4.4 面向材料显微图像生成的材料学信息一致性约束基于GAN的图像生成方法可生成与目标材料显微图像表观相似的图像。但目前深度学习网络模型无法对生成图像中蕴含的材料学信息进行约束,如何引入这样的信息确保生成图像符合材料基本特性,如尺寸分布和形状分布等是下一步研究的重要方向。

5 总结与展望基于深度学习的图像分析方法可通过深度网络强有效的特征提取能力,提取图像中对于目标任务的显著性特征,该方法在材料显微图像分析的各个应用中取得了一定进展。本文将与材料显微图像相关的研究任务分为图像处理、图像分析和图像理解3个层次,并对图像分析中与材料学信息提取密切相关的图像识别、图像分割和图像生成等3个应用展开了详细介绍:1)材料显微图像识别,如使用卷积神经网络对低碳钢的微观结构的识别;2)材料显微图像分割,该应用可对材料显微图像进行像素级别的分割,在此基础上可进一步提取图像中物相组成,并对组织进行形状尺寸表征;3)材料显微图像生成,由于材料显微图像的采集和标注过程耗费大量人力和时间,使用深度学习的生成模型,即可生成对应的材料显微图像并作为数据增广策略辅助模型训练,给材料科学的研究带来了新的思路。

由于材料显微图像数据的复杂性,深度学习在材料显微图像分析领域还存在众多挑战。例如特征可解释性分析问题、小样本数据高效分析问题、大尺寸材料显微组织三维或四维精准高效重构及全信息表征问题,以及材料显微图像生成中材料学信息一致性约束问题等。这些问题已成为材料科学下一步研究中的难点与热点。

本文仅对深度学习在材料显微图像分析的应用展开综述,而在图像处理和图像理解的任务中深度学习也展示了相较于传统方法的优越性,在未来的研究中,将会有更多的深度学习方法应用于材料显微图像处理、分析和理解的相关任务中。

| [1] |

BUTLER K T, DAVIES D W, CARTWRIGHT H, et al. Machine learning for molecular and materials science[J]. Nature, 2018, 559(7715): 547-555. DOI:10.1038/s41586-018-0337-2 |

| [2] |

RAMPRASAD R, BATRA R, PILANIA G, et al. Machine learning in materials informatics: Recent applications and prospects[J]. NPJ Computational Materials, 2017, 3: 54. DOI:10.1038/s41524-017-0056-5 |

| [3] |

LOOKMAN T, ALEXANDER F, RAJAN K. Information science for materials discovery and design[M]. Switzerland: Springer International Publishing, 2016.

|

| [4] |

WANG Changsheng, FU Huadong, JIANG Lei, et al. A property-oriented design strategy for high performance copper alloys via machine learning[J]. NJP Computational Materials, 2019, 5(1): 1-8. DOI:10.1038/s41524-019-0227-7 |

| [5] |

HU J, SHI Y N, SAUVAGE X. Grain boundary stability governs hardening and softening in extremely fine nanograined metals[J]. Science, 2017, 355: 1292-1296. DOI:10.1126/science.aal5166 |

| [6] |

RAJAN K. Materials informatics: The materials "gene" and big data[J]. Annual Review of Materials Research, 2015, 45: 153-169. DOI:10.1146/annurev-matsci-070214-021132 |

| [7] |

LECUN Y, BENGIO Y, HINTON G. Deep learning[J]. Nature, 2015, 521(7553): 436-444. DOI:10.1038/nature14539 |

| [8] |

KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks[C]//Proceedings of Advances in Neural Information Processing Systems.[S.l.]: Neural Information Processing Systems Foundation, Inc., 2012: 1097-1105.

|

| [9] |

HE K, GKIOXARI G, DOLLÁR P, et al. Mask R-CNN[C]//Proceedings of 2017 IEEE International Conference on Computer Vision. Piscataway, NJ: IEEE, 2017: 2980-2988. DOI: 10.1109/ICCV.2017.322

|

| [10] |

CHEN L, PAPANDREOU G, KOKKINOS I, et al. DeepLab: Semantic image segmentation with Deep Convolutional Nets, atrous convolution, and fully connected CRFs[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40(4): 834-848. DOI:10.1109/TPAMI.2017.2699184 |

| [11] |

冯海.基于深度学习的中文OCR算法与系统实现[D].深圳: 中国科学院大学(中国科学院深圳先进技术研究院), 2019. FENG Hai. Chinese OCR algorithm and system implementation based on deep learning[D]. Shenzhen: Institutes of Advanced Technology, Chinese Academy of Sciences, 2019. DOI: 10.27822/d.cnki.gszxj.2019.000014 |

| [12] |

刘小沣.基于深度学习的人脸图像识别技术的研究[D].长春: 中国科学院大学(中国科学院长春光学精密机械与物理研究所), 2019. LIU Xiaofeng. Research on the technology of deep learning based face image recognition[D]. Changchun: Changchun Institute of Optics, Fine Mechanics and Physics, Chinese Academy of Sciences, 2019. |

| [13] |

陈宇鹏.基于深度学习的自动驾驶单目视觉目标识别技术研究[D].长春: 吉林大学, 2019. CHEN Yupeng. Research based on deep learning for autonomous driving monocular vision object detection technology[D]. Changchun: Jilin University, 2019. |

| [14] |

王苏振.基于深度学习的手势识别技术研究[D].杭州: 浙江大学, 2019. WANG Suzhen. Research on gesture recognition technology based on deep learning[D]. Hangzhou: Zhejiang University, 2019. |

| [15] |

AZIMI S M, BRITZ D, ENGSTLER M, et al. Advanced steel microstructural classification by deep learning methods[J]. Scientific Reports, 2018, 8(1): 1-14. DOI:10.1038/s41598-018-20037-5 |

| [16] |

ROSENBLATT F. The perceptron: A probabilistic model for information storage and organization in the brain[J]. Psychological Review, 1958, 65(6): 386. DOI:10.1037/h0042519 |

| [17] |

RUMELHART D E, HINTON G E, WILLIAMS R J. Learning representations by back-propagating errors[J]. Nature, 1986, 323(6088): 533-536. DOI:10.1038/323533a0 |

| [18] |

HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2016: 770-778. DOI: 10.1109/CVPR.2016.90

|

| [19] |

European Union Aviation Safety Agency. EASA artificial intelligence roadmap——A human-centric approach to AI in aviation[EB/OL]. (2020-07-02). https://www.easa.europa.eu/document-library/general-publications/easa-artificial-intelligence-roadmap-10.

|

| [20] |

The White House, National Quantum Coordination Office. A strategic vision for American's quantum networks[EB/OL]. (2020-02-12). https://quantumcomputingreport.com/white-house-national-quantum-coordination-office-releases-a-strategic-vision-for-americas-quantum-networks/.

|

| [21] |

The White House. President Trump's FY 2021 budget commits to double investments in key industries of the future[EB/OL]. (2020-02-11). https://www.whitehouse.gov/briefings-statements/president-trumps-fy-2021-budget-commits-double-investments-key-industries-future/.

|

| [22] |

MA Boyuan, BAN Xiaojuan, HUANG Haiyou, et al. Deep learning-based image segmentation for Al-La alloy microscopic images[J]. Symmetry, 2018, 10(4): 107-120. DOI:10.3390/sym10040107 |

| [23] |

LUO M C, LIU L. Generative model for material irradiation experiments based on prior knowledge and attention mechanism[J]. NIPS2018 MMLM Workshop, 2018. |

| [24] |

LECUN Y, BOSER B, DENKER J S, et al. Backpropagation applied to handwritten zip code recognition[J]. Neural Computation, 1989, 1(4): 541-551. DOI:10.1162/neco.1989.1.4.541 |

| [25] |

SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[R]. arXiv: 1409.1556, 2014.

|

| [26] |

SZEGEDY C, LIU W, JIA Y, et al. Going deeper with convolutions[C]//Proceedings of 2015 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2015: 1-9. DOI: 10.1109/CVPR.2015.7298594

|

| [27] |

HUANG G, LIU Z, VAN DER MAATEN L, et al. Densely connected convolutional networks[C]// Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2017: 4700-4708. DOI: 10.1109/CVPR.2017.243

|

| [28] |

HU J, SHEN L, SUN G. Squeeze-and-excitation networks[C]//Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Piscataway, NJ: IEEE, 2018: 7132-7141. DOI: 10.1109/CVPR.2018.00745

|

| [29] |

SHELHAMER E, LONG J, DARRELL T, et al. Fully convolutional networks for semantic segmentation[C] // Proceedings of IEEE Transactions on Pattern Analysis and Machine Intelligence. Piscataway, NJ: IEEE, 2017, 39(4): 640-651. DOI: 10.1109/TPAMI.2016.2572683

|

| [30] |

GOODFELLOW I, POUGET-ABADIE J, MIRZA M, et al. Generative adversarial nets[C]//Proceedings of the 27th International Conference on Neural Information Processing Systems. Montreal: [s.n.], 2014: 2672-2680.

|

| [31] |

王坤峰, 苟超, 段艳杰, 等. 生成式对抗网络GAN的研究进展与展望[J]. 自动化学报, 2017, 43(3): 321-332. WANG Kunfeng, GOU Chao, DUAN Yanjie, et al. Generative adversarial networks: The state of the art and beyond[J]. Acta Automatica Sinica, 2017, 43(3): 321-332. DOI:10.16383/j.aas.2017.y000003 |

| [32] |

KARRAS T, LAINE S, AILA T. A style-based generator architecture for generative adversarial networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2019: 4401-4410. DOI: 10.1109/CVPR.2019.00453

|

| [33] |

宋晓艳. 体视学, 图像分析与计算材料学之间的关系及进展[J]. 中国体视学与图像分析, 2008, 13(4): 280-285. SONG Xiaoyan. Progress on the multi-disciplinary relationship of stereology, image analysis and computational materials science[J]. Chinese Journal of Stereology and Image Analysis, 2008, 13(4): 280-285. DOI:10.13505/j.1007-1482.2008.04.005 |

| [34] |

章毓晋. 图像工程[M]. 第四版. 北京: 清华大学出版社, 2019. ZHANG Yujin. Image engineering[M]. 4th ed. Beijing: Tsinghua University Press, 2019. |

| [35] |

北京科技大学.一种基于视频清晰度融合的大尺寸显微图像生成方法: CN201810432523.1[P].2018-10-04. University of Science & Technology Beijing. A kind of large scale micro-image generation method based on video definition fusion: CN201810432523.1[P]. 2018-10-04. |

| [36] |

MA Boyuan, BAN Xiaojuan, HUANG Haiyou, et al. A fast algorithm for material image sequential stitching[J]. Computational Materials Science, 2019, 158: 1-13. DOI:10.1016/j.commatsci.2018.10.044 |

| [37] |

YOSHITAKA A, MOTOKI T, SHOGO H. Microstructure recognition by deep learning[J]. Tetsu-to-Hagane, 2016, 102(12): 722-729. DOI:10.2355/tetsutohagane.TETSU-2016-035 |

| [38] |

YAMAMOTO T. Crystal graph neural networks for data mining in materials science[R]. Yokohama, Japan: RIMCS LLC, 2019.

|

| [39] |

RUELAS-SANTOYO E A, VÁZQUEZ-LÓPEZ J A, YAÑEZ-MENDIOLA J, et al. System for the recognition of wear patterns on microstructures of carbon steels using a multilayer perceptron[J]. Ingeniería e Investigación, 2018, 38(1): 113-120. DOI:10.15446/ing.investig.v25n2.60265 |

| [40] |

WANG B, YAGER K, YU D, et al. X-ray scattering image classification using deep learning[C]// Proceedings of 2017 IEEE Winter Conference on Applications of Computer Vision (WACV). Piscataway, NJ: IEEE, 2017: 697-704.

|

| [41] |

RONNEBERGER O, FISCHER P, BROX T. U-net: Convolutional networks for biomedical image segmentation[C]//Proceedings of International Conference on Medical Image Computing and Computer-Assisted Intervention. Cham: Springer, 2015: 234-241. DOI: 10.1007/978-3-319-24574-4_28

|

| [42] |

FALK T, MAI D, BENSCH R, et al. U-Net: deep learning for cell counting, detection, and morphometry[J]. Nature Methods, 2019, 16(1): 67-70. DOI:10.1038/s41592-018-0261-2 |

| [43] |

DECOST B L, LEI B, FRANCIS T, et al. High throughput quantitative metallography for complex microstructures using deep learning: A case study in ultrahigh carbon steel[J]. Microscopy and Microanalysis, 2019, 25(1): 21-29. DOI:10.1017/S1431927618015635 |

| [44] |

LI W, FIELD K G, MORGAN D. Automated defect analysis in electron microscopic images[J]. NPJ Computational Materials, 2018, 4(1): 1-9. DOI:10.1038/s41524-018-0093-8 |

| [45] |

MAKSOV A, DYCK O, WANG K, et al. Deep learning analysis of defect and phase evolution during electron beam-induced transformations in WS2[J]. NPJ Computational Materials, 2019, 5(1): 1-8. DOI:10.1038/s41524-018-0138-z |

| [46] |

MA Boyuan, LIU Chuni, BAN Xiaojuan, et al. WPU-Net: Boundary learning by using weighted propagation in convolution network[R]. arXiv: 1905.09226, 2019.

|

| [47] |

MA Boyuan, WEI Xiaoyan, LIU Chuni, et al. Data augmentation in microscopic images for material data mining[R]. arXiv: 1905.04711, 2019.

|

2020, Vol. 28

2020, Vol. 28