随着航天技术的发展,世界上越来越多的国家开展空间目标监视系统任务.空间目标监视系统的任务是对重要空间目标进行精确探测和跟踪,确定可能对航天系统构成威胁的目标的任务、尺寸、形状和轨道参数等重要目标特性[1].美国是目前空间监视能力最强的国家,欧盟、日本等国也在发展独立的空间目标监视系统,我国的空间目标监视系统研究发轫于航天事业的迅猛进展之中[2],正在逐步走向前沿.由于光学成像目标探测技术的普适性优势,基于光学成像系统的目标检测和分割成为空间目标监视系统的关键技术.本文空间运动目标为中低轨道卫星、飞船等目标,这些卫星和飞船在轨飞行时,遇太阳光照射,光学敏感器采集到的图像含有少量云层等背景信息.因此,在未知任何先验信息的条件下,如何精确检测和分割云层背景下空间运动目标具有重要意义.

常用的运动目标检测方法一般都是基于序列图像的运动目标检测,主要有帧差法[3]、背景建模法[4]、光流法[5-6]等.帧差法和背景建模法在摄像机固定情况下运动目标检测具有较好的效果,但是对摄像机运动情况下的目标检测,处理效果不太理想.光流法作为重要的二维运动估计技术,不但能够有效的估计出图像中目标运动的大小和方向信息,而且对场景运动的情况具有较好的鲁棒性.另外一类目标检测主要是采用监督分类方法进行目标检测,其中最具有代表性的方法是基于滑动窗口[7]的目标检测方法.但其需要提前采集样本进行训练,由于空间目标形状、大小和位置信息一般是未知的,在轨运行航天器很难采集到样本进行训练.人类视觉注意能力是人类视觉的一种重要的心理调节机制,选择性注意是其最基本的特征之一,具有选择部分视觉信息,去除或者忽略其他不相关的信息,以满足大脑对有限时间内信息处理能力的需求.随着计算机科学和认知科学的交叉发展,快速的、下意识的、自地向上、数据驱动的视觉显著性检测方法[8]得到广泛关注.

为了提高空间动态背景下运动目标检测和分割的精度,本文通过梯度信息和频率调谐滤波的互补方式分别计算整幅图像和mean shift分割后各个分块区域的显著性,进而以整幅图像显著性均值为参考,确定合理的阈值检测候选目标,与此相并行,也利用光流计算及相应的阈值检测方法获取候选目标,进而通过对显著性计算所得到的候选目标分布图与光流计算所得候选目标分布图的合取运算进行目标确认,最后再辅之以形态学增强处理进行目标增强,从而实现空间运动目标的高精度检测和分割.

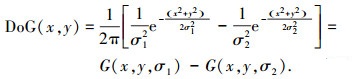

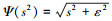

1 基于显著性计算的mean shift自适应目标检测与分割 1.1 基于梯度信息和频率调谐的显著性计算视觉显著性计算从揭示人类视觉感知机制出发,对人类视觉注意能力进行建模和量化计算,从而形成了一系列表征图像区域显著性的模型化分析与计算方法[9].显著性计算在揭示视觉注意机制的同时,在目标检测与分割、图像分析与理解、场景分析、以及视频跟踪等方面都得到了成功的应用[10-11].受显著性认知计算原理的启发,Achanta等提出了一种简单有效的频率调谐显著区域检测(frequency-tuned salient region detection)算法[8],其通过高斯差分(difference of gaussian, DoG)带通滤波来确定中心-外周对比度.当标准差的比率为1:1.6[12]时,与高斯-拉普拉斯滤波相比,高斯差分带通滤波能更好地检测图像亮度变化,因此被广泛应用于图像增强、边缘检测中.一般而言,DoG滤波可由两个高斯函数构成,方程式为

|

(1) |

其中标准差参数σ1和σ2可调,可根据实际需要进行调节和设置,从而得以保留有效的空间频率信息,并去除高频噪声等因素的影响.当高斯函数的幅值较小时,则可近似为二项式滤波.为了计算简单,选取5×5的二项式移动窗口进行带通滤波,其核函数的系数应为{1, 4, 6, 4, 1}/16.然而,很显然,这种带通滤波式频率调谐显著性区域检测,在采用DoG滤波去除高频噪声信息的同时也会伤损边缘信息,对目标检测和分割的精度造成影响.因此,本文在频率调谐的显著性计算的基础上,引入了梯度信息进行互补增强,提出了梯度信息与频率调谐的互补增强式显著性计算方法,具体算式为

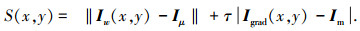

|

(2) |

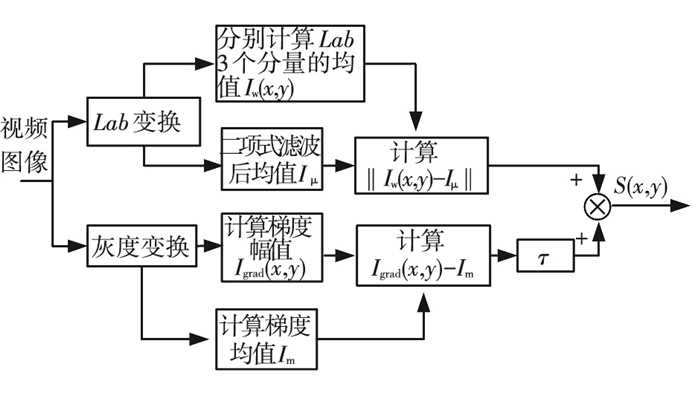

此算式有两部分组成,频率调谐的算法只有第一部分,其中Iμ=[Lμ aμ bμ]T为图像在Lab彩色空间中均值向量,Iw(x, y)=[Lw aw bw]T是图像在Lab空间中经二项式滤波后的Lab向量,通过二者之差的L2范数计算(x, y)坐标处的显著性;式(2)中的第2项是本文为了克服边缘信息受损所造成的影响,而融入的梯度信息的显著性计算,其中Igrad(x, y)为图像的亮度梯度,Im为整个图像的亮度梯度均值.互补增强的效果可通过权重参数τ进行调节,针对空间视频图像目标检测的实验结果表明,τ在[20, 40]取值时,互补效果显著,可取得满意检测效果.具体算法流程如图 1所示.

|

图 1 梯度信息与频率调谐互补增强式显著性计算流程 |

首先将输入的视频图像分别转换为Lab彩色图像和灰度图像,然后分别计算其显著性,进而通过对二者的加权融合以得到互补增强的显著性信息S(x, y).

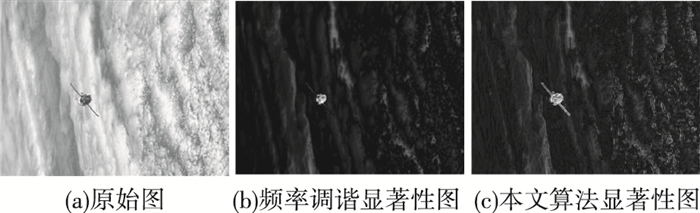

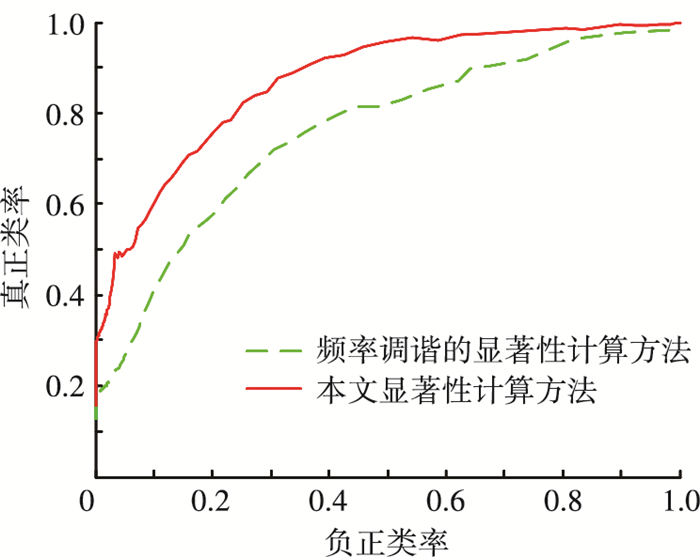

本文提出融合梯度信息的互补增强式显著性计算和频率调谐的显著性计算结果比较如图 2所示. 图 2(b)、2(c)中亮度值越大,表明该区域越显著.由此可见图 2(b)中卫星中心显著性较高,卫星两边的帆板显著性较低,采用频率调谐的显著性区域检测仅能分割出目标的中心区域.而图 2(c)采用基于梯度信息和频率调谐的显著性计算,卫星整体都被确定为显著性区域,同时背景区域的边缘显著性也有显著提高.对于显著性计算生成的显著性图,采用受试者工作特性(receiver operating characteristic,ROC)曲线来评价其准确性. 图 3给出了本文提出的显著性计算方法和频率调谐的显著性计算方法ROC曲线.本文显著性计算方法ROC曲线下方所围的面积为0.870 4,频率调谐的显著性计算方法ROC曲线下方所围的面积为0.838 2.可见,梯度信息与频率调谐互补增强式显著性计算方法所围的面积大于频率调谐的显著性计算方法所围的面积,这说明本文显著性计算方法对于运动目标的估计优于频率调谐的显著性计算方法,因此本文提出的显著性计算方法能够有效提高检测和分割精度.

|

图 2 显著性计算结果比较 |

|

图 3 显著性计算方法的ROC曲线 |

mean shift[13]是一种高效的非参数核密度估计算法,它既不需要知道样本点的分布特征,也不需要事先设定聚类的数目和大小,而是完全依赖于特征空间中样本点的动态聚类结果. mean shift算法广泛应用于图像滤波、图像分割以及视频跟踪.将mean shift算法与显著性计算相结合可在目标检测与分割中发挥相得益彰的作用.

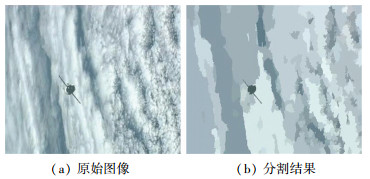

图 4(b)为用mean shift方法分割之后的图像,空间特征点在空间域的核函数带宽选为7,在Lab彩色空间核函数的带宽选为6.5,筛选合并的尺度门限为20,从图 4(b)中可以看出,采用mean shift方法的分割结果已经展现出目标的有效区域,从而可为进一步的高精度目标检测提供可靠保证.

|

图 4 mean shift分割结果 |

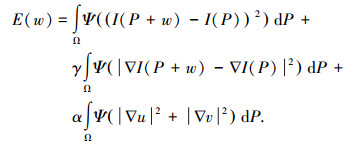

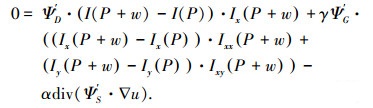

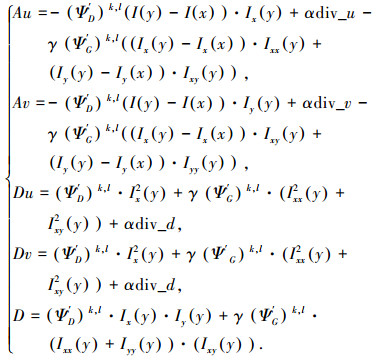

光流反映了图像上每一点灰度的变化趋势,可看成是带有灰度的像素点在图像平面上运动而产生的瞬时速度,也是一种对真实运动的近似估计.由于不需要场景的先验信息及求解的准确性,光流法和阈值分割等其他技术结合在一起,应用于运动目标检测中. Brox等[14]提出的变分光流,其在计算精度和时间上都显示出优势. Javier等对传统变分光流模型进行变形,并给出具体的数值求解过程.定义图像在t时刻的空时坐标为P=(x, y, t)T, 其中(x, y)为空间(平面)坐标,t为时间变量,则由t时刻到(t+1)时刻的空时坐标流变增量为ΔP =(Δx, Δy, 1)T.光流向量(u, v)=(Δx, Δy),根据光流亮度的不变性和梯度不变性,以及全局平滑的约束条件,光流模型为

|

(3) |

式中前两项分别为亮度和梯度不变性准则项,最后一项是为全局平滑约束项,

求解变分光流场的过程就是(u, v)的最优化过程,并使目标函数E(w)最小.应用Euler-Lagrange方程求解式(3)可得

|

(4) |

式中

|

(5) |

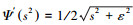

由于含有I(x+w)非线性函数等式(3)的求解较为困难,为了计算方便,对其一阶泰勒展开:

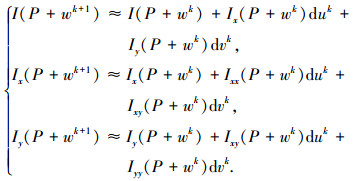

|

(6) |

式中wk=(uk, vk)T,duk=uk+1-uk,dvk=vk+1-vk.

假设

|

(7) |

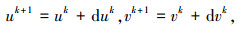

对式(3)离散化并经推导可得光流的迭代计算式为

|

(8) |

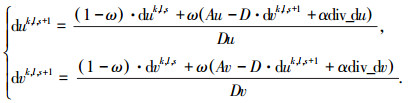

式中ω为SOR松弛参数,div表示散度,Au, Av, Du, Dv, D定义为

|

(9) |

对式(8)进行迭代,直到满足迭代收敛的条件:

|

(10) |

式中:N为图像中像素的个数,λ为停止迭代阈值,k为内层迭代数,l为外层迭代数,s为金字塔层数.

3 互补增强式空间运动目标高精度检测与分割 3.1 显著性与光流信息的互补作用基于视觉显著性计算的目标检测方法不需要知道目标的先验信息, 计算简单,检测效果好,但其目标检测误警率较高.光流法作为运动目标检测的常用方法,广泛应用于背景和目标同时运动目标的目标检测中,但是在光照变化、噪声干扰等情况下,光流法目标检测效果影响较大.因此本文提出互补增强的显著性计算和光流目标检测和分割算法,光流法以其较高的检测准确率,与融合梯度信息的显著性目标检测互补合取,有效剔除虚警目标,提高目标检测和分割的精确性.

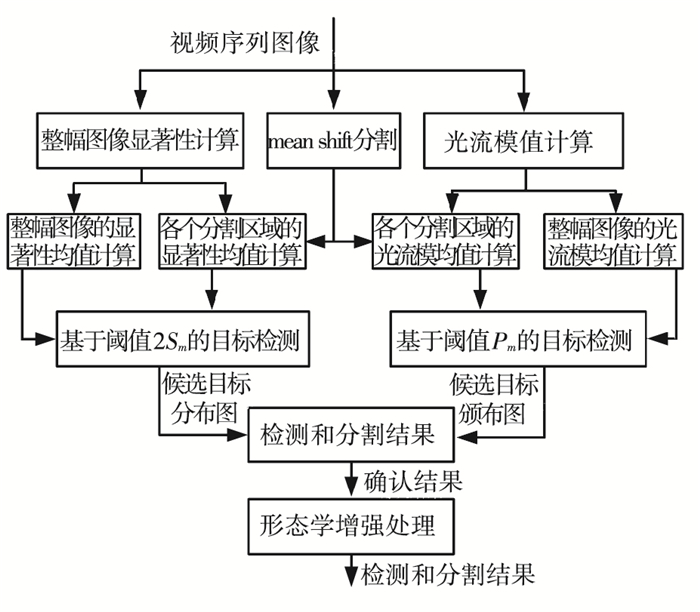

3.2 显著性与光流互补增强的目标检测与分割根据目标检测与分割的技术特点与要求,特设计显著性与光流互补增强式目标检测与分割的方案流程如图 5所示.

|

图 5 显著性与光流互补增强的目标检测和分割方案 |

图 5中,首先分别计算整幅图像的显著性均值Sm和各个mean shift分割区域的显著性均值Smi,并以2Sm为阈值,以区分候选目标和背景,若分割区域的显著性均值大于该阈值,则判定为候选目标区域,否则即为背景.于此相并行,也计算整幅图像的光流模均值Pm和每个mean shift分割区域的光流模均值Pmi,并设置阈值为Pm,以判别各个分割区域是否为候选目标区域或背景.最后,以前述两个通道所判定的候选目标区域的合取运算作为初步检测结果,再施以形态学增强处理而得到最终的目标检测与分割结果.很显然,互补增强,也利用了数学形态学处理所擅长的目标轮廓增强优势,从而可实现高精度的目标检测与分割.很显然,在此算法流程中既包含了显著性与光流的互补增强,也利用了数学形态学处理所擅长的目标轮廓增强优势,从而可实现高精度的目标检测与分割.

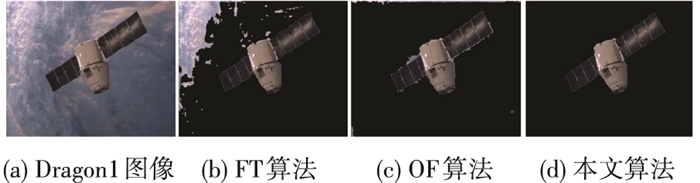

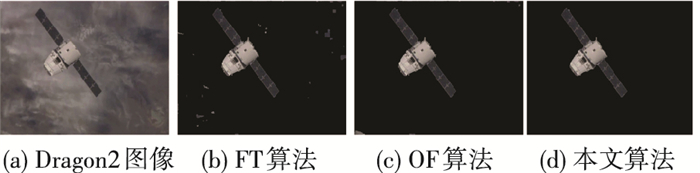

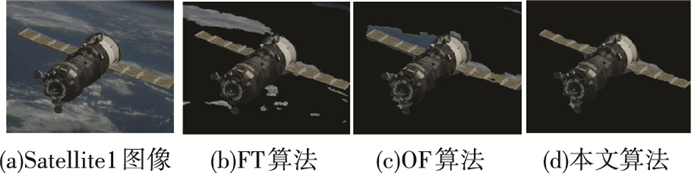

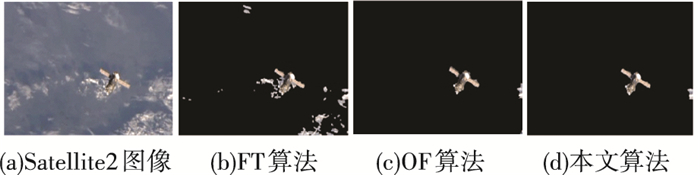

4 实验结果与比较分析 4.1 实验条件和对象为了验证本文算法,采用NASA广播视频片段中5组空间在轨运行空间目标视频序列进行实验,视频序列的名称标记为Dragon1、Dragon2、Satellite1、Satellite2、Satellite3,序列图像的帧数分别为41、600、233、645、800.在Pentium (R)计算机CPU为3.2 GHz的Windows XP操作系统上采用MATLAB编程实现该算法.

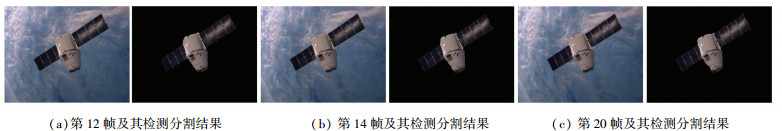

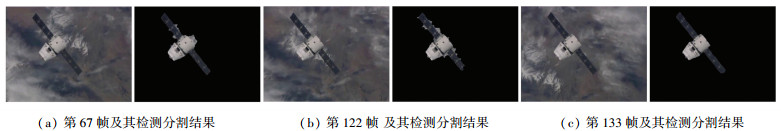

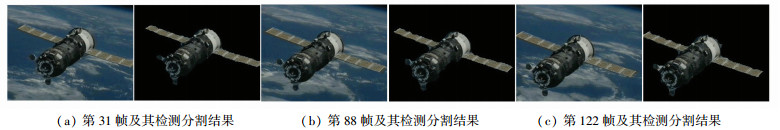

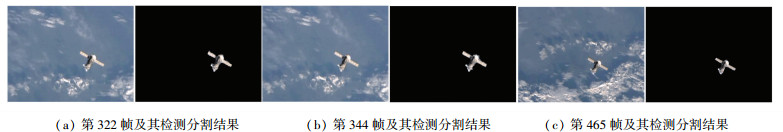

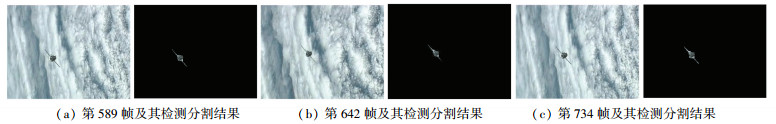

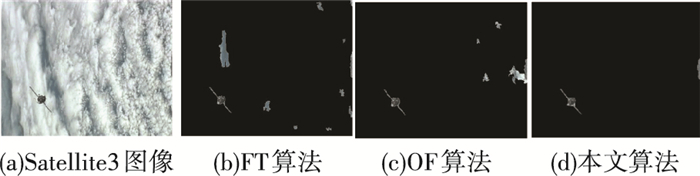

4.2 实验结果与比较分析实验1.为了验证本文算法的有效性,分别在5组空间运动目标图像系列进行了实验. 图 6~10随机给出了5组空间运动目标的检测分割结果,图 6为Dragon1飞船运动目标视频图像和其对应的检测分割结果;图 7为Dragon2飞船运动目标视频图像和其对应的检测分割结果;图 8为Satellite1卫星运动目标视频图像和其对应的检测分割结果;图 9为Satellite2卫星运动目标视频图像和其对应的检测分割结果;图 10为Satellite3卫星视频图像和其对应的检测分割结果. 图 6~10序列图像中含有云层的图像为待检测图像,背景全黑的图像为本文算法在相应帧图像上的检测和分割结果,从图 6~10中视频图像在不同时刻检测和分割结果可以看出,随着在轨相机和空间目标变化,本文提出的检测与分割算法不但能精确检测并分割出空间云层背景下的运动目标,而且可以适应不同光照、噪声等条件,算法具有较强鲁棒性.

|

图 6 Dragon1飞船视频图像及其检测分割结果 |

|

图 7 Dragon2飞船图视频图像及其检测分割结果 |

|

图 8 Satellite1卫星视频图像及其检测分割结果 |

|

图 9 Satellite2卫星视频图像及其检测分割结果 |

|

图 10 Satellite3卫星视频图像及其检测分割结果 |

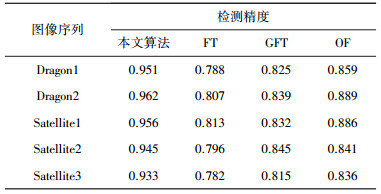

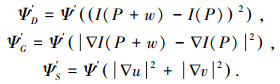

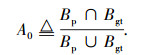

实验2.为了验证本文算法的检测准确度,分别对上述5组视频序列采用本文算法、频率调谐(frequency-tuned, FT)方法、梯度信息与频率调谐(gradient and frequency-tuned, GFT)的方法和光流(optical flow,OF)运动目标检测进行精度统计.采用平均检测精度进行评价,需要确定判断目标检测正确的准则,用Bp表示实际检测结果的目标区域,Bgt表示真实目标区域,现定义A0为检测所得目标区域与实际目标区域的符合度,即

|

(11) |

若A0>0.5,则检测结果正确.设一组视频图像序列中的图像总数为n,其中目标检测结果正确的图像数目为nt,则针对该视频图像序列的检测精度定义为

|

(12) |

由式(12)可给出对5个视频序列的检测精度统计结果,见表 1.很显然,本文算法的平均检测精度最高,其中视频Dragon2由于背景简单,光照变化小,检测精度较高,而视频Satellite3由于目标距离观测相机较远,观测到的运动目标较小,并且背景云层运动比较明显,因此采用梯度信息与频率调谐的目标检测和光流法运动目标检测效果较差,在5组检测序列中,其检测精度最低.

| 表 1 空间运动目标检测精度 |

实验3.为了说明本文算法的分割效果,分别在上述5组视频序列中对本文算法、频率调谐(FT)和光流法(OF)检测方法进行实验分析. 图 11~15给出了互补增强式运动目标分割结果,由图 11~15可知,FT频域谐调的显著性区域检测算法能够准确分割空间运动目标,但是也会将一些背景误分割为目标,如图 11(b)中Drgon1视频图像所示,左上角光照较亮,频率调谐算法分割目标的同时,一大片背景也被分割为出来.而光流法运动目标检测算法容易将云层背景误分割为运动目标.如图 11~15的分割结果,本文提出的视觉选择性显著计算和光流法互补增强的目标检测与分割算法,能有效的剔除背景云层信息,准确检测和分割出空间目标,比其他两种检测和分割算法具有较高的精确性.

|

图 11 Dragon1图像目标分割结果比较 |

|

图 12 Dragon2图像目标分割结果比较 |

|

图 13 Satellite1图像目标分割结果比较 |

|

图 14 Satellite2图像目标分割结果比较 |

|

图 15 Satellite3图像目标分割结果比较 |

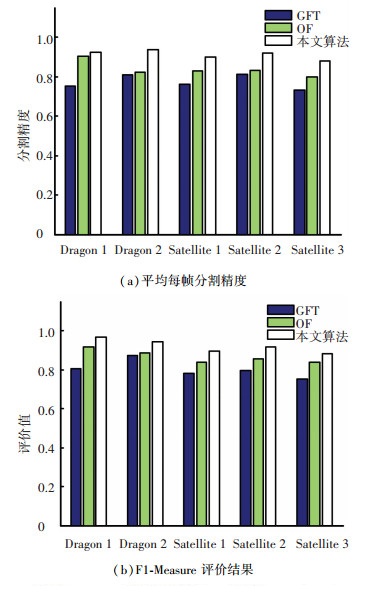

实验4.为了验证本文所提分割算法的精度,采用平均每帧的分割精度[15](average segmentation rate)和F1-measure评价指标对5组视频图像进行评价分析.其评价指标的定义和计算公式如下:TP(true positives)为目标被正确分割的像素个数;FP(false positives)为非目标被检测为分割的像素个数;TN(true negatives)为非目标被正确分割的像素个数;FN(false negatives)为目标被分割为非目标的像素个数;precision表示每帧的分割精度,precision= TP/(TP+FP),recall表示召回率,recall=TP/(TP+FN).则F1-measure=2 * precision * recall/(precision * recall);average segmentation

|

图 16 本文算法和其他目标分割算法精度比较 |

由图 16(a)中可知,在5组视频序列中,本文提出的显著性和光流信息互补增强的空间运动目标高精度分割算法中无论是采用平均每帧分割精度指标,还是采用F1-measure评价指标,都比其他两种检测和分割算法精度较高.其次是基于光流的目标检测和分割方法.显著性检测方法目标分割精度最低.同时5组视频序列检测和分割中,Satellite卫星视频由于存在模糊、丢帧等现象,检测效果不如视频Dragon序列图像分割效果好.

5 结论针对空间监视系统中运动目标高精度检测和分割,提出了互补增强显著性视觉注意模型和光流法互补增强式空间运动目标检测和分割算法.首先,对于频域调谐显著性计算中带通滤波器破坏边缘信息的问题,提出融合梯度信息的频域调谐的显著性计算方法,更好地描述运动目标区别于周围背景的程度,结合自适应mean shift算法确定阈值进行目标检测.其次,所提互补增强目标检测和分割算法,充分发挥了显著性计算和光流法目标检测的优势.能够精确检测和分割出云层背景下的空间未知运动目标,并对噪声和光照变化等影响因素具有良好的适应能力,适用于空间运动目标监视方面的任务.但由于采用了并行互补方案,时间开销仍然较大,需要在后续的研究工作中进一步改进.

| [1] |

周彦平, 舒锐, 陶坤宇, 等. 空间目标光电探测与识别技术的研究[J]. 光学技术, 2007, 33(1): 68-73. |

| [2] |

张浩鹏, 刘正一, 姜志国, 等. BUAA-SID1.0空间目标图像数据库[J]. 航天返回与遥, 2010, 31(4): 65-71. |

| [3] |

YIN Hongpeng, CHAI Yi, SIMON X, et al. Fast-moving target tracking based on mean shift and frame-difference methods[J]. Journal of Systems Engineering and Electronics, 2011, 22(4): 587-592. DOI:10.3969/j.issn.1004-4132.2011.04.006 |

| [4] |

SHEIKH Y, SHAH M. Bayesian modeling of dynamic scenes for object detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2005, 27(11): 1778-1792. DOI:10.1109/TPAMI.2005.213 |

| [5] |

MUELLER M, KARASEV P, KOLESOV I, et al. Optical flow estimation for flame detection in videos[J]. IEEE Transactions on Image Processing, 2013, 22(7): 2786-2797. DOI:10.1109/TIP.2013.2258353 |

| [6] |

JAVIER S, NELSON M, AGUSTÍN S. Robust optical flow estimation[J]. Image Processing on Line, 2013, 3: 252-270. DOI:10.5201/ipol |

| [7] |

DALAL N, TRIGGS B. Histograms of oriented gradients for human detection[C]//Proceedings of IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Diego: IEEE, 2005: 886-893. http://ieeexplore.ieee.org/xpls/abs_all.jsp?arnumber=1467360

|

| [8] |

ACHANTA R, HEMAMI S, ESTRADA F, et al. Frequency-tuned salient region detection[C]//IEEE Conference on Computer Vision and Pattern Recognition. Miami: IEEE, 2009: 1597-1604. http://ieeexplore.ieee.org/xpls/icp.jsp?arnumber=5206596

|

| [9] |

CHENG Mingming, ZHANG Guoxin X, MITRA N J, et al. Global contrast based salient region detection[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Providence: IEEE, 2011: 409-416. http://doi.ieeecomputersociety.org/10.1109/CVPR.2011.5995344

|

| [10] |

ITTI L, KOCH C, NIEBUR E. Model of saliency-based visual attention for rapid scene analysis[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1998, 20(11): 1254-1259. DOI:10.1109/34.730558 |

| [11] |

ACHANTA R, ESTRADA F, WILS P, et al. Salient region detection and segmentation[C]//Proceedings of the 6th International Conference on Computer Vision Systems. Santorini: Springer Lecture, 2008: 66-75. http://link.springer.com/chapter/10.1007/978-3-540-79547-6_7

|

| [12] |

MARR D. Vision:a computational investigation into the human representation and processing of visual information[M]. San Francisco: W. H. Freeman & Company, 1982.

|

| [13] |

BUGEAU A, PEREZ P. Detection and segmentation of moving objects in highly dynamic scenes[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Minneapolis: IEEE, 2007: 1-7. http://ieeexplore.ieee.org/xpls/icp.jsp?arnumber=4270269

|

| [14] |

BROX T, BRUHN A, PAPENBERG N, et al. High accuracy optical flow estimation based on a theory for warping[C]//The Series Lecture Notes in Computer Science. Berlin Heidelberg: Springer, 2004: 25-36. http://link.springer.com/10.1007/978-3-540-24673-2_3

|

| [15] |

LAPTEV I. Improving object detection with boosted histograms[J]. Image and Vision Computing, 2009, 27(5): 535-544. DOI:10.1016/j.imavis.2008.08.010 |

2016, Vol. 48

2016, Vol. 48