2. 空间智能控制技术重点试验室, 100190 北京

2. Science and Technology on Space Intelligent Control Laboratory, 100190 Beijing, China

开展深空探测活动是人类进一步了解宇宙、认识太阳系、探索地球与生命起源和演化、获取更多科学认识的必须手段,更是国家发展、科学探索、科技创新和开拓疆域的共同需求[1].随着科学技术的快速发展,地外天体着陆探测成为深空探测的重要内容.目前人类已经实现了对月球、火星、小行星和彗星的着陆探测,在这些着陆探测任务中采用的着陆自主导航方法主要是惯性导航.但由于初始导航误差、惯性测量误差以及引力场模型误差的存在,惯性导航误差随时间增加而逐步增大,因此,惯性导航通常需要与其他外部敏感器测量信息相结合以提高导航精度.目前广泛使用的是基于惯性导航配以测距测速修正的导航方法,其已在“嫦娥三号”、“阿波罗”等月球着陆任务以及火星着陆任务中得到成功应用[2-3].尽管测距测速敏感器提供了较高精度的速度和斜距测量信息,能够有效地抑制惯性导航在速度和高度方向上的误差发散,但是单纯的测距测速无法为惯性导航系统提供水平位置误差修正信息,因此这种导航方法只能满足对着陆精度要求不太高的探测任务需求.

未来地外天体探测任务要求探测器具有在较高科学价值的特定区域精确着陆的能力.美国宇航局(NASA)[4]提出的精确定点着陆(pinpoint landing systems, PPL)要求探测器着陆精度在100 m以内,现有的惯性导航辅以测距测速修正的着陆导航方法难以满足精确定点着陆的要求.针对未来深空探测地外天体精确着陆自主导航的需求,一种最为可行的技术手段是引入地外天体表面图像信息进行自主导航.这主要是由于地外天体表面分布着大量形状各异的陨石坑、岩石和纹理等天然陆标,利用地外天体表面陆标图像信息能够获取完备的探测器位置和姿态信息.采用序列图像的自主导航技术,作为未来载人和无人深空探测精确定点着陆任务的关键技术,NASA和欧空局(ESA)等[5-7]机构都将其作为深空探测技术的重点发展方向之一.

根据我国2030年前深空探测发展规划,2020年前后我国将自主开展火星和小行星等地外天体的着陆探测任务.在这一背景下,本文对基于序列图像的深空探测着陆过程自主导航进行综述,系统地总结基于序列图像的深空探测着陆过程自主导航的研究现状,概括并分析基于序列图像的深空探测着陆过程自主导航涉及到的关键技术,提出当前研究存在的主要问题并对其后续发展进行展望,为我国未来的地外天体着陆探测任务提供参考.

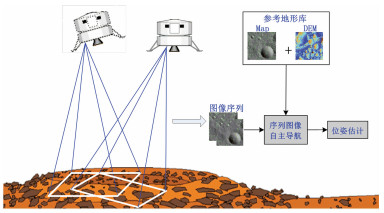

1 深空探测着陆过程序列图像自主导航研究现状基于序列图像的自主导航解决的是采用图像序列的运动估计问题,其指载体利用主动或被动成像敏感器获取环境图像序列,通过对该序列图像进行分析处理获得载体的位置、速度和姿态等导航信息的技术, 如图 1所示.基于序列图像的自主导航处于多学科交叉领域,研究范围涉及光学、图像、模式识别、电子、导航等多个学科,早期主要应用于机器人导航任务,包括无人地面车辆、无人机和水下机器人等[8-10],近年来其在深空探测地外天体精确着陆自主导航中的应用研究也越来越多.目前,研究人员已在基于天体表面序列图像信息的地外天体精确着陆自主导航方面开展了大量研究和飞行试验工作.

|

图 1 序列图像自主导航 |

根据所采用敏感器的不同,基于序列图像的深空探测着陆过程自主导航可以分为两类:主动式和被动式.主动式采用激光雷达(light detection and ranging, LIDAR)主动成像敏感器感知探测器着陆环境;被动式采用光学相机作为主要导航敏感器来获取环境图像序列.

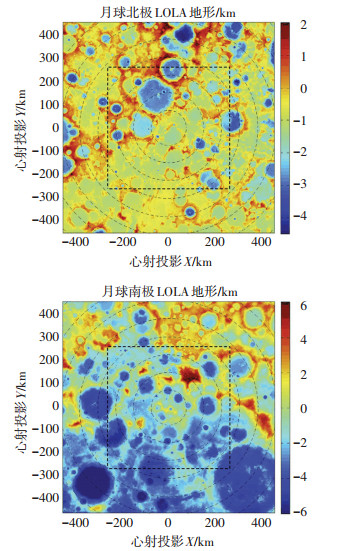

1.1 采用LIDAR的序列图像自主导航研究现状LIDAR敏感器可直接获得着陆区域的三维地形图,典型的LIDAR图像如图 2所示[11].LIDAR成像敏感器具有精度高、分辨率高、更新速度快、不受光照条件限制等优点,是理想的着陆导航敏感器[12].首先LIDAR敏感器对视场内的着陆区域三维成像,获取着陆器相对着陆区域的斜距信息,然后LIDAR测量数据结合着陆器当前位姿估计生成数字高程图(dight elevation map, DEM),最后利用相关性方法或模式匹配方法将获得的DEM与着陆器存储的着陆区域参考地形库进行比对从而得到着陆器的绝对位姿估计.当着陆器中没有参考地形库时,可通过比对由LIDAR敏感器获得的序列图像得到局部相对位姿和速度估计,局部相对位姿和速度的准确估计是实现行星着陆自主避障和安全着陆的关键技术[13-14].

|

图 2 月球南北极LIDAR图像[11] |

目前,已经存在多种采用LIDAR的自主着陆导航方法.20世纪90年代初期NASA约翰逊航天中心(NASA-JSC)就进行了利用LIDAR对着陆区域扫描成像以实现障碍检测和规避的研究[15],喷气推进试验室(JPL)的Johnson等[16-17]在此基础上进一步深入研究了利用LIDAR实现火星着陆自主避障和安全着陆的问题,并通过数学仿真进行了验证.同时,加拿大Sherbrooke大学的Lafontaine等[18-21]也对采用LIDAR敏感器的行星自主着陆导航和避障问题进行了研究.2006年NASA针对实现探测器自主着陆月球、火星甚至小行星的要求启动了自主着陆和避障技术研究项目(autonomous landing and Hazard avoidance technology, ALHAT)[4, 22].基于LIDAR的地形相对导航是ALHAT项目的核心技术之一,NASA为ALHAT项目专门研制了闪光式激光成像雷达敏感器(flash lidar),并对由该LIDAR敏感器作为主要敏感器的精确着陆自主导航系统进行了广泛的测试验证[23-25],最终经过闭环飞行试验表明基于LIDAR的ALHAT系统达到甚至超过了NASA六级技术就绪水平(technology readiness level, TRL)[26].此外,2013年中国“嫦娥三号”月球探测器利用激光三维成像敏感器在世界上首次实现了地外天体软着陆精确自主避障[27].

1.2 采用光学相机的序列图像自主导航研究现状相较于主动成像敏感器,以光学相机为代表的被动成像敏感器具有质量和体积小、功耗低、技术成熟、不受使用高度限制等特点,但其受到光照条件约束[12].随着计算机视觉技术的发展,基于光学图像的运动估计问题得到了广泛的研究[28-31],其在深空探测着陆过程自主导航中的应用研究也越来越多,并在地外天体着陆探测任务中得到不同程度的测试和验证.当前,对基于光学图像的深空探测着陆过程自主导航的研究以美国NASA为主.2000年美国NEAR小行星探测器首次进行了采用陆标光学图像的导航,在最后的接近着陆过程中通过跟踪Eros小行星表面的陨石坑获得了远高于传统方法的导航精度,但该导航过程主要在地面完成[32].2004年美国的“火星探测漫游者(MER)”火星探测器通过下降图像运动估计系统(descent image motion estimation system, DIMES)在着陆过程中通过跟踪3幅序列图像中的相关图像块实现对探测器水平方向速度的估计[33].随后在DIMES基础上,JPL提出了一种适用于行星着陆的通用地形相对导航方法,该方法可自主完成下降图像和参考地形图中陆标特征的识别和匹配以及下降图像序列中陆标特征的识别和跟踪,并通过扩展卡尔曼滤波器(EKF)融合陆标图像测量信息和惯性测量信息实现着陆器的位姿估计,该方法经探空火箭试验表明最终导航精度优于10 m[34-37].在上述研究基础上,NASA开发了着陆器视觉系统(lander vision system, LVS),并设计制造了LVS原型样机,该系统硬件部分主要由相机、惯性敏感单元和专用计算元件组成[38],2014年和2015年NASA使用直升机和自主下降上升动力飞行试验台(autonomous descent and ascent powered-flight testbed, ADAPT)成功对LVS进行了飞行试验测试[39-40].此外,日本的“隼鸟号”采样返回探测器在着陆近地小行星过程中采用了基于人造陆标图像的相对导航技术方案[41];中国的“嫦娥三号”月球着陆器在接近段飞行过程中首次利用光学相机观测预定着陆区实现月球软着陆粗避障[27].上述深空探测任务对基于光学图像的着陆过程自主导航的应用和试验验证表明了基于光学序列图像的深空探测着陆过程自主导航的可行性和对提高导航精度的巨大潜能.除上述方法外,研究人员还提出了多种采用光学序列图像的着过程自主导航方法.约翰斯-霍普金斯大学应用物理试验室提出采用两个正交安装的光学相机进行导航的精确着陆自主导航(autonomous precision landing navigation algorithm, APLNav)方法[42-43];ESA在行星接近和着陆导航项目(navigation for planetary approach and landing, NPAL)中[44]提出一种基于特征点提取、跟踪和估计的视觉导航方法;Janschek等[45]提出利用由导航相机获取的光流信息重构着陆区域的三维模型,并与提前存储的参考数字高程模型进行匹配得到着陆器的位姿估计;Guizzo等[46]提出基于双目视觉的火星着陆自主导航方法.国内对基于序列图像的深空探测着陆过程自主导航方法也进行了广泛的研究.哈工大、北理工和北京控制工程研究所等[47-51]机构对月球、火星和小天体探测器在软着陆阶段的自主视觉导航与避障的关键技术方面都进行了较为深入的研究.

2 基于序列图像的深空探测着陆过程自主导航关键技术国内外学者从不同角度和不同侧重点对基于序列图像的深空探测着陆过程自主导航进行了系统深入的研究.从目前研究来看,基于序列图像的深空探测着陆过程自主导航所涉及的关键技术包括:天体表面地形的建模和表征技术、天体表面图像导航特征的提取、匹配和跟踪技术、基于序列图像的自主导航技术、基于序列图像的着陆过程自主导航敏感器技术和基于序列图像的深空探测着陆过程自主导航仿真验证技术等.

2.1 天体表面地形的建模和表征技术不管是采用主动式还是被动式成像敏感器的地外天体着陆绝对导航均需要着陆区域的参考地形数据库,因此利用天体表面地形的建模和表征技术构建天体的三维地形数据库是采用序列图像信息进行绝对自主导航的基础.目前,随着火星、月球和小行星等地外天体探测任务的实施,探测器在轨获取了大量的天体影像和高程等数据,通过地面处理,构建了火星、月球和小行星等天体的三维地形数据库,可为未来着陆探测任务的着陆安全分析和导航提供技术基础.

对于火星,“火星全球勘测者(MGS)”探测器通过线阵相机和激光测距仪获取了大量测量数据,生成了分辨率介于200~300 m,高程精度为5~30 m的全火星三维地形数据库[52].“火星快车(mars express)”探测器利用高分辨率立体测绘相机(high resolution stereo Camera, HRSC)获取了分辨率约为10 m的火星表面影像数据,该高分辨率影像目前已经基本覆盖火星全球,利用该影像数据可以获取分辨率优于百米的火星全球地形数据[53].“火星侦察轨道器(MRO)”利用高分辨率科学成像试验相机(high resolution science imaging experiment, HiRISE)获取的影像分辨率优于0.5 m,是目前为止分辨率最高的火星表面影像图,但是仅能覆盖火星表面不足1%的区域[54].在“好奇号”着陆探测计划实施过程中,MRO利用HiRISE对多个备选着陆区进行了详细观测,获取了备选着陆区的精确地形数据,构建了备选着陆区的三维地形数据库,地面利用该数据库进行了大量的着陆仿真验证,确保了“好奇号”着陆探测任务的成功实施.此外,JPL的Gaskell利用“海盗号”探测器的测绘数据构建了高分辨的火星地形和反照率模型,还利用稀少的立体观测数据构建了含数百个陆标的火卫一地形模型[55].

对于月球,“克莱门汀”月球探测器提供了分辨率为100 m/像素的全月表图像和精度为7.6 km/像素的数字高程图;“月球勘测轨道器”利用相机和激光测距仪对月球进行了全月球观测,构建了月球三维地形数据库,全月球分辨率为100 m,局部区域分辨率达到25~35 m、高程精度优于1 m[13, 56].“嫦娥”系列卫星也获取了全月球的高程和图像数据,全月球影像图分辨率达到7 m,目前构建的月球三维地形数据库平面位置和高程精度分别为192 m和120 m[57-58],为“嫦娥三号”选取着陆区提供了重要支持.

对于小天体,NEAR任务利用在轨测量数据构建了Eros小行星三维形状、引力等模型[59];Gaskell[60]利用NEAR任务获取的大量立体影像数据,构建了平均分辨率为30 m、大部分区域分辨率介于10~30 m的Eros小行星形状和地形模型.Gaskell[61]还利用已有小行星Itokawa雷达观测模型结合“隼鸟号”任务获取的影像和高程等数据,构建了带有陆标的Itokawa三维仿真模型,并进行了初步的陆标导航仿真分析.

为提高天体表面三维地形模型的分辨率,国内外学者研究了光束法平差[52, 62-64]、密集匹配[65-66]等关键技术.Shan等[52, 62]采用二阶多项式模型对MGS获取的火星表面影像数据进行了光束法平差处理; Li等[63]采用三阶多项式建立了MRO任务影像数据的严格平差模型,利用平差后的结果在“勇气号”火星车着陆区生成了1 m网格的高分辨率地形数据; 王任享[64]提出的三线阵CCD影像EFP光束法平差方法已应用在“嫦娥一号”获取的月球影像数据处理中.利用立体影像数据生成三维地形数据库的核心问题是影像的密集匹配; Kirk等[65-66]通过对MGS获取的图像和距离数据进行密集匹配处理,获取了“勇气号”和“机遇号”着陆区的高分辨地形模型,利用MRO获取的观测数据生成的“凤凰号”着陆区地形模型分辨率达到米级.

2.2 天体表面图像导航特征的提取、匹配和跟踪技术基于序列图像的深空探测着陆过程自主导航是利用天体表面导航特征的图像测量信息对着陆器的状态进行更新估计,因此天体表面图像导航特征的提取、匹配和跟踪技术是基于序列图像的深空探测着陆过程自主导航的关键技术之一.

从目前国内外的研究情况看,天体表面可用于导航的特征主要有陨石坑、尺度不变特征变换(scale-invariant feature transformation, SIFT)特征点、角点和岩石等.陨石坑是最适用于着陆导航的陆标特征,其具有显著的几何形状,可在不同光照条件和无需相机高度和姿态信息的情况下实现特征的提取、匹配和跟踪[67].目前,天体表面图像导航特征的提取算法主要就是针对陨石坑特征进行的.天体表面图像陨石坑特征的提取主要有基于模板匹配提取和基于边缘或阴影信息启发式提取两种思路.Louren等[68]针对天体表面陨石坑特有的形状,生成相应的模板,并通过模板匹配实现陨石坑的提取.该方法能够在图像帧之间对陨石坑进行识别,但当图像出现较大的旋转、尺度缩放及形变时,就很难获得较好的提取效果; Cheng等[67]提出一种实时陨石坑检测算法,该算法首先利用Canny算子提取图像中的边缘信息,然后利用边缘分组方法找出属于同一个陨石坑的边缘,并将其拟合为闭合椭圆用来表征陨石坑,最后将拟合出的陨石坑椭圆与陨石坑数据库进行匹配; 丁萌等[69]提出采用KLT特征提取方法对陨石坑可能存在的区域进行搜索,并通过分割、边缘提取及形状拟合等处理实现陨石坑的提取.尽管地外天体上陨石坑非常常见,但并不能保证所有的目标着陆区域都有足够多的陨石坑用于着陆器位置估计,因此需要一种更普遍的陆标特征用于着陆过程导航,SIFT特征点是一种可能的选择.SIFT可将图像数据转换成与图像尺度和旋转无关的特征向量或关键点(key points)信息,利用关键点信息可实现图像之间的准确匹配[70].由于在提取SIFT关键点时计算量较大,目前基于SIFT的特征点提取和匹配方法在地外天体着陆导航中的应用研究还比较少.角点特征是另一种较容易从图像中提取的陆标特征,其通常对应于图像中的纹理区域,适合用相关性方法进行跟踪[36].针对岩石等特征点,Troglio等[71]提出一种融合分水岭分割算法(watershed segmentation)、Hough变化等多种图像处理技术的图像特征提取方法;JPL试验室提出利用图像阈值分割确定阴影区域,进而根据太阳光的照射角度确定岩石区域的方法[72].

天体表面图像特征的匹配方法主要有相关性方法(correlation approaches)和模式匹配(pattern matching)及其组合方法.相关性方法是将敏感器获取的天体表面图像块与地形模型库的每个位置块进行相似性评价,得到相似性最高的位置即为最佳匹配点[13].相关性方法主要有两种:平面图像的相关性方法[33-34]和三维图像的相关性方法[73].与相关性方法相比,模式匹配是用图像陆标匹配代替了图像块的相关性评估,利用从敏感器观测图像中提取出的图像陆标与参考地形库中的陆标进行特征匹配,这就要求参考地形库必须包含陆标的明显特征和位置信息.Cheng等[74]提出从探测器着陆过程拍摄的图像中提取陨石坑,根据陨石坑的直径、相对距离和角度等特征与参考陨石坑数据库进行模式匹配,从而获得探测器绝对位置与姿态信息,该方法已经利用月球、火星和小行星图像进行了测试.Frome等[75]利用三维成像敏感器获取天体表面三维图像,并从中提取出形状特征,与着陆区数字地形中的形状特征进行匹配,进而估计着陆器位置和姿态.此外,Gaskell[76]研究了一种图像模式匹配和相关性方法相结合的组合导航特征匹配方法,其利用已获取的天体表面图像来构建多个地形表面块的三维模型,将这些三维表面块作为导航的陆标,在着陆过程中利用当时太阳光照条件和表面块三维模型生成表面块平面图像,利用生成的表面块平面图像与敏感器实际获取的图像进行相关性处理,得到最佳匹配点信息,从而估计探测器位置和姿态.

当利用下降过程获得的序列图像估计着陆器局部位置或速度时,导航陆标的匹配问题就转变为跟踪问题.目前,应用最多的图像特征跟踪方法是KLT算法[77],其利用梯度下降方法搜索序列图像间的匹配模板来实现特征点跟踪,但该方法在弱光照条件下的效果较差.MER探测器的DIMES系统利用区域相关和图像单应性方法在已知姿态和高度信息的情况下实现跟踪3幅下降图像中的4个特征点[33].Johnson等[34]在DIMES基础上改进特征跟踪算法,实现在无外部姿态和高度敏感器情况下在上百幅图像中稳定跟踪数十个特征点.

2.3 基于序列图像的自主导航技术如何利用天体表面特征图像信息以提高着陆导航精度是实现精确着陆的关键技术之一.地外天体着陆任务面对的飞行环境、地形和光照条件等可能各不相同,利用天体表面特征图像信息的方式也不尽相同.目前,国内外学者针对不同情况,从不同角度出发,提出了多种利用天体表面图像信息的导航方法.

第1类是完全不依赖动力学模型,纯粹依靠图像信息的导航方法,以NASA为MER探测器开发的DIMES系统为代表.DIMES系统利用导航相机识别、匹配相邻两帧图像中特征点,结合高度计测距信息,利用简单的三角几何关系和匀速运动假设,完成对探测器水平速度的估计[33].此外,Sun等[78]的几何可观性分析表明,当存在3个及3个以上的不共面方向矢量测量时,相机载体的位姿即可唯一确定.因此,当在下降图像中可检测到至少3个不共线且位置已知的陆标时,即可根据几何关系确定着陆器位姿信息.目前研究人员提出了多种仅利用已知位置陆标图像测量信息计算相机载体位姿的算法[67, 79-80].该类导航方法虽简单可靠,但其存在以下两个不足[36]:1)其要求整个着陆过程中的下降图像均至少能检测到3个已知位置的陆标,但大多数着陆过程并不能保证满足该要求;2)该方法只能确定成像时刻着陆器状态,而这对于着陆过程来说是不够的.

针对单纯依靠图像信息进行导航存在的问题,研究人员提出了利用滤波算法融合天体表面已知位置陆标图像测量信息和惯性测量信息的组合导航方法,利用离散的已知位置陆标图像测量信息对惯导系统进行修正,估计探测器位置、姿态以及惯性测量单元的漂移[35-36, 81-82].这种方法主要适用于引力场模型准确的大天体的软着陆任务.

上述方法均是针对参考地形库中已存在的陆标特征进行的,当下降序列图像中检测和跟踪的陆标在参考地形库中不存在或没有着陆区域的参考地形库,即用于导航的陆标位置未知时,上述导航方法将不再适用.目前,针对这种情况主要有两类处理方法.一类是将陆标位置作为系统状态进行估计,即同时定位与地图创建(simultaneous localization and mapping, SLAM)方法,该方法在机器人视觉导航中研究较多[83-84].但目前来看SLAM方法并不适用于探测器在大天体的着陆导航任务,主要原因是当陆标较多时计算量太大,难以实时进行,且SLAM方法主要适用于闭合轨道的导航,而着陆过程并不满足闭合轨道要求[36].尽管如此,SLAM方法仍可用于小天体的着陆导航,Cocaud等[85-87]研究了利用SLAM方法的小行星着陆自主导航方法.另一类是利用陆标的图像测量信息结合飞行器在陆标成像时刻的估计位姿建立约束方程,以建立的约束方程作为导航系统的测量方程,进行飞行器状态估计[88-91].Mourikis等[88]提出一种多状态约束卡尔曼滤波算法(multi-state constraint Kalman filter, MSCKF), 该方法对序列图像中的陆标进行跟踪测量,通过最小二乘方法估计出陆标的位置信息,进而利用估计的陆标位置进行系统状态的更新估计;Gurfil等[89]利用子空间约束(subspace constraints)方法对飞行器部分状态进行估计,该方法通过测量陆标在图像中的运动,建立陆标图像运动与相机转动和平移运动之间的关系,并以之作为观测方程,估计飞行器的运动状态;Indelman等[90]提出一种基于3幅图像几何约束的视觉辅助惯性导航方法,该方法是基于矩阵秩条件提出的利用3个时刻对同一陆标的图像测量信息结合成像时刻相机位姿信息建立约束方程作为系统测量方程;Zhao等[91]提出利用序列图像之间的单应性矩阵(homography matrix)为观测量,对飞行器状态进行估计.上述各种方法通过利用序列图像测量信息以及成像时刻相机的位姿信息建立约束方程作为导航系统测量方程,都避免了要求已知陆标位置等先验信息,但这些导航方法只能进行相对导航,且系统状态不完全可观,因此通常需要融合其他外部敏感器的测量信息来实现高精度自主导航.

2.4 基于序列图像的着陆过程自主导航敏感器技术成像敏感器是基于序列图像的着陆过程自主导航系统的关键部件.地外天体软着陆自主导航系统要求导航敏感器具有测量精度高、灵敏度高、体积小、质量轻、功耗低等特点,因此对基于序列图像的自主导航成像敏感器提出了极其严格的要求.

目前,基于序列图像的深空探测着陆过程自主导航成像敏感器主要有两类:主动式和被动式.主动式成像敏感器以NASA-LaRC为ALHAT项目研制的闪光式三维成像激光雷达为代表.NASA-LaRC研制的闪光式激光成像雷达敏感器如图 3所示.该敏感器具有如下3个功能:20~0.1 km高度范围内的高度测量、15~5 km高度范围内地形相对导航,1 000~100 m高度范围内的障碍检测和规避(hazard detection and avoidance, HDA)和障碍相对导航(hazard relative navigation, HRN)[92].从2008年到2012年该Fish Lidar敏感器经过4次直升机飞行试验、1次固定翼飞机飞行试验分别对其障碍检测和规避、地形相对导航、障碍相对导航等功能进行了飞行测试[14, 23, 92].2014年以来,集成了Flash Lidar敏感器的GNC软硬件系统作为“梦神号”行星着陆器原型系统(Morpheus)的主要载荷进行了多次飞行测试,系统表现良好[26].

|

图 3 NASA-LaRC研制的Flash Lidar原型样机[92] |

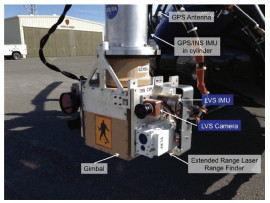

不同于主动成像式敏感器,被动光学成像敏感器技术更成熟,可选择的敏感器更多.MER的DIMES系统采用了一个分辨率为1 024×1 024,视场角为45°×45°,像平面中心角分辨率每像素0.82 mrad,光谱响应范围为400~1 100 nm的工程相机[33, 93],如图 4所示.JPL开发的LVS原型系统采用了商业敏感器组件,其相机由PhotonFocus公司的DS1-D1024全帧曝光CMOS和Kowa 6M6HC 6 mm镜头组成,具有85°视场角,如图 5所示[39].约翰斯-霍普金斯大学应用物理试验室[94]提出的APLNav系统采用了两个分辨率为256×256,视场角为55°的Sony XCD-SX910光学数字相机,如图 6所示[96];Johnson等[34-36]则分别利用商业相机Pulnix TM-9701和SonyXC55作为着陆导航系统的成像敏感器在地面利用探空火箭进行了飞行试验.Pollard等[95]研究了现有月球着陆导航敏感器技术,对其技术成熟度进行了评估,并据此给出了几种月球着陆器地形相对导航的敏感器组件配置方案.

|

图 4 MER下降相机[93] |

|

图 5 LVS系统[39] |

|

图 6 APLNav相机[96] |

为验证所研究的基于序列图像的深空探测着陆过程自主导航技术的有效性、可行性和实用性,必须针对地外天体着陆任务,建立地面仿真试验验证系统.这是突破关键技术所必须的,也是自主导航系统能够转入工程实施的基础.

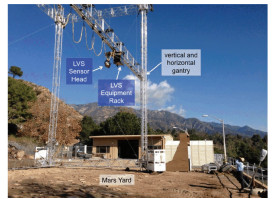

从国外的发展情况看,基于序列图像的着陆过程自主导航系统的仿真验证大致经历模拟仿真验证、直升机或固定翼飞机、探空火箭等飞行试验验证以及采用着陆器模拟平台的闭环实时试验验证.以JPL的LVS系统为例[39]:LVS系统发展早期研究人员利用在不同地形类型和不同光照条件下收集的地形数据对采用地形图像的地形相对导航算法进行了大量的离线仿真测试;完成LVS原型系统设计后在试验室利用火星图片进行了测试,验证了其位置、姿态和速度估计能力;随后又利用两自由度的台架对LVS系统的校正、对准和数据存储时间等进行了验证,如图 7所示;之后,利用直升机搭载LVS系统对各种可能的火星EDL情形进行了飞行试验验证,如图 8所示;最后,利用ADAPT平台对LVS系统进行了闭环实时仿真测试,如图 9所示[40].由于当前地外天体探测任务收集的天体表面地形数据有限,因此,在模拟仿真验证阶段通常需要解决高精度地外天体表面地形图像的模拟问题.约翰斯-霍普金斯大学应用物理试验室[56]提出利用低分辨率地形图像人工添加高分辨率数据生成高分辨率地形的月球表面地形建模技术,为ALHAT项目提供符合要求的月球地形数据.邓迪大学[97-98]为ESA开发了PANGU软件,用于生成行星和小行星表面模拟地形,目前该软件已经广泛应用于ESA基于视觉导航系统的仿真验证项目.

|

图 7 LVS系统台架试验[39] |

|

图 8 LVS系统直升机飞行试验[39] |

|

图 9 LVS系统ADAPT飞行试验[40] |

Quadrelli等[99]指出要实现精确定点着陆需要进入前的导航、加速度测量技术、基于陆标图像的在线导航、燃料最优的大范围轨迹调整制导和障碍检测与避让等技术紧密合作.而综合运用这些技术的在线制导导航与控制系统是作为复杂系统来运行的,要实现探测器精确定点着陆就需要综合考虑系统部件、飞行动力学和物理环境等的相互影响.因此,需要在各种真实仿真环境下从系统层面进行闭环建模、测试和仿真验证.而目前的仿真验证技术还远未达到该要求,需要进一步发展物理仿真验证方法以提高系统测试能力.

3 基于序列图像的深空探测着陆过程自主导航展望从技术发展趋势看,采用序列图像信息是提高着陆过程自主导航精度的一种重要的技术手段,具有良好的发展和应用前景.目前国内外学者从多种角度、侧重不同问题对采用序列图像的着陆过程自主导航进行了探索和研究,在各关键技术方面都取得一定进展.但是,采用序列图像的地外天体精确定点着陆自主导航仍存在较多难点问题未能很好地解决,其难点问题主要有:针对深空探测着陆过程自主导航实时性的要求,在星载计算机存储和计算能力有限的约束下,如何稀疏表征所需要的天体表面三维地形模型库;如何实现快速可靠的多尺度图像特征提取、匹配与跟踪;如何实现多维多时空导航信息的快速最优融合处理等.因此,需要针对上述难点问题深入开展研究,以满足地外天体精确定点着陆任务的需求.

3.1 天体表面导航陆标的稀疏表征与优化选取尽管国内外相关研究利用在轨获取的深空天体各类影像、高程等数据,经过一系列的地形测绘数据处理技术和手段,构建了一定精度的天体表面三维地形模型,但由于已实现的深空天体探测任务十分有限,因此绝大多数天体仍无可用于导航的地形表征库.特别是针对小天体的着陆探测任务基本也是目标天体的首次探测任务,因此需要解决如何利用在轨测量数据快速构建高精度天体表面地形数据库的问题.深空天体表面地形复杂多样,且形态各异,难以用描述符号表征,且对于深空大天体着陆任务,着陆过程探测器航程可达数百公里,导致需要的天体表面区域三维地形数据非常庞大,针对星载计算机存储和计算能力有限的约束以及着陆导航对实时性的严格要求,需要解决导航陆标特征信息的稀疏表征问题.此外,保证陆标导航信息的完备性和最优性是实现高精度导航的关键,因此还需要解决导航陆标的优化选取与规划问题.

3.2 天体表面多尺度多视点图像陆标特征提取与匹配目前,国内外学者在天体表面图像导航特征提取、匹配和跟踪的研究方面已经取得了一定的进展和效果.但是,对于深空探测着陆过程的特殊任务背景,探测器的航程、高度和姿态变化范围大,光照条件不确定,敏感器获取的天体表面图像尺度、视点、阴影等范围变化大,已有的图像导航特征提取、匹配和跟踪算法还无法适应深空探测着陆过程的特殊任务环境.另外,无论是相关性方法,还是模式匹配,都需要进行大范围的图像匹配,很难满足着陆过程自主导航的实时性要求.因此,还需要深入开展天体表面多尺度多视点图像特征的提取、匹配与跟踪方面的研究工作.

针对可能出现的陆标图像多位置重点以及特征不明显等问题,需要研究如何观测获取最优的导航陆标图像.针对敏感器视点等大范围变化导致图像变形以及不同光照带来的阴影变化等问题,需要研究引入导航陆标等信息的图像特征快速提取方法.针对多尺度多视点以及局部特性不明显图像可能引起的误匹配问题,需要研究引入基于信息融合的鲁棒导航陆标匹配方法.

3.3 基于序列图像信息的最优融合自主导航从目前的研究情况看,要实现地外天体精确定点着陆任务,尤其是对于未知环境下的天体着陆任务,采用序列图像信息的自主导航系统通常还需要融合惯性测量单元、测距测速敏感器等其他外部敏感器的测量信息以提高导航系统精度和可靠性,这就需要解决测量信息的最优融合问题.

针对着陆过程获取的序列陆标图像、惯性测量和测距测速等导航信息存在时间不同步、空间不一致等问题,需要研究多维测量信息的时空同化与表征方法.导航陆标相对目标着陆点的位置精度决定了着陆精度,限于目前探测和测量手段,导航陆标必然存在一定的位置误差,需要研究导航陆标位置误差的校正方法.针对精确定点着陆自主导航的需求,需要研究多信息最优融合导航理论与分析方法,解决如何选取高品质测量信息才能满足全部导航参数可快速估计的需求、如何融合多维信息才能最优估计导航参数等问题.

4 结语采用序列图像的着陆过程自主导航是未来实现地外天体精确定点着陆任务最为可行的技术手段之一.本文首先对基于序列图像的深空探测着陆过程自主导航发展现状进行了总结,然后概括并分析了采用序列图像的着陆过程自主导航涉及到的关键技术,最后对深空探测着陆过程序列图像自主导航的难点问题进行了总结分析,并对其后续发展进行了展望.

目前,国外已经对采用序列图像的深空探测着陆过程自主导航技术进行了大量的飞行试验,即将进入实际应用阶段,而我国也即将开展小行星和火星的着陆探测任务,因此有必要对采用序列图像的着陆过程自主导航技术进行更为深入的研究,为我国未来的地外天体着陆探测任务提供必要的技术储备.

| [1] |

叶培建, 彭兢. 深空探测与我国深空探测展望[J]. 中国工程科学, 2006, 8(10): 13-18. DOI:10.3969/j.issn.1009-1742.2006.10.003 |

| [2] |

吴伟仁, 李骥, 黄翔宇, 等. 惯导/测距/测速相结合的安全软着陆自主导航方法[J]. 宇航学报, 2015, 36(8): 893-898. |

| [3] |

OBERHETTINGER D, SKULSKY E D, BAILEY E S. Assessment of Mars phoenix EDL performance[C]//Proceedings of 2011 IEEE Aerospace Conference. Big Sky, MT: IEEE, 2011: 1-6.

|

| [4] |

EPP C D, SMITH T B. Autonomous precision landing and hazard detection and avoidance technology (ALHAT)[C]//Proceedings of 2007 IEEE Aerospace Conference. Big Sky, MT: IEEE, 2007: 1-7. http://ieeexplore.ieee.org/xpls/icp.jsp?arnumber=4161571

|

| [5] |

STEINFELDT B A, GRANT M J, MATZ D A, et al. Guidance, navigation, and control system performance trades for Mars pinpoint landing[J]. Journal of Spacecraft and Rockets, 2010, 47(1): 188-198. DOI:10.2514/1.45779 |

| [6] |

MILLER J K, CHENG Y. Autonomous landmark tracking orbit determination strategy[C]//Proceedings of 2003 AAS Astrodynamics Specialist Conference. Big Sky, MT: AAS, 2003: 1779-1789. http://ntrs.nasa.gov/search.jsp?R=20060029241

|

| [7] |

REBORDAO J M. Space optical navigation techniques-an overview[C]//Proceedings of 8th Iberoamerican Optics Meeting and 11th Latin American Meeting on Optics, Lasers, and Applications. Porto, Portugal: SPIE, 2013. http://proceedings.spiedigitallibrary.org/proceeding.aspx?articleid=1782231

|

| [8] |

SULLIVAN L O, CORKE P, MAHONY R. Image-based visual navigation for mobile robots[C]//Proceedings of IEEE International Conference on Robotics and Automation. Karlsruhe: IEEE, 2013: 5277-5283. http://ieeexplore.ieee.org/xpls/icp.jsp?arnumber=6631332

|

| [9] |

CESETTI A, FRONTONI E, MANCINI A, et al. A vision-based guidance system for UAV navigation and safelanding using natural landmarks[J]. Journal of Intelligent and Robotic Systems, 2010, 57(1/2/3/4): 233-257. |

| [10] |

GRACIAS N, VICTOR J S. Underwater video mosaics as visual navigation maps[J]. Computer Vision and Image Understanding, 2000, 79(1): 66-91. DOI:10.1006/cviu.2000.0848 |

| [11] |

MAZARICO E, NEUMANN G A, SMITH D E, et al. Illumination conditions of the lunar polar regions using LOLA topography[J]. Icarus, 2011, 211(2): 1066-1081. DOI:10.1016/j.icarus.2010.10.030 |

| [12] |

JOHNSON A E, HUERTAS A, WERNER R A, et al. Analysis of on-board hazard detection and avoidance for safe Lunar landing[C]//Proceedings of 2008 IEEE Aerospace Conference. Big Sky, MT: IEEE, 2008: 1-9. http://ieeexplore.ieee.org/xpls/abs_all.jsp?arnumber=4526301

|

| [13] |

JOHNSON A E, MONTGOMERY J F. Overview of terrain relative navigation approaches for precise Lunar landing[C]//Proceedings of IEEE Aerospace Conference. Big Sky, MT: IEEE, 2008. http://ieeexplore.ieee.org/xpls/abs_all.jsp?arnumber=4526302

|

| [14] |

JOHNSON A E, IVANOV T I. Analysis and testing of a LIDAR-based approach to terrain relative navigation for precise Lunar landing[C]//Proceedings of AIAA Guidance, Navigation, and Control Conference. Oregon. Portland: AIAA, 2011. http://arc.aiaa.org/doi/abs/10.2514/6.2011-6578

|

| [15] |

PIEN H. Autonomous hazard detection and avoidance: C. S. Draper Laboratory Report CSDLC-6303[R]. Cambridge, MA: NASA, 1992.

|

| [16] |

JOHNSON A E, KLUMPP A, COLLIER J, et al. LIDAR-based hazard avoidance for landing on Mars[J]. Journal of Guidance, Control, and Dynamics, 2002, 25(6): 1091-1099. DOI:10.2514/2.4988 |

| [17] |

WONG E C, SINGH G, MASCIARELLI J P. Guidance and control design for hazard avoidance and safe landing on Mars[J]. Journal of Spacecraft and Rockets, 2006, 43(2): 378-384. DOI:10.2514/1.19220 |

| [18] |

De LAFONTAINE J, NEVEU D, LEBEL K. Autonomous planetary landing with obstacle avoidance: the quartic guidance revisited[C]//Proceedings of 14th AAS/AIAA Space Flight Mechanics Meeting. Maui, Hawaii: AAS/AIAA, 2004.

|

| [19] |

De LAFONTAINE J, GUEYE O. Autonomous planetary landing using a LIDAR sensor:the navigation function[J]. Space Technology, 2004, 24(1): 7-18. |

| [20] |

De LAFONTAINE J, NEVEU D, LEBEL K. Autonomous planetary landing using a lidar sensor: the closed-loop system[C]//Proceedings of 6th International ESA Conference on Guidance, Navigation and Control Systems. Loutraki: ESA, 2005. http://adsabs.harvard.edu/abs/2006ESASP.606E...3D

|

| [21] |

De LAFONTAINE J, ULITSKY A, TRIPP J W, et al. LAPS: the development of a scanning LIDAR system with GNC for autonomous hazard avoidance and precision landing[C]//Proceedings of SPIE Vol. 5418. Bellingham, WA: SPIE, 2004. https://www.spiedigitallibrary.org/conference-proceedings-of-spie/5418/LAPS--the-development-of-a-scanning-lidar-system-with/10.1117/12.555421.short

|

| [22] |

STRIEPE S A, EPP C D, ROBERTSON E A. Autonomous precision landing and hazard avoidance technology (ALHAT) project status as of May 2010[C]//Proceedings of International Planetary Probe Workshop 2010. Barcelona: Spain, 2010. http://core.ac.uk/display/10554581

|

| [23] |

KEIM J A, MOBASSER S, KUANG D, et al. Field test implementation to evaluate a flash lidar as a primary sensor for safe Lunar landing[C]//Proceedings of IEEE Aerospace Conference. Big Sky, MT: IEEE, 2010.

|

| [24] |

JOHNSON A E, KEIM J A, IVANOV T. Analysis of flashlidar field test data for safe lunar landing[C]//Proceedings of IEEE Aerospace Conference. Big Sky, MT: IEEE, 2010. http://ieeexplore.ieee.org/xpls/icp.jsp?arnumber=5447025

|

| [25] |

ROBACK V, BULYSHEV A, AMZAJERDIAN, et al. Helicopter flight test of a compact, real-time 3-D flash lidar for imaging hazardous terrain during planetary landing[C]//Proceedings of AIAA Space 2013 Conference and Exposition. San Diego, CA: AIAA, 2013.

|

| [26] |

EPP C D, ROBERTSON E A, CARSON J M. Real-time hazard detection and avoidance demonstration for a planetary lander[C]//Proceedings of AIAA Space 2014 Conference, San Diego, CA: AIAA, 2014. http://arc.aiaa.org/doi/pdf/10.2514/6.2014-4312

|

| [27] |

张洪华, 梁俊, 黄翔宇, 等. 嫦娥三号自主避障软着陆控制技术[J]. 中国科学:科学技术, 2014, 44(6): 559-568. |

| [28] |

STRELOW D W. Motion estimation from images and inertial measurements[D]. Pittsburgh PA: Carnegie Mellon University, 2004.

|

| [29] |

PANG C C, GUESALAGA A R, RODA V O. Structural and movement parameter estimation in image sequences[C]//Proceedings of SPIE Vol. 4365. Orlando: SPIE, 2001: 158-167.

|

| [30] |

SOATTO S, FREZZA R, PERONA P. Motion estimation via dynamic vision[J]. IEEE Transaction on Automatic Control, 1996, 41(3): 393-413. DOI:10.1109/9.486640 |

| [31] |

HYSLOP A M, HUMBERT J S. Autonomous navigation in three-dimensional urban environments using wide-field integration of optical flow[J]. Journal of Guidance, Control, and Dynamics, 2010, 33(1): 147-159. DOI:10.2514/1.43778 |

| [32] |

CHENG Y, Miller J K. Autonomous landmark based spacecraft navigation system[C]//Proceedings of Spaceflight Mechanics 2003, Ponce PR: AAS, 2003.

|

| [33] |

JOHNSON A, WILLSON R, CHENG Y, et al. Design through operation of an image-based velocity estimation system for Mars landing[J]. International Journal of Computer Vision, 2007, 74(3): 319-341. DOI:10.1007/s11263-006-0022-z |

| [34] |

JOHNSON A E, ANSAR A, MATTHIES L H, et al. A general approach to terrain relative navigation for planetary landing[C]//Proceedings of AIAA Infotech@Aerospace Conference. Rohnert Park: AIAA, 2007.

|

| [35] |

TRAWNY N, MOURIKIS A I, ROUMELIOTIS S I, et al. Vision-aided inertial navigation for pinpoint landing using observations of mapped landmarks[J]. Journal of Field Robotics, 2007, 24(5): 357-378. DOI:10.1002/(ISSN)1556-4967 |

| [36] |

MOURIKIS A I, TRAWNY N, ROUMELIOTIS S I, et al. Vision-aided inertial navigation for spacecraft entry, descent, and landing[J]. IEEE Transactions on Robotics, 2009, 25(2): 264-280. DOI:10.1109/TRO.2009.2012342 |

| [37] |

ALEXANDER J, CHENG Y, ZHENG W, et al. A Terrain relative navigation sensor enabled by multi-core processing[C]//Proceedings of 2012 IEEE Aerospace Conference. Big Sky: IEEE, 2012: 104-114.

|

| [38] |

JOHNSON A, BERGH C, CHENG Y, et al. Design and ground test results for thelander vision system[C]//Proceedings of 36th Annual AAS Guidance and Control Conference. Breckenridge CO: AAS, 2013.

|

| [39] |

JOHNSON A, CHENG Y, MONTGOMERY J, et al. Real-time terrain relative navigation test results from a relative environment for Mars landing[C]//Proceedings of AIAA Guidance, Navigation, and Control Conference. Kissimmee: AIAA, 2015.

|

| [40] |

LANDAU E. Successful test flights for Mars landing technology[EB/OL]. [2015-03-19]. https: //www. nasa. gov/jpl/successful-test-flights-for-mars-landing-technology.

|

| [41] |

KUBOTA T, HASHIMOTO T, SAWAI S, et al. An autonomous navigation and guidance system for MUSES-C asteroid landing[J]. Acta Astronautica, 2003, 52(2/3/4/5/6): 125-131. |

| [42] |

MCGEE T G, CRISS T B, ROSENDALL P, et al. APLNav: development status of an onboard passive optical terrain relative navigation system[C]//Proceedings of AIAA Guidance, Navigation, and Control Conference. Kissimmee Florida: AIAA, 2015.

|

| [43] |

CRISS T B, WHITE M J, ADAMS D. APLNav terrain relative navigation airplane field test[C]//Proceedings of AIAA Guidance, Navigation, and Control Conference. Toronto Ontario: AIAA, 2010. http://arc.aiaa.org/doi/abs/10.2514/6.2010-8027

|

| [44] |

FRAPARD B, POLLE B, FLANDIN G, et al. Navigation for planetary approach and landing[C]//Proceedings of 5th International ESA Conference on Spacecraft Guidance, Navigation and Control System. Frascati: ESA, 2002: 159-168.

|

| [45] |

JANSCHEK K, TCHERNYKH V, BECK M. Performance analysis for visual planetary landing navigation using optical flow and DEM matching[C]//Proceedings of AIAA Guidance, Navigation, and Control Conference. Keystone Colorado: AIAA, 2006. https://arc.aiaa.org/doi/abs/10.2514/6.2006-6706

|

| [46] |

GUIZZO G P, VUKMAN I. Autonomous smartlander simulator based on stereo vision for the descent phase on Mars[C]//Proceedings of 54th International Astronautical Congress of the International Astronautical Federation, the International Academy of Astronautics, and the International Institute of Space Law. Bremen: IAC, 2003.

|

| [47] |

姜肖楠. 月球探测器软着陆视觉导航方法研究[D]. 哈尔滨: 哈尔滨工业大学, 2010. http://www.wanfangdata.com.cn/details/detail.do?_type=degree&id=D269171

|

| [48] |

崔平远, 冯军华, 朱圣英, 等. 基于三维地形匹配的月球软着陆导航方法研究[J]. 宇航学报, 2011, 32(3): 470-476. |

| [49] |

田阳, 崔平远, 崔祜涛. 基于图像序列的软着陆小天体自主导航方法[J]. 宇航学报, 2009, 30(1): 210-259. |

| [50] |

王大轶, 李骥, 黄翔宇, 等. 月球软着陆过程高精度自主导航避障方法[J]. 深空探测学报, 2014, 1(1): 44-51. |

| [51] |

李爽. 基于光学测量的相对导航方法及在星际着陆中的应用研究[D]. 哈尔滨: 哈尔滨工业大学, 2007.

|

| [52] |

SHAN J, YOON J S, LEE D S, et al. Photogrammetric analysis of the Mars global surveyor mapping data[J]. Photogrammetric Engineering&Remote Sensing, 2005, 71(1): 97-108. |

| [53] |

SCHOLTEN F, GWINNWE K, ROATSCH T, et al. Mars express HRSC data processing-methods and operational aspects[J]. Photogrammetric Engineering&Remote Sensing, 2005, 71(10): 1143-1152. |

| [54] |

MCEWEN A S, BANKS M E, BAUGH N, et al. The high resolution imaging science experiment (HiRISE) during MRO's primary science phase (PSP)[J]. Icarus, 2010, 37(2): 2-37. |

| [55] |

GASKELL R W. Determination of landmark topography from imaging data[C]//Proceedings of AAS/AIAA Astrodynamics Specialists Conference. Breckenridge: AAS, 2002: 167-179.

|

| [56] |

SHANKAR U J, CRISS T B, SHYONG W, et al. Lunar terrain surface modeling for the ALHAT program[C]//Proceedings of 2008 IEEE Aerospace Conference. Big Sky: IEEE 2008.

|

| [57] |

李春来. 嫦娥一号三线阵CCD数据摄影测量处理及全月球数字地形图[J]. 测绘学报, 2013, 42(6): 853-860. |

| [58] |

国家航天局. 嫦娥二号7米分辨率全月球影像图发布[J]. 中国航天, 2012, 11(2): 10-11. |

| [59] |

MILLER J K, KONOPLIV A S, ANTREASIAN P G, et al. Determination of shape, gravity, and rotational state of asteroid 433 Eros[J]. Icarus, 2002, 155(1): 3-17. DOI:10.1006/icar.2001.6753 |

| [60] |

GASKELL R W. High resolution shape and topography of Eros-preliminary results from NEAR imaging data[C]//Proceedings of AGU Spring Meeting. Montreal: AGU, 2004.

|

| [61] |

GASKELL R W. Landmark navigation and target characterization in a simulated Itokawa encounter[C]//Proceedings of AAS/AIAA Astrodynamics Specialists Conference. Lake Tahoe: AAS, 2005: 629-644.

|

| [62] |

YOON J S, SHAN J. Combined adjustment of MOC stereo imagery and MOLA altimetry data[J]. Photogrammetric Engineering&Remote Sensing, 2005, 71(10): 1179-1186. |

| [63] |

LI R X, HWANGBO J, CHEN Y H, et al. Rigorous photogrammetric processing of HiRISE stereo imagery for Mars topographic mapping[J]. IEEE Transactions on Geoscience and Remote Sensing, 2011, 49(7): 2558-2572. DOI:10.1109/TGRS.2011.2107522 |

| [64] |

王任享. 月球卫星三线阵CCD影像EFP光束法空中三角测量[J]. 测绘科学, 2008, 33(4): 5-7. |

| [65] |

KIRK R L, KRAUS E H, REDDING B, et al. High-resolution topomapping of candidate MER landing sites with Mars orbiter camera narrow-angle images[J]. Journal of Geophysical Research, 2003, 108(E12): 1-38. |

| [66] |

KIRK R L, KRAUS E H. Ultra high resolution topographic mapping of Mars with MRO HiRISE stereo images:meter-scale slopes of candidate phoenix landing sites[J]. Journal of Geophysical Research, 2007, 113(E00A24): 1-31. |

| [67] |

CHENG Y, ANSAR A. Landmark based position estimation for pinpoint landing on Mars[C]//Proceedings of 2005 IEEE International Conference on Robotics and Automation. Barcelona: IEEE, 2005: 4470-4475.

|

| [68] |

LOUREN B, SARA J, PEDRO P. Development of a methodology for automated crater detection on planetary images[J]. Lecture Notes in Computer Science, 2009, 4447: 193-200. |

| [69] |

丁萌, 曹云峰, 吴庆宪. 一种从月面图像检测陨石坑的方法[J]. 宇航学报, 2009, 30(3): 1243-1248. |

| [70] |

LOWE D G. Distinctive image features from scale-invariantkeypoints[J]. International Journal of Computer Vision, 2004, 2(60): 91-110. |

| [71] |

TROGLIO G, BENEDIKTSSON J A, MOSER G, et al. Automatic extraction of planetary image features[C]//Proceedings of 2009 IEEE International Conference on Space Mission Challenge for Information Technology. Pasadena CA: IEEE, 2009: 211-215.

|

| [72] |

MATTHIES L, HUERTAS A, CHENG Y, et al. Stereo vision and shadow analysis for landing hazard detection[C]//Proceedings of 2008 IEEE International Conference on Robotics and Automation. Pasadena CA: IEEE, 2008: 2735-2742.

|

| [73] |

SABATA B, AGGARWAL J K. Estimation of motion from a pair of range images:a review[J]. CVGIP:Image Understanding, 1991, 54(3): 309-324. DOI:10.1016/1049-9660(91)90032-K |

| [74] |

CHENG Y, JOHNSON A, OLSON C, et al. Optical landmark detection for spacecraft navigation[C]//Proceedings of 2003 AAS Spaceflight Mechanics Conference. Ponce PR: AAS, 2003: 1785-1803.

|

| [75] |

FROME A, HUBER D, KOLLURI R, et al. Recognizing objects in range data using regional point descriptors[C]//Proceedings of 8th European Conference on Computer Vision. Prague: ECCV, 2004: 224-237.

|

| [76] |

GASKELL R W. Automated landmark identification for spacecraft navigation[C]//Proceedings of AAS Astrodynamics Specialists Conference. Quebec QC: AAS, 2001: 1749-1756.

|

| [77] |

LUCAS B, KANADE T. An iterative image registration technique with an application to stereo vision[C]//Proceedings of 7th International Joint Conference on Artificial Intelligence. Vancouver: IJCAI, 1981: 674-679.

|

| [78] |

SUN D, CRASSIDIS J L. Observability analysis of six-degree-of-freedom configuration determination using vector observations[J]. Journal of Guidance, Control, and Dynamics, 2002, 25(6): 1149-1157. DOI:10.2514/2.4995 |

| [79] |

MORTARI D, ROJAS J, JUNKINS J. Attitude and position estimation from vector observations[C]//Proceedings of AAS/AIAA Spaceflight Mechanics Conference. Maui: AAS, 2004.

|

| [80] |

HARALICK B M, LEE C N, OTTENBERG K, et al. Review and analysis of solutions of the three point perspective pose estimation problem[J]. International Journal of Computer Vision, 1994, 13(3): 331-356. DOI:10.1007/BF02028352 |

| [81] |

LI Shuang, CUI Pingyuan, CUI Hutao. Vision-aided inertial navigation for pinpoint planetary landing[J]. Aerospace Science and Technology, 2007, 11(6): 499-506. DOI:10.1016/j.ast.2007.04.006 |

| [82] |

PHAM B V, LACROIX S, DEVY M. Vision-based absolute navigation for descent and landing[J]. Journal of Field Robotics, 2012, 29(4): 627-647. DOI:10.1002/rob.21406 |

| [83] |

KIM J, SUKKARIEH S. Autonomous airborne navigation in unknown terrain environments[J]. IEEE Transactions on Aerospace and Electronic Systems, 2004, 40(3): 1031-1045. DOI:10.1109/TAES.2004.1337472 |

| [84] |

BONIN-FONT F, ORTIZ A, OLIVER G. Visual navigation for mobile robots:a survey[J]. Journal of Intelligent and Robotic Systems, 2008, 53(3): 263-296. DOI:10.1007/s10846-008-9235-4 |

| [85] |

COCAUD C, KUBOTA T. Autonomous navigation near asteroids based on visual SLAM[C]//Proceedings of the 23rd International Symposium on Space Flight Dynamics. Pasadena, CA: JPL, 2012.

|

| [86] |

COCAUD C, KUBOTA T. SLAM-based navigation scheme for pinpoint landing on small celestial body[J]. Advanced Robotics, 2012, 26(15): 1747-1770. DOI:10.1080/01691864.2012.685227 |

| [87] |

COCAUD C, KUBOTA T. SURF-based SLAM scheme using octree occupancy grid for autonomous landing on asteroids[C]//Proceedings of the International Symposium on Artificial Intelligence, Robotics and Automation in Space. Sapporo: SAIRAS, 2010: 275-282.

|

| [88] |

MOURIKIS A I, ROUMELIOTIS S I. A multi-state constraint Kalman filter for vision-aided inertial navigation[C]//Proceedings of 2007 IEEE International Conference on Robotics and Automation. Roma: IEEE, 2007: 3565-3572.

|

| [89] |

GURFIL P, ROTSTEIN H. Partial aircraft state estimation from visual motion using the subspace constraints approach[J]. Journal of Guidance, Control, and Dynamics, 2001, 24(5): 1016-1028. DOI:10.2514/2.4811 |

| [90] |

INDELMAN V, GURFIL P, RIVLIN E, et al. Real-time vision-aided localization and navigation based on three-view geometry[J]. IEEE Transactions on Aerospace and Electronic Systems, 2012, 48(3): 2239-2259. DOI:10.1109/TAES.2012.6237590 |

| [91] |

ZHAO Shiyu, LIN Feng, PENG Kemao, et al. Homography-based vision-aided inertial navigation of UAVs in unknown environments[C]//Proceedings of AIAA Guidance, Navigation, and Control Conference. Minneapolis: AIAA, 2012.

|

| [92] |

AMZAJERDIAN F, PETWAY L B, HINES G D, et al. Lidar sensor for autonomous landing and hazard avoidance[C]//Proceedings of AIAA Space Conference and Exposition. San Diego: AIAA, 2013: 172-182.

|

| [93] |

MAKI J N, BELL J F, HERKENHOFF K E, et al. Mars exploration rover engineering cameras[J]. Journal of Geophysical Research, 2003, 108(E12): ROV12(1-24). |

| [94] |

MCGEE T G, SHANKAR U, SHAPIRO S, et al. Performance analysis of the APLNav system for passive optical Lunar navigation[C]//Proceedings of AIAA Guidance, Navigation, and Control Conference. Ⅲinois: AIAA, 2009.

|

| [95] |

POLLARD A M, MCGEE T G. Design considerations for a guidance, navigation, and control sensors system for a robotic Lunarlander[C]//Proceedings of 2011 IEEE Aerospace Conference. Big Sky: IEEE, 2011.

|

| [96] |

WHITE M, CRISS T, ADAMS D. APLNav terrain relative navigation helicopter field testing[C]//Proceedings of AIAA Guidance, Navigation, and Control Conference. Ⅲinois: AIAA, 2009.

|

| [97] |

PARKES S, DUNSTAN M, MATTHEWS D, et al. LIDAR-based GNC for planetary landing: simulation with PANGU[C]//Proceedings of DASIA 2003. Prague: ESA Publications Division, 2003: 151-162.

|

| [98] |

DUBOISMATRA O, PARKES S, DUNSTAN M. Testing and validation of planetary vision-based navigation systems with PANGU[C]//Proceedings of International Symposium on Space Flight Dynamics. Toulouse: ISSFD, 2009.

|

| [99] |

QUADRELLI M B, WOOD L J, RIEDEL J E, et al. Guidance, navigation, and control technology assessment for future planetary science missions[J]. Journal of Guidance, Control, and Dynamics, 2015, 38(7): 1165-1186. DOI:10.2514/1.G000525 |

2016, Vol. 48

2016, Vol. 48