2. 综合交通运输智能化国家与地方联合工程实验室,成都 610031

2. National United Engineering Laboratory of Integrated and Intelligent Transportation, Chengdu 610031, China

在智能视频监控领域,为了得到较为完整的前景目标物,大多采用背景差法[1].背景是场景中较为固定的部分[2].特别是在交通视频中,无法直接获取背景,需要进行背景重建.因此,背景建模是视频智能识别的一项关键技术.目前,国内外的研究已经提出大量建模方法.但对于复杂环境,如:前景目标物较多,背景有扰动等,这些方法获取的前景目标物不太理想,直接导致前景目标物的误检和漏检.在交通场景中导致对交通流参数的统计不准确,从而智能交通监测、交通流预测以及交通事故预警等方面的效率低下.所以,如何通过建立完整的背景模型而获取较好的前景目标物识别效果在交通视频智能监控中非常关键.

目前背景建模方法建立在统计学基础上.从模型参数层面可分为参数建模和非参数建模两类[3],从建模面积层面可分为像素建模和子块建模两类[4],从时空层面可分为时域建模和空域建模两类[1]等.从不同角度亦可以构建不同的模型,目前使用较多的是结合多个角度来构建联合模型[1, 4],所得模型效果较相对单一的模型要好.

早期采用较多的方法为均值法和中值法[5].这两种方法属于时域范围的基于像素的非参数建模方法.由于方法简单,到目前仍然在一定程度上使用.但前景目标物较多时,背景出现拖尾现象[6].之后Stauffer等[7]提出了混合高斯模型(mixture of Gaussian,MOG),属于时域范围的基于像素的参数方法.由于采用学习策略来适应背景变化,对缓慢变化的背景效果较好,因而得到了广泛使用.但对突变背景(如光照、天气的突变)容易把背景和噪声检测为前景目标,对较多的前景目标物常出现严重拖尾现象,且算法较为复杂[6],对突变的多背景的效果不佳.针对多背景,Kim等[8]采用码本(codebook,CB)建模法,该方法是时域范围的基于像素的非参数建模方法.但其需要记录图像像素,占用存储空间较大.以上基于像素的建模方法至今使用的仍然很多,但单个像素的考虑和甄别,割裂图像的空间特性,导致前景目标物不完整,故而导致误检和漏检.早在1979年,Robert Mitchell等就提出块编码(block truncation coding,BTC)方法[9],主要用于图片编码和解码.但解码出来的图像与编码前的图像相比存在明显分块,特别是图像的边缘,不是很准确. Marko Heikkila等[10]把局部二值模式(local binary pattern, LBP)用于背景提取,这是一种空域的基于子块的非参数的背景建模法,可以识别前景目标和背景.张玲等[11]证实了LBP算子对阴影的检测非常有效.但是LBP算子直方图维数为2P(其中p为选取为领域点的数量),p越大,维数越高.为减少维数,Heikkila等[12]提出了对称二值模式算子(center-symmetric local binary pattern,CSLBP),直方图维数仅为2p/2,但这种方法目标前景的边缘可能包含较多背景. Lingfeng Wang[13]等采用自适应εLBP方法,但所需参数太多,且很多参数需要进行预先测定.考虑到图像同时具有时域和空域的特性,Guo J.M.等[14]把CB建模法用于分块的方法上.但该方法得出的前景目标出现块状特征.解文华等[4]提出对前景目标物的边缘采用高斯建模的方式进行判断,得到较为光滑的前景目标物边缘.但该方法对前景目标进行像素级高斯建模,对移动较快的前景目标物边缘判断不是很准确.其他非参数模型方法还有核密度估计方法[15]以及目前使用较多的低秩矩阵方法[16-17].但这两种方法均需要进行较多帧的训练,且对多背景的情况效果不是很好.

综上所述,为达到实时要求,目前使用较多的仍然是非参数模型,同时兼顾时域和空域进行背景建模,获取前景目标物.为了解决目标物提取不完整以及变化背景的问题,本文从空域考虑使用分块的方法,从时域考虑采用多层策略,借鉴CSLBP获取纹理的方法以及Guo J. M.等[13]的分块CB建模方法,提出一种多层分块建模法来进行背景建模.这种方法对于多背景、局部和整体变化等效果都进行了考虑,因此比起传统方法在背景建模方面具有较好效果.由于采用了多层的方法,对于较大块和较小块背景进行层层分离,在计算速度和前景分割方面均有较好的效果,此外,采用多背景策略,对于变化的背景亦能进行较好识别.文中第1部分对分块建模法进行了简单介绍.为了验证本文方法的可行性,在第2部分对分块建模法进行了测试,同时与LBP、CSLBP、CB、MOG以及LRM算法进行了比对,并分析了测试结果.最后进行了总结.

1 多层分块建模法为了粗区分图像上的背景和前景,利用帧差法可以快速获取运动目标的特征,对于运动较慢的目标物,前后两帧直接相减容易目标消失,采用间隔帧差法可以改善,得到初始帧.把初始帧分成M×M块,由于分块面积较大,不存在目标物成为背景的情况,采用块均值来对前景和背景进行判断.对均值为0的块标记为背景,采用CSLPB方法得出直方图,并用分块CB方法记录特征向量.对均值不为0的块不进行标记,找完所有块则输入下一帧,在下一帧中继续寻找之前未进行标记的块.直到已经不能再找出任何一个m×m的背景块时,对不能标记的块再分为N×N块进行背景块寻找,直到不能再分成小块(最小块为9×9) 时对剩余位置进行CSLBP直方图和CB特征向量的提取,得到一副完整的直方图和特征向量.此时,训练完成,进入识别部分.读入新的一帧,用背景差法得到一个检测帧,匹配该帧每一部分的CSLBP直方图以及CB特征向量,得出是前景还是背景的判断,如果是背景则进行相应的背景的更新.

对多层分块建模法中涉及到的带阈值的间隔帧差法、CSLBP算法、分块CB算法以及本文提出的多层分块建模法的详细步骤,在下面将一一进行介绍.

2 带阈值的间隔帧差法帧差法[2]利用运动的目标前景在不同帧上产生不同边缘的原理来进行前景和背景的粗分割.这种方法极其简单,运行速度快,在交通视频识别中使用较多.但其能获取运动目标的边缘,运动目标提取不完整,大量空洞导致误检.对前景目标移动缓慢时,使用前后两帧直接相减较难获取目标物边缘,导致漏检.考虑到这种情况本文算法采用相隔N帧的图像进行帧差,对前景目标进行粗检测.相隔N帧减少了移动缓慢目标物的影响,同时,帧差法得到的前景目标物在一定的分块范围内会存在多多少少的残留物,不容易被认为是背景.此外,由于时间和光线的微弱变化,在不同的视频帧中的同一背景的像素会稳定在一定的区域范围内,因而,本文方法引入阈值计算.具体计算公式为

| $ F\left( {i,j} \right) = \left\{ {\begin{array}{*{20}{c}} {255,\left| {{f_2}\left( {i,j} \right) - {f_1}\left( {i,j} \right)} \right| > {\delta _1};}\\ {0,\left| {{f_2}\left( {i,j} \right) - {f_1}\left( {i,j} \right)} \right| < {\delta _1}.} \end{array}} \right. $ | (1) |

式中:f1(i, j)、f2(i, j)分别为相隔N帧的两幅视频帧;F(i, j)为相减后的运动前景目标图像帧;δ1为阈值.在F(i, j)中,大于δ1δ1的像素点为前景目标点,小于δ1的为背景点,直接设定为0.文中δ1的设定采用经验值20.

3 CSLPB算子Heikkila等[12]的CSLBP算子可以对块的区域进行纹理计算,直接记录该块的纹理.同时考虑到阴影仅仅是对于背景物的光线变化,对于背景物的纹理是不变的特征,该方法对阴影有很好的识别.交通视频大多在户外拍摄,存在大量的阴影,采用CSLBP算子可以进行前景目标物阴影的去除.本文利用CSLBP算子的特征,采用该方法来对背景纹理进行记录,以方便对背景、前景的区分与识别. CSLBP算子是从LBP算子改进而来,因此在介绍CSLBP之前有必要先介绍LBP算子.

LBP算子采用灰度信息中局部邻域关系模式来描述纹理[10].纹理可以表示为向量T=t(gc, g0, g1), …, gp-1),其中,gc为中心点,gi=(i=0, 1, 2, …, p-1) 表示以gc为中心的邻域点.领域点的选择对于LBP算子提取的纹理准确性至关重要.理论上p选取越多获得的纹理越为准确.但p越多,意味着以2p为维数的直方图的维数越高.直方图维数越高计算量也就相应越大.故而p的选取一般为8较为合适. LBP算子以gc像素值为阈值对gi点作二值化处理,如式(2)、(3) 所示.

| $ \mathit{\boldsymbol{T}} \approx t\left( {s\left( {{g_{\rm{c}}},{g_0}} \right),s\left( {{g_{\rm{c}}},{g_1}} \right), \cdots ,s\left( {{g_{\rm{c}}},{g_{p - 1}}} \right)} \right). $ | (2) |

| $ s\left( {{g_{\rm{c}}},{g_i}} \right) = \left\{ \begin{array}{l} 1,{g_{\rm{c}}} \le {g_i};\\ 0,{g_{\rm{c}}} > {g_i}. \end{array} \right. $ | (3) |

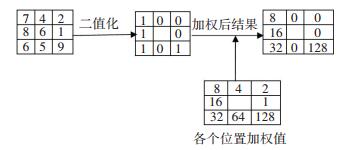

经过二值化处理的像素得到一个二值向量,对向量的各个元素使用因子2i的进行加权.加权后的向量用式(4) 对其求和,得到一个LBP纹理阈值BLBP.此处算法如图 1所示.通过计算,得到gc点的LBP阈值,BLBP=8+16+32+128=184.

| $ {B_{{\rm{LBP}}}}\left( {{g_{\rm{c}}}} \right) = \sum\limits_{i = 0}^{p - 1} {s\left( {{g_{\rm{c}}},{g_i}} \right){2^i}} . $ | (4) |

|

图 1 BLBP算法 Figure 1 BLBP algorithm |

对图像上每个像素点求其BLBP值,得到一个P维的直方图.随着像素点的P维增加,产生的直方图维数激增.为此,Heikklia等[12]提出了CSLBP纹理模型. CSLBP模型是对称的LBP模型,是LBP模型的改进.其算法仅仅与中心gc对称的邻域点(如g0和g4,g1和g5)有关,算法如图 2所示,BCSLBP=1+2+4+8=15.

|

图 2 BCSLBP算法 Figure 2 BCSLBP algorithm |

当P=8、R=3时,使用直方图进行区域纹理描述时,LBP维数为2p, 而CSLBP维数为

|

图 3 p=8, R=3时的抗噪示意图 Figure 3 The diagram of anti-noise(p=8, R=3) |

输入新的一帧时,对于可能是背景的部分,直接比对直方图,采用巴氏距离(Bhattacharyya distance)进行匹配,其计算公式为

| $ d\left( {{H_1},{H_2}} \right) = \sqrt {1 - \sum\nolimits_i {\frac{{\sqrt {{H_1}\left( i \right) \cdot {H_2}\left( i \right)} }}{{\sum\nolimits_i {{H_1}\left( i \right)} \sum\nolimits_i {{H_2}\left( i \right)} }}} } . $ | (5) |

式中:H1为新输入帧的直方图,H2为已经存在的直方图.当距离d<D时认为达到匹配.其中D为经验阈值,D=0时认为全匹配,D=0.55时为半匹配,经过对多个视频进行检测发现,D=0.4时效果最好,故文中D取0.4.对于匹配的背景采用式(6) 进行更新匹配背景.其中α为学习因子.对于不匹配的背景则进行记录.

| $ {H_{1,t}} = \left( {1 - \alpha } \right){H_{1,t + 1}} + \alpha {H_{2,t}}. $ | (6) |

Guo J. M.等[14]利用CB算子[8]的思路,即使用码本中的码字来对视频帧中出现的像素进行记录,对每一个出现的像素给予一定的权重,直到检测完成后,对每一个码字的权重进行分析,对权重较大的码字认为是背景,权重较小的码字认为是前景,可以较好地解决多背景的情况.交通视频中在不同光线下呈现不同的背景,属于多背景视频,采用CB算子具有较好的适应性.但是CB算子针对的是每一个像素的统计,割裂前景目标物的完整性,故而采用子块策略.对每一子块采用BTC[9]的方法,对颜色特征采用特征向量V={μht,μhb,μlt,μlb}来表征[13].其中μht,μhb,μlt,μlb的计算公式分别为

| $ {\mu _{{\rm{ht}}}} = \frac{{\sum\limits_{i = 1}^I {\sum\limits_{j = 1}^J {\left( {{x_{ij}}\left| {{x_{ij}} \ge {\mu _{\rm{h}}}} \right.} \right)} } }}{{\sum\limits_{i = 1}^I {\sum\limits_{j = 1}^J {\left\{ \begin{array}{l} 1,{x_{ij}} \ge {\mu _{\rm{h}}}\\ 0,其他 \end{array} \right.} } }}, $ | (7) |

| $ {\mu _{{\rm{hd}}}} = \frac{{\sum\limits_{i = 1}^I {\sum\limits_{j = 1}^J {\left( {{x_{ij}}\left| {{x_{ij}} < {\mu _{\rm{h}}}} \right.} \right)} } }}{{\sum\limits_{i = 1}^I {\sum\limits_{j = 1}^J {\left\{ \begin{array}{l} 1,{x_{ij}} < {\mu _{\rm{h}}}\\ 0,其他 \end{array} \right.} } }}, $ | (8) |

| $ {\mu _{{\rm{lt}}}} = \frac{{\sum\limits_{i = 1}^I {\sum\limits_{j = 1}^J {\left( {{x_{ij}}\left| {{x_{ij}} \ge {\mu _{\rm{l}}}} \right.} \right)} } }}{{\sum\limits_{i = 1}^I {\sum\limits_{j = 1}^J {\left\{ \begin{array}{l} 1,{x_{ij}} \ge {\mu _{\rm{l}}}\\ 0,其他 \end{array} \right.} } }}, $ | (9) |

| $ {\mu _{{\rm{ld}}}} = \frac{{\sum\limits_{i = 1}^I {\sum\limits_{j = 1}^J {\left( {{x_{ij}}\left| {{x_{ij}} < {\mu _{\rm{l}}}} \right.} \right)} } }}{{\sum\limits_{i = 1}^I {\sum\limits_{j = 1}^J {\left\{ \begin{array}{l} 1,{x_{ij}} < {\mu _{\rm{l}}}\\ 0,其他 \end{array} \right.} } }}. $ | (10) |

式中F(i, j)为图像的第i行第j列的像素值.为了更好地表征亮度,本文把亮度划分为较高、高、低、较低4个档次,其中μht为较高亮度,μhb为高亮度,μlt为低亮度,μlb为较低亮度.式中μh、μl的计算公式分别为

| $ {\mu _{\rm{h}}} = \frac{{\sum\limits_{i = 1}^I {\sum\limits_{j = 1}^J {\left( {{x_{ij}}\left| {{x_{ij}} \ge \mu } \right.} \right)} } }}{{\sum\limits_{i = 1}^I {\sum\limits_{j = 1}^J {\left\{ \begin{array}{l} 1,{x_{ij}} < \mu \\ 0,其他 \end{array} \right.} } }}, $ | (11) |

| $ {\mu _{\rm{l}}} = \frac{{\sum\limits_{i = 1}^I {\sum\limits_{j = 1}^J {\left( {{x_{ij}}\left| {{x_{ij}} < \mu } \right.} \right)} } }}{{\sum\limits_{i = 1}^I {\sum\limits_{j = 1}^J {\left\{ \begin{array}{l} 1,{x_{ij}} < \mu \\ 0,其他 \end{array} \right.} } }}. $ | (12) |

式中:μh和μl分别为高亮度和低亮度;μ为该块的平均像素,计算公式为

| $ \mu = \frac{1}{{I \times J}}\sum\limits_{i = 1}^I {\sum\limits_{j = 1}^J {{x_{ij}}} } . $ | (13) |

每一个子块用k个特征向量{v0i, v1i, …, vki}表示,其中vki表示第i个子块的第k个特征向量.每一个特征向量赋给权重ωki. k越大,包含的背景就越多,但是k越大,计算量也就越大,针对背景的复杂程度一般k取3~5.初始化:v0i=vi, ω0i=1,v1i=v2i=…=vki=0,ω1i=ω2i=…=ωki=0.读入新一帧图像,对子块i用式(14) 计算欧式距离,如果(vti, vk, ti)小于距离阈值TD,则认为与背景匹配,否则进行背景添加.

| $ D\left( {v_t^i,v_{k,t}^i} \right) = \sqrt {\sum\limits_{j = 1}^4 {{{\left( {v_{tj}^i - v_{k,tj}^i} \right)}^2}} } . $ | (14) |

对于匹配的背景,采用当前子块的vti来对vk, ti进行更新,如式(15) 所示.式中αv为模型的学习因子.用式(16) 更新权重ωk, t+1i,其中αω为模型的学习因子,Mk配时为1,否则为0.更新完成后对权重归一化处理.

| $ v_{k,t + 1}^i = \left( {1 - {\alpha _v}} \right)v_{k,t}^i + {\alpha _v}v_t^i, $ | (15) |

| $ \omega _{k,t + 1}^i = \left( {1 - {\alpha _\omega }} \right)\omega _{k,t}^i + {\alpha _\omega }{M_k}. $ | (16) |

背景建模完成后,对新输入帧进行判断,匹配和修正背景模型的特征向量.

5 多层分块背景建模本文提出的多层分块建模分为背景训练和前景检测两个阶段,两个阶段顺序进行,首先通过训练阶段得出较为完整的背景模型,再进入前景检测阶段得到前景目标物.两个阶段的具体算法如下.

背景训练阶段:

步骤1 读入间隔N帧图像,采用帧差法得出的二值图.

步骤2 分为81×81的块,对于不能被81整除的部分则分为27×27和9×9的块.

步骤3 对每一块求取均值,均值为0则进行CB特征向量以及CSLBP特征值的记录.

步骤4 对该帧图像检查完成后继续间隔N帧后输入图像进行步骤1~3检查,直到找不到均值为0的块,进入步骤5.

步骤5 在帧差法得到的二值图上对剩余均值不为0的块分为27×27(不能分的除外),寻找均值为0的块进行记录.

步骤6 对该帧图像检查完成后继续间隔N帧后输入图像进行步骤5检查,直到找不到均值为0的块进入步骤7.

步骤7 在帧差法得到的二值图上对剩余的均值不为0的块分为9×9的块,寻找均值为0的块进行记录.

步骤8 对该帧图像检查完成后继续间隔N帧后输入图像进行步骤7检查,直到一帧图像完全寻找到为止.

在每一次新的二值图输入时,对之前已经找到过的块求均值,均值为0则进行CSLBP纹理直方图用巴氏距离如式(5) 进行比对,新出现的直方图进行记录. CB特征向量通过式(13)~(16) 进行比对,更新向量及权值

前景检测阶段:

步骤1 对输入帧采用背景差法求取二值图.

步骤2 对二值图每一个位置求取均值.

步骤3 均值为0则可能为背景,进行背景比对,如果是已经存在的背景则确认为背景,如果该背景不存在则进行CSLBP纹理和CB特征检测,只要有一个符合即认为是已有背景,否则进行记录和更新.对于均值不为0的部分进行CSLBP检测,如果不符合背景则认为是前景,如果符合背景纹理,则进行CB特征向量检测,如果也符合则认为是背景,否则认为是前景.

直到整帧图像检测完成,区分前景和背景.整个训练和检测的流程见图 4.

|

图 4 训练和检测目标算法流程图 Figure 4 Flow chart of training and detection algorithm |

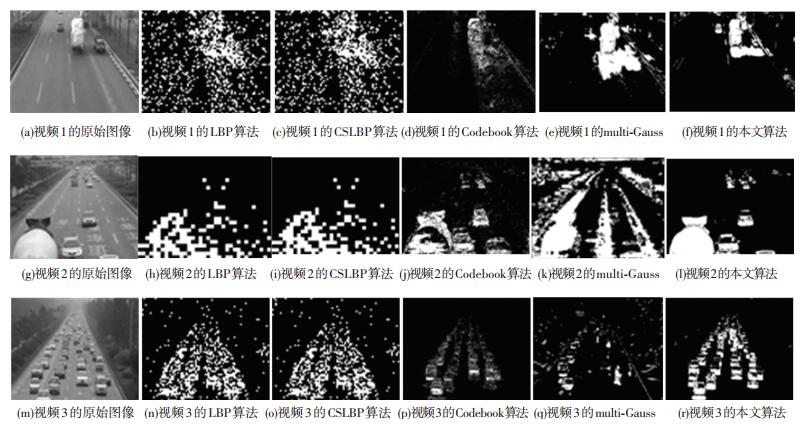

为检测本文算法,对本文算法进行了实验.对交通视频进行背景训练后进行前景目标识别,比对该帧的前景目标物,证实了本方法的可行性.为验证本文算法的有效性,将LBP、CSLBP、CB算法和multi-Gauss算法与本文算法进行了比较.在进行算法比对时采用的方法均为背景差法,算法实现均为前景训练和目标检测两个部分.

在实验阶段,测试平台处理器为Intel Core i5-4210,内存为4G,操作系统为Windows 7.本文采用的软件平台为Visual C++和Open CV.测试所使用的视频是从多个交通视频中提取出3个比较具有代表性的视频.选取的3个视频均为自行拍摄.选择时主要考虑了背景的复杂程度、不同的光线变化以及前景目标物数量等情况.以本文方法训练完成背景所需要的帧数作为采用5种方法获取背景所需帧数来对每一种方法进行背景建模. 5种方法均以完成背景建模所需帧数的下一帧作为测试帧来进行前景目标物提取,如图 5所示.

|

图 5 5种方法的目标物提取 Figure 5 Object extraction of five methods |

图 5中,从上到下,第1行到第2行图像分别为两个不同的视频.从光线变化的角度,视频1中光线变化较大,出现背景较多,且呈非周期性变化.视频2和视频3中光线变化较为稳定,无较大突变.从前景目标物的多少的角度来看,视频1中前景目标物相对视频2和视频3较少,视频3中的前景目标最多.采用本文方法获取背景帧数分别为4 263、6 375和9 135帧.图中所示图像分别为4 264帧、6 376帧和9 136帧.从左到右第1列为原始图像,第2列到第6列为4种方法提取的前景目标物图像.其中,第2列和第3列使用的LBP和CSLBP采用p=8,n=3(经过测试,n选择过小或者过大效果均不是很好).从图中可见,使用LBP方法和CSLBP方法所提取的前景目标基本相同,对比原图可以发现所提取的目标物不是很清晰,基本上呈现颗粒块状,体现了算法的子块状特征.第4列使用的CB方法采用的对每一个像素进行建模,K=3(经过测试,发现K>3包含太多前景,K<3则背景不足).如图所示,使用CB提取的前景目标基本准确,但是由于目标物的颜色有的时候和背景很相似,目标相比较不是很完整,呈现点状,这主要是由算法采用针对像素来进行分析造成的.第5列为multi-Gauss算法,其中高斯函数的个数采用5个.从图中可见,由于算法采用对像素的分析,与CB算法相似,得到的目标相对不是很完整.但是效果不如CB算法好,对多背景的提取效果不如CB算法.最后一列为本文方法提取的前景目标,从图中可见,前景目标提取较为清晰完整,不存在块状的情况.

为了客观评价模型的有效性,本文采用了普遍采用的打分的方式对模型进行打分[4],其中涉及到索引率和准确率.索引率指的是正确检测前景点占所有正确前景点的比率,准确率指的是正确检测前景点与所有检测的前景点的比率.这3个指标能够较为客观地评价算法, 计算公式分别为

| $ P = \frac{{{n_{{\rm{TP}}}}}}{{{n_{{\rm{TP}}}} + {n_{{\rm{FN}}}}}}, $ | (17) |

| $ R = \frac{{{n_{{\rm{TP}}}}}}{{{n_{{\rm{TP}}}} + {n_{{\rm{FP}}}}}}, $ | (18) |

| $ F = 2 \times \frac{{P \cdot R}}{{P + R}}. $ | (19) |

其中: F为打分的分值,P为索引率,R为准确率.式中,nTP为算法检测出的正确检测的前景点数,nFP为算法检测出的错误检测的前景点数,nFN为算法检测出的检测为背景的前景点数.各种方法的索引率P,准确率R以及打分结果F见表 1~3.

| 表 1 5种方法索引率P Table 1 Index rate P of five method |

| 表 2 5种方法准确率R Table 2 Correct rate R of five methods |

| 表 3 5种方法打分F Table 3 Scoring F of five methods |

从3个表中可见,本文算法索引率P,准确率R和打分F明显高于LBP、CSLBP、CB和multi-Gauss方法.其中,LBP和CSLBP两种算法的结果非常接近,说明这两种算法基本相似. CSLBP本身来源于LBP,CSLBP较好的继承了LBP的特性且计算量小于LBP算法. CB算法的索引率均低于LBP和CSLBP算法,但准确率却高于这两种方法,在最后总和打分结果中除了视频1中打分高于LBP和CSLBP算法外,其他两个视频的打分均低于这两个算法,但分数较为接近.说明在光线较为稳定状态下,CB算法对前景目标的识别比LBP和CSLBP算法要差一些,而光线变化较大时,则CB算法较好. Multi-Gauss除了视频3,在索引率结果中均高于CB、LBP和CSLBP算法,准确率除了视频两外均高于LBP和CSLBP算法,3个视频亦高于CB算法,打分则除了视频1以外,均低于3种算法.这主要是因为这CB和Multi-Gauss算法仅仅考虑了图像颜色,且是按照像素来进行检测的.而图像颜色与背景颜色较为相近时就会失效,出现漏检.由表 1~3中可见,本文方法在每一个视频中的索引率是最高,准确率除了视频3略低于CB算法外,其余均高于4种方法,最后的打分结果亦高于4种方法.这主要是因为本文方法结合了颜色和纹理的考虑,并且从整体到部分均进行了考虑,故而各项指标明显较好.

7 结论在间隔帧差法的基础上,采用多级分块的方法,结合CSLBP和codebook算法为视频背景建立模型.采用3个不同光线变化,不同背景以及不同前景的视频来对本方法进行检验,并与LBP、CSLBP、codebook以及multi-Gauss算法进行比对.结果证明,该建模算法对于前景目标物的提取效果较好,打分亦明显高于其他方法.该方法较好地解决了在交通视频中存在的多背景、过多运动目标的情况下的前景目标的识别.进一步提高了智能交通视频监控中前景目标的识别率,具有一定的实用价值.

| [1] |

储琚, 杨樊, 张桂梅, 等. 一种分步的融合时空信息的背景建模[J].

自动化学报, 2014, 40(4): 731-743.

CHU Ju, YANG Fan, ZHANG Guimei, et al. A stepwise background subtraction by fusion spatio-temporal information[J]. Acta Automatica Sinica, 2014, 40(4): 731-743. |

| [2] |

MARQUES O.

Practical image and video processing using MATLAB[M]. Beijing: Tsinghua University Press, 2011.

|

| [3] |

王溢, 赵春晖, 程咏梅. 基于区域相关的核函数背景建模算法[J].

计算机测量与控制, 2008, 16(5): 722-724.

WANG Yi, ZHAO Chunhui, CHEN Yongmei. Region-based correlation method of kernel background modeling[J]. Computer Mea-surement & Control, 2008, 16(5): 722-724. |

| [4] |

解文华, 易本顺, 肖进胜, 等. 基于像素与子块的背景建模级联算法[J].

通信学报, 2013, 34(4): 194-200.

XIE Wenhua, YI Benshun, XIAO Jinsheng, et al. Cascaded algorithm for background modeling using pixel-based and block-based methods[J]. Journal on Communications, 2013, 34(4): 194-200. |

| [5] |

刘瑞祯, 于世琪.

OpenCV教程[M]. 北京: 北京航空航天大学出版社, 2007: 110-138.

LIU Ruizhen, YU Shiqi. OpenCV program[M]. Beijing: Beihang University Press, 2007: 110-138. |

| [6] |

李海霞, 范红. 基于背景差法的几种背景建模方法的研究[J].

工业控制计算机, 2012, 25(7): 62-66.

LI Haixia, FAN Hong. Research of several background modeling based on background subtraction[J]. Industrial Control Computer, 2012, 25(7): 62-66. |

| [7] |

STAUFFER C, GRIMSON W E. Adaptive background mixture mo-dels for real-time tracking [C]. cvpr. IEEE Computer Science, 1999:2246.

|

| [8] |

KIM K, CHALIDABHONGSE T H, HARWOOD D, et al. Real-time foreground-background segmentation using codebook model[J].

Real-Time Imaging, 2005, 11(3): 172-185.

DOI: 10.1016/j.rti.2004.12.004 |

| [9] |

DELP E J, MITCHELL O R. Image compression using block truncation coding[J].

IEEE Transactions on Communications, 1979, 27(9): 1335-1342.

DOI: 10.1109/TCOM.1979.1094560 |

| [10] |

HEIKKLA M, PIETIKAINEN M. A texture-based method for mo-deling the background and detecting moving objects[J].

IEEE Tran-sactions on Pattern Analysis & Machine Intelligence, 2006, 28(4): 657-62.

|

| [11] |

张玲, 程义民, 葛仕明, 等. 基于纹理的运动阴影检测方法[J].

光电工程, 2008, 35(1): 80-84.

ZHANG Ling, CHENG Yiming, GE Shiming, et al. Moving shadow detection approach based on texture[J]. Opto-Electronic Engine-ering, 2008, 35(1): 80-84. |

| [12] |

HEIKKLA M, PIETIKAINEN M, SCHMID C. Description of interest regions with local binary patterns[J].

Pattern Recognition, 2009, 42(3): 425-436.

DOI: 10.1016/j.patcog.2008.08.014 |

| [13] |

WANG Lingfeng, WU Huaiyu, PAN Chunhong.

Adaptive εLBP for background subtraction[M]. Asian Conference on Computer Vision. Berlin Heidelberg: Springer-Verlag, 2010: 560-571.

|

| [14] |

GUO Jingming, LIU Yunfu, HSIA C H, et al. Hierarchical method for foreground detection using codebook model[J].

Circuits & Systems for Video Technology IEEE Transactions on, 2011, 21(6): 804-815.

|

| [15] |

ELGAMMAL A, HARWOOD D, DAVIS L. Non-parametric model for background subtraction[J].

Lecture Notes in Computer Science, 2000, 1843(2): 751-767.

|

| [16] |

WANG Lingfeng, PAN Chunhong. Effective multi-resolution background subtraction[J].

National Laboratory of Pattern recognition, 2011, 7882(1): 909-912.

|

| [17] |

LIU Xin, ZHAO Guoying, YAO Jiawen, et al. Background subtraction based on low-rank and structured sparse decomposition[J].

IEEE Transactions on Image Processing, 2015, 24(8): 2502-2514.

DOI: 10.1109/TIP.2015.2419084 |

2017, Vol. 49

2017, Vol. 49