2. 上海交通大学 机械与动力工程学院,上海 200240

2. School of Mechanical and Power Engineering, Shanghai Jiaotong University, Shanghai 200240, China

机械臂已经广泛应用于工业自动化领域,但大多数情况下,机械臂是在静态结构化环境下作业,即机械臂的作业过程是固定不变的,机械臂只需要重复运行预先离线编制好的程序即可完成预定作业任务[1].在未来智能工厂中,需要机械臂能够在动态变化的非结构环境下完成复杂作业任务,要求机械臂具有智能感知外部复杂环境、自主规划作业路径以及安全作业的能力.

视觉传感器作为非接触式外部传感器,可以感知机械臂在定位和跟踪任务中环境的动态变化[2].在视觉伺服中,通常将当前特征和期望特征之间的误差定义为反馈函数[3-4],通过视觉传感器反馈信息实时引导机械臂运动,使这个误差趋向于零.

根据误差函数的定义,现有的视觉伺服方法主要可以分为基于位置的视觉伺服(Position-Based Visual Servoing, PBVS)和基于图像的视觉伺服(Image-Based Visual Servoing, IBVS)两大类,前者将误差定义在三维笛卡尔空间,后者将误差直接定义在二维图像空间[5-6].

IBVS对相机标定和建模误差有着较好的鲁棒性、局部稳定性和收敛性[7].然而,IBVS却经常会遇到全局收敛性问题,尤其当目标初始位姿和期望位姿相差较大时,可能会导致视觉伺服失败[8].此外,当图像特征在相机视野之外也会导致伺服任务失败.当IBVS不能对机械臂和相机有效控制时,可能会因为机械臂与工作空间中的障碍物发生碰撞而导致机械臂无法执行预定操作.因为在大多数机械臂应用中都存在着目标的初始和期望位姿相差较大和多重环境约束,所以融合路径规划技术的IBVS策略可以改善视觉伺服过程的鲁棒性.

视觉伺服路径规划的主要思想是在特定动态非结构环境约束下规划和生成可执行的图像轨迹,然后驱动机械臂沿着规划的轨迹完成作业任务[9].

本文首先介绍存在于动态非结构环境视觉伺服路径规划中的两类重要约束,即相机/图像约束和机械臂/物理约束;其次,总结视觉伺服路径规划方法的研究进展,并分析各种路径规划方法存在的不足;最后,对未来的研究方向进行展望.

1 路径规划中存在的约束1998年,法国国家信息与自动化研究所(INRIA)的Chaumette[8]对基于位置的视觉伺服和基于图像的视觉伺服问题进行了研究,讨论了约束条件下的PBVS和IBVS可能存在的稳定性和收敛性问题,并将这些约束主要分为两大类:(1)相机/图像约束;(2)机械臂/物理约束.

1.1 相机/图像约束相机/图像约束主要是因为视觉系统感知限制,或者因为“在图像空间中特征的变化率”与“由包含图像特征的雅可比矩阵所定义的相机在笛卡尔空间中的移动速度”之间的相互关系.这些约束分为:相机视场限制,图像局部最小化,图像雅可比奇异.

1.1.1 相机视场限制任何相机的视场都是有限的,所获得的图像通常是有限的矩形区域.如果三维物体在相机的视场内,则其特征投影到相机图像平面是可见的.尽管IBVS控制直接定义在图像平面上,但是当核心特征在相机中的初始位姿与期望位姿相差很大时,容易造成特征不在相机视场内.

1.1.2 图像局部最小化IBVS中的图像局部最小化是由于不可实现的图像运动,造成的结果是相机速度为零,但图像误差并不能收敛到零[10].一般来说,不考虑相机与目标在初始及期望的相对位置直接判断是否会出现图像最小化是很困难的,导致在视觉伺服任务中反复耗费大量时间搜索图像中的局部最小化.但对于PBVS,因为任务函数定义在笛卡尔空间,所以不存在图像局部最小化问题.

1.1.3 图像雅可比奇异当出现图像雅可比奇异时,图像特征在图像空间的运动不能驱动机械臂实现相应运动. Chaumette[8]分析了当图像特征矢量由3个共线点组成或者3个点位于以相机光轴为轴线的圆柱面时,图像雅可比会出现奇异.虽然使用多于3个非共面点可以避免奇异,但是图像雅可比仍然可能出现奇异.例如,当视觉伺服任务中相机只绕其光轴旋转180°时,不论使用多少个特征点定义任务函数,都会导致雅可比奇异. Chaumette[8]也论证了使用线特征代替点特征有助于避免奇异,然而,却不能完全消除图像空间的奇异. 1997年,美国宾夕法尼亚州立大学的Sharma等[11]则提出了运动感知力的概念,并将其作为接近图像奇异的衡量标准.

1.2 机械臂/物理约束视觉伺服控制环中相机的运动不可避免地受到工作空间机械臂和物理障碍物的限制.这些约束包括:1)机械臂运动学,例如关节限制和机械臂雅可比奇异;2)机械臂动力学;3)与障碍物发生碰撞或者自身碰撞;4)由障碍物和机械臂本体引起的遮挡或者目标自身遮挡.

过去几十年来,大量科技人员投入到规划可行路径的研究中,以避免机械臂运动学或者动力学约束以及各种各样复杂环境中的物理障碍和自身碰撞[12-13].有些路径规划方法在需要保证目标可见的应用中同时也考虑了遮挡约束[14-15].

1.3 约束的处理方法自从Chaumette[8]阐述了经典的视觉伺服中存在收敛性和稳定性问题后,大量研究工作集中在如何将相机/图像约束、机械臂/物理约束这两大类约束集成在视觉伺服控制环中.

研究人员提出了解耦控制方法[16-20],即相机一部分自由度以IBVS方式控制,其余自由度用PBVS方式控制,充分利用了各自的优势,从而避免了以上提及的一部分约束.但每种解耦方法在考虑前述约束时都有各自的优缺点.美国伊利诺伊大学的Gans等[21]则用IBVS详细比较了以上解耦方法的性能和效率.受混合系统理论的启发,一些研究人员提出了由不同视觉伺服控制器组成的混合策略和切换规则[22-25],在需要时可切换相应控制器.切换策略增强了经典视觉伺服的稳定性区域,同时可以在不稳定的控制器之间切换,提高总体系统的稳定性.

针对在视觉伺服过程中目标特征可能不在相机视野内的问题,南开大学刘玺[26]提出了一种移动机器人自适应主动视觉伺服方法.中国农业大学张春龙[27]设计了具有圆柱面相机运动空间的主动视觉系统,研究了基于粒子群优化算法(PSO)的主动视觉伺服最佳取景方位搜索策略,仿真实现了果树点云空间的主动视觉最佳取景方位搜索.南京航空航天大学刘玉月等[28]分析了基于视觉伺服的手部跟踪技术,并针对Stewart机器人的动力学模型进行了仿真实验,结果表明该方法能够利用主动视觉解决手部跟踪运动过程中的自遮挡问题,能够完成手部跟踪的任务.南开大学李保全等[29]针对单目视觉非完整移动机器人系统,提出了一种基于主动视觉选择策略的视觉伺服镇定控制方法,从而使目标特征处于相机的视野内.

上述每一种解耦或者混合策略以及主动视觉策略都只是解决了其中一部分约束问题.在视觉伺服控制环中,融合相机/图像约束和机械臂/物理约束(这两类约束在动态非结构环境中确实同时存在)是非常具有挑战性的.因此,在视觉伺服控制中融合路径规划以解决上述约束问题是非常必要的.

2 视觉伺服路径规划视觉伺服路径规划的主要思想是在考虑上述所有约束条件下规划和生成可行的图像轨迹,然后以IBVS驱动机械臂沿着规划的轨迹进行作业[30].通过将较大的初始误差离散化,使得在每个伺服周期中的误差足够小,从而能够充分地利用IBVS出色的局部稳定性与鲁棒性[31].

根据路径规划方法特点和所做的假设,与视觉伺服相结合的路径规划方法可以分为以下5类:1)图像空间路径规划;2)基于优化的路径规划;3)基于势场法的路径规划;4)全局路径规划;5)不确定性下视觉伺服路径规划.

2.1 图像空间路径规划图像空间路径规划技术旨在初始图像和期望图像之间插入一条路径而不需要任何相机标定或者目标模型.这种方法的难点在于规划的图像空间路径可能不会对应唯一的相机路径.所以,学者们又研究了规划图像路径对应无标定环境中可执行的相机路径.其中,对极几何、射影单应性和射影不变性等射影几何知识被应用于图像空间路径规划中.

2.1.1 对极几何1995年,日本大阪大学Hosoda等[32]基于定义在由机械臂末端的立体相机(眼在手上配置)获得图像中的对极几何约束,直接在图像空间中设计视觉伺服轨迹生成器,然后利用基于雅可比估计器的无标定视觉伺服控制器跟踪规划好的图像轨迹,从而实现了在不需要任何系统或者相机标定等先验知识的前提下,保证机械臂末端执行器能够在未知环境中避开障碍物.

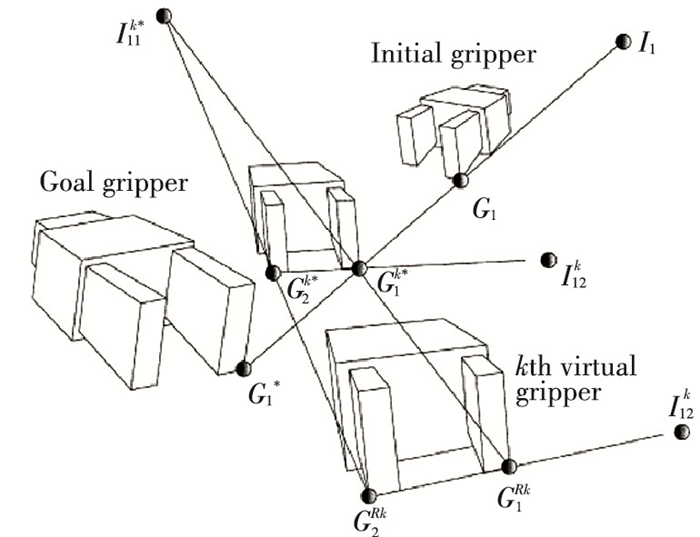

2003年,澳州国立大学Hartley等[33]通过给定同一场景的多个视角,也采用对极几何研究了无标定视觉伺服问题.在没有目标物体的任何三维信息的情况下,韩国先进科技学院Park和Chung[34]提出了基于眼在手外的立体视觉抓取场景中的无标定图像空间路径规划方法,在初始图像和期望图像的射影空间中利用对极几何沿着一条直线生成机械臂手爪的一系列中间视图,这些中间视图组成期望的图像轨迹,然后利用法国国家信息与自动化研究所(INRIA)的Espiau等[35]提出的IBVS方法控制机械臂沿着图像轨迹运动,机械臂跟随轨迹的同时,手爪可以在三维工作空间走直线,整个运动过程中手爪的特征点始终处在相机视野内,如图 1所示,可以看出末端执行器手抓虚拟点始终沿着直线运动,而未逃离相机视野.

2.1.2 射影单应性法国国家信息与自动化研究所一直致力于图像空间路径规划方面研究工作.为了避免计算可行相机路径依赖于相机标定和目标模型,1993年,该研究所的Faugeras[36]使用初始图像和期望图像建立射影几何关系,由于定义在射影空间,相机在欧几里德空间的位移可以部分参数化,而不需要显式重建欧几里德空间分量.射影单应性矩阵可以被应用在路径规划方法中,它体现了同一场景不同视野之间的关系,可以从两幅图像中的点、线、面和轮廓等特征估计得到[37-38].

2003年,INRIA的Mezouar等[39]又提出一种在初始图像和期望图像之间插入共线矩阵来获得封闭的共线路径的无标定路径规划方法,使用IBVS跟踪求导后的图像特征轨迹.然而,这种方法在存在视野约束时却不能保证收敛到期望位置.法国巴黎第六大学Schramm等[40]则在上述研究基础上引入了可见性约束来扩展这种方法,通过引导目标上任意选择的参考点在图像中沿着直线运动,从而保证参考点始终处于相机视野内.由此带来的问题是,相机不再沿着直线运动,并且其他特征也可能会不在相机视野内,所以设计了深度模块,通过控制相机沿着光轴后退来保证无论何时一个特征到达相机视野边界时,其它特征都实时可见.

一些研究人员采用分解欧几里德单应性矩阵的方法来规划图像路径,从而生成可执行的相机路径而不需要笛卡尔空间相机路径的重建.例如,拉彭兰塔科技大学Kyrki等[41]提出一种基于单应性矩阵部分位姿估计的最短路径规划方法,该方法直接沿着单应性矩阵分解得到的方向移动手眼相机到达工作空间的期望位姿,同时保证位于目标物体中心虚拟点的可见性.佛罗伦萨大学Allotta等[42]提出一个类似的基于单应性分解的方法,选择螺旋线路径代替直线路径作为参考路径来表示相机从初始位姿到期望位姿的平移运动.威斯康星大学麦迪逊分校Borgstadt等[43]使用特殊的单应性矩阵分解为一个已知模型的平面目标,从初始图像到期望图像之间插入一条路径.由于目标模型已知,利用三维重建将插值好的期望路径转换到相机可执行的不与工作空间边界碰撞的路径.

2.1.3 射影不变性2001年,法国雷恩大学Malis[44]提出一个通过射影变换定义在不变空间中的基于图像的路径规划方法.射影不变性的基本思想是构建一个相对相机内参数不变的任务函数,只依赖于相机的位置相对观测目标和它的3D结构.这使得在不变空间生成的特征矢量路径独立于相机内参数,同时对应相机在工作空间的路径是一条直线.此外,视觉系统安装电机驱动伸缩平台可以保证特征的可见性.

综上所述,直接在图像空间路径规划的主要优势在于无需考虑相机标定和目标模型;但是,由于在图像空间规划路径,所以这些方法不能很好解决复杂视觉伺服场景中的机械臂/物理约束.

2.2 基于优化的路径规划在视觉伺服任务中,可能同时存在许多不同的相机路径,研究人员总是设法规划出优化的机器人路径.优化技术旨在从成本函数(图像边界距离,路径长度和能量消耗等)中找到一条优化的路径.

Mezouar等[39]以最小能量和最小加速度为优化目标在图像空间规划相机路径,在初始和期望图像之间插入中间图像,该方法保证了收敛性,却没有考虑可见性约束.因此,图像特征可能会不在相机视野内.

1997年,美国宾夕法尼亚州立大学Sharma等[45]提出了基于感知控制流形(Perceptual Control Manifold, PCM)的眼在手外的路径规划框架,PCM定义了机械臂关节空间和目标物体图像空间组成的内积空间. PCM被认为是从机械臂构型到可见图像特征矢量的一种映射,可以将相机视野约束和机械臂关节限制以及障碍物映射到PCM可解空间;但是,考虑到约束的数量和机械臂的自由度,这种映射相当耗时.所以又提出各种优化准则(比如最小速度、最小拦截时间和最少机械臂运动),在一系列可行的PCM中找到最优路径.优化后的PCM方法结合全局场景的视觉伺服可以用在拦截一个轨迹已知的运动物体,而固定相机则可以同时观察到机械臂末端执行器和运动目标.

2002年,美国罗文大学Zhang等[46]提出的视觉运动规划方法用一系列等式和不等式描述机器人沿着视场边界的运动约束,可以为移动机器人满足可见性约束下规划出最优的路径.利用拉格朗日数值求解器解决优化问题,从而通过最小化已知权重的动能函数和来获得最优的图像路径,但是该方法只能应用在二维和三维环境下的移动机器人.

为了解决基于优化的视觉伺服路径规划方法中存在的问题,也有研究者引进各种参数化相机路径的方法. 2007年,意大利锡耶纳大学Chesi等[47]利用多项式系数参数化相机路径,通过线性插值得到相机的平移路径,再通过凯利旋转表示法径向参数化相机的旋转路径,使图像中的单一路径离图像边界的距离很容易由多项式的根计算得到.因此,优化问题等价转化为在所有参数化路径中最大化图像边界距离.在跟随规划好的图像路径时,假如相机没有标定误差,相机将会在工作空间跟随一条直线.而事实上,标定误差是必然存在的,相机则不会走直线而是沿着不同的曲线移动,曲线离规划的直线的距离也会随着标定误差的增大而变大.

Chesi等[48]提出一种以最小化图像面积、轨迹长度和曲率为优化目标,同时考虑相机视野、工作空间和关节限制约束的路径规划方法.设计了多项式参数化所有连接相机初始位姿和期望位姿的路径,相机位姿则是通过图像测量和目标模型的三维重建获得.此外,设计的非凸型优化方法导致了多个可行区域,并且每个区域存在多个局部最优解.因此,在所有可行区域中找到全局最优解是非常困难的. Chesi[49]还通过齐次形式参数化从初始位姿到期望位姿的路径.利用合适的正则齐次形式建立约束模型,通过求解凸优化的线性矩阵不等式(LinearMatrixInequalities, LMI)获得了合理可执行的路径,从而使得期望的性能最优:包括特征离图像边界的距离、相机离障碍物的距离以及规划的路径尽可能成直线.

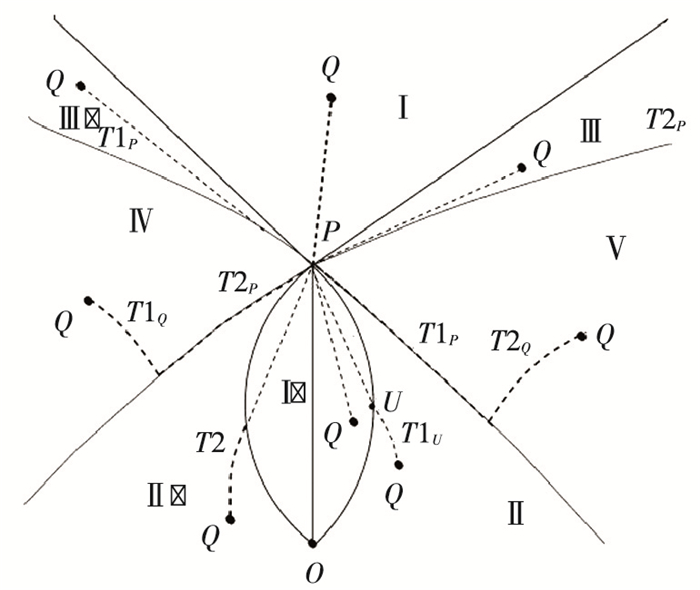

2007年,伊利诺伊大学香槟分校Bhattacharya等[50]针对差分驱动机器人(Differential Driving Robot, DDR)利用最优控制理论设计图像轨迹,使其位于相机视野之内并满足路标的可见性,再将图形轨迹映射到笛卡尔空间,生成由直线和T型曲线构成的最短路径,图 2给出了生成的T型最短路径,同时保证了可见性约束.

西班牙萨拉戈萨大学Lopez-Nicolas等[51]设计了基于单应性矩阵元素的收敛性的切换视觉伺服控制器来跟踪这些最短路径.法国图卢兹大学Hayet等[52]在杂乱障碍物环境下为DDR设计了完备的运动规划器,将最优曲线段作为运动基元设计局部最优路径,从而满足障碍物和可见性约束下DDR路径是可执行的.但是,由于障碍物被假定为透明的,所以忽略了障碍物引起的遮挡问题.意大利比萨大学Salaris等[53]则将Bhattacharya等[50]研究的图像空间中获得的最优曲线进行了扩展,以便利用IBVS控制器可以直接在图像空间执行,实现了通过李雅普诺夫函数(Lyapunov Function)使得图像中沿着这些最优路径运动的反馈控制.然而,对于DDR,所有最短路径的完整特性和它们的解析描述仍没有得到完全解决.

加拿大康考迪亚大学Keshmiri等[54]提出了基于优化预定义的轨迹规划方法,通过最小化图像特征误差函数获得轨迹参数,利用深度估计算法为目标轨迹规划提供深度信息,再利用视觉控制器补偿期望特征匹配时产生的误差,从而生成了满足系统始末条件的轨迹,该规划方法的优势在于将位置规划和姿态规划解耦,同时获得了末端执行器的速度旋量.

2017年,西安航空学院马翔宇等[55]通过非线性优化算法对其最短路径进行优化设计,计算其最短路径下各关节对应的旋转角度和移动距离,并对其稳定性进行了分析.

尽管以上基于优化的路径规划方法考虑了实际问题的复杂性并生成了最优路径,但是这些方法仍或多或少局限于简单场景和系统.引入机械臂/物理约束很大程度上增加了优化问题的复杂性,因此,在以上优化框架中考虑上述约束也大幅度增加了时间的复杂度.

2.3 基于势场法的路径规划人工势场法在机械臂路径规划领域中被认为是一种很有前途的快速局部避障策略,可以为机械臂在约束环境下规划出实时安全的运动路径[56],主要思路是构建人工势能场,“吸引势能之和”吸引机械臂朝向期望位置,“排斥势能之和”使机械臂远离各种约束(例如障碍物和机械臂关节限制),最终机械臂将沿着势场负梯度方向到达目标位置[57].

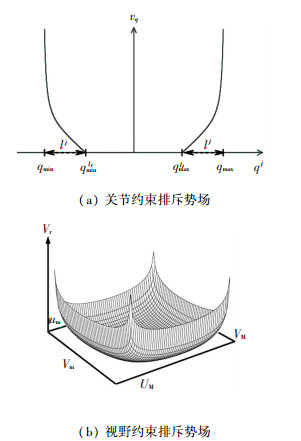

Mezouar和Chaumette[30]研究了基于势场法的手眼机械臂图像视觉伺服控制,考虑了相机视野和机械臂关节限制两种约束(如图 3所示),分别给出人工势场随着关节角度和图像视野的变化关系.为了获得合理的机械臂轨迹,首先在工作空间规划机械臂运动,然后投影到图像空间.定义在工作空间的吸引势场将机械臂拉向最终期望位姿,考虑到以上约束,排斥势场定义在图像空间和关节空间驱使图像轨迹远离图像边界和避免关节限制.所以,作用在机械臂总的合力是吸引势能和排斥势能沿负梯度方向计算得到各自分力的权值之和.图像轨迹将会沿着机械臂合力方向生成,然后随着时间离散化之后,最终可以用IBVS方法跟踪这些图像轨迹.以上策略可以应用在已知或者未知模型的目标,针对后者情形,利用欧几里德重建可以获得工作空间的相机路径,沿着特征轨迹的当前期望的图像特征来更新图像雅可比,可以自动避免图像局部最小化.

|

图 3 人工势场随着两种约束的变化关系[30] Figure 3 Variation of artificial potential field with two kinds of constraints[30] |

基于势场法的路径规划方法在添加实际物理约束(如避障、遮挡)则总势场非常有可能陷入局部最小化.为了避免吸引力与排斥力之和引起的局部最小化,1985年,加拿大滑铁卢大学Kirkpatrick等[58]利用模拟退火的方法调节初始温度和冷却速率来保证收敛到全局最小化.提出的规划框架采用了两种不同轨迹生成策略:方法一是相对静止的目标坐标系规划末端执行器轨迹;方法二则是相对当前末端执行器坐标系规划目标轨迹.前者生成的相机路径在工作空间近乎直线,而后者目标原点的图像轨迹受到约束,在图像中沿着近乎直线运动,减小了图像特征不在相机视野内的几率.

针对人工势场法可能会进入局部极小这一缺陷,中国海洋大学唐彪等[59]通过添加虚拟目标点来改进人工势场法.该方法可以让机械臂逃离局部极小点,实现机械臂的避障路径规划.

中国农业大学赵栋杰[60]针对喷雾机器人的连续运动作业模式,提出了一种基于改进势场法的喷雾机械臂运动规划对靶实时控制算法,该算法在传统势场法基础上引入了速度势场、视场约束和关节极限位置约束,可规划出更优的喷雾机械臂运动轨迹,有效提高喷雾机器人对靶控制的鲁棒性.

当然,也可以设计局部切换策略,即当沿着规划轨迹检测到接近图像局部最小化和图像奇异时从IBVS切换到PBVS.该方法的不足之处在于为了避免由于重复切换引起的不稳定性,切换策略只能使用一次.然而,在系统切换到PBVS后也不能完全保证仍然满足视野约束和关节限制.

势场法的主要优势在于可以快速计算出驱动力,非常适合实时视觉伺服应用.当跟踪图像轨迹需要考虑到由于建模和标定对规划轨迹带来的偏差影响时,即可应用以上策略.

2.4 全局路径规划当考虑所有约束时,以上视觉伺服任务中的路径规划方法会出现收敛性问题,所以研究者又探索了全局路径规划方法. 2002年,美国加州大学伯克利分校Cowan等[61]提出一种基于导航函数的全局稳定性策略,可以保证从任意初始位姿收敛到可见期望位姿,同时保证所有特征沿着路径可见,而不需要跟随预定义参考图像轨迹,但是构建这种导航函数受限于非常简单的应用场景.

2008年,英属哥伦比亚大学Baumann等[62]使用概率地图法(Probabilistic Road Map, PRM)为手眼相机相对于目标物体规划最少遮挡路径,使用IBM托马斯沃森研究中心Tarabanis等[63]提出的技术计算图像边界,将区域划分为目标可见区域和目标被工作空间障碍物遮挡不可见区域,提出的算法在可见区域之外为相机轨迹指定正比于相机平移距离的惩罚度,但是该方法并没有考虑相机的姿态和视野限制.

受加拿大西蒙弗雷泽大学Yao等[64]研究通用末端执行器约束的全局路径规划的启发,2009年,Kazemi等[65]在手眼机械臂视觉伺服中结合了基于采样的全局路径规划方法,全局规划器在相机空间中搜索满足视野限制和遮挡约束的相机路径,然后利用局部规划器在机械臂关节空间中跟踪这些路径,避免了关节限制和与障碍物发生碰撞,从而保障了机械臂可以顺利运动.斯坦福大学Kuffner等[66]和中国科学技术大学杜明博等[67]分别采用一个搜索树作为规划器,利用快速扩展随机树(Rapidly-exploring Random Tree,RRT)算法在其中搜索可行的路径,然后即可从搜索树中提取出连接相机初始位姿和期望位姿的路径,进而投影到图像空间获得采样特征轨迹作为一系列图像路径点.最终,这些路径点被时间参数化成三次样条曲线后利用IBVS进行跟踪.

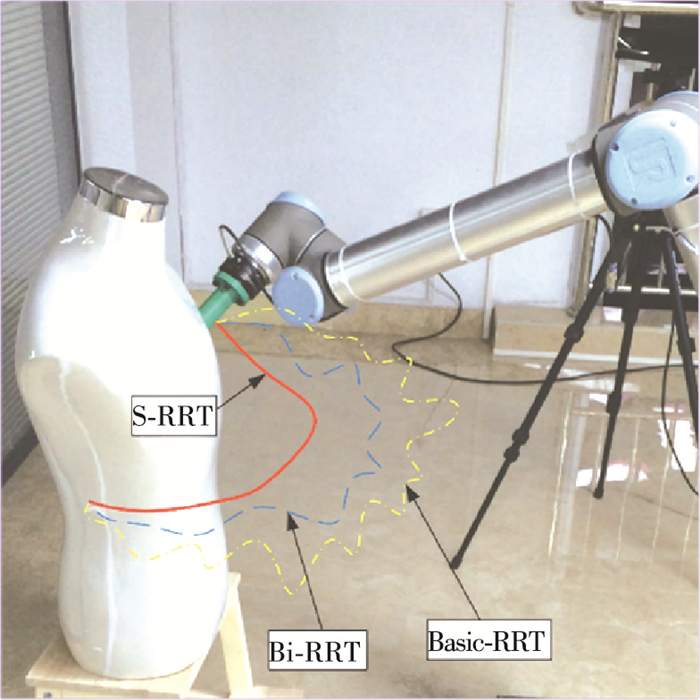

针对基本RRT算法和Bi-RRT(双向搜索树)算法生成路径不光滑问题,任秉银提出了改进的S-RRT光滑算法,并对上述三种RRT算法的自主避障(人体模型为障碍物)路径规划结果进行了对比,如图 4所示.

|

图 4 3种RRT算法路径规划结果对比 Figure 4 Comparison of path planning results of three kinds of RRT algorithms |

由图 4可知,基于RRT算法的全局路径规划方法可使机械臂通过视觉伺服绕过障碍物到达期望位姿,同时避免了在复杂环境任务中目标遮挡、逃离视野和碰撞.

2017年,浙江大学滕根保[68]研究了用改进随机扩展树求解体素空间表达型狭窄通道,将星形算法中估价函数引入到随机扩展树的目标节点方向上,降低采样的盲目性,提高搜索效率,并提出了基于平滑样条对路径引导点序进行平滑处理,实现机械臂在狭窄通道工况下安全、快速、平稳作业.

综上所述,全局路径规划方法需要完整和相对精确的环境信息、相机标定和目标模型.然而,这些苛刻要求在许多视觉伺服场景中是受限制的.在规划阶段考虑建模和标定不确定性可以降低对上述先验知识的要求.

2.5 不确定性下视觉伺服路径规划由于视觉伺服系统中存在不确定性,机械臂可能不会准确跟踪规划好的路径.事实上,在一些情形下,工作空间和图像空间跟踪的路径与理想规划好的路径相差非常大,就会不满足一些约束条件. INRIA的Espiau[69]研究了相机内、外参数误差对视觉伺服性能的影响.拉普兰塔理工大学Kyrki等[70]则分析了图像误差传播对位姿估计和视觉伺服控制律的影响.

一些研究人员提出局部规划技术,使得在规划阶段就能考虑执行时可能存在的偏差.例如,使用势场法局部考虑这些偏差,但是却很容易像之前所述,陷入局部最小化.一种解决未建模的不确定性方法是当违背约束条件时让相机迅速撤退或者重新规划.德国不来梅大学Lang等[71]提出变量缩放技术,当被障碍物遮挡时让目标在可见范围内迅速后退,这种缩放效应通过降低固定尺寸物体(相机从一定距离观测)的测量噪声,从而很大程度上改善了IBVS的性能.

2006年,INRIA的Comport等[72]提出了一种基于增强现实的视觉伺服方法.尽管他们的方法主要集中在通过虚拟视觉伺服进行相机位姿估计,但是可以扩展到由于未建模的不确定性导致目标上的特征点可能不在视野场景内这一情况.使用增强现实方法可以从混杂已知特征的场景中的其它物体获得的原始信息(如直线、边缘等)定位图像中丢失的特征点.在这种情形下,目标被用作视觉伺服的主要对象,而其它图像特征有利于位姿估计,最终有利于伺服任务,只有非常少的特征点可能会不在相机视野内.

综上所述,机械臂视觉伺服系统中存在诸多不确定性,包括相机内外参数不确定性、机械臂运动学和动力学参数不确定性等.不确定性的存在严重影响了视觉伺服路径规划的跟踪精度,现有方法主要集中在局部路径规划中考虑上述不确定性,但是非常容易陷入局部最小化和没有考虑所有约束类型.在完全未知环境中,解决各种不确定性下的全局视觉伺服路径规划问题的研究工作任重道远.

3 总结和展望本文对存在于机械臂视觉伺服路径规划中的两类约束进行了简要介绍,对主要的路径规划方法研究进展进行了评述.动态非结构环境下路径规划的难点在于需要同时处理两类约束,并且在诸多视觉伺服系统不确定性因素下规划出可行路径,从而提高视觉伺服系统的收敛性和稳定性,进而提高机械臂在动态非结构环境下的自主作业的能力.

现阶段对于视觉伺服路径规划的研究主要针对简单静态环境下的视觉伺服任务,为了提高机械臂在复杂环境下作业的灵活性和可靠性,未来机械臂视觉伺服路径规划的研究可以从以下几个方面展开:

1) 动态非结构环境下的视觉伺服路径规划

静态环境障碍物都是已知的,约束也都是单一的,而在动态环境中,障碍物都是未知或动态的,可能会造成目标的遮挡或与机械臂发生碰撞,而且同时存在两类约束.为了保证机械臂在复杂动态环境下作业的可靠性和稳定性,非常有必要针对这些问题做进一步的研究.

2) 基于多算法融合的视觉伺服路径规划

面对动态非结构环境中的复杂多约束和诸多不确定性,单一路径规划方法有其缺陷和不足,不能很好地解决视觉伺服中存在的难题,未来研究应结合多种算法优点,基于多算法切换和融合的路径规划方法是十分必要的.

3) 考虑动力学因素的视觉伺服路径规划

在机械臂作业过程中,有时需要考虑机械臂和环境的接触力等动力学因素,而当前路径规划基本上只考虑运动学,故今后非常有必要研究融合动力学的视觉伺服路径规划,提高机械臂面对复杂特殊作业的稳定性和快速性.

4) 融合机器学习方法的视觉伺服路径规划

机器学习方法,如深度学习和强化学习以及二者的结合等,不需要对系统建立模型,只需要离线训练就可以很好地利用其良好的逼近泛化能力,根据图像空间的视觉特征进行智能路径规划,机器学习可以很好地作为传统路径规划方法的有效补充,基于机器学习的视觉伺服路径规划是未来机器人学领域的重要研究方向.

5) 基于多相机融合的视觉伺服路径规划

单相机的视野范围和分辨率是有限的,使用多相机可以扩展视野范围,并且相机之间相互配合可以提高系统的可靠性和灵活性.未来可以针对多相机冗余视觉系统的控制以及视觉伺服路径规划展开研究.

| [1] |

谭民, 王硕. 机器人技术研究进展[J].

自动化学报, 2013, 39(7): 963-972.

TAN Min, WANG Shuo. Research progress on robotics[J]. Acta Automatica Sinica, 2013, 39(7): 963-972. DOI: 10.3724/SP.J.1004.2013.00963 |

| [2] |

夏群峰, 彭勇刚. 基于视觉的机器人抓取系统应用研究综述[J].

机电工程, 2014, 31(6): 697-701, 710.

XIA Qunfeng, PENG Yonggang. Review on application research of robots scraping system based on visual[J]. Journal of Mechanical & Electrical Engineering, 2014, 31(6): 697-701, 710. DOI: 10.3969/j.issn.1001-4551.2014.06.004 |

| [3] |

HUTCHINSON S, HAGER G D, CORKE P I. A tutorial on visual servo control[J].

IEEE Transactions on Robotics & Automation, 1996, 12(5): 651-670.

DOI: 10.1109/70.538972 |

| [4] |

ESPIAU B, CHAUMETTE F, RIVES P. A new approach to visual servoing in robotics[J].

IEEE Transactions on Robotics & Automation, 1992, 8(3): 313-326.

DOI: 10.1109/70.143350 |

| [5] |

CHAUMETTE F, HUTCHINSON S. Visual servo control part Ⅰ: basic approaches[J].

IEEE Robotics & Automation Magazine, 2006, 13(4): 82-90.

DOI: 10.1109/MRA.2006.250573 |

| [6] |

CHAUMETTE F, HUTCHINSON S. Visual servo control part Ⅱ: advanced approaches[J].

IEEE Robotics & Automation Magazine, 2007, 14(1): 109-118.

DOI: 10.1109/MRA.2007.339609 |

| [7] |

方勇纯. 机器人视觉伺服研究综述[J].

智能系统学报, 2008, 3(2): 109-114.

FANG Yongchun. A survey of robot visual servoing[J]. CAAI Transactions On Intelligent Systems, 2008, 3(2): 109-114. DOI: 10.3969/j.issn.1673-4785.2008.02.002 |

| [8] |

CHAUMETTE F. Potential problems of stability and convergence in image-based and position-based visual servoing[C]//The confluence of vision and control. London: Springer, 1998:66-78. DOI: 10.1007/BFb0109663.

|

| [9] |

贾丙西, 刘山, 张凯祥, 等. 机器人视觉伺服研究进展:视觉系统与控制策略[J].

自动化学报, 2015, 41(5): 861-873.

JIA Bingxi, LIU Shan, ZHANG Kaixiang, et al. Survey on robot visual servo control: vision system and control strategies[J]. Acta Automatica Sinica, 2015, 41(5): 861-873. DOI: 10.16383/j.aas.2015.c140724 |

| [10] |

KERMORGANT O, CHAUMETTE F. Dealing with constraints in sensor-based robot control[J].

IEEE Transactions on Robotics, 2014, 30(1): 244-257.

DOI: 10.1109/TRO.2013.2281560 |

| [11] |

SHARMA R, HUTCHINSON S. Motion perceptibility and its application to active vision-based servo control[J].

IEEE Transactions on Robotics & Automation, 1997, 13(4): 607-617.

DOI: 10.1109/70.611333 |

| [12] |

BARRAQUAND J, LATOMBE J. Robot motion planning: a distributed representation approach[J].

International Journal of Robotics Research, 1991, 10(6): 628-649.

DOI: 10.1177/027836499101000604 |

| [13] |

LAVALLE S.

Planning algorithms[M]. Cambridge: Cambridge University Press, 2006.

|

| [14] |

LAVALLE S, GONZALEZ-BANOS H, BECKER C, et al. Motion strategies for maintaining visibility of a moving target[C]//IEEE International Conference on Robotics and Automation. Albuquerque: IEEE, 1997:731-736.DOI: 10.1109/ROBOT.1997.620122.

|

| [15] |

MICHELT P, SCHEURERTT C, KUFFNERT J, et al. Planning for robust execution of humanoid motions using future perceptive capability[C]//IEEE/RSJ International Conference on Intelligent Robots and Systems. San Diego:IEEE, 2007:3223-3228. DOI: 10.1109/IROS.2007.4399249.

|

| [16] |

CORKE P, HUTCHINSON S. A new partitioned approach to image-based visual servo control[J].

IEEE Transactions on Robotics & Automation, 2001, 17(4): 507-515.

DOI: 10.1109/70.954764 |

| [17] |

DEGUCHI K. Optimal motion control for image-based visual servoing by decoupling translation and rotation[C]//IEEE/RSJ International Conference on Intelligent Robots and Systems. Victoria: IEEE, 1998:705-711. DOI: 10.1109/IROS.1998.727274.

|

| [18] |

MAHONY R, HAMEL T, CHAUMETTE F. A decoupled image space approach to visual servo control of a robotic manipulator[C]//IEEE International Conference on Robotics and Automation. Washington, DC:IEEE, 2002:3781-3786.DOI: 10.1109/ROBOT.2002.1014305.

|

| [19] |

MALIS E, CHAUMETTE F, BOUDET S. 2-1/2-D visual servoing[J].

IEEE Transactions on Robotics & Automation, 1999, 15(2): 238-250.

DOI: 10.1109/70.760345 |

| [20] |

MOREL G, LIEBEZEIT T, BOUDETS, et al. Explicit incorporation of 2D constraints in vision based control of robot manipulators[C]//The Sixth International Symposium on Experimental Robotics Ⅵ. London: Springer-Verlag, 1999:99-108. DOI:10.1007/BFb0119389.

|

| [21] |

GANS N R, HUTCHINSON S A, CORKE P I. Performance tests for visual servo control systems, with application to partitioned approaches to visual servo control[J].

International Journal of Robotics Research, 2003, 22(10): 955-984.

DOI: 10.1177/027836490302210011 |

| [22] |

CHESI G, HASHIMOTO K, PRATTICHIZZO D, et al. Keeping features in the field of view in eye-in-hand visual servoing: a switching approach[J].

IEEE Transactions on Robotics & Automation, 2004, 20(5): 908-914.

DOI: 10.1109/TRO.2004.829456 |

| [23] |

DENG L, JANABI-SHARIFI F, WILSON W J. Hybrid motion control and planning strategies for visual servoing[J].

IEEE Transactions on Industrial Electronics, 2005, 52(4): 1024-1040.

DOI: 10.1109/TIE.2005.851651 |

| [24] |

GANS N R, HUTCHINSON S A. Stable visual servoing through hybrid switched-system control[J].

IEEE Transactions on Robotics, 2007, 23(3): 530-540.

DOI: 10.1109/TRO.2007.895067 |

| [25] |

HASHIMOTO K, NORITSUGU T. Potential problems and switching control for visual servoing[C]//IEEE/RSJ International Conference on Intelligent Robots and Systems.Takamatsu:IEEE, 2000:423-428.DOI: 10.1109/IROS.2000.894641.

|

| [26] |

刘玺. 移动机器人主动视觉伺服技术研究[D]. 天津: 南开大学, 2010. DOI: 10.7666/d.y1814223.

LIU Xi. Research on the active visual servoing of mobile robot[D]. Tianjin: Nankai University, 2010. DOI: 10.7666/d.y1814223. http://d.wanfangdata.com.cn/Thesis/Y1814223 |

| [27] |

张春龙. 自然环境下农业机器人作业目标信息获取与视觉伺服策略研究[D]. 北京: 中国农业大学, 2014.

ZHANG Chunlong. Research on target information acquisition and vision Servo strategy of agricultural robot in natural environment[D]. Beijing: China Agricultural University, 2014. http://cdmd.cnki.com.cn/Article/CDMD-10019-1014223526.htm |

| [28] |

刘玉月, 吴东苏, 顾宏斌. 基于视觉伺服的手部跟踪仿真研究[J].

信息技术, 2012(5): 9-15.

LIU Yuyue, WU Dongsu, GU Hongbin. Research and simulation of hand tracking based on visual servo[J]. Information Technology, 2012(5): 9-15. DOI: 10.3969/j.issn.1009-2552.2012.05.003 |

| [29] |

李宝全, 方勇纯, 张雪波, 等. 基于选择策略的移动机器人视觉伺服镇定方法[J].

系统科学与数学, 2012, 32(6): 750-767.

LI Baoquan, FANG Yongchun, ZHANG Xuebo, et al. Selection-strategy-based visual servo regulation of wheeled mobile robots[J]. Journal of Systems Science and Mathematical Sciences, 2012, 32(6): 750-767. |

| [30] |

MEZOUAR Y, CHAUMETTE F. Path planning for robust image-based control[J].

IEEE Transactions on Robotics & Automation, 2002, 18(4): 534-549.

DOI: 10.1109/TRA.2002.802218 |

| [31] |

陶波, 龚泽宇, 丁汉. 机器人无标定视觉伺服控制研究进展[J].

力学学报, 2016, 48(4): 767-783.

TAO Bo, GONG Zeyu, DING Han. Survey on uncalibrated robot visual servoing control[J]. Chinese Journal of Theoretical and Applied Mechanics, 2016, 48(4): 767-783. DOI: 10.6052/0459-1879-16-161 |

| [32] |

HOSODA K, SAKAMOTO K, ASADA M. Trajectory generation for obstacle avoidance of uncalibrated stereo visual servoing without 3D reconstruction[C]//IEEE/RSJ International Conference on Intelligent Robots and Systems.Pittsburgh:IEEE, 1995:29-34.DOI: 10.1109/IROS.1995.525771.

|

| [33] |

HARTLEY R, ZISSERMAN A. Multiple view geometry in computer vision[J].

Kybernetes, 2003, 30(9/10): 1865-1872.

DOI: 10.1108/k.2001.30.9_10.1333.2 |

| [34] |

PARK J S, CHUNG M J. Path planning with uncalibrated stereo rig for image-based visual servoing under large pose discrepancy[J].

IEEE Transactions on Robotics & Automation, 2003, 19(2): 250-258.

DOI: 10.1109/TRA.2003.808861 |

| [35] |

ESPIAU B, CHAUMETTE F, RIVES P. A new approach to visual servoing in robotics[J].

IEEE Transactions on Robotics & Automation, 1992, 8(3): 313-326.

DOI: 10.1109/70.143350 |

| [36] |

FAUGERAS O.

Three-dimensional computer vision, a geometric viewpoint[M]. Cambridge: MIT Press, 1993: 187-205.

|

| [37] |

CHESI G, MALIS E, CIPOLLA R. Automatic segmentation and matching of planar contours for visual servoing[C]//IEEE International Conference on Robotics and Automation. San Francisco: IEEE, 2000: 2753-2758.DOI: 10.1109/ROBOT.2000.846444.

|

| [38] |

MALIS E, CHAUMETTE F. 2 1/2 D visual servoing with respect to unknown objects through a new estimation scheme of camera displacement[J].

International Journal of Computer Vision, 2000, 37(1): 79-97.

DOI: 10.1023/A:1008181530296 |

| [39] |

MEZOUAR Y, CHAUMETTE F. Optimal camera trajectory with image-based control[J].

International Journal of Robotics Research, 2003, 22(10): 781-804.

DOI: 10.1177/027836490302210001 |

| [40] |

SCHRAMM F, MOREL G. Ensuring visibility in calibration-free path planning for image-based visual servoing[J].

IEEE Transactions on Robotics, 2006, 22(4): 848-854.

DOI: 10.1109/TRO.2006.878955 |

| [41] |

KYRKI V, KRAGIC D, CHRISTENSEN H I. New shortest-path approaches to visual servoing[C]// IEEE/RSJ International Conference on Intelligent Robots and Systems.Sendai:IEEE, 2004:349-354.DOI: 10.1109/IROS.2004.1389376.

|

| [42] |

ALLOTTA B, FIORAVANTI D. 3D motion planning for image-based visual servoing tasks[C]//IEEE International Conference on Robotics and Automation. Barcelona:IEEE, 2005:2173-2178.DOI: 10.1109/ROBOT.2005.1570435.

|

| [43] |

BORGSTADT J A, FERRIER N J. Visual servoing: path interpolation by homography decomposition[C]//IEEE International Conference on Robotics and Automation. Seoul:IEEE, 2001:723-730.DOI: 10.1109/ROBOT.2001.932636.

|

| [44] |

MALIS E. Visual servoing invariant to changes in camera intrinsic parameters[C]//Eighth IEEE International Conference on Computer Vision. Vancouver:IEEE, 2001:704-709.DOI: 10.1109/ICCV.2001.937592.

|

| [45] |

SHARMA R, SUTANTO H. A framework for robot motion planning with sensor constraints[J].

IEEE Transactions on Robotics & Automation, 1997, 13(1): 61-73.

DOI: 10.1109/70.554347 |

| [46] |

ZHANG H, OSTROWSKI J P. Visual motion planning for mobile robots[J].

IEEE Transactions on Robotics & Automation, 2002, 18(2): 199-208.

DOI: 10.1109/TRA.2002.999648 |

| [47] |

CHESI G, PRATTICHIZZO D, VICINO A. Straight line path-planning in visual servoing[J].

Journal of Dynamic Systems Measurement & Control, 2007, 129(4): 541-543.

DOI: 10.1115/1.2745882 |

| [48] |

CHESI G, HUNG Y S. Global path-planning for constrained and optimal visual servoing[J].

IEEE Transactions on Robotics, 2007, 23(5): 1050-1060.

DOI: 10.1109/TRO.2007.903817 |

| [49] |

CHESI G. Visual servoing path planning via homogeneous forms and LMI optimizations[J].

IEEE Transactions on Robotics, 2009, 25(2): 281-291.

DOI: 10.1109/TRO.2009.2014131 |

| [50] |

BHATTACHARYA S, MURRIETA-CID R, HUTCHINSON S. Optimal paths for landmark-based navigation by differential-drive vehicles with field-of-view constraints[J].

IEEE Transactions on Robotics, 2007, 23(1): 47-59.

DOI: 10.1109/TRO.2006.886841 |

| [51] |

LOPEZ-NICOLAS G, BHATTACHARYA S, GUERRERO J, et al. Switched homography-based visual control of differential drive vehicles with field-of-view constraints[C]//IEEE International Conference on Robotics and Automation. Roma: IEEE, 2007:4238-4244.DOI: 10.1109/ROBOT.2007.364131.

|

| [52] |

HAYET J B, ESTEVES C, MURRIETACID R. A motionplanner for maintaining landmark visibility with a differential drive robot[M]//Algorithmic Foundation of Robotics Ⅷ. Heidelberg: Springer, 2009:333-347. DOI: 10.1007/978-3-642-00312-7-21.

|

| [53] |

SALARIS P, BELO F, FONTANELLI D, et al. Optimal paths in a constrained image plane for purely image-based parking[C]//IEEE/RSJ International Conference on Intelligent Robots and Systems. Nice:[s.n.], 2008:1673-1680.DOI: 10.1109/IROS.2008.4651050.

|

| [54] |

KESHMIRI M, XIE W. Image-based visual servoing using an optimized trajectory planning technique[J].

IEEE/ASME Transactions on Mechatronics, 2017, 22(1): 359-370.

DOI: 10.1109/TMECH.2016.2602325 |

| [55] |

马翔宇, 李阿为, 刘冠云. 基于躯体反射的焊接机械手位姿路径规划[J].

西安航空学院学报, 2017, 35(1): 29-33.

MA Xiangyu, LI Awei, LIU Guanyun. Pose path planning of welding manipulator based on body reflection[J]. Journal of XIAN Aeronautical University, 2017, 35(1): 29-33. DOI: 10.3969/j.issn.1008-9233.2017.01.006 |

| [56] |

KHATIB O. Real-time obstacle avoidance for manipulators and mobile robots[J].

International Journal of Robotics Research, 1986, 5(1): 90-98.

DOI: 10.1177/027836498600500106 |

| [57] |

何兆楚, 何元烈, 曾碧. RRT与人工势场法结合的机械臂避障规划[J].

工业工程, 2017, 20(2): 56-63.

HE Zhaochu, HE Yuanlie, ZENG Bi. Obstacle avoidence path planning for robot arm based on mixed algorithm of artificial potential field method and RRT[J]. Industrial Engineering Journal, 2017, 20(2): 56-63. DOI: 10.3969/j.issn.1007-7375.e17-2002.j.issn.1007-7375.e17-2002 |

| [58] |

KIRKPATRICK S, GELATT Jr C, VECCHI M P. Optimization by simulated annealing[J].

Science, 1983, 220(4598): 606-615.

DOI: 10.1126/science.220.4598.671 |

| [59] |

唐彪, 何波. 改进人工势场法的机械臂避障路径规划研究[J].

无线互联科技, 2017(3): 115-117.

TANG Biao, HE Bo. Research on obstacle avoidance path planning of manipulator with improved artificial potential field method[J]. Wuxian Hulian Keji, 2017(3): 115-117. DOI: 10.3969/j.issn.1672-6944.2017.03.046 |

| [60] |

赵栋杰. 对靶喷雾机器人视觉伺服控制系统研究[D]. 北京: 中国农业大学, 2017.

ZHAO Dongjie. Research on visual servo control system of target spraying robot[D].Beijing: China Agricultural University, 2017. http://cdmd.cnki.com.cn/Article/CDMD-10019-1017168312.htm |

| [61] |

COWAN N, WEINGARTEN J, KODITSCHEK D. Visual servoing via navigation functions[J].

IEEE Transactions on Robotics & Automation, 2002, 18(4): 521-533.

DOI: 10.1109/TRA.2002.802202 |

| [62] |

BAUMANN M, DUPUIS D, LEONARD S, et al. Occlusion-free path planning with a probabilistic roadmap[C]//IEEE/RSJ International Conference on Intelligent Robots and Systems. Nice: IEEE, 2008:2151-2156.DOI: 10.1109/IROS.2008.4651035.

|

| [63] |

TARABANIS K, TSAI R Y, KAUL A.

Computing occlusion-free viewpoints[M]. Champaign: IEEE Computer Society, 1992.

|

| [64] |

YAO Z, GUPTA K. Path planning with general end-effector constraints[J].

Robotics & Autonomous Systems, 2007, 55(4): 316-327.

DOI: 10.1016/j.robot.2006.11.004 |

| [65] |

KAZEMI M, GUPTA K, MEHRANDEZH M. Global path planning for robust visual servoing in complex environments[C]//IEEE International Conference on Robotics and Automation. Kobe: IEEE, 2009:326-332.DOI: 10.1109/ROBOT.2009.5152453.

|

| [66] |

KUFFNER J J, LAVALLE S M. RRT-connect: an efficient approach to single-query path planning[C]// IEEE International Conference on Robotics and Automation.SanFrancisco:IEEE, 2000:995-1001.DOI: 10.1109/ROBOT.2000.844730.

|

| [67] |

杜明博, 梅涛, 陈佳佳, 等. 复杂环境下基于RRT的智能车辆运动规划算法[J].

机器人, 2015, 37(4): 443-450.

DU Mingbo, MEI Tao, CHEN Jiajia, et al. RRT-basedmotion planning algorithm for intelligent vehicle in complex environments[J]. Robot, 2015, 37(4): 443-450. DOI: 10.13973/j.cnki.robot.2015.0443 |

| [68] |

滕根保. 面向狭窄通道的机械臂避障规划与示教技术研究及应用[D]. 杭州: 浙江大学, 2017.

TENG Genbao. Research and application of obstacle avoidance planning and teaching technology for narrow-channel manipulators[D].Hangzhou: Zhejiang University, 2017 http://d.g.wanfangdata.com.cn/Thesis_Y3188228.aspx |

| [69] |

ESPIAU B. Effect of camera calibration errors on visual servoing in robotics[C]//The International Symposium on Experimental Robotics Ⅲ. London: Springer-Verlag, 1993:182-192.DOI:10.1007/BFb0027594.

|

| [70] |

KYRKI V, KRAGIC D, CHRISTENSEN H I. Measurement errors in visual servoing[J].

Robotics & Autonomous Systems, 2006, 54(10): 815-827.

DOI: 10.1016/j.robot.2006.05.002 |

| [71] |

LANG O, GRASER A. Visual control of 6 DOF robots with constant object size in the image by means of zoom camera[C]//The 25th Annual Conference of the IEEE Industrial Electronics Society Proceedings. San Jose:IEEE, 1999:1342-1347.DOI: 10.1109/IECON.1999.819406.

|

| [72] |

COMPORT A I, MARCHAND E, PRESSIGOUT M, et al. Real-time markerless tracking for augmented reality: the virtual visual servoing framework[J].

IEEE Transactions on Visualization & Computer Graphics, 2006, 12(4): 615-628.

DOI: 10.1109/TVCG.2006.78 |

2018, Vol. 50

2018, Vol. 50