语音是人类最基本、最便捷的交流形式, 承载复杂信息的语音信号不仅可以反映语义内容, 还能够传递说话人内在的情感状态, 语音情感识别对建立更加自然、和谐的人机交互环境至关重要[1-2], 是人工智能领域重要发展目标.近年来, 情感特征提取的研究工作已经取得不错进展[3-4], 例如将时长、基频、能量等韵律特征用于情感识别[5-6], 将谱相关特征运用到语音情感的识别[7-13], 提取声音质量特征进行语音情感识别[14-16]等.常用的谱特征例如梅尔频率倒谱系数(Mel-Frequency Cepstral Coefficients, MFCC)是基于人耳听觉特性提出来的[17-18], 已经广泛地应用在语音相关研究领域. Sun Y等[19]指出了MFCC存在因分帧处理引起相邻帧谱特征之间相关性被忽略的问题, 导致很多有用信息丢失.语谱图直观地呈现语音信号在各时段的频率分布情况, 包含了重要的语言学信息[20-22], 梁泽[23]、阮柏尧[24]将语谱图送入脉冲耦合神经网络(Pulse Coupled Neural Network, PCNN)进行迭代处理得到描述语谱图信息的时间点火序列、点火位置信息特征, 该特征不仅包含语谱图的灰度分布信息, 更重要的是还包含其中相邻像素之间的相对位置信息, 不但能探测说话人的情感状态, 同时考虑了相邻频谱间的互相关信息, 与MFCC特征形成互补.因此本文提出提取时间点火序列、点火位置信息特征对MFCC特征进行补充, 从而改善语音情感识别系统性能, 实验结果表明, 改进之后的方法提升了语音情感识别效果.另一方面, 本文尝试将情感识别结果表示为PAD三维情感空间中的坐标点, 突破了离散形容词标签(高兴、生气、悲伤等)描述情感种类局限性, 采用量化方法揭示情感空间中各种情感的定位和关系, 在处理情感的单一维度问题上也更高效.

1 语音情感特征提取针对MFCC存在因分帧处理引起相邻帧谱特征之间相关性被忽略的问题, 本节在首先提取MFCC特征后, 加入时间点火序列和点火位置信息特征提取, 为后续根据获取的上述三种特征预测所得P, A, D值加权融合提供数据.

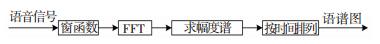

1.1 梅尔频率倒谱系数本文提取MFCC特征参数的过程见图 1.

|

图 1 MFCC提取流程图 Figure 1 Flow chart of MFCC extraction |

预处理包括预加重和加窗分帧[25], 帧长取256, 帧移取128, 窗函数为汉明窗, 将每帧语音信号的语音序列s(n)进行快速傅里叶变换(FFT)得到各帧的频谱X(n), 对其取模平方得到语音信号的能量谱|X(n)|2, 将|X(n)|2通过梅尔滤波器组Hm(k), 输出参数Pm(m=0, 1, 2, ..., M-1), 其计算方法为

| $ {\mathit{\boldsymbol{P}}_{\rm{m}}} = \mathop \sum \limits_{k = {f_{{\rm{m}} - 1}}}^{{f_{{\rm{m}} + 1}}} {\mathit{\boldsymbol{H}}_{\rm{m}}}\left( k \right)|\mathit{\boldsymbol{X}}\left( n \right){|^2}, m = 0, 1, 2, ..., M - 1. $ | (1) |

式中M为滤波器的个数, 本文取26.

最后对参数Pm取对数做离散余弦变换(DCT)得到静态梅尔频率倒谱系数Cmel(k):

| $ {\mathit{\boldsymbol{L}}_{\rm{m}}} = \ln ({\mathit{\boldsymbol{P}}_{\rm{m}}}), m = 0, 1, 2, ..., M - 1, $ | (2) |

| $ {\mathit{\boldsymbol{C}}_{{\rm{mel}}}}\left( k \right) = \mathop \sum \limits_{m = 0}^{M - 1} {\mathit{\boldsymbol{L}}_{\rm{m}}}\cos \left( {\frac{{k\left( {m - 0.5} \right)}}{M}} \right), k = 1, 2, 3, ..., N. $ | (3) |

对静态MFCC参数进行一阶差分, 对得到的一阶差分系数进行二阶差分, 得到动态的一阶MFCC参数和二阶MFCC参数.通过实验对比发现, 一阶MFCC参数对语音情感识别的准确率较静态MFCC参数有一定程度的提高, 但二阶MFCC参数由于多了一倍的参数值, 导致维数增加, 在当前语音特征值维数与语料相比过大的情况下, 维数的提升反而导致该参数识别性能下降, 最终本文选取一阶差分MFCC参数.

1.2 神经元点火序列将语音信号对应的语谱图作为PCNN的输入, 得到神经元点火序列, 过程见图 2, 该序列描述语谱图各时刻释放脉冲(点火)的神经元总数, 其中求语谱图流程见图 3.帧长、帧移以及窗函数的选择与计算MFCC相同, 用时间n作横坐标, 频率ω作纵坐标, 任一给定频率成分在给定时刻的强弱程度采用相应点的灰度表示, 构成的二维图像即为语谱图[26].

|

图 2 特征时间序列提取流程图 Figure 2 Flow chart of characteristic time series extraction |

|

图 3 求语谱图过程流程图 Figure 3 Flow chart of speech spectrum seeking process |

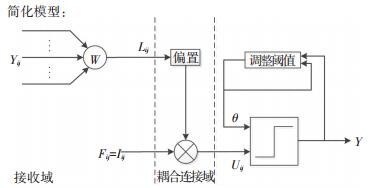

Eckhorn依据猫的视觉皮层神经元释放同步脉冲现象提出了脉冲耦合神经网络(PCNN)模型[27], PCNN单个神经元由接收域、耦合连接域和脉冲发生器三部分组成, 其简化结构模型见图 4.

|

图 4 脉冲耦合神经网络神经元简化模型 Figure 4 Simplified model of pulse coupled neural network neuron |

1) 在接收域中, Yij代表附近神经元上一时刻的输出, Yij与对应系数相乘得到连接输入项Lij.反馈输入项Fij即Iij, 代表来自外界刺激信号输入(本文指语谱图像素构成矩阵中第(i, j)个像素灰度值), 计算公式为

| $ {\mathit{\boldsymbol{L}}_{ij}}\left[ n \right] = \sum {w_{ijpq}}\mathit{\boldsymbol{Y}}\left[ {n - 1} \right], $ | (4) |

| $ {\mathit{\boldsymbol{F}}_{ij}}\left[ n \right] = {\mathit{\boldsymbol{I}}_{ij}}. $ | (5) |

式中wijpq为连接权值矩阵W的元素, 代表PCNN中第(i, j)个神经元与第(p, q)个神经元的连接系数.权值矩阵一般是3×3的矩阵, 反映了相邻神经元传输给中心神经元信号强度的大小.其元素定义为

| $ {w_{ijpq}} = \frac{1}{{{{\left( {i - p} \right)}^2} - {{\left( {j - q} \right)}^2}}}. $ | (6) |

式中(i, j), (p, q)为像素点的坐标值.

2) 在耦合连接域中, 将连接输入项Lij的偏置与反馈输入项Fij相乘, 得到内部活动项Uij, 表达式为

| $ {\mathit{\boldsymbol{U}}_{ij}}\left[ n \right] = {\mathit{\boldsymbol{F}}_{ij}}(1 + \beta {\mathit{\boldsymbol{L}}_{ij}}\left[ n \right]). $ | (7) |

式中β为连接强度系数.

3) 在脉冲发生器中, 比较内部活动项Uij与动态阈值门限θij的大小, 若内部活动项Uij较大, 则神经元释放脉冲(也称作点火)并且使输出的脉冲值重新对动态阈值门限进行反馈调节.若Uij不大于动态阈值, 那么神经元不输出脉冲(也称作不点火).输出脉冲和动态阈值门限的表达式为

| $ {\mathit{\boldsymbol{Y}}_{ij}}\left[ n \right] = \left\{ {\begin{array}{*{20}{l}} {1, }&{{\mathit{\boldsymbol{U}}_{ij}}\left[ n \right] > {\mathit{\boldsymbol{\theta }}_{ij}}\left[ {n - 1} \right];}\\ {0, }&{{\mathit{\boldsymbol{U}}_{ij}}\left[ n \right] \le {\mathit{\boldsymbol{\theta }}_{ij}}\left[ {n - 1} \right].} \end{array}} \right. $ | (8) |

| $ {\mathit{\boldsymbol{\theta }}_{ij}}\left[ n \right] = \exp \left( { - {\alpha _\theta }} \right){\mathit{\boldsymbol{\theta }}_{ij}}\left[ {n - 1} \right] + {V_\theta }{\mathit{\boldsymbol{Y}}_{ij}}\left[ {n - 1} \right]. $ | (9) |

式中:αθ为θij的衰减时间常数, Vθ为动态阈值门限固有常数, Yij[n]为PCNN神经元的输出值, 本文定义输出从0变为1为神经元的点火.

本文使用50次迭代的点火神经元的总数T(n)作为特征时间序列, 定义为

| $ \mathit{\boldsymbol{T}}\left( n \right) = \mathop \sum \limits_{ij} {\mathit{\boldsymbol{Y}}_{ij}}\left( n \right). $ | (10) |

式中Yij(n)为n时刻二值图像输出, T(n)统计了n时刻整幅图像中发出脉冲的神经元总数.

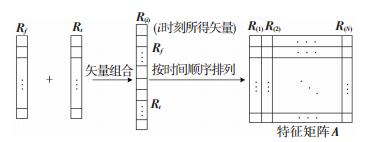

1.3 神经元点火位置信息将每次迭代所得点火神经元位置颁布图分别向时间轴和频率轴上投影, 再把投影后的两个矢量合并成一个矢量.最后, 将每个时刻的点火位置分布图所得矢量按照时间排成多列, 组成一个矩阵即为语音情感识别特征矩阵, 过程见图 5.

|

图 5 提取特征时间序列流程图 Figure 5 Flow chart of characteristic time series extraction |

图中, Rf代表某一时刻对语谱图的点火位置图像的频率轴投影所得矢量, Rt代表该时刻对时间轴投影所得矢量, R(i)表示两个矢量的组合矢量, A是每个时刻得到的组合矢量按时间顺序排列合成的特征矩阵.

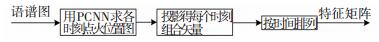

本文提取神经元点火位置信息的流程见图 6.

|

图 6 提取神经元点火位置信息流程图 Figure 6 Flow chart of neuron ignition position information extraction |

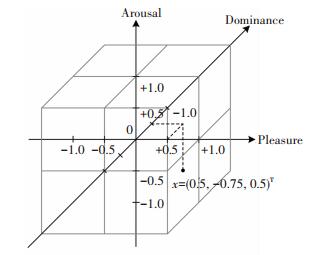

学者们一般采用离散情感标签来分类少数几种基本情感, 但悲喜交加、喜极而泣等已不再完全属于某一基本情感类别, 这不利于创建新型的、更加人性化的人机交互环境.基于维度论的PAD三维情感模型见图 7, 该模型打破了传统的标签描述方法, 是各种情感维度模型中较为成熟的一种.

|

图 7 PAD三维情感模型 Figure 7 PAD 3D emotion model |

其中P代表愉悦度(Pleasure-Displeasure), 表明了个体情感状态的积极或消极特性; A代表激活度(Arousal-Nonarousal), 表明了个体的神经生理激活程度; D代表优势度(Dominance-Submissiveness), 表明了个体对环境和他人的主观控制状态[28].该模型与离散情感描述模型相比, 更关注情感内在成分的表达, 通过计算待预测情感语音的PAD值与各基本情感类型的PAD量表值的距离, 可以判别待测情感语音的情感状态并分析其内在情感组成, 本文选择该模型进行语音情感分析.

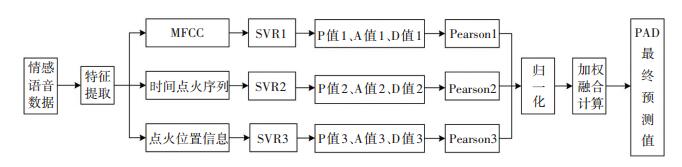

2.2 特征权重计算利用提取所得MFCC、PCNN神经元点火序列以及神经元点火位置信息三种语音情感特征, 用支持向量机回归SVR(Support Vector Regression)建立语音情感识别模型, 预测不同语音情感的P、A、D值, 得到不同语音情感在三维情感空间中的分布.最后, 按照不同特征的相关性系数来确定特征权重, 融合得到该语音信号在三维情感空间中的最终PAD值.实现流程见图 8.

|

图 8 PAD三维情感模型中的多特征融合 Figure 8 Multi-feature fusion in PAD 3D emotion model |

计算Pearson相关系数确定特征权重, 它在协方差的基础上除以两个随机变量的标准差, 得到一个介于-1~1之间的值, 当相关系数等于1时, 表示两个随机变量的线性关系正相关最强; 反之当它等于-1时, 表示它们之间线性关系负相关最强; 等于0说明它们之间不存在线性相关关系为

| $ \begin{array}{l} {\rho _{{\rm{X, Y}}}} = {\rm{corr}}\left( {X, Y} \right) = \frac{{{\mathop{\rm cov}} \left( {X, Y} \right)}}{{{\sigma _{\rm{X}}}{\sigma _{\rm{Y}}}}} = \\ \;\;\;\;\;\;\;\;\;\mu \frac{{{\rm{E}}\left[ {\left( {X - {\mu _{\rm{X}}}} \right)\left( {Y - {\mu _{\rm{Y}}}} \right)} \right]}}{{{\sigma _{\rm{X}}}{\sigma _{\rm{Y}}}}}. \end{array} $ | (11) |

式中:X为预测值, Y为PAD量表参考值, μX, μY分别为变量X, Y的平均值, σX, σY分别表示变量X, Y的标准差.

3 实验结果与分析 3.1 语音情感数据库选择公开使用许可的中科院自动化所语音情感数据库(CASIA), 柏林语音情感数据库(EmoDB)和Surrey视听表情情感数据库(SAVEE)评价所提方法的有效性, 它们在语音情感识别中应用广泛[29], 使用上述数据库可以方便与其他工作的实验结果对比.

CASIA由4位录音人在5种不同情感(温和、惊吓、生气、难过、高兴、悲伤)下对500句文本发音得到, 共9 600句语料. EmoDB由10位演员对10条语句进行7种情感(温和、生气、害怕、高兴、悲伤、厌恶、难过)的演绎得到, 共包含800句语料. SAVEE由4个演员制作, 设计了7种情感(生气、害怕、厌恶、高兴、温和、惊吓、悲伤), 共480句语料.

上述3个数据库虽然是离散语音情感数据库, 但是根据Mehrabian研制的原版PAD情绪量表以及中国科学院心理所修订的中文简化版PAD情绪量表与基本情感类型的对应关系, 可以获得数据库中各情感类型的PAD量表值, 所以以上3个数据库中语料能够作为本文实验所需的维度情感语音数据, 涉及的基本情感类型对应的PAD量表值见表 1.

| 表 1 基本情感类型的PAD量表值 Table 1 PAD scale for basic emotion types |

实验的运行环境为Matlab(R2014b), 系统环境为Win10, 计算机配置为Intel Core i3-3217U CPU(1.8GHz), 8GB内存.

MFCC的提取方法依照提取流程图获得MFCC.为确保PCNN输出时间序列唯一, 对语谱图的处理采用同一参数模型, 取值见表 2.

| 表 2 PCNN的参数及取值 Table 2 Parameters and values of PCNN |

表 2中, αF、αL、αθ分别为反馈输入项Fij, 连接输入项Lij, 动态阈值门限θij的衰减时间常数. VF, VL, Vθ分别表示PCNN的反馈放大系数、连接放大系数和阈值放大系数.通过文献[30]提出的结合局部梯度确定时间衰减常数αθ和放大系数Vθ方法指导参数αθ、Vθ的设置, 计算方法为

| $ {\alpha _\theta } = \nabla f\left( {x, y} \right), $ | (12) |

| $ {V_\theta } = 1 - \nabla f\left( {x, y} \right). $ | (13) |

式中∇f(x, y)为语谱图f(x, y)的梯度表示, 计算方法为

| $ \nabla f\left( {x, y} \right) = {\left[ {\frac{{\partial f}}{{\partial x}}\frac{{\partial f}}{{\partial y}}} \right]^{\rm{T}}}. $ | (14) |

表 2β为连接强度系数, 其值越大神经元兴奋的提升量越大, 神经元也越容易点火.相应地, 语谱图像素的局部对比度可以反映神经元的兴奋状态, 对比度高说明对应位置神经元比较兴奋, 容易受到刺激而点火, 因此将局部对比度的大小作为参数β设置的依据. Y, L, U初始值设为0, 输入为归一化的灰度值, 属于[0, 1]之间.连接域半径r=1.5, 内部连接矩阵W是一个3×3的方阵, 其中每一个元素数值为中心像素到周围每个像素的欧几里德距离平方的倒数(r-2).

利用提取的三种语音情感特征, 建立情感语音识别预测模型, 本文SVR回归算法选用高斯径向基函数, 实验样本的80%作为训练集, 剩余样本作为测试集检验预测效果. 表 3是以CASIA数据库中文本内容为“阳光使得你们温暖”, 情感标签为高兴的测试数据为例, 得到的三种特征的相关系数归一化结果.首先将该语音的MFCC特征作为SVR的输入参数, SVR的输出结果为该情感语音的PAD值, 然后计算该预测值与PAD量表值的Pearson相关系数.同理, 继续利用该语音情感数据的点火时间序列和点火位置信息特征进行P、A、D值预测, 计算Pearson相关系数.根据表 3中相关性分析结果我们可知道, 不同的特征在P(愉悦度)、A(激活度)和D(优势度)三个维度上所对应的相关系数存在差别, 其中P、A的相关系数由大到小的顺序是点火位置信息特征、时间点火序列、MFCC, 而D的相关系数由大到小的顺序为时间点火序列、点火位置信息特征、MFCC, 表明三种特征在语音情感识别的准确率中各有侧重.因此, 在对语音情感进行识别时, 不宜选取单一特征, 而应根据相关系数的大小给三种特征赋予不同的权值以提高识别精度.

| 表 3 三种语音情感特征的相关系数归一化结果 Table 3 Correlation coefficient normalization of three speech emotion features |

根据三种语音情感特征的相关系数归一化结果, 获取待识别情感语音的PAD值加权融合计算结果.计算方法为

| $ P = {P_1}{\lambda _1} + {P_2}{\lambda _2} + {P_3}{\lambda _3}. $ | (15) |

式中:P1, P2, P3依次代表采用MFCC, 点火时间序列, 点火位置信息对该语音在P维度的预测值, λ1, λ2, λ3表示以上三种语音情感特征对该语音情感类型在P维度的相关系数归一化值, 满足λ1+λ2+λ3=1.由式(15)计算所得P即为该语音在三维情感空间中的愉悦度最终预测值.同理可计算其优势度最终值D和激活度最终值A.

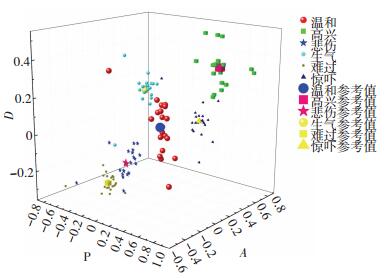

运用本文提出的方法对CASIA语音数据库中数据进行PAD值预测, 将得到的PAD数据表示在三维空间中, 绘制出PAD空间中不同情感的分布见图 9.

|

图 9 PAD三维情感空间分布 Figure 9 PAD 3D emotional spatial distribution |

由分布图观察得, 语音数据库中各标签类下语音P、A、D值分布情况见表 4.

| 表 4 6种情感的PAD最终预测值分布范围 Table 4 Distribution range of PAD final predictive value of the 6 emotion types |

图 9显示6种情感样本类间分布比较分散, 各个样本类内则较集中地分布在表 1中PAD量表值对应坐标点附近, 证明上述三种情感特征的预测结果通过相关系数加权融合后, 在连续维度情感预测中对基本情感类型具有较好的区分效果.分布图中绝大多数情感语音样本的位置并不与PAD量表表 1中所示6种基本情感的PAD参考值重合, 而是离散分布在基本情感标定点附近, 因此可以通过计算其与基本情感PAD值的距离, 进一步分析该情感语音状态的构成元素以及组成比例, 从而能够识别出形如“温和偏悲伤”或者“温和偏高兴”等混合情感类型, 更恰当地反映出情感表达的极性和程度.

3.4 与其他特征对比采用均方根误差(root-mean-square error, RMSE)作为基本情感类型识别准确性的评价指标, 计算方法为

| $ {\rm{RMSE}} = \sqrt {\frac{{\sum _{i = 1}^n{{\left( {{X_{{\rm{obs}}, i}} - {X_{{\rm{model}}, i}}} \right)}^2}}}{n}} . $ | (16) |

式中:Xobs, i为实验预测值, Xmodel, i为PAD量表参考值.

为证明时间点火序列、点火位置信息对MFCC有更好的互补效果, 计算文献[31]中MFCC、文献[32]中MFCC+OTHER、文献[33]中MFCC+PROS、本文MFCC+FIRING不同特征对MFCC补充之后预测结果的RMSE值见表 5.其中OTHER由线性预测倒谱系数(Linear Predictor Cepstral Coefficient, LPCC)、过零幅度峰值(Zeros Crossing Peak Amplitude, ZCPA)组成, PROS表示基频、短时能量、共振峰等韵律特征, FIRING代表时间点火序列和点火位置信息.表中每个维度的RMSE值都规范化至0~1之间, RMSE越小说明对应的方法性能越好.

| 表 5 RMSE值对比 Table 5 RMSE value comparison |

从表 5的对比结果看出, 只用MFCC特征, 识别结果不尽人意, 虽然MFCC特征充分考虑了人耳的听觉特征, 但在语音情感识别中表现却不及语音识别和说话人识别中优秀, 其他谱特征对MFCC也几乎没有补充效果.加入韵律特征后, 识别效果提升很多, 这说明韵律特征相对其他谱特征对MFCC有较大改进效果.在3个数据库上MFCC+FIRING的RMSE值最小, 其中在SAVEE数据库中P维度的RMSE值从0.80降低到0.31, 这一结果说明本方法引入时间点火序列和点火位置信息能提高情感识别效果, 并且两者在对MFCC的互补效果上比其他谱特征和韵律特征性能更好.

4 结论本文在常用语音情感特征MFCC的基础上增加时间点火序列、点火位置信息特征分别单独进行语音情感预测, 计算该语音预测结果与PAD量表值的相关系数, 将相关系数归一化结果作为特征权重, 加权融合获得语音的PAD最终预测值.该方法在提升基本情感类型识别效果的基础上, 将识别结果表示为PAD三维情感空间中的坐标点, 采用量化方法揭示情感空间中各种情感定位与联系, 更细腻地展现语音情感状态构成, 为后续复杂语音情感的分类识别奠定研究基础.

| [1] |

胡海龙.基于音节分布特征提取的语音情感识别[D].厦门: 厦门大学, 2011 HU Hailong.Speech emotion recognition based on syllable distribution feature extraction [D].Xiamen: Xiamen University, 2011 http://www.wanfangdata.com.cn/details/detail.do?_type=degree&id=Y1978902 |

| [2] |

蒋海华, 胡斌. 基于PCA和SVM的普通话语音情感识别[J]. 计算机科学, 2015, 42(11): 270. JIANG Haihua, HU Bing. Analysis ofmandarin speech emotion based on PCA and SVM[J]. Computer Science, 2015, 42(11): 270. DOI:10.11896/j.issn.1002-137X.2015.11.055 |

| [3] |

SWAIN M, ROUTRAY A, KABISATPATHY P. Databases, features and classifiers for speech emotion recognition: a review[J]. International Journal of Speech Technology, 2018, 21(1): 93. DOI:10.1007/s10772-018-9491-z |

| [4] |

MUSTAFA M B, YUSOOF M A M, DON Z M, et al. Speech emotion recognition research: an analysis of research focus[J]. International Journal of Speech Technology, 2018, 21(1): 137. DOI:10.1007/s10772-018-9493-x |

| [5] |

ILIOU T, ANAGNOSTOPOULOS C N.Statistical Evaluation of Speech Features for Emotion Recognition[C]//International Conference on Digital Telecommunications.Colmar, France IEEE, 2009: 121 http://ieeexplore.ieee.org/document/5205224/

|

| [6] |

WANG Y, DU S, ZHAN Y.Adaptive and Optimal Classification of Speech Emotion Recognition[C]//Fourth International Conference on Natural Computation.IEEE Computer Society, 2008: 407 http://ieeexplore.ieee.org/document/4667466/

|

| [7] |

OOI C S, Seng K P, ANG L M, et al. A new approach of audio emotion recognition[J]. Expert Systems with Applications, 2014, 41(13): 5858. DOI:10.1016/j.eswa.2014.03.026 |

| [8] |

LIKITHA M S, GUPTA S R R, HASITHA K, et al.Speech based human emotion recognition using MFCC[C]//International Conference on Wireless Communications, Signal Processing and NETWORKING.IEEE, 2018 http://ieeexplore.ieee.org/document/8300161/

|

| [9] |

ROZGIC V, ANANTHAKRISHNAN S, SALEEM S, et al.Emotion Recognition using Acoustic and Lexical Features[C]//Conference of the International Speech Communication Association.2012

|

| [10] |

WANG K, AN N, LI B N, et al. Speech emotion recognition using fourier parameters[J]. IEEE Transactions on Affective Computing, 2017, 6(1): 69. |

| [11] |

BITOUK D, VERMA R, NENKOVA A. Class-Level spectral features for emotion recognition[J]. Speech Communication, 2010, 52(7/8): 613. DOI:10.1016/j.specom.2010.02.010 |

| [12] |

CHAUHAN R, YADAV J, KOOLAGUDI SG, et al.Text independent emotion recognition using spectral features[C]//Proc.of the 2011 Int'l Conf.on Contemporary Computing.Berlin, Heidelberg: Springer-Verlag, 2011.359.DOI: 10.1007/978-3-642-22606-9_37

|

| [13] |

WU SQ, FALK TH, CHAN WY. Automatic speech emotion recognition using modulation spectral features[J]. Speech Communication, 2011, 53(5): 768. DOI:10.1016/j.specom.2010.08.013 |

| [14] |

LUGGER M, YANG B.The relevance of voice quality features in speaker independent emotion recognition[C]//IEEE International Conference on Acoustics, Speech and Signal Processing.IEEE, 2007: Ⅳ-17.DOI: 10.1109/ICASSP.2007.367152

|

| [15] |

LUGGER M, YANG B.Psychological motivated multistage emotion classification exploiting voice quality features[C]//Proc.of the Speech Recognition.2008

|

| [16] |

LUGGER M, JANOIR ME, YANG B.Combining classifiers with diverse feature sets for robust speaker independent emotion recognition[C]//Proc.of the 2009 European Signal Processing Conf.Glagow: EURASIP, 2009.1225

|

| [17] |

刘振焘, 徐建平, 吴敏等.语音情感特征提取及其降维方法综述[J/OL].计算机学报, 2017, 1-22(2017-08-13).http://kns.cnki.net/kcms/detail/11.1826.TP.20170813.1200.006.html. LIU Zhentao, XU Jianping, WU Min, et al.Aeeview of speech emotion extraction and its dimension reduction [J].Chinese Journal of Computers, 2017, 1-2 (2017-08-13).http://kns.cnki.net/kcms/detail/11.1826.TP.20170813.1200.006.html |

| [18] |

袁敏.汉语孤立词识别理论及关键技术研究[D].兰州大学, 2005 YUAN Min.Chinese isolated word recognition theory and key technologies [D].Lanzhou University, 2005 http://www.wanfangdata.com.cn/details/detail.do?_type=degree&id=Y731937 |

| [19] |

SUN Y, WEN G, WANG J. Weighted spectral features based on local Hu moments for speech emotion recognition[J]. Biomedical Signal Processing and Control, 2015, 18: 80. DOI:10.1016/j.bspc.2014.10.008 |

| [20] |

AJMERA P K, JADHAV D V, HOLAMBE R S. Text-independent speaker identification using radon and discrete cosine transforms based features from speech spectrogram[J]. Pattern Recognition, 2011, 44(10/11): 2749. |

| [21] |

KALINLI O, NARAYANNAN S. Prominence detection using auditory attention cues and task-dependent high level information[J]. IEEE Transactions on Audio Speech & Language Processing, 2009, 17(5): 1009. |

| [22] |

马义德, 袁敏, 齐春亮, 等. 基于PCNN的语谱图特征提取在说话人识别中的应用[J]. 计算机工程与应用, 2005, 41(20): 81. MA Yide, YUAN Mi, QI Chunliang, et al. Application of PCNN-based feature extraction in speaker recognition[J]. Computer Engineering and Applications, 2005, 41(20): 81. DOI:10.3321/j.issn:1002-8331.2005.20.024 |

| [23] |

梁泽.PCNN在语音情感识别中的应用研究[D].兰州: 兰州大学, 2008 LIANG Ze.Application of PCNN in speech emotion recognition [D].Lanzhou: Lanzhou University, 2008 http://www.wanfangdata.com.cn/details/detail.do?_type=degree&id=Y1331627 |

| [24] |

阮柏尧.脉冲耦合神经网络(PCNN)在基于语谱图的说话人识别中的应用[D].五邑大学, 2008 RUAN Baiyao.Application of pulse coupled neural network (PCNN) in speaker recognition based on speech spectrogram [D].Wuyi university, 2008 http://cdmd.cnki.com.cn/Article/CDMD-11349-2008172206.htm |

| [25] |

张文克.融合LPCC和MFCC特征参数的语音识别技术的研究[D].湘潭大学, 2016 ZHANG Wenke.Research onspeech recognition technology combining LPCC and MFCC feature parameters [D].Xiangtan University, 2016 http://cdmd.cnki.com.cn/Article/CDMD-10530-1016104874.htm |

| [26] |

李姗, 徐珑婷. 基于语谱图提取瓶颈特征的情感别算法研究[J]. 计算机技术与发展, 2017, 27(5): 82. LI Shan, XU LT. Research onemotion recognition algorithm of bottleneck characteristics extraction based on spectral graph[J]. Computer Technology and Development, 2017, 27(5): 82. DOI:10.3969/j.issn.1673-629X.2017.05.018 |

| [27] |

宋静, 张雪英, 孙颖, 等. 基于PAD情绪模型的情感语音识别[J]. 微电子学与计算机, 2016, 33(9): 128. SONG Jing, ZHANG Xueying, SUN Ying, et al. Emotion speech recognition based on PAD emotion model[J]. Microelectronics and Computers, 2016, 33(9): 128. |

| [28] |

张雪英, 孙颖, 张卫, 等. 语音情感识别的关键技术[J]. 太原理工大学学报, 2015, 46(06): 629. ZHANG Xueying, SUN Ying, ZHANG Wei, et al. Key Techniques of Speech Emotion Recognition[J]. Taiyuan University of Technology, 2015, 46(06): 629. |

| [29] |

韩文静, 李海峰. 情感语音数据库综述[J]. 智能计算机与应用, 2013, 3(01): 5. HAN Wenjing, LI Haifeng. Summary of Emotional Speech Database[J]. Journal of Microcomputer & Application, 2013, 3(01): 5. DOI:10.3969/j.issn.2095-2163.2013.01.002 |

| [30] |

李建锋.脉冲耦合神经网络在图像处理中的应用研究[D].中南大学, 2013 LI Jianfeng.Application of pulse coupled neural network in image processing [D].Central South University, 2013 |

| [31] |

韩一, 王国胤, 杨勇. 基于MFCC的语音情感识别[J]. 重庆邮电大学学报(自然科学版), 2008, 20(5): 597. HAN Yi, WANG Guoyin, YANG Yong. Speech emotion recognition based on MFCC[J]. Journal of Chongqing University of Posts and Telecommunications (Natural Science Edition), 2008, 20(5): 597. |

| [32] |

孙亚新.语音情感识别中的特征提取与识别算法研究[D].广州: 华南理工大学, 2015 SUN Yaxin.Research on feature extraction and recognition algorithm in voice emotion recognition [D].Guangzhou: South China university of technology, 2015 http://cdmd.cnki.com.cn/Article/CDMD-10561-1015987072.htm |

| [33] |

任浩, 叶亮, 李月, 等. 基于多级SVM分类的语音情感识别算法[J]. 计算机应用研究, 2017, 34(6): 1682. REN Hao, YE Liang, LI Yue, et al. Speech emotion recognition algorithm based on multi-level SVM classification[J]. ComputerApplication Research, 2017, 34(6): 1682. DOI:10.3969/j.issn.1001-3695.2017.06.018 |

2018, Vol. 50

2018, Vol. 50