2. 中国科学院大学,北京 100049

2. University of the Chinese Academy of Sciences, Beijing 100049, China

现代航空成像探测系统在侦查过程中,场景动态范围大,受相机CCD动态范围约束,拍摄的图像中总会有些部分曝光过度或曝光不足,在一幅图像中难以呈现场景中的所有信息.通过调节曝光量的方式[1-2],只能对场景中的部分区域准确曝光.曝光融合可以将每幅图像中曝光适度的部分融合到一幅图像中,得到的图像在各处都曝光正常且亮度适宜.

航空相机一般挂载在侦察机上,随着飞机的运动而运动,拍摄的图像在曝光融合前必须进行配准.配准算法通常计算量大,速率低.本文结合航空相机的工作环境特点以及其平台提供的定位信息,提出了基于SURF算法的小范围快速配准策略,有效地提高了配准的速率和准确性.

多曝光融合方法可分为空间域融合方法[3-6]和多分辨率融合方法[7-8]两类.目前针对曝光融合方面的研究多集中在空间域方法,但空间域方法对图像细节信息的处理不佳.多分辨率融合方法使用多尺度变换分解工具分解图像,在不同尺度和不同方向上获得分解后的子图像,对相同尺度和相同方向上的子图像进行融合,然后将融合后的子图像重构.这类融合方法顾及图像不同尺度上的数据,融合后的结果较好.常规的多分辨率分析方法中金字塔分解变换对图像的方向信息体现的不够全面;传统小波变换的方向选择性有限,同时不具备平移不变性.近些年来,有学者提出了更好的多尺度分析工具,如curvelet, ridglet, contourlet[9]等.这些变换中采用的下采样操作,导致出现伪吉布斯现象.目前图像融合领域使用最广泛的是非下采样轮廓波变换(non-subsampled contourlet transform, NSCT)[10-11],不进行下采样,没有伪吉布斯现象,虽然融合效果较好,但计算耗时长,不能满足航空多曝光图像融合对速率的要求.

双树复小波变换(dual-tree complex wavelet transform, DT-CWT)[12-13]采用二元树的方法,用实数小波变换实现复小波变换,图像经DT-CWT分解后可以得到6个方向上的细节信息,相比小波变换有更好的方向选择性;相比于NSCT计算复杂度较低,效率高.本文尝试使用DT-CWT用于曝光融合,根据高频和低频信息的特点分别采取相应的融合方式,探索一种获得亮度均匀,细节丰富的结果的方法;同时将这种方法应用于航空相机的工作过程中.

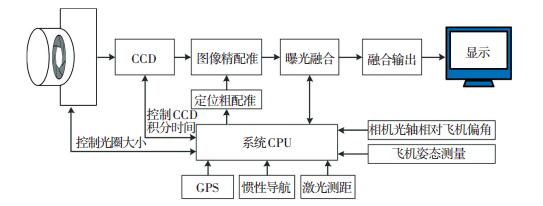

1 航空相机多曝光图像融合系统航空相机多曝光图像融合系统如图 1所示,整个系统由光学镜头,CCD传感器,图像配准模块(定位粗配准和图像精配准),曝光融合模块,融合输出模块,显示模块,飞机定位相关模块(GPS、惯性导航、激光测距、相机光轴相对飞机偏角、飞机姿态测量)和系统CPU构成.光学镜头对场景成像,得到光信号,CCD把光信号转变成电信号,调节CCD积分时间,连续拍摄,得到一组同一场景下的多曝光图像.航空相机搭载在飞机上,随着飞机的运动而运动,得到的多曝光图像序列的像素不是完全对应的,所以在融合前需要图像配准.本文结合航空相机工作平台搭载的定位系统,根据定位信息进行粗配准,然后由此结果在图像小范围内快速精确配准,配准后进行融合,得到融合结果输出到显示设备上显示.第2节介绍了本文的图像配准策略.第3节详细介绍了系统中曝光融合模块的算法.

|

图 1 航空相机多曝光融合系统结构图 Figure 1 Layout of aerial camera multi-exposure fusion system |

航空相机在工作过程中一直处于运动状态,连续拍摄的几幅多曝光图像不能保证像素完全对应,在融合前需要先进行配准.航空相机连续拍摄的几幅图像几乎没有尺度变化,有转角和视角变化,最显著的是亮度变化.选取的配准方法必须满足光照不变性,能够抗转角和视角的变化,并且为了在工程中能够实时应用,选取的配准算法处理速率要快.

SURF(speeded up robust feature)[14]算法是对配准经典算法SIFT(scale-invariant feature transform)的改进,具有光照不变性、具有一定的抗转角和视角变换的特性,算法速率较SIFT更高.本文选取SURF算法用于配准. SURF算法由3个步骤组成:特征点检测、特征点描述和特征点匹配.

多曝光融合所需图像一般大于两幅,每幅源图像之间都需要配准.选取源图像序列中信息熵最大的图像作为参考图像,使用SURF算法中的特征点检测算子对参考图像提取特征点,目的是在同一场景中尽可能多的提取特征点.

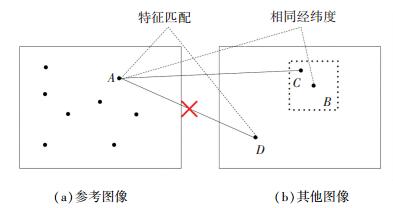

航空相机工作平台通常搭载全球定位系统(GPS)、航空姿态测量系统和激光测距机等定位相关设备,根据他们提供的信息,包括:飞机位置,飞机姿态角,相机光轴与飞机的相对位置,与地面的距离等,可以得到参考图像中的特征点对应的地面经纬度,也可以知道这些经纬度信息对应在其他图像中的像素位置.在其他图像中找到的与参考图像特征点经纬度相同的像素附近检测特征点,具体过程如图 2所示,参考图像中(左侧)的特征点A与其他图像中(右侧)的像素点B经纬度相同,在B周围的小范围区域内提取特征点与A进行匹配,得到点C,如果B周围没有与A相匹配的点,这是因为B周围区域曝光不准确导致信息的丢失,即使在其他区域存在和A特征描述能够匹配上的点(如D),在其他图像中也没有与A相匹配的点.这种策略减小了特征点匹配的区域,提高了配准效率,合理利用了已知信息,能够有效地去除误匹配点.

|

图 2 配准策略示意图 Figure 2 Diagram of registration strategy |

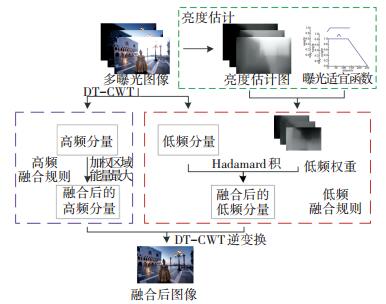

对一组配准后的多曝光图像序列{Ii} (i=1, 2…n, n为图像个数)的RGB三通道分别进行DT-CWT,经过一次DT-CWT可以将原图像分解为两个低频分量{A(j, 1),A(j, 2)}和6个方向(θ=±15°, ±45°, ±75°)上的高频分量{D(j, θ) },j为分解层数. 图 3给出了本文曝光融合算法的流程图.

|

图 3 曝光融合流程图 Figure 3 Flowchart for exposure fusion |

估计源图像的亮度情况,选择不同的曝光适宜度函数得到低频权重,3.1节详细介绍了这一部分;3.2和3.3节分别介绍了低频和高频融合规则;融合后的低频和高频分量经DT-CWT逆变换,得到最终结果.

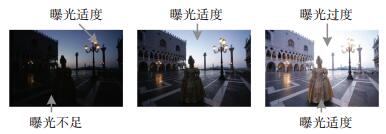

3.1 亮度估计从图 4[7]中可以看出低亮度图像中像素灰度值较大的区域曝光较适宜,高亮度图像中像素灰度值较小的区域曝光较适宜.设置两个灰度阈值pl和ph,如果在图像中有一半以上的像素灰度值小于pl,则此时图像为低亮度图像;反之,如果在图像中有一半以上的像素灰度值大于ph,则此时图像为高亮度图像;其他时认为此图像为中等亮度图像.本文选取的pl和ph分别为64、196像素灰度.

|

图 4 一组多曝光图像序列 Figure 4 A multi-exposure sequence |

曝光适宜是一个模糊的概念,没有一个绝对的准则规定曝光适宜与否,这类问题可以用模糊逻辑的来解决.根据前面分析,建立曝光适宜度的隶属度函数分别如下.

1) 低亮度图像时

| $ M = \left\{ \begin{array}{l} \frac{p}{{128}}, \;\;\;\;\;\;0 \le p < 128;\\ 1, \;\;\;\;\;\;\;\;\;\;\;128 \le p \le 255. \end{array} \right. $ |

2) 中等亮度图像时

| $ M = \left\{ \begin{array}{l} \frac{p}{{128}}, \;\;\;\;\;\;\;\;\;\;\;0 \le p < 128;\\ -\frac{p}{{128}} + 2, \;\;\;\;128 \le p \le 255. \end{array} \right. $ |

3) 高亮度图像时

| $ M = \left\{ \begin{array}{l} 1, \;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;0 \le p < 128;\\ -\frac{p}{{128}} + 2, \;\;\;\;128 \le p \le 255. \end{array} \right. $ |

式中p为像素灰度值;M为曝光适宜度,M∈[0, 1],数值越大表示曝光越适宜.对整幅图像计算每个像素位置的M,得到曝光适宜度矩阵Mi.

3.2 低频融合规则低频分量是原图像低频信息的体现,低频信息反映着主要能量分布,对于图像来说就是整体亮度情况.对于一组多曝光图像,它们的亮度变化很大,所以它们的低频系数有很大差异.最终结果的亮度取决于低频分量的融合规则.低频分量的融合规则要考虑整幅图像的亮度,而不只是考虑某个像素,这就需要估计图像的整体亮度情况.包络滤波(envelop filter)[15]可以平滑掉信号中的微弱变化,同时保留信号变化的趋势,它的这一特点满足对图像的亮度估计.包络滤波过程迭代式分别为

| $ \left\{ \begin{array}{l} L_i^ + = \max \left\{ {\alpha \left( {\nabla {S_i}} \right) \cdot {L_{i-1}} + \left( {1-\alpha \left( {\nabla {S_i}} \right)} \right) \cdot {S_i}, {S_i}} \right\}, \\ {L_i} = \max \left\{ {\alpha \left( {-\nabla {S_{i + 1}}} \right) \cdot L_{i - 1}^ + + \left( {1 - \alpha \left( { - \nabla {S_{i + 1}}} \right)} \right) \cdot } \right.\\ \;\;\;\;\;\;\left. {{S_{i + 1}}, {S_i}} \right\}. \end{array} \right. $ |

式中:Si为输入信号;Li为输出信号;Li+为中间状态信号;∇Si表示信号的局部梯度;α取值为

| $ \alpha \left( {\nabla S} \right) = \left\{ \begin{array}{l} {\alpha _0}, \;\;\;\;\;\;\;\;\nabla S \ge-\frac{1}{T};\\ -\frac{{{\alpha _0}}}{{\nabla S \cdot T}}, \;\;\;\nabla S <-\frac{1}{T}. \end{array} \right. $ |

式中-1/T为梯度阈值.

对图像的亮度分量进行包络滤波可以得到对应的亮度估计图,根据曝光适宜度的隶属度函数计算亮度估计图的曝光情况.根据每幅图像的曝光情况分配的权值为

| $ {\mathit{\boldsymbol{W}}_i} = \frac{{{\mathit{\boldsymbol{M}}_i}}}{{\sum\nolimits_{i = 0}^n {{\mathit{\boldsymbol{M}}_i}} }}. $ |

式中Wi为第i幅图像的权值矩阵,Mi为第i幅图像的曝光适宜度矩阵.

在同一尺度上求每幅图像的权值矩阵和其低频分量的Hadamard积,然后求和,即得到了融合后的低频分量为

| $ \mathit{\boldsymbol{A}}_{\left( {j, p} \right)}^f = \sum\limits_{i = 1}^n {{{\mathit{\boldsymbol{W'}}}_i}*\mathit{\boldsymbol{A}}_{\left( {j, p} \right)}^i} . $ |

式中:Wi′为与低频分量同尺度的权值矩阵;Ai(j, p)为第i幅的低频分量矩阵;A(j, p)f为低频分量的融合结果;j为分解层数;p=1、2,即分解得到的两个低频分量.

3.3 高频融合规则图像亮度幅值变化特性通过高频分量反映,如图像的边缘等细节特征,高频分量融合结果决定结果的细节信息.人眼对单一像素的大小不敏感,对图像的局部对比度变化十分敏感.考虑系数间的空间相关性,将以系数为中心的小范围区域的区域能量制定融合规则.

对j+1层分解得到的θ方向上位置为(x, y)的高频分量,计算其在3×3范围内的能量E(j+1, θ)(x, y)为

| $ {E_{\left( {j + 1, \theta } \right)}}\left( {x, y} \right) = \sum\limits_{m =-1}^1 {\sum\limits_{n =-1}^1 {\omega \left( {x, y} \right){d^2}\left( {x + m, y + n} \right)} } . $ |

式中d(x+m, y+n)为(x+m, y+n)位置的高频分量系数,ω(x, y)为权重矩阵.中心系数比周边系数对能量的贡献更大,为了突出中心的能量作用,中心位置的权值应大于周围,选取权值

| $ \mathit{\boldsymbol{\omega }}\left( {x, y} \right) = \frac{1}{{16}}\left[{\begin{array}{*{20}{c}} 1&2&1\\ 2&4&2\\ 1&2&1 \end{array}} \right]. $ |

对每幅图像的每个高频分量系数选取加权区域能量最大的系数作为融合后的高频分量系数.

4 实验结果为了验证曝光融合前配准算法选取的合理性以及配准的必要性,在室内和室外分别拍摄两组多曝光图像用于实验,在拍摄的过程相机有位置和视角的变化,模拟航空相机的工作环境.本文主要创新点在于曝光融合算法,为了验证它的有效性,对曝光融合库中的两组已配准的图像序列进行实验, 与5个曝光融合算法对比.为了验证本文方法对真实航空图像的有效性,对两组航空多曝光图像进行实验.实验部分中本文算法的DT-CWT分解次数均选取3.

4.1 实验室仿真实验实验采用CemareLink和以太网将相机拍摄的图像传输到实验室计算机上,在计算机上进行实验,验证本文方法的有效性,拍摄时通过控制CCD的快门时间得到多曝光图像.

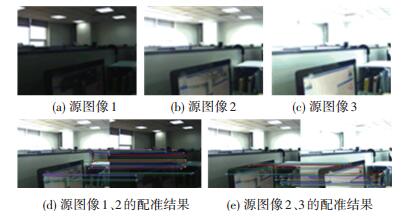

图 5(a)~5(c)为在实验室室内拍摄的一组图像,其中图 5(a)与图 5(b)之间有纵向位移,图 5(b)与图 5 (c)之间有横向位移和视角变化,3幅图像中图 5 (b)的信息熵最高,将其作为参考图像,将图 5 (a)和图 5 (c)分别和图 5 (b)进行图像配准. 图 5(d)、5 (e)展示了它们的配准结果.

|

图 5 室内拍摄的多曝光图像序列及其配准结果 Figure 5 A multi-exposure sequence taken indoor and its registration result |

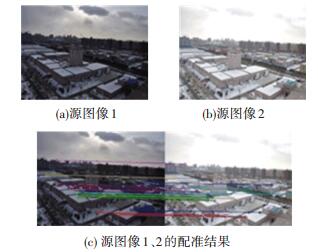

模拟航空相机的工作环境,从高空对地面进行拍摄,如图 6(a)、6(b)所示.在图 6(a)中天空曝光较适宜,亮度适中,但是地面景物曝光量较低,所以亮度较低;而在图 6(b)中恰恰相反,地面景物曝光适宜,亮度适中,但是天空曝光量较高,因此亮度过高. 图 6(c)是它们的配准结果.

|

图 6 室外拍摄的多曝光图像序列及其配准结果 Figure 6 A multi-exposure sequence taken outdoor and its registration result |

从图 5、6中可以看出,SURF配准算法可以在亮度差异很大时得到满意的结果,符合曝光融合前配准的需求.

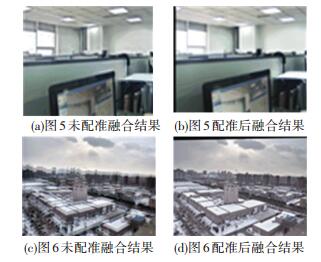

为了验证本文中配准策略的必要性,对未配准图像和配准后的图像使用本文提出的融合算法进行融合,图 5、6的融合结果见图 7,图 7(a)、7(c)分别为图 5、6未配准融合结果,图 7(b)、7(d)分别为图 5、6配准后的融合结果.未配准的融合图像中存在不同程度的重影现象,与拍摄时摄像机的振动程度有关;因为没有配准所以在根据亮度分配权值时不够准确,融合后的结果中有些区域的亮度或颜色与配准后的融合结果存在差异.配准后融合的图像边缘清晰,没有重影现象,亮度均匀.

|

图 7 仿真实验融合结果 Figure 7 Exposure fusion results of simulation experiment |

航空相机在获取多曝光图像过程中,不可避免地会有移动,在曝光融合前进行配准是不可缺少的一步,将配准与曝光融合结合起来,是很有必要的.

4.2 曝光融合图像库实验在本节将本文方法与5种曝光融合方法对比,5种方法的简介如下:文献[3]通过评价图像亮度和颜色得到权值矩阵,并使用递归滤波对其修正;文献[4]使用引导滤波计算每幅图像的加权系数;文献[5]在融合图像时采用稠密SIFT描述子提取图像中的细节信息进行融合;文献[6]首先计算图像的梯度信息,梯度越大表示图像越清晰,由此提出了选取最大梯度的融合规则;文献[7]是在拉普拉斯金字塔模型下,使用对比度、饱和度和曝光度3个评价因子,求源图像的权值.

选取空间频率(spatial frequency, SF),图像清晰度(figure definition,FD),平均梯度(average gradient,AG),边缘信息保持度(edge preservation information,Qab/f)[16]对各种融合方法的效果进行评价.空间频率,图像清晰度和平均梯度反映融合后图像的质量,数值越大表示图像质量越好,边缘信息保持度可以反映算法的融合效果,数值越接近1表示融合结果保留的源边缘信息越多.

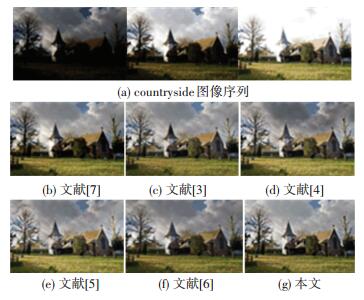

图 8、9分别给出了countryside[17]和office(MATLAB提供)图像序列的实验结果. 图 8(a)为countryside图像序列,它们是在同一场景下拍摄的不同曝光量图像. 图 8(b)~8(g)为本文方法与其他5种曝光融合方法的实验结果.在图 8(b)中,房屋的右墙面亮度较低,细节不够清晰.在图 8(d)中,天空中云的颜色较黑,亮度较低.在图 8(e)中,草地的亮度偏高,图像的清晰程度稍低. 图 8(f)的清晰度较差.本文结果的对比度高,细节清晰.人眼只能大致评判结果,准确评估结果还需通过客观评价指标. 表 1给出了6种结果的客观评价数据,可以看出,本文结果效果最佳.

|

图 8 countryside图像序列的实验结果 Figure 8 Experimental results of countryside sequence |

|

图 9 office图像序列的实验结果 Figure 9 Experimental results of office sequence |

| 表 1 countryside图像序列实验结果数据 Table 1 Objective evaluation for the results of countryside |

图 9(a)为office图像序列,它们是在同一场景下拍摄的不同曝光量图像. 图 9(b)~9(g)为6种曝光融合方法的实验结果,图 9(h)~9(m)是图 9(b)~9(g)的局部放大图.在图 9(d)中,有一块黑色阴影在显示器的左边,这是在源图像序列中没有的,也不应该出现在融合后的结果中,从放大图中可以看出,本文结果中的树枝等细节更清晰,易于分辨. 表 2给出了6种结果的客观评价数据.从表 2中可以看出,本文结果效果最佳.

| 表 2 office图像序列实验结果数据 Table 2 Objective evaluation for results of office |

对两组真实的航空多曝光图像进行实验. 图 10(a)和图 10(b)是在某城市上空拍摄的灰度图像,在图 10(a)中,由于高楼的遮挡形成了一片阴影,阴影下的图像较暗,其中的细节难以分辨,在阴影外的图像曝光适当,细节清晰;图 10(b)的曝光程度较高,在阴影下细节信息显而易见,但是阴影外的景物由于过高的曝光量有些模糊不清.将图 10(a)与图 10(b)进行配准,得到图 10(c),根据配准结果融合得到结果图 10(d),图 10(d)基本保留了两幅图像中曝光适当的部分,整幅图像亮度均匀,细节清晰.

|

图 10 灰度航拍图像实验结果 Figure 10 Experimental results of gray aerial images |

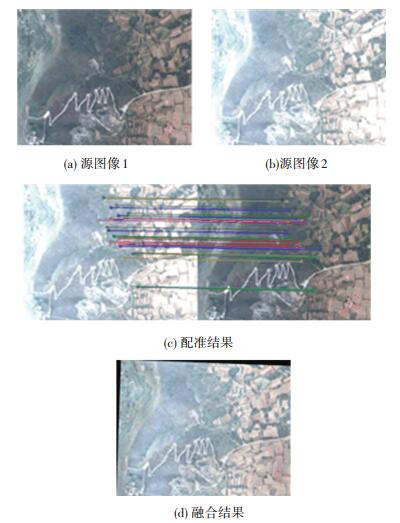

图 11(a)和图 11(b)是在某野外上空拍摄的彩色图像,图 11(a)的中间树林部分图像亮度较低,纹理难以分辨,其他部分曝光较正常;图 11(b)的树林部分曝光适当,细节清晰,而其他部分有些曝光过度.将图 11(a)与图 11(b)进行配准得到图 11(c),根据配准结果融合得到图 11(d),而图 11(d)无论在中间树林部分还是其他部分亮度适宜,细节信息比图 11(a)、11(b)都丰富.

|

图 11 彩色航拍图像实验 Figure 11 Experimental results of color aerial images |

1) 针对目前航空相机调光系统在高动态范围场景下成像过程中出现曝光不足或过度的问题,提出了一种结合亮度估计的曝光融合方法,有效地弥补了这一问题,具有一定的应用价值.

2) 航空相机在同一高动态场景下,多次曝光,得到一组多曝光图像,使用基于SURF算法的小范围快速配准策略对图像配准,避免了直接融合产生的重影现象.

3) 使用DT-CWT将图像分为低频和高频分量,根据图像亮度信息对低频分量融合,这样使得融合结果整体亮度准确、适中;使用加权的区域绝对值最大法用于高频分量的融合,有效地保留了源图像中的细节信息.

4) 结合亮度估计的航空相机曝光融合方法有效地解决了拍摄过程中相机移动导致的融合结果中的重影问题;与其他5种具有代表性的曝光融合方法相比较,该方法融合效果较好.

| [1] |

申小禾, 刘晶红, 楚广生. 基于直方图分析的航空摄像机自动调光方法研究[J]. 电子与信息学报, 2016, 38(3): 541-548. SHEN Xiaohe, LIU Jinghong, CHU Guangsheng. Auto exposure algorithm for aerial camera based on histogram statistics method[J]. Journal of Electronics & Information Technology, 2016, 38(3): 541-548. |

| [2] |

黄辉, 周进. 基于现场可编程门阵列的CCD相机自动调光[J]. 光学精密工程, 2014, 22(2): 426-433. HUANG Hui, ZHOU Jin. Auto-exposure for CCD camera based on FPGA[J]. Optics and Precision Engineering, 2014, 22(2): 426-433. |

| [3] |

LI Shutao, KANG Xudong. Fast multi-exposure image fusion with median filter and recursive filter[J]. IEEE Transactions on Consumer Electronics, 2012, 58(2): 626-632. DOI:10.1109/TCE.2012.6227469 |

| [4] |

LI Shutao, KANG Xudong, HU Jianwen. Image fusion with guided filtering[J]. IEEE Transactions Image Processing, 2013, 22(7): 2864-2875. DOI:10.1109/TIP.2013.2244222 |

| [5] |

LIU Yu, WANG Zengfu. Dense SIFT for ghost-free multi-exposure fusion[J]. Journal of Visual Communication and Image Representation, 2015, 31(7): 208-224. |

| [6] |

PAUL S, SEVCENCO S I, AGATHOKLIS P, et al. Multi-exposure and multi-focus image fusion in gradient domain[J]. Journal of Circuits Systems and Computers, 2016, 25(10): 123-131. |

| [7] |

MERTENS T, KAUTZ J, REETH F V. Exposure fusion: a simple and practical alternative to high dynamic range photography[J]. Computer Graphics Forum, 2009, 28(1): 161-171. DOI:10.1111/cgf.2009.28.issue-1 |

| [8] |

SHEN Jiangbing, ZHAO Ying, YAN Shuicheng, et al. Exposure fusion using boosting laplacian pyramid[J]. IEEE Transactions on Cybernetics, 2014, 44(9): 1579-1590. DOI:10.1109/TCYB.2013.2290435 |

| [9] |

DO M N, VETTERLI M. The contourlet transform: an efficient directional multiresolution image representation[J]. IEEE Transactions on Image Processing, 2005, 14(12): 2091-2106. DOI:10.1109/TIP.2005.859376 |

| [10] |

闫利, 向天烛. NSCT域内结合边缘特征和自适应PCNN的红外与可见光图像融合[J]. 电子学报, 2016, 44(4): 761-766. YAN Li, XIANG Tianzhu. Fusion of infrared and visible images based on edge feature and adaptive PCNN in NSCT domain[J]. Acta Electronica Sinica, 2016, 44(4): 761-766. |

| [11] |

YANG Yong, TONG Song, HUANG Shuying, et al. Multifocus image fusion based on NSCT and focused area detection[J]. IEEE Sensors Journal, 2015, 15(5): 2824-2838. |

| [12] |

KINGSBURY N. The dual-tree complex wavelet transform: a new technique for sift invariance and directional filters[C]//Proceeding of 8th IEEE Digital Signal Processing Workshop. Bryce Canyon: IEEE, 1998: 120-131.

|

| [13] |

SELESNICK I W, BARANIUK R G, KINGSBURY N. The dual-tree complex wavelet transform[J]. IEEE Signal Processing Magazine, 2005, 22(6): 123-151. DOI:10.1109/MSP.2005.1550194 |

| [14] |

SHAKED D, KESHST R. Robust recursive envelope operators for fast Retinex: HPL-2002-74(R. 1)[R]. Haifa: Hewlett Packard Research Laboratories, 2004.

|

| [15] |

BAY H, TUYTELAARS T, GOOL L V. SURF: speeded up robust features[C]// Proceeding of the European Conference on Computer Vision. Graz: Springer, 2006: 404-417.

|

| [16] |

XYDEAS C, PETROVIC V. Objective image fusion performance measure[J]. Electronics Letters, 2005, 36(4): 308-309. |

| [17] |

VONIKAKIS V, BOUZOS O, ANDEADIS I. Multi-exposure image fusion based on illumination estimation[C]// Proceeding of Signal and Image Processing and Applications. Heraklion: SIPA, 2011: 135-142.

|

2018, Vol. 50

2018, Vol. 50