随着科学技术的发展,现代战争的作战形式发生了巨大变化,其中以高超声速滑翔式再入飞行器为代表的远程快速精确静默打击受到了越来越多国家的关注[1].与此同时,为了应对其大跨空域、高超声速飞行所带来的威胁,各国相继研发出一系列反导系统来降低高超声速飞行器的作战效能.在这一系列技术博弈推动下,发展多高超声速飞行器协同饱和打击技术成为未来的一个必然趋势[2].

由于长距离飞行和跨空域的复杂环境变化特点,高超声速飞行器协同饱和打击任务要求各飞行器能够在一定程度上自由调节自身飞行时间,进而实现在指定时间范围内对目标的打击.而在这一过程中,无动力滑翔再入段占据了90%以上,是影响最终时间和饱和打击效果的决定性因素之一[2-3],因而针对该阶段的飞行时间可控性要求进行相应的再入制导律设计具有一定的必要性与紧迫性.

现阶段再入制导方法主要有标称轨迹制导和预测-校正制导,二者各有特点并已成功运用于工程实践之中[4-6].但其均没有考虑飞行时间约束,仅以到达指定状态为目标,加之再入运动的复杂性,时间可控再入制导律的发展较为缓慢.王少平等[2]利用离线轨迹优化方法对其可控性进行了验证,但无法解决实际环境中的参数摄动问题;方科等[3]利用神经网络对剩余飞行误差进行在线预估与校正,总体上具有一定的可行性但存在较多的人为限定因素.从已有的研究成果中可知,高超声速飞行器指定飞行时间的再入制导问题的主要难点与特点为:1)大跨空域、高空高速飞行使得整个过程中存在大量相互耦合的不确定性因素;2)各类干扰对于飞行时间的影响不明确且相互耦合,难以进行详细分析;3)无动力再入过程总能量有限且控制过程不可逆,难以实现类似文献[7]中的显式制导律设计,需要进行方法创新;4)高超声速飞行器再入轨迹具有较强的横纵向解耦特性[5].在到达目标点的前提下,飞行时间主要与横向制导律有关,其通过对倾侧角符号的规划来改变横向机动范围,实现再入飞行时间调整[3].

由此可知,时间可控再入制导可归结为横向上的倾侧角符号规划问题,但由于其复杂性和制导实时性要求,常规方法难以应用.而强化学习类方法在一些决策问题上的出色表现为本文供了可行的探索方向,并且其“离线训练+在线使用”模式具有较强的适应性与实时性[8-9].所以本文首先给出总体制导律结构,之后引入深度Q-学习网络(deep Q-learning network, DQN)进行倾侧角符号规划策略设计,实现指定飞行时间的再入过程,最后进行相应的仿真验证.

1 指定飞行时间的再入问题描述高超声速飞行器的三自由度无动力滑翔再入过程(忽略地球自转)运动方程为[5]

| $ \left\{ \begin{array}{l} \begin{array}{*{20}{l}} {\dot r = v\sin \theta ,}\\ {\dot \lambda = \frac{{v\cos \theta \sin \psi }}{{r\cos \varphi }},} \end{array}\\ \begin{array}{*{20}{l}} {\dot \varphi = \frac{{v\cos \theta \cos \psi }}{r},}\\ {{{\dot S}_{\rm{e}}} = \frac{{v\cos \theta }}{r},} \end{array}\\ \dot v = - \frac{D}{m} - g\sin \theta ,\\ \begin{array}{*{20}{l}} {\dot \theta = \frac{1}{v}\left[ {\frac{{L\cos \sigma }}{m} + \left( {\frac{{{v^2}}}{r} - g} \right)\cos \theta } \right],}\\ {\dot \psi = \frac{1}{v}\left[ {\frac{{L\sin \sigma }}{{m\cos \theta }} + \frac{{{v^2}}}{r}\cos \theta \sin \psi \tan \varphi } \right].} \end{array} \end{array} \right. $ |

式中:地心距r=R0+h,其中R0=6 378 km为地球半径, h为飞行高度;v为飞行速度;θ为速度倾角, 水平为0且向上为正;Se为射程角; λ、φ分别为经纬度;ψ为弹道偏航角,正北方为0且顺时针为正;σ为倾侧角,右偏为正;m为质量;g为当前高度下地球重力加速度;L、D分别为升力和阻力.

再入飞行过程是一个复杂的多约束运动学问题.对于制导律而言需要在线生成制导指令,实现多余能量的安全逸散和引导飞行器到达指定状态(高度、速度、位置等).具体约束项分别为:

| $ \dot Q = \frac{{11030}}{{\sqrt {0.1} }}{\left( {\frac{v}{{{V_{\rm{c}}}}}} \right)^{3.15}}{\left( {\frac{\rho }{{{\rho _0}}}} \right)^{0.5}} \le {{\dot Q}_{\max }}, $ | (1) |

| $ n = \sqrt {{L^2} + {D^2}} /m{g_0} \le {n_{\max }}, $ | (2) |

| $ q = 0.5\rho {v^2} \le {q_{\max }}, $ | (3) |

| $ \left( {g - {v^2}/r} \right) - L\cos {\sigma _{{\rm{EQ}}}}/m = 0, $ | (4) |

| $ \left| {{\sigma _{{\rm{cmd}}}}} \right| \le {90^\circ },\left| {{{\dot \sigma }_{{\rm{cmd}}}}} \right| \le {{\dot \sigma }_{{\rm{max}}}}, $ | (5) |

| $ h\left( {{t_{\rm{f}}}} \right) = {h_{\rm{f}}},v\left( {{t_{\rm{f}}}} \right) = {v_{\rm{f}}},\lambda \left( {{t_{\rm{f}}}} \right) = {\lambda _{\rm{f}}},\varphi \left( {{t_{\rm{f}}}} \right) = {\varphi _{\rm{f}}}. $ | (6) |

式中:

除此之外,飞行时间约束条件为

| $ {t_{{\rm{need}}}} = \int_{{t_0}}^{{t_{\rm{f}}}} {\rm{d}} t = {t_{\rm{f}}} - {t_0}. $ |

式中:tneed为期望的再入飞行时间,t0为起始时刻.

本文以CAV-H为对象进行研究与仿真分析,具体参数设置见文献[10].

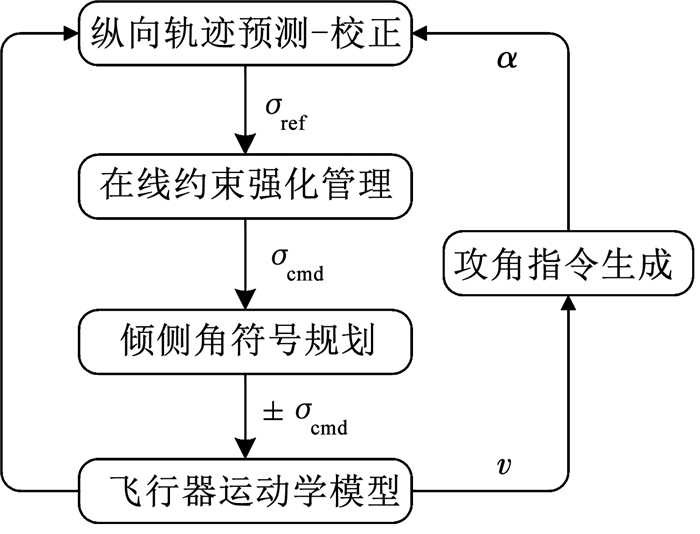

2 制导系统总体结构本文所设计的制导律总体如图 1所示,其主要包括纵向轨迹预测-校正、在线约束强化管理、倾侧角符号规划3个模块.

|

图 1 制导系统总体结构 Fig. 1 Overall scheme of reentry guidance system |

在每个制导周期内,攻角指令生成模块根据如下的速度-攻角剖面[10]生成α.

| $ \alpha = \left\{ {\begin{array}{*{20}{l}} {{{35}^\circ },v \ge 10.0Ma;}\\ {{{\left[ {35 - 0.45{{(v - 10)}^2}} \right]}^\circ },2.5\quad Ma \le v < 10.0Ma.} \end{array}} \right. $ |

式中:Ma为马赫数.随后纵向轨迹预测-校正模块进行纵向轨迹规划并输出无符号倾侧角σref;之后在线约束强化管理模块对其进行限幅,输出无符号的σcmd;最后倾侧角符号规划模块利用训练好的DQN,根据当前飞行状态进行决策,输出有符号的倾侧角指令±σcmd并作用于运动模型之中.

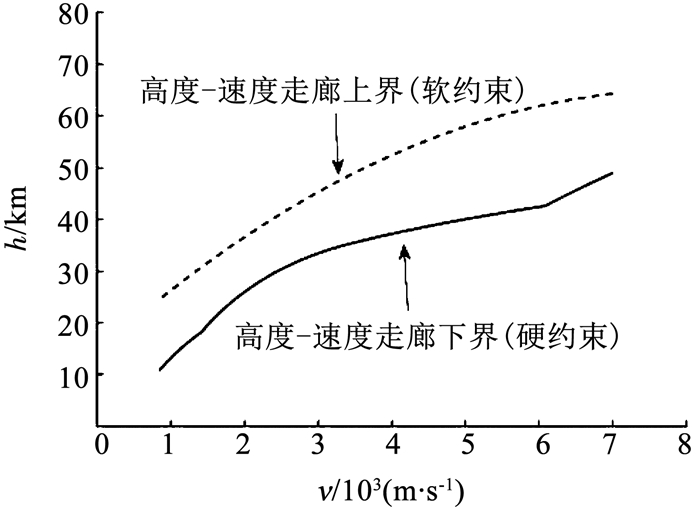

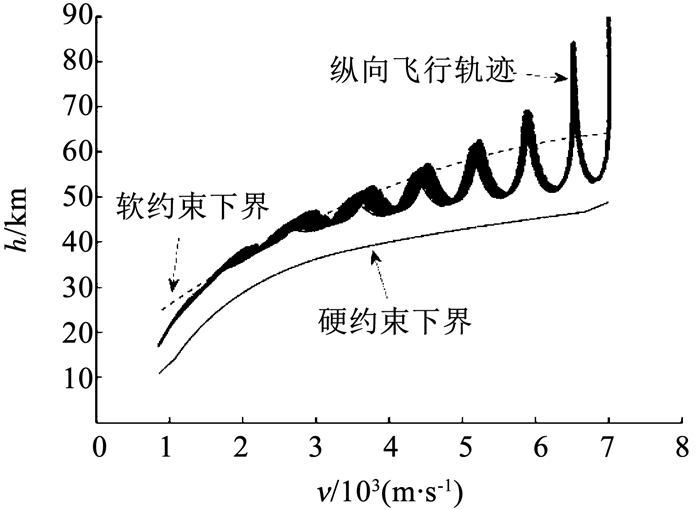

3 指定飞行时间的再入制导律由于再入制导问题的复杂性和狭窄的可行解范围,首先需要进行约束降维与简化,即构建如图 2、3所示的可行高度-速度走廊和倾侧角走廊.

|

图 2 可行高度-速度走廊 Fig. 2 Feasible altitude-velocity corridor |

|

图 3 倾侧角-速度走廊 Fig. 3 Bank angle-velocity corridor |

相关研究表明,再入飞行时间主要与横向机动范围、参数不确定性等因素有关[3].其中参数不确定性是造成时间不可控的主要被动因素,需要通过对主动因素——即横向机动范围的调节进行抑制.而再入过程具有明显的横纵向解耦特性[5],横向机动范围只与横向制导律——即倾侧角符号规划方法有关;同时因篇幅有限,本文将重点介绍倾侧角符号规划模块的设计方法.

3.1 纵向轨迹预测-校正根据地球任意两经纬度之间最短圆弧距离计算公式和射程角定义,可将终端经纬度约束转换为如下的射程角约束:

| $ {S_{\rm{e}}}\left( {{t_{\rm{f}}}} \right) = \arccos \left[ {\sin \varphi \sin {\varphi _{\rm{f}}} + \cos \varphi \cos {\varphi _{\rm{f}}}\cos \left( {\lambda - {\lambda _{\rm{f}}}} \right)} \right] = {S_{{\rm{go}}}}, $ |

式中Sgo为所需的剩余射程角.参数化之后的倾侧角规划剖面为

| $ {\sigma _{{\rm{design}}}}(v) = \omega {\sigma _{\min }}(v) + (1 - \omega ){\sigma _{\max }}(v). $ | (7) |

式中:ω为权重系数;σdesign(v)为规划的倾侧角剖面;σmin(v)、σmax(v)分别为倾侧角-速度走廊的下、上界.由此将轨迹规划转化为ω的单参数规划问题,而ω与Se存在如下的单调递增隐函数关系[6]:

| $ {R_0}{S_{\rm{e}}} = f(\omega ), $ | (8) |

| $ {S_{\rm{p}}}(\omega ) \approx c\omega + d. $ |

式中:Sp(ω)为预估的剩余射程角;c、d为待估计参数.通过引入最小二乘方法对其进行在线参数迭代估计,使得在每个制导周期内仅需一次全弹道积分便可完成ω与σdesign(v)的校正,具体计算流程如下[3, 6]:

| $ \left\{ {\begin{array}{*{20}{l}} {{{\mathit{\boldsymbol{\hat x}}}_k} = {{\left[ {{{\hat c}_k}{{\hat d}_k}} \right]}^{\rm{T}}},}\\ {{{\mathit{\boldsymbol{\hat x}}}_{k + 1}} = {{\mathit{\boldsymbol{\hat x}}}_k} + {\mathit{\boldsymbol{K}}_{k + 1}}\left( {{z_{k + 1}} - \mathit{\boldsymbol{h}}_{k + 1}^{\rm{T}}{{\mathit{\boldsymbol{\hat x}}}_k}} \right),}\\ {{\mathit{\boldsymbol{h}}_k} = {{\left[ {{\mathit{\boldsymbol{\omega }}_k}1} \right]}^{\rm{T}}},}\\ {{z_k} = {S_{\rm{p}}}\left( {{\mathit{\boldsymbol{\omega }}_k}} \right),}\\ {{\mathit{\boldsymbol{K}}_{k + 1}} = {\mathit{\boldsymbol{P}}_k}{\mathit{\boldsymbol{h}}_{k + 1}}{{\left( {{R_{k + 1}} + \mathit{\boldsymbol{h}}_{k + 1}^{\rm{T}}{\mathit{\boldsymbol{P}}_k}{\mathit{\boldsymbol{h}}_{k + 1}}} \right)}^{ - 1}},}\\ {{\mathit{\boldsymbol{P}}_{k + 1}} = \left( {\mathit{\boldsymbol{I}} - {\mathit{\boldsymbol{K}}_{k + 1}}\mathit{\boldsymbol{h}}_{k + 1}^{\rm{T}}} \right){\mathit{\boldsymbol{P}}_k},}\\ {{\mathit{\boldsymbol{\omega }}_{k + 1}} = {\mathit{\boldsymbol{\omega }} _k} + \left[ {{S_{{\rm{go}}}} - {S_{\rm{p}}}\left( {{\mathit{\boldsymbol{\omega }}_k}} \right)} \right]/{{\hat c}_{k + 1}}.} \end{array}} \right. $ |

式中:下标k为第k个周期;ĉ、

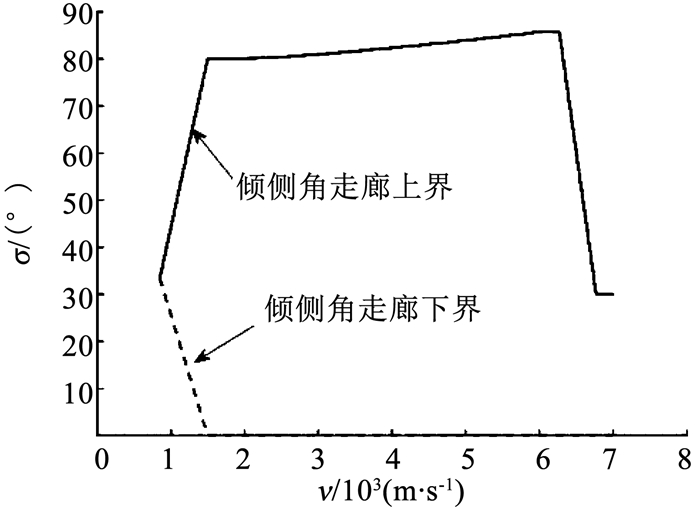

|

图 4 在线约束强化管理 Fig. 4 Online constraint enhanced management |

其中,终端约束强化管理过程为

| $ \left\{ {\begin{array}{*{20}{l}} {\Delta \theta = \theta - {\theta _{\rm{f}}},}\\ {\Delta \cos {\sigma _{{\rm{coe}}}} = {A_3}vm\Delta \theta /L,}\\ {{\sigma _{{\rm{to}}}} = \arccos \left( {\cos {\sigma _{{\rm{ref}}}} + \Delta \cos {\sigma _{{\rm{coe}}}}} \right),} \end{array}} \right. $ |

式中常数A3 < 0.过程约束强化管理过程为

| $ \left\{ {\begin{array}{*{20}{l}} {\Delta {h_{\rm{d}}} = h - {h_{{\rm{down}}}},}\\ {\cos {\sigma _{{\rm{connin}}}} = \frac{m}{L}\left[ {\frac{{\Delta {{\ddot h}_{\rm{d}}} - 2{\lambda _h}\Delta {{\dot h}_{\rm{d}}} - \lambda _h^2\Delta {h_{\rm{d}}}}}{{\cos \theta }} - \left( {g - \frac{{{v^2}}}{r}} \right)\cos \theta } \right],}\\ {{\sigma _{{\rm{po}}}} = \min \left( {{\sigma _{{\rm{to}}}},{\sigma _{{\rm{conin}}}}} \right).} \end{array}} \right. $ |

式中:λh∈[0, 1]为高度下降速率限制因子;Δhd为剩余可行高度,hdown为当前速度v在可行高度-速度走廊上所对应的高度下界.

控制约束强化管理过程为

| $ \sigma _{{\rm{cmd}}}^k = \left( {1 - {k_{{\rm{pf}}}}} \right)\sigma _{{\rm{cmd}}}^{k - 1} + {k_{{\rm{pf}}}}\sigma _{{\rm{po}}}^k. $ |

式中:上标k为第k个制导周期;kpf∈[0, 1].经过以上限幅处理最终得到倾侧角指令σcmd.

3.3 倾侧角符号规划在传统再入制导律设计中,通常只考虑制导精度、实时性、鲁棒性等,然而饱和打击任务的出现,使得再入飞行时间的可控性也成为一个值得考虑的重要因素[1].

现阶段研究表明,高超声速飞行器无动力滑翔再入过程具有一定的时间可控性,并且主要与横向制导律有关[3].其通过对倾侧角符号的规划来改变横向机动范围,进而调节再入飞行时间.倾侧角符号规划本质上而言是一个典型的二值决策问题,即根据当前状态和目标给出“+”或“-”,但受困于问题的复杂性,难以使用传统方法进行分析与设计.然而强化学习类方法所具有的设计流程通用性、自学习自适应能力、泛化能力,为本文的横向制导律设计提供了可行的探索方向.

3.3.1 DQN基本流程强化学习类方法的目标是通过大量数据积累和参数寻优,得到一套能最大化如下所示的期望累计收益Jπθ(s0, sf)的策略πθ[11].

| $ {J_{{{\rm{ \mathsf{ π} }}^\theta }}}\left( {{s_0},{s_{\rm{f}}}} \right) = {\mathit{\boldsymbol{E}}_{{{\rm{ \mathsf{ π} }}^\theta }}}\left[ {\sum\limits_{t = 0}^n {{\eta ^t}P\left( {{s_t},{a_t},{s_{t + 1}}} \right){f_{\rm{R}}}\left( {{s_t},{a_t},{s_{t + 1}}} \right)} } \right], $ | (9) |

式中:Jπθ(s0, sf)为在πθ作用下,从初状态s0经过n步到达终端状态sf的期望累计收益;E[·]为求取期望值的符号函数;st为第t步的状态;at为第t步的动作;fR(st, at, st+1)为状态st下选择动作at后到达状态st+1的收益函数;P(st, at, st+1)为状态转移概率,表示状态st下采用at后成功转移到st+1的概率;η∈[0, 1]为衰减系数.与此同时需要将原问题建模成如下的马尔可夫决策过程(markov decision process,MDP).

| $ {\rm{MDP}} = \left( {\mathit{\boldsymbol{S}},\mathit{\boldsymbol{A}},P,{f_{\rm{R}}},\mathit{\boldsymbol{\eta }}} \right). $ |

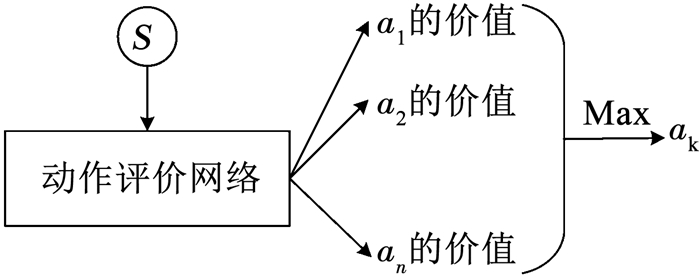

式中:S为所有状态空间的集合且∀s∈S; A为所有动作空间的集合且∀a∈A.针对本文所研究问题具有状态空间无限、动作空间有限的特点,选择DQN进行横向制导律设计,其基本流程如图 5所示.

|

图 5 DQN基本流程 Fig. 5 Fundamental process of DQN |

在每个训练周期中,DQN根据内部参数πυ的动作评价网络对当前状态s下所有能够采取的动作ai(i=1, 2, …, n)的价值Qπυ(s, ai)进行估计,输出其中具有最大价值的动作ak;之后根据ak的实际价值与估计值之间的误差对πυ进行更新.为保证网络具有一定探索能力,定义以ηε进行指数衰减的探索率ε,使得每次输出均存在概率ε进行随机动作选择.假设在第t步时状态为st,输出的动作at,收益为Rt,则该状态-动作对的实际价值QTπυ(st, at)为

| $ Q_{\rm{T}}^{{{\rm{ \mathsf{ π} }}^v}}\left( {{s_t},{a_t}} \right) = \left\{ {\begin{array}{*{20}{l}} {{R_t},{s_{t + 1}} = {s_{\rm{f}}};}\\ {{R_t} + \eta \max {Q^{{{\rm{ \mathsf{ π} }}^v}}}\left( {{s_{t + 1}},{a_{t + 1}}} \right),{s_{t + 1}} \ne {s_{\rm{f}}}.} \end{array}} \right. $ |

动作评价网络对于该状态-动作对的估计价值为Qπυ(st, at),可得误差函数L(πυ)为

| $ L\left( {{{\rm{ \mathsf{ π} }}^v}} \right) = {E_{{{\rm{ \mathsf{ π} }}^\theta }}}\left[ {\frac{1}{2}{{\left( {Q_{\rm{T}}^{{{\rm{ \mathsf{ π} }}^v}}\left( {{s_t},{a_t}} \right) - {Q^{{{\rm{ \mathsf{ π} }}^v}}}\left( {{s_t},{a_t}} \right)} \right)}^2}} \right]. $ |

L(πυ)相对于各网络参数πυ的梯度为

| $ \frac{{\partial L\left( {{{\rm{ \mathsf{ π} }}^v}} \right)}}{{\partial {{\rm{ \mathsf{ π} }}^v}}} = {\mathit{\boldsymbol{E}}_{{{\rm{ \mathsf{ π} }}^\theta }}}\left[ {\left( {Q_{\rm{T}}^{{{\rm{ \mathsf{ π} }}^v}}\left( {{s_t},{a_t}} \right) - {Q^{{{\rm{ \mathsf{ π} }}^v}}}\left( {{s_t},{a_t}} \right)} \right)\frac{{\partial {Q^{{{\rm{ \mathsf{ π} }}^v}}}\left( {{s_t},{a_t}} \right)}}{{\partial {{\rm{ \mathsf{ π} }}^v}}}} \right], $ | (10) |

根据式(10)对网络参数πυ进行调整与更新,并不断重复上述流程,最终在理论上可以获得一套能够根据当前状态与目标对倾侧角符号进行规划决策的网络参数πυ.

3.3.2 马尔可夫决策过程建模为了将DQN应用到横向制导律设计中,首先对原问题进行马尔可夫决策过程建模.考虑到再入飞行时间主要与横向飞行状态有关[3],并综合射程、落点误差和再入飞行时间要求,构建如下的状态空间集合S为

| $ \mathit{\boldsymbol{S}} = {\left[ {\begin{array}{*{20}{l}} h&v&\lambda &\varphi &{{S_{{\rm{go}}}}}&\psi &{\Delta t} \end{array}} \right]^{\rm{T}}}, $ |

式中Δt=tneed-tpre为剩余飞行时间误差, 其中tpre为当前飞行状态下改变倾侧角符号后,剩余飞行时间的估计量,其来源于纵向轨迹预测-校正模块中的全弹道积分预测结果.其中由于再入飞行的横纵向解耦特性,倾侧角符号的改变只会影响飞行轨迹的横向分布而不会造成总射程的变化,既不会影响到纵向轨迹规划结果.所以只需要改变原轨迹预测过程中的倾侧角符号即可得到在倾侧角改变后的剩余时间tpre,并且该过程也不会增加额外的制导周期耗时.

由于各状态量之间数量级与物理意义的差异,需要进行如下的归一化过程:

| $ \tilde h = \frac{{h - \left( {{h_0} + {h_{\rm{f}}}} \right)/2}}{{{h_0} - {h_{\rm{f}}}}},\tilde v = \frac{{v - \left( {{v_0} + {v_{\rm{f}}}} \right)/2}}{{{v_0} - {v_{\rm{f}}}}}, $ |

| $ \tilde \lambda = \frac{{\lambda - \left( {{\lambda _{\rm{f}}} + {\lambda _0}} \right)/2}}{{{\lambda _{\rm{f}}} - {\lambda _0}}},\tilde \varphi = \frac{{\varphi - \left( {{\varphi _{\rm{f}}} + {\varphi _0}} \right)/2}}{{{\varphi _{\rm{f}}} - {\varphi _0}}}, $ |

| $ {{\tilde S}_{{\rm{go}}}} = \frac{{{S_{{\rm{go}}}}}}{{{S_0}}},\tilde \psi = \frac{\psi }{2},\Delta \tilde t = \frac{{{t_{{\rm{need}}}} - {t_{\rm{p}}} - {t_{{\rm{pre}}}}}}{{{t_{{\rm{need}}}}}}, $ |

其中归一化之后的状态空间集合S为

| $ \mathit{\boldsymbol{S}} = {\left[ {\begin{array}{*{20}{c}} {\tilde h}&{\tilde v}&{\tilde \lambda }&{\tilde \varphi }&{{{\tilde S}_{{\rm{go}}}}}&{\tilde \psi }&{\Delta \tilde t} \end{array}} \right]^{\rm{T}}}. $ | (11) |

式中:下标0、f分别为初始时刻与终端时刻;S0为初始射程角;tp为已飞行时间.

由于倾侧角符号仅存在正负两种可能,所以动作空间集合A为

| $ \mathit{\boldsymbol{A}} = {\rm{sign}} (\sigma ) = \left\{ {1, - 1} \right\}, $ | (12) |

式中sign(·)为求取正负号函数.

收益函数fR的设计较为复杂,主要原因在再入飞行存在难以量化的多任务目标特点.常规的强化学习类问题往往只有一个优化目标,例如最短时间等;然而指定飞行时间的再入过程存在落点误差和飞行时间两个指标,并且需要尽可能地减少倾侧角符号的变化次数.所以结合混合奖励函数设计方法[12],将fR设置为

| $ {f_{\rm{R}}}\left( {{s_t},{a_t},{s_{t + 1}}} \right) = \left\{ {\begin{array}{*{20}{l}} {{\varepsilon _{\rm{r}}} - 0.1\left( {\Delta S + \left| {\Delta {t_{\rm{f}}}} \right|} \right),{s_{t + 1}} = {s_f};}\\ {{\varepsilon _{\rm{r}}},{s_{t + 1}} \ne {s_f}.} \end{array}} \right. $ |

式中:ΔS=20(Serror/100)2,其中Serror为终端横向距离误差;Δtf=2(terror/10)2,其中terror为最终飞行时间误差;倾侧角符号奖励函数εr为

| $ {\varepsilon _{\rm{r}}} = \left\{ {\begin{array}{*{20}{l}} {0.01, {\rm{sign}} \left( {{\sigma _t}} \right) = {\rm{sign}} \left( {{\sigma _{t - 1}}} \right);}\\ { - 0.10, {\rm{sign}} \left( {{\sigma _t}} \right) \ne {\rm{sign}} \left( {{\sigma _{t - 1}}} \right).} \end{array}} \right. $ |

εr的设置引导决策网络在训练中更加倾向于以更少次数的符号变化来完成给定的飞行任务,提高横向制导律的稳定性与工程可行性.由于飞行器的运动为确定性事件并存在终端截止条件,式(9)可简化为

| $ J = {J_{{{\rm{ \mathsf{ π} }}^\theta }}}\left( {{s_0},{s_{\rm{f}}}} \right) = \sum\limits_{t = 0}^n {{f_{\rm{R}}}} \left( {{s_t},{a_t},{s_{t + 1}}} \right). $ |

在实际训练过程中,由于问题较为复杂且奖励函数稀疏,可行解范围狭窄,训练过程不稳定且收敛速度慢;并且由运动模型自举产生的训练数据集内部存在强关联性,降低了网络的稳定性与泛化能力.所以为了改善网络的稳定性、训练速度和泛化能力,需要加入以下两项改进措施:

1) 经验池和小批量梯度下降.由于再入飞行的长周期性,通过在线自举产生的训练集破坏了样本之间的相互独立性要求,所以需要引入经验池和小批量梯度下降方法.称每次自举产生的样本(st, at, Rt, st+1)为一条经验,将其放入容量大小为VMP的经验池中,在每次训练中随机选择其中的VMB条经验组成训练数据集.由于VMP≫VMB,因而每次训练中使用的绝大多数数据来源于不同的再入过程,大大地降低了数据间的关联性.并且通过小批量梯度下降方法求取的加权平均梯度能够有效抑制数据自身扰动,使得训练过程更加平稳和减少资源占用率.

2) 阶段性迭代训练方法.从凸函数上的任意一点出发,沿着梯度下降的方向移动,必然能够到达全局最小值附近,但该结论在函数非凸的情况下并不成立.强化学习类方法中所使用的多层神经网络恰恰是非凸函数,所以其理论上存在多个局部极小值,并且随着网络复杂性与层数的增加而增多,这是造成实际训练过程不稳定和发散的主要原因之一[11, 13].同时,问题可行域的狭小也是造成以上现象的原因之一,并且难以通过简单地设置学习率进行解决.针对以上问题,本文结合自适应思想和逐步缩小可行域方法,设计了一套阶段性迭代训练方法.

设网络初始学习率、探索率为αL和ε.在Ed个训练周期后,每个周期的总收益J在一定范围内振荡或出现持续衰减,则说明在该学习率下,网络训练已到达饱和或存在陷入局部极值点的风险,需要减小相关训练参数.定义Ed为阶段训练周期,并称此时网络完成了一个阶段的学习,保存此时网络参数并将学习率改为

| $ {{\alpha '}_{\rm{L}}} = {\delta _\alpha }{\alpha _{\rm{L}}}, $ |

式中衰减率δα∈[0.01,0.10].探索率重置为

| $ {{\varepsilon '}_0} = {\delta _\varepsilon }{\varepsilon _0}. $ |

式中:衰减率δε∈[0.25,1.00];ε0为上一个阶段的初始探索率.

在新的学习率α′L和探索率ε′0基础上继续训练网络约Ed个周期,若每个周期的总收益J满足要求则结束训练,反之重复以上的训练参数衰减过程直至J符合要求或不再提高.

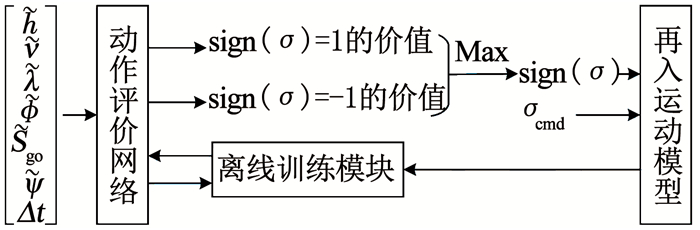

最后综合以上给出本文所设计的横向制导律基本流程,具体如图 6所示.其中离线训练模块(含阶段性迭代训练方法等)仅用于离线训练过程,并不出现在实际应用中.通过离线训练得到一套较好的动作评价网络参数πυ,在实际的每个制导周期内,各状态量组成式(11)的状态向量输入到动作评价网络之中.该网络输出式(12)两个动作的价值,进而选择具有最大价值的动作作为倾侧角的符号输出,最后与σcmd共同作用于实际再入运动模型.

|

图 6 基于DQN的横向制导律基本流程 Fig. 6 Basic process of lateral guidance law based on DQN |

本文DQN中的动作评价网络采用如图 7所示的全连接结构,输入层为式(11)的状态向量;两个隐藏层神经元节点数均为500,采用ReLU激活函数;输出层为式(12)中两个动作的估计价值,采用线性激活函数.在人为经验[14]和多次尝试的基础上,网络参数设定为:经验池大小VMP=105,每次抽取样本数VMB=212.初始学习率αL=10-5,初始探索率ε=0.2,衰减系数ηε=0.999 97;阶段性训练周期Ed=102,衰减系数δα=10-2、δε=0.5;仿真步长ΔT=1 s.由于飞行器在再入过程中的机动能力十分有限,时间调节能力较小,飞行任务(即飞行距离与再入时间之间的合理性)的设置较为严苛,所以为避免在训练过程中出现不合理的设置,本文再入任务的生成与可行性验证来源于文献[3].最后定义一次再入任务及其网络训练的完成为一个训练周期.

|

图 7 全连接DQN结构 Fig. 7 Structure of full-connected DQN |

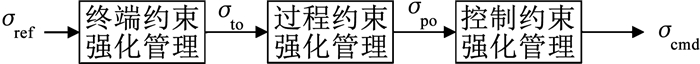

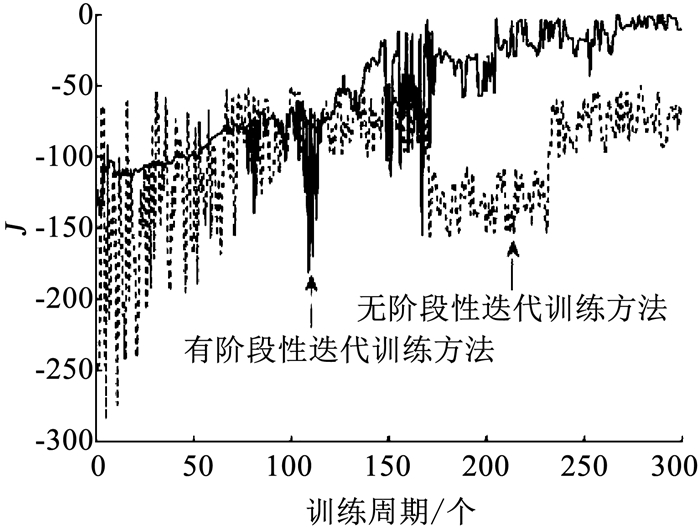

为验证阶段性迭代训练方法的有效性,在相同软硬件条件下进行300个训练周期的对比实验,每个周期总收益J的变化如图 8所示.

|

图 8 训练过程中总收益J的变化对比 Fig. 8 Comparison of total reward J during training |

图 8表明在固定学习率下,所训练的网络大约在170个训练周期后出现总收益J急剧下降的现象,说明网络陷入局部极值陷阱.虽然在230个训练周期后网络跳出了该陷阱,但受限于过大的学习率,网络参数接近饱和,J在-100~-50之间震荡.与之相对的在加入了阶段性迭代训练方法后,网络能够成功地避开极值陷阱并一直保持较高的增长率.这说明了本文所设计的阶段性迭代训练方法具有一定的有效性,其能够在一定程度上解决网络在长时间训练后陷入局部极值陷阱和过早饱和现象的发生.

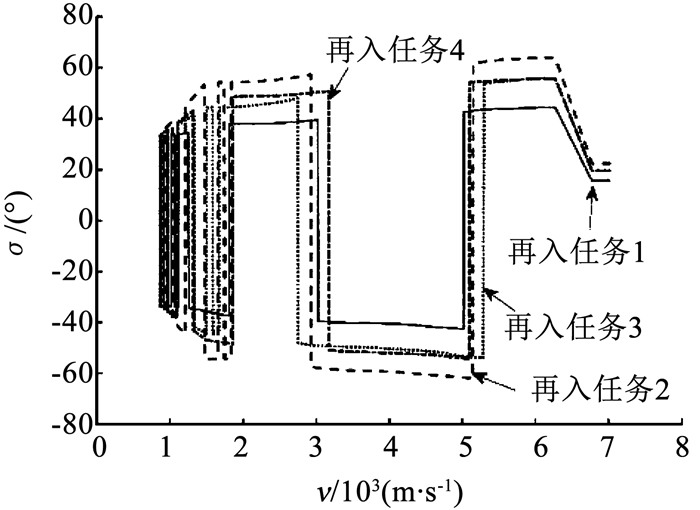

4.2 多任务标称环境仿真为验证时间可控再入制导律的有效性和任务适应性,首先进行标称环境下的多任务指定再入时间仿真.各再入任务初始点见表 1[10, 15],目标点的经、纬度坐标均为(215°, 25°),仿真结果如图 9~11所示,统计结果见表 2.

| 表 1 再入任务初始点设置 Tab. 1 Setting of reentry missions' initial points |

|

图 9 多任务纵向轨迹 Fig. 9 Longitudinal trajectory of multi-mission |

|

图 10 多任务横向轨迹 Fig. 10 Horizontal trajectory of multi-mission |

|

图 11 多任务倾侧角剖面 Fig. 11 Bank angle profile of multi-mission |

| 表 2 多任务仿真结果 Tab. 2 Results of multi-mission simulation |

由仿真结果可知,各任务横向飞行轨迹较为平滑,纵向轨迹均在H-V走廊之上,倾侧角符号的变化次数在4~10次之间,各模块之间的相互配合能够实现指定时间的再入飞行过程.

4.3 蒙特卡洛仿真本文通过蒙特卡罗仿真进一步验证制导律的鲁棒性与稳定性.仿真对象为任务1,参数拉偏见表 3,拉偏方式均为正态分布.随机选择3个可行时间并分别进行500次对比仿真,结果见表 4,其中“传统方法”代指文献[5].以期望时间为1 891 s为例,飞行轨迹分布如图 12、13所示,飞行时间误差分布直方图如图 14所示.

| 表 3 蒙特卡洛参数拉偏表 Tab. 3 Monte Carlo parameters deviation |

| 表 4 蒙特卡洛仿真结果对比 Tab. 4 Comparison of Monte Carlo simulation results |

|

图 12 纵向轨迹分布 Fig. 12 Longitudinal trajectory distribution |

|

图 13 横向轨迹分布 Fig. 13 Horizontal trajectory distribution |

|

图 14 飞行时间误差直方图 Fig. 14 Histogram of flight time error |

由图 12、13可知,在各类不确定性参数的干扰下,高超声速飞行器能够到达指定的终端状态并且全程没有违反过程约束条件.表 4说明在不同期望时间作用下,本文方法相对于传统方法而言,其具有较强的时间调节能力和控制能力.除此之外,其制导精度和终端高度管理能力也优于传统方法.图 14表明最终飞行时间误差总体上呈正态分布趋势,并且在各类不确定性干扰下依然能够保证最终飞行时间误差在±10 s以内,满足指定时间再入飞行的任务需求[3],具有较强的稳定性与鲁棒性.

5 结论1) 本文针对高超声速飞行器的再入飞行时间可控性要求,提出基于DQN的时间可控再入制导律.

2) 由于再入飞行的横纵向解耦特性,飞行时间主要与倾侧角的符号规划——即横向制导律设计有关.但由于再入过程较为复杂,无法使用常规方法进行问题建模与分析,所以引入DQN进行制导律设计;同时针对网络训练过程中的收敛速度过慢与不稳定问题,设计了一套阶段性迭代训练方法.

3) 基于DQN的时间可控再入制导律在线根据飞行状态进行倾侧角符号规划以调节再入时间,仿真验证了其具有良好的任务适应性、时间可控性、稳定性和鲁棒性.

| [1] |

黄志澄. 高超声速武器及其未来战争的影响[J]. 战术导弹技术, 2018(3): 1. HUANG Zhideng. Hypersonic weapons and its influence on future war[J]. Tactical Missile Technology, 2018(3): 1. DOI:10.16358/j.issn.1009-1300.2018.8.501 |

| [2] |

王少平, 董受全, 李晓阳, 等. 助推滑翔高超声速反舰导弹多方向协同突防可行性研究[J]. 指挥控制与仿真, 2019, 39(2): 55. WANG Shaoping, DONG Shouquan, LI Xiaoyang, et al. Feasibility study of multi-direction coordinated penetration of the boost-glide hypersonic anti-ship missile[J]. Command Control and Simulation, 2019, 39(2): 55. DOI:10.3969/j.issn.1673-3819.2017.02.012 |

| [3] |

方科, 张庆振, 倪昆, 等. 高超声速飞行器时间协同再入制导[J]. 航空学报, 2018, 39(5): 202. FANG Ke, ZHANG Qingzhen, NI Kun, et al. Time-coordination reentry guidance law for hypersonic vehicle[J]. Acta Aeronautica et Astronautica Sinica, 2018, 39(5): 202. DOI:10.7527/S1000-6893.2018.21958 |

| [4] |

SHEN Zuojun, LU Ping. Onboard generation of three-dimensional constrained entry trajectory[J]. Journal of Guidance, Control & Dynamics, 2003, 26(1): 111. DOI:10.2514/2.5021 |

| [5] |

LU Ping. Entry guidance: A unified method[J]. Journal of Guidance Control & Dynamics, 2014, 37(3): 713. DOI:10.2514/1.62605 |

| [6] |

CHENG Lin, WANG Zhenbo, CHENG Yang, et al. Multi constrained predictor-corrector reentry guidance for hypersonic vehicles[J]. Proceedings of the Institution of Mechanical Engineers, Part G: Journal of Aerospace Engineering, 2017, 232(16): 0954410017724185. DOI:10.1177/0954410017724185 |

| [7] |

JEON I S, LEE J I, TAHK M J. Impact-time-control guidance law for anti-ship missiles[J]. IEEE Transactions on Control Systems Technology, 2006, 14(2): 26. DOI:10.1109/tcst.2005.863655 |

| [8] |

周锐, 陈宗基. 强化学习在导弹制导中的应用[J]. 控制理论与应用, 2001, 18(5): 748. ZHOU Rui, CHEN Zongji. Application of reinforcement learning in missile guidance[J]. Control Theory and Applications, 2001, 18(5): 748. DOI:10.3969/j.issn.1000-8152.2001.05.023 |

| [9] |

JIANG X, FURFARO R, LI S. Integrated guidance for Mars entry and powered descent using reinforcement learning and Gauss pseudospectral method[EB/OL]. (2018-5-23). https://www.researchgate.net/publication/324982576_Integrated_Guidance_for_Mars_Entry_and_Powered_Descent_Using_Reinforcement_Learning_and_Gauss_Pseudospectral_Method

|

| [10] |

王光伦.高超声速飞行器再入段预测校正制导研究[D].哈尔滨: 哈尔滨工业大学, 2010 WANG Guanglun. Predictor-corrector reentry guidance for hypersonic vehicles[D]. Harbin: Harbin Institute of Technology, 2010 http://cdmd.cnki.com.cn/article/cdmd-10213-1011260109.htm |

| [11] |

SUTTON R S, BARTO A G. Reinforcement learning: An introduction[M]. Cambridge, MA: MIT Press, 2005.

|

| [12] |

SEIJEN H V, FATEMI M, ROMOFF J, et al. Hybrid reward architecture for reinforcement learning[EB/OL]. (2017-06-13)[2017-11-28]. http://cn.arxiv.org/abs/1706.04208

|

| [13] |

MNIH V, KAVUKCUOGLU K, SILVER D, et al. Playing atari with deep reinforcement learning[EB/OL]. (2013-12-19). https://arxiv.org/abs/1312.5602

|

| [14] |

CASTANO A P. Practical artificial intelligence[M]. Berkeley, CA: Apress, 2018.

|

| [15] |

PHILLIPS T H. A common aero vehicle (CAV) model, description, and employment guide[R]. Albuqerque: New Mexico Schafer Corp-oration for AFRL and AFSPC, 2003

|

2019, Vol. 51

2019, Vol. 51