2. 新型显示技术及应用集成教育部重点实验室(上海大学),上海 200072

2. Key Laboratory of Advanced Display and System Application (Shanghai University), Ministry of Education, Shanghai 200072, China

异常行为的研究关乎人身财产安全,视频监控系统已成为预防犯罪行为和识别安全威胁的流行方式.但是目前用人力来分析海量视频信息非常昂贵和低效,因此需要自动检测和定位可疑异常行为并及时预警.由于人类行为的模糊性和歧义性,异常行为的精准识别具有一定的挑战性.

早期的工作主要提取运动区域的手工特征如光流OF[1]、方向梯度直方图HOG[2]、运动历史图MHI[3]等来对视频进行编码.Hyukmin等[4]通过融合MHI与HOG来对人体行为进行建模与识别.Shiyang等[5]通过光流提取前景目标上的稀疏粒子轨迹来计算运动不稳定性,以实现异常行为识别.光流场与运动历史图在运动识别领域作为常用特征,在受约束场景下取得了较好效果,但在复杂场景下,上述方法均容易受到图像噪声、光照变化和背景抖动影响.与提取浅层手工特征相反,大量研究致力于从海量标记视频数据中自动学习深层特征[6].Christoph等[7]结合RGB图像光流场来训练双流2D-CNN网络,达到了较好的行为识别性能.但是2D-CNN容易丢失连续帧间时域运动信息的相关性,而这通常是行为识别的关键特征.杨天明等[8]提出基于3D-CNN的时-空双流网络来进行动作识别.但是3D-CNN只能对短时序间的运动结构进行建模.AMIN等[9]提出了基于2D-CNN与DB-LSTM的卷积循环神经网络,可以对长时序间的运动结构进行建模.考虑到人体运动行为之间具有很强的时间依赖性,需要同时对短时序与长时序间的运动区域进行建模.此外,公开的训练数据集如UMN[10]、CAVIAR[11]、Web[12]中正常行为视频片段数量远多于异常行为,使得模型容易陷入过拟合,很难从有限失衡样本中学习到其行为模式.

综上,视频异常行为识别的主要挑战有3点:1)如何在光照变化、背景运动等复杂场景下压制背景干扰,提取出丰富的前景信息用于视频分析.2)如何提取多帧间的时-空域结构信息并保留上下文间的时-空相关性用于视频理解.3)如何通过有限且失衡的训练样本来训练神经网络.针对上述问题,本文提出了基于3D-LCRN网络的视频异常行为识别方法.该方法先建立包含光照感应与补偿机制的结构相似性背景模型,用于矫正光流场与运动历史图.接着,融合多模态特征获得矫正光流运动历史图COFMHI,并通过聚类扩充样本.在此基础上,结合3D-CNN、贡献因子加权的LSTM网络,提取COFMHI片段的多尺度时-空域特征用于异常行为判别.

1 光流运动历史图 1.1 结构相似性背景建模光照突变、背景运动都会产生光流场与运动历史图,这些运动信息对异常行为的识别造成了一定的干扰.为了解决上述问题,本文提出了结构相似性背景建模方法来提取前景,在此基础上矫正光流场与运动历史图,以对抗运动背景和光照突变的干扰.

结构相似性[13]可以在一定程度上反映两张图像的纹理差异.即使背景是动态的,诸如树叶抖动、水纹波动、电梯运动也不会给背景造成较大的结构性改变,即帧间结构相似性基本保持不变.而当前景目标运动或光照突变时,帧间结构相似性会降低.基于背景图像具有结构相似性,背景更新模型定义为Bt(x, y)=(1-St(lt-1(x, y), lt(x, y))·α)Bt-1(x, y)+St(lt-1(x, y), lt(x, y))·α·It(x, y).

式中:α为学习因子,设置为经验值0.01,It(x, y)为t时刻输入图像在像素(x, y)处的像素值,St是表征帧间结构突变程度的抑制因子,定义为

| $ \begin{array}{l}{S_{t}\left(l_{t-1}(x, y), l_{t}(x, y)\right)=\left(\frac{2 \mu_{1} \mu_{2}+c_{1}}{\mu_{1}^{2}+\mu_{2}^{2}+c_{1}} \cdot \frac{2 \sigma_{1, 2}+c_{2}}{\sigma_{1}^{2}+\sigma_{2}^{2}+c_{2}}\right)^{2}}, \\ {S_{t}\left(l_{t-1}(x, y), l_{t}(x, y)\right) \in[0, 1]}.\end{array} $ |

式中:lt-1(x, y)为背景图像Bt-1在点(x, y)处的亮度,lt(x, y)为输入图像It在点(x, y)处的亮度,μ1和μ2分别是lt-1(x, y)和lt(x, y)的局部均值,σ1和σ2分别是lt-1(x, y)和lt(x, y)的局部方差,σ1, 2是lt-1(x, y)和lt(x, y)之间的协方差(上述参数可通过与3×3大小的高斯滤波器卷积获得),c1和c2是常数,分别设为6.5和58.5.

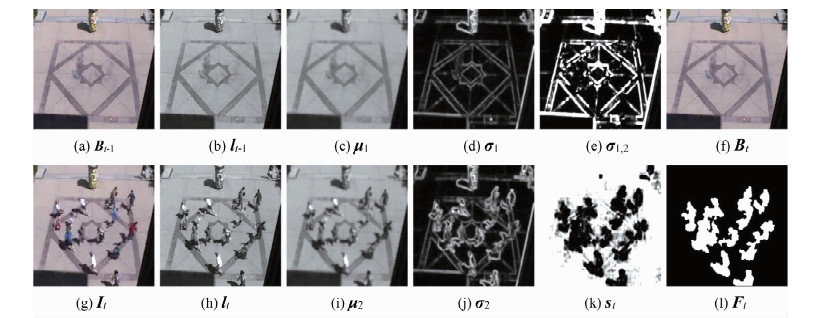

部分实验结果如图 1所示.其中,图 1(a)~(f)依次为Bt-1、lt-1、μ1、σ1、σ1, 2与Bt;图 1(g)~(l)依次为It、lt、μ2、σ2、St与最终分割得到的前景目标Ft.

|

图 1 结构相似性建模中间结果展示 Fig. 1 Experimental results during structural similarity modeling |

为了使模型能尽快地感知场景光线变化,以便做出相应的光照补偿,需加入光照突变感应机制.当光照改变时,背景结构会发生变化,结构相似性会降低.因此,使用最小结构相似性映射的均值μs来反应环境亮度的变化,定义为

| $\begin{array}{l}{\mu_{\mathrm{s}}=\frac{1}{m n} \sum\limits_{x=0}^{m-1} \sum\limits_{y=0}^{n-1} \min \left(S_{t-1}\left(l_{t-2}(x, y), l_{t-1}(x, \right.\right.} \\ {\left.y)), S_{t}\left(l_{t-1}(x, y), l_{t}(x, y)\right)\right)}.\end{array} $ |

式中:m、n分别为图像的长和宽.

图像亮度变化越大,μs越小.为了降低光照突变对前景分割产生的干扰,当环境光照突变时,即当满足式(1)时,可依据式(2)更新背景Bt:

| $ \mu_{s}<T_{u}, $ | (1) |

| $ B_{t}=\left\{\begin{array}{l}{B_{\text {bright }}, \text { if }\left|u_{\mathrm{b}}-u_{\mathrm{t}}\right|<\left|u_{\mathrm{d}}-u_{\mathrm{t}}\right|}; \\ {B_{\text {dark }}, \text { otherwise. }}\end{array}\right. $ | (2) |

式中:Tu是背景变化阈值,实验中设为0.1[14],Bbright为明候选背景,Bdark为暗候选背景,μt为当前帧It亮度均值,μb为明背景亮度均值,μd为暗背景亮度均值.

若相邻两帧结构相似性的差异性Δlt在光照突变后达到了历史最小值,则需更新Bbright与Bdark:

| $ \begin{array}{l}{\Delta l_{\mathrm{t}}=\sum\limits_{x=0}^{m-1} \sum\limits_{y=0}^{n-1} \frac{\left|l_{\mathrm{t}-1}(x, y)-l_{\mathrm{t}}(x, y)\right|}{S_{\mathrm{t}}\left(l_{\mathrm{t}-1}(x, y), l_{\mathrm{t}}(x, y)\right)+1}}, \\ {\left\{\begin{array}{l}{B_{\mathrm{bright}}=I_{\mathrm{t}}, u_{\mathrm{b}}<u_{\mathrm{t}} ;} \\ {B_{\mathrm{datk}}=I_{\mathrm{t}}, u_{\mathrm{d}}>u_{\mathrm{t}}}.\end{array}\right.}\end{array} $ |

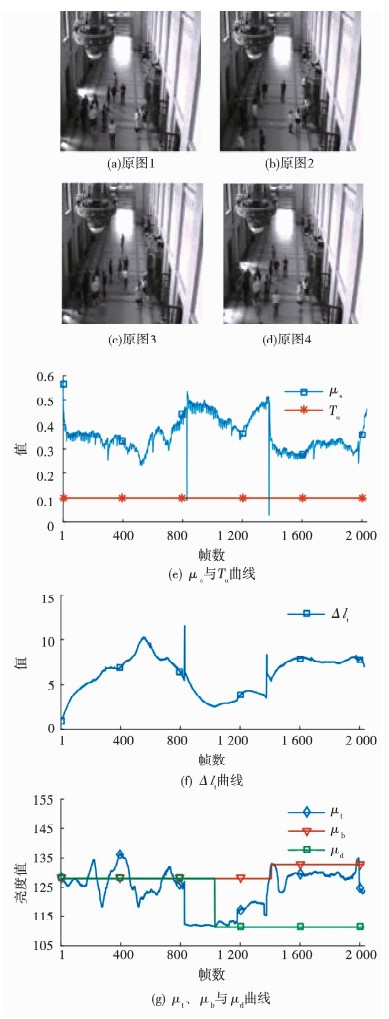

部分实验结果如图 2所示.其中,(a)~(d)分别为第500、821、1 193与1 400帧输入图像,(e)为μs、Tu曲线,(f)为Δlt曲线,(g)为μt、μb、μd曲线.可以看出,当场景光线变化时,μs降低,Δlt升高.模型感知到了光线变化,调整μt、μb与μd的大小,做出相应的光照补偿.

|

图 2 光照突变感应与补偿 Fig. 2 illumination sensing and compensation |

根据模型计算得到的背景图像,对视频帧和背景图像进行差分和形态学滤波[15],提取出前景目标

| $ F_{\mathrm{t}}=D\left(F\left(I_{\mathrm{t}}-B_{\mathrm{t}}\right)\right), $ |

式中:D(.)为图像的膨胀运算,F(.)为图像的腐蚀运算.

部分实验结果如下图.其中,图 3(a)~(d)为视频原图,图 3(e)~(h)为背景图像,图 3(i)~(l)为前景图像.

|

图 3 结构相似性建模得到的背景与前景图像 Fig. 3 Background and foreground images obtained from structural similarity modeling |

1) 光流运动历史图

经上述结构相似性背景建模后,为进一步压制光照变化和背景抖动影响,分别进行运动历史图MHI和光流场OF矫正:

| $ H_{\mathrm{t}}(x, y)=\left\{\begin{array}{l}{\tau, \text { if } F_{\mathrm{t}}(x, y) \neq 0}; \\ {\max \left(0, H_{\mathrm{t}}(x, y)-\delta\right), \text { otherwise. }}\end{array}\right. $ |

| $ d_{\mathrm{t}}(x, y)=\left\{\begin{array}{l}{\left(\sum\limits_{N} w A^{\mathrm{T}} A\right) \sum\limits_{N} w A^{\mathrm{T}} \Delta B, \text { if } F_{t}(x, y) \neq 0}; \\ {0, \text { otherwise. }}\end{array}\right. $ |

式中:Ht(x, y)为第t帧像素(x, y)处矫正后的运动历史图,Ft(x, y)为第t帧前景图像(x, y)处的像素值,τ为持续时间,δ为衰退参数(实验中分别设为50,1),dt(x, y)为像素(x, y)处的矫正光流场,w是像素(x, y)的邻域N的权重函数[16],A与ΔB为扩展系数[16].

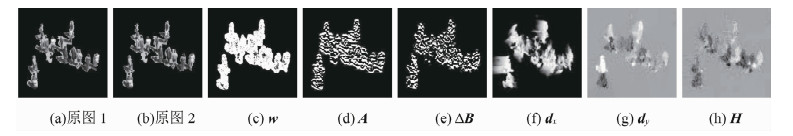

部分实验结果如图 4所示.其中,图 2(a)~(b)分别为前、后帧输入灰度图像(以前景图像F为掩码得到);图 2(c)~(e)分别为权重函数w、扩展系数A、扩展系数ΔB;图 2(f)~(h)分别为矫正光流场d在x方向的分量、矫正光流场d在y方向的分量与矫正运动历史图H.

|

图 4 光流场与运动历史图矫正过程 Fig. 4 The correction of OF and MHI |

在获取上述矫正运动历史图CMHI和矫正光流场COF的基础上,将COF分解为水平方向光流图COFx与垂直方向光流图COFy,并对上述图像分别进行归一化后将CMHI作为图像的R通道,COFx作为图像的G通道,COFy作为图像的B通道.对三通道进行堆叠形成矫正光流运动历史图COFMHI.

部分实验结果如图 5所示.其中,图 5(a)、(f)、(k)为视频原图,图 5(b)、(g)、(l)为CMHI,图 5(c)、(h)、(m)为COFx,图 5(d)、(i)、(n)为COFy,图 5(e)、(j)、(o)为COFMHI.

|

图 5 矫正光流运动历史图 Fig. 5 Corrected optical flow motion history image |

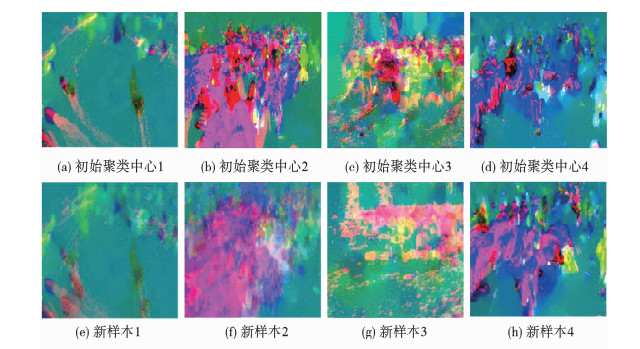

2) 样本扩充

由于实际视频监控中正常行为数量往往远超出异常行为,因此,为后续的基于深度学习方法进行视频异常行为识别,需进行相应的异常行为样本扩充.具体方法与策略如下:对异常视频片段计算COFMHI,将连续的COFMHI,称为剪辑的片段,片段间隔设置为T.从每个剪辑片段Ti中随机提取N个n×n×3×T大小的区域,称为视觉词块.对所有剪辑片段进行处理后,在剔除平均像素值较小的视觉词块的基础上,采用K-means聚类[17]形成K个聚类中心,获取聚类中心的视觉词块.对聚类获得的K个n×n×3×T大小的扩充块进行尺度变换,转换成224×224×3×T大小的视觉词块.扩充后,将得到K×T帧224×224×3大小的COFMHI(计算COFMHI和提取扩充样本的过程如图 6所示).

|

图 6 矫正光流运动历史图样本扩充 Fig. 6 Sample expansion of the corrected optical flow motion history images |

本文选取欧几里得距离d(i, j)来度量样本间的相似性,误差平方和SE作为聚类的目标函数:

| $ \begin{aligned} d(i, j)=& \sqrt{\sum\limits_{x=1}^{n} \sum\limits_{y=1}^{n} \sum\limits_{i=1}^{T} \sum\limits_{R C B}\left(S_{i}-K_{j}\right)^{2}} , \\ S_{E} &=\sum\limits_{j=1}^{K} \sum\limits_{S_{i} \in K_{j}} d(i, j)^{2} , \end{aligned} $ |

式中:Si为第i个聚类样本,Kj为第j个聚类中心.

实验中,T为16,N为20,K=[FN/(3T)],n=

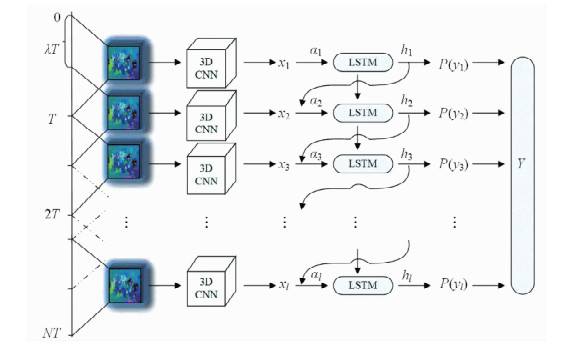

人体行为通常由一系列的子行为组成,子行为间有强烈的时间相关性.例如打架斗殴包含挥动手臂、奔跑等子行为.连续帧间的运动关联性比单帧图像更能区分行为.因而,本文采用3D-CNN对短时序视频片段的运动信息进行建模,捕获局部时-空域特征.此外,先前发生的行为在一定程度上会影响后续行为,例如跌倒后一般都会平躺然后弯腰起身.因而,本文采用LSTM桥接短时序时-空域特征,进行长时序深层次全局时-空域特征提取.

正常行为或异常行为中的某些片段是无关、冗余或具有混淆性的,例如空白的街道,上下运动的电梯与飞驰而过的车辆等.这些视频片段的主要内容从行人本身转移到了一些无关的运动物体上,会对网络训练造成一定的干扰.因此,本文提出了可学习的贡献因子αt,使得每个视频片段的重要性有所不同.αt由t时刻3D-CNN输出xt与t-1时刻LSTM输出ht-1计算所得

| $ \alpha_{\mathrm{t}}=\exp \left(\tan h \left(w_{x \alpha} x_{\mathrm{t}}+w_{\mathrm{h} \alpha} h_{\mathrm{t}-1}+b_{\alpha}\right)\right). $ |

式中:wxα、whα为线性变换的权重,bα为偏置.

t时刻LSTM输入x′t由特征xt和贡献因子αt加权所得

| $ x_{\mathrm{t}}^{\prime}=\alpha_{\mathrm{t}} x_{\mathrm{t}}. $ |

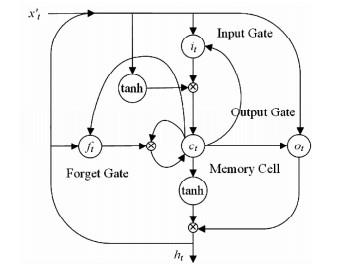

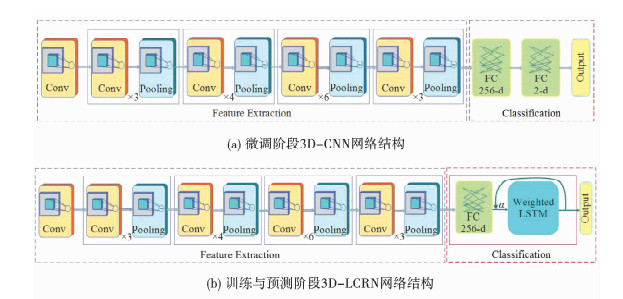

在此基础上,本文构造了结合长-短时序的多层次网络模型3D-LCRN,以正确地对行为间的时间结构进行建模,如图 7所示.3D-CNN模块基于ResNets[18],用于捕获连续动作帧间的局部短时序时-空结构信息.本文剥离了ResNets最后的全连接层,增加了256-d、2-d两层全连接层,用于微调3D-CNN网络以适应后续建模.贡献因子αt加权的特征x′t与长短时记忆网络LSTM相连,用于调整不同时刻时-空域信息的重要性.3D-LCRN结合LSTM的门控制记忆细胞(如图 8所示)来存储过去态,当前态依据当前输入、输出和存储在该记忆细胞中的过去态进行更新,见式(3)~(7).最后,基于LSTM输出计算每个时刻的类别概率分布P(yt), 通过对重叠片段的所有预测结果求平均值来获得每帧图像的所属类别,以实现正常与异常行为识别,见式(8)、(9).3D-LCRN的结构特性,使其能够在长时序间桥接重要信息,保留记忆,实现由短时序-长时序,由局部-全局的多层次时-空域特征提取.

| $ i_{t}=\sigma\left(w_{x i} x^{\prime}_{t}+w_{h i} h_{t-1}+w_{c i} c_{t-1}+b_{i}\right), $ | (3) |

| $ f_{t}=\sigma\left(w_{x f} x^{\prime}, +w_{h f} h_{t-1}+w_{c f} c_{t-1}+b_{f}\right), $ | (4) |

| $ o_{t}=\sigma\left(w_{x o} x_{t}^{\prime}+w_{h o} h_{t-1}+w_{c o} c_{t}+b_{o}\right), $ | (5) |

| $ c_{t}=f_{t} c_{t-1}+i_{t} \tan h \left(w_{x c} x_{t}^{\prime}+w_{h c} h_{t-1}+b_{c}\right), $ | (6) |

| $ h_{t}=o_{t} \tan h \left(c_{t}\right). $ | (7) |

|

图 7 3D-LCRN网络结构 Fig. 7 The structure of the 3D Long-short-term Convolutional Recurrent Network |

|

图 8 LSTM记忆细胞结构 Fig. 8 The structure of the long short-term memory cell |

式中:σ为sigmoid激活函数,wx*、wh*、wc*是线性变换的权重,b*是偏置,it为输入门,ft为忘记门,ot为输出门,ct为记忆细胞的状态,ht为LSTM输出.

| $ P\left(y_{t}=z\right)=\frac{\exp \left(w_{h z} h_{t, z}+b_{z}\right)}{\sum\limits_{z^{\prime} \in Z} \exp \left(w_{h z} h_{t, z^{\prime}}+b_{z}\right)}, $ | (8) |

| $ y_{f}=\max \left(\frac{\sum\limits_{t \in f} P\left(y_{t}\right)}{\sum\limits_{t \in f}}\right). $ | (9) |

式中:P(yt=z)是模型预测t时刻输入视频片段属于类别z的概率,yf为第f帧图像所属类别,whz为权重,bz为偏置.

2.2 3D - LCRN网络训练3D-LCRN网络训练包含两个阶段,即3D-CNN训练和贡献因子αt加权的LSTM训练.3D-CNN模块基于UMN、CAVIAR与Web数据集对在UCF101[19]与HMDB51[20]数据集上预训练好的模型[21]进行微调,结构如图 9(a)所示.模型输入为连续的16帧COFMHI,大小为3×16×224×224.输出2-d向量,表示正常或异常行为.微调后的模型剥离最后的2-d全连接层,抽取出256-d的特征向量.

|

图 9 微调、训练与预测阶段3D-CNN与3D-LCRN网络结构 Fig. 9 The structure of 3D-CNN and 3D-LCRN during the fine tuning, training and predict stage |

LSTM模块初始输入为多个256-d特征向量的平均值,这些特征向量由随机抽取的一段正常视频通过预训练好的3D-CNN获得.基于该初始化,可以计算第1时刻的贡献因子α1.在后续的每个时刻,LSTM将依据上一时刻的输出计算新的贡献因子.本文将训练样本通过3D-CNN提取的特征加权后作为输入馈送到LSTM中训练整个3D-LCRN网络,如图 9(b)所示.训练时,通过输出类别与真实类别计算出的误差反向传播来对贡献因子与LSTM权重进行训练,而3D-CNN的权重保持不变.图 4中,3D-LCRN网络滑动步长为λT,时间步长为l.实验中,λ与l分别设为0.25与40[22],T为16.学习率为0.003,在每150 000次迭代后减半.对于所有非循环连接,dropout设为0.5[23].

3 实验结果与分析基于上述方法,本文选用多个公开数据集进行实验验证,包括UMN、CAVIAR与Web.UMN包含不同场景(草坪、室内和广场)中拍摄的11段视频,图像大小为320×240像素.每段视频都包含正常部分,几十人随机地四处走动,然后发生异常事件,人们惊慌地逃离.CAVIAR包含人们独自散步、与他人见面、逛街、进出商店、打架和昏迷,图像大小为384×288像素.Web数据集由8个具有异常行为(恐慌逃逸、抗议者冲突和人群斗殴)的序列和12个具有正常行为(步行、马拉松跑步)的序列组成,图像大小不等.UMN与CAVIAR场景相对简单,部分视频含有局部或全局的光照变化.Web数据集主要包含针对城市场景的纪录片和视频,通常包含复杂的背景,对识别系统具有挑战性[24].

本文实验软件运行环境为Windows 7 64位,平台为Python3.6+Opencv3.3.1开源视觉库+Tensorflow1.8.0开源机器学习框架,硬件配置为Intel® CoreTMi5-4440 3.10GHz CPU,8G RAM内存.

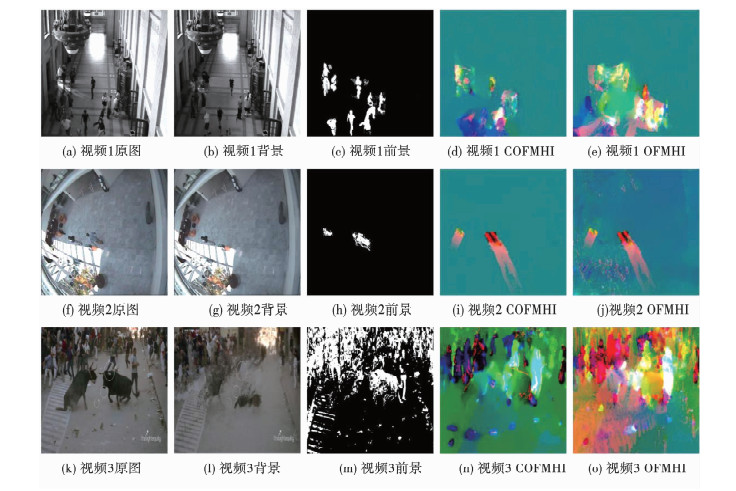

3.1 异常行为识别图 10为OFMHI与COFMHI部分实验结果对比.其中,图 10(a)、(f)、(k)为视频原图,分别选自UMN、CAVIAR与Web数据集;图 10(b)、(g)、(l)为背景图像;图 10(c)、(h)、(m)为前景图像;图 10(d)、(i)、(n)为COFMHI;图 10(e)、(j)、(o)为OFMHI.

|

图 10 COFMHI与OFMHI对比实验 Fig. 10 Comparisons between corrected optical flow motion history image and optical flow motion history image |

从图 10中可以看出,OFMHI包含大量由光照、抖动引起的背景干扰(透明绿色、红色);而本文所提前景图像压制了背景抖动,对光照变化不敏感,矫正所得COFMHI几乎无背景干扰.实验证明,本文所提COFMHI在复杂场景下仍具有较好的鲁棒性,能够有效压制背景干扰.

样本扩充时的聚类参数如表 1所示.其中,误差平方和为聚类完成后得到的结果.由于Web数据集计算得到的COFMHI图像尺寸不一,本文统一归一化为224×224×3像素.聚类范围为去除平均像素值小于0.2的候选样本后总样本数量.

| 表 1 K-means聚类参数 Tab. 1 Parameters of K-means clustering |

部分实验结果如图 11所示.由于每个聚类中心为4D视觉词块,这里选取T=1通道进行展示.其中,图 11(a)~(d)为初始聚类中心,图 11(e)~(h)为最终得到的聚类中心,即扩充后的新样本.可以看出,扩充后的新样本与原始样本不同,但是具有一定的相似性.

|

图 11 初始聚类中心与产生的新样本 Fig. 11 Initial centers and new samples |

经过聚类扩充后,本文得到了132个聚类中心,即2112帧新COFMHI图像.接着把原始样本与扩充产生的新样本一起送入3D-CNN进行网络微调,最后送入3D-LCRN网络进行分类训练,以实现异常行为识别.部分实验结果见图 12与图 13所示.

|

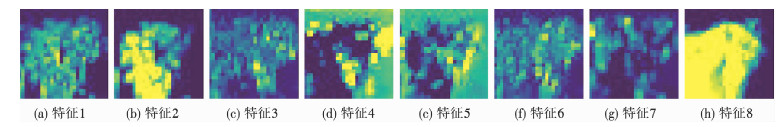

图 12 3D-CNN提取的时-空域特征 Fig. 12 Spatial-temporal feature maps extracted from 3D-CNN |

|

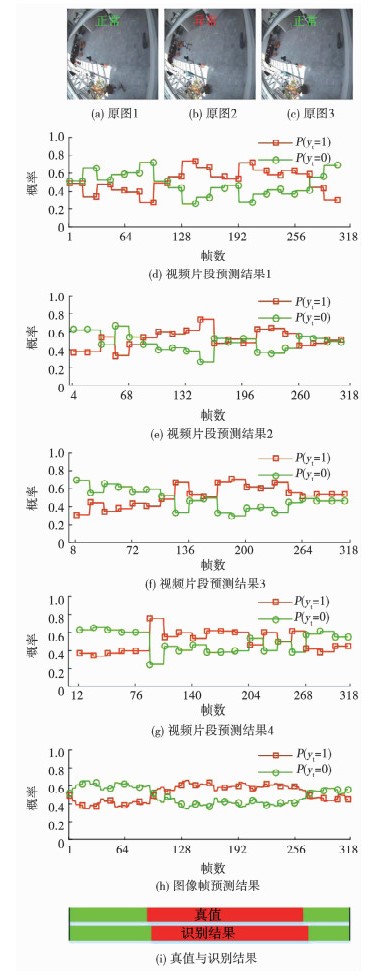

图 13 LSTM预测概率分布 Fig. 13 Probability distribution predicted by LSTM |

图 12为微调后3D-CNN第2层卷积层输出的部分时-空域特征.该层共有64个特征,每个特征为56×56×8像素的3D特征块.其中,图 12(a)~(h)为8个特征块的第一通道.

图 13为LSTM预测所得类别概率分布.其中,图 13(a)~(c)分别为第20、175与296帧输入图像,选自CAVIAR数据集;图 13(d)~(g)为视频片段预测结果,P(yt=1)为t时刻当前片段属于异常行为的概率,P(yt=0)为t时刻当前片段属于正常行为的概率;(h)为图像帧预测结果,P(yf=1)为第f帧属于异常行为的概率,P(yf=0)为第f帧属于正常行为的概率;(i)为真值与识别结果对比.从图中可以看出,本文所提3D-LCRN网络有效、可行,异常行为识别结果准确、稳定.

3.2 客观定量评价对比为进一步评价本文所提COFMHI的有效性,分别将光流图(矫正前后)、运动历史图(矫正前后)、光流运动历史图(矫正前后)与3D-LCRN网络结合,基于3个公开数据集进行5折交叉验证对比实验.实验使用6种不同的图像数据来训练6个3D-LCRN网络,结果如表 2所示.其中,每一列的平均值与标准差由该列的3个数据计算得到.由表 2可知,光流图与运动历史图相结合后识别效果提升,与光流图相比提高了0.7%,与运动历史图相比提高了2.4%.究其原因为光流场包含了运动目标的瞬态运动信息与表观结构,运动历史图包含了运动目标的轮廓轨迹和运动能量的空间分布,两相结合可以在一定程度上丰富时-空域特征的表现形式.并且,三类图像经过本文所提方法进行矫正后识别效果均有提升,COFMHI较OFMHI识别效果提高了2.0%.究其原因为本文所提方法能够在一定程度上对抗光照变化与背景抖动,压制了场景中部分背景干扰.实验表明,本文方法有效可行.

| 表 2 基于不同预处理图像的异常行为识别性能对比 Tab. 2 Performance comparisons for different preprocessed images |

为定量评价本文所提贡献因子的有效性,将COFMHI分别与有、无贡献因子的3D-LCRN结合,在3个公开数据集上进行5折交叉验证,实验结果如表 3所示.其中,每一行的平均值与标准差由该行的三个数据计算得到.由表 3可知,含有贡献因子的3D-LCRN模型识别精度较高,较不含贡献因子的3D-LCRN相比提高了1.9%.究其原因为本文所提贡献因子能让每个输入视频片段的重要性有所不同,通过自适应学习能够在一定程度上压制冗余、混淆或无关视频片段,提高异常行为识别精度.

| 表 3 有无贡献因子α的3D-LCRN识别性能对比 Tab. 3 Performance comparisons for 3D-LCRN with and without α |

为客观定量评价本文方法的有效性,选取方法[5][8-9]基于3个公开数据集进行5折交叉验证,实验结果如表 4所示.其中,每一行的平均值与标准差由该行的三个数据计算得到.由表 4可知,本文所提方法异常行为识别时性能最优.究其原因在于,文献[5]基于轨迹计算运动不稳定性来判别异常行为.在复杂场景下,行人间存在大量交叉遮挡,该方法难以跟踪并提取目标的完整运动轨迹,因而异常行为识别精度不高.文献[8]基于输入为原始图片与光流图片的双流卷积神经网络来进行行为识别.但是光流和3D-CNN提取的都是短时序特征,针对长视频,上下文间的相关性容易流失,并且在复杂场景下无法压制光线变化与背景运动等干扰,因而在简单场景下识别效果较优,但是在复杂场景下性能不如本文所提方法.文献[9]通过2D-CNN提取RGB图像特征,送入双向LSTM网络进行深层特征提取,从而识别行为.由于2D-CNN容易丢失连续视频帧间运动信息的时间相关性,并且视频片段具有一定的冗余与混淆性,因而识别精度不高.实验表明,本文方法具有优异的异常行为识别性能.

| 表 4 不同异常行为识别方法性能对比 Tab. 4 Performance comparisons among the proposal and others |

提出了一种基于3D-LCRN的异常行为识别方法.1)通过结构相似性背景模型获取复杂场景下能够压制光照突变与背景运动的矫正光流场与矫正运动历史图.2)提出样本维度与数量双向聚类扩充方法有效丰富了COFMHI样本的时-空域信息,在一定程度上克服了样本有限且失衡的问题.3)提出结合可学习贡献因子的3D-LCRN网络对COFMHI进行分类识别,能够压制冗余,提取局部-全局、短时序-长时序的多层次时-空域特征,进一步提高了异常行为识别精度.该方法在UMN、CAVIAR与Web公开数据集上平均识别准确率达到94.1%,与现有的行为识别方法相比,本文方法能够在光照变化、背景抖动等复杂场景下保留视频上下文间的时-空相关性,准确、有效识别异常行为,具有优异的识别性能与一定的实用价值.

| [1] |

BROX T, BRUHN A, PAPENBERG N, et al. High accuracy optical flow estimation based on a theory for warping[C]//Proc 8th European Conference on Computer Vision. Prague: Springer, 2004: 25

|

| [2] |

DALAL N, TRIGGS B. Histograms of oriented gradients for human detection[C]//2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Diego, CA: IEEE Press, 2005: 886

|

| [3] |

MURTAZA F, YOUSAF M H, VELASTIN S A. Multi-view human action recognition using 2D motion templates based on MHIs and their HOG description[J]. IET Computer Vision, 2017, 10(7): 758. DOI:10.1049/iet-cvi.2015.0416 |

| [4] |

EUM H, YOON C, LEE H, et al. Continuous human action recognition using Depth-MHI-HOG and a spotter model[J]. Sensors, 2015, 15(3): 5197. DOI:10.3390/s150305197 |

| [5] |

XIE Shiyang, GUAN Yepeng. Motion instability based unsupervised online abnormal behaviors detection[J]. Multimedia Tools & Applications, 2016, 75(12): 7423. DOI:10.1007/s11042-015-2664-8 |

| [6] |

IJJINA E P, CHALAVADI K M. Human action recognition using genetic algorithms and convolutional neural networks[J]. Pattern Recognition, 2016, 59(11): 199. DOI:10.1016/j.patcog.2016.01.012 |

| [7] |

FEICHTENHOFER C, PINZ A, ZISSERMAN A. Convolutional two-stream network fusion for video action recognition[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV: IEEE Press, 2016: 1933

|

| [8] |

杨天明, 陈志, 岳文静. 基于视频深度学习的时空双流人物动作识别模型[J]. 计算机应用, 2018, 38(3): 895. YANG Tianming, CHEN Zhi, YUE Wenjing. Spatio-temporal two-stream human action recognition model based on video deep learning[J]. Journal of Computer Applications, 2018, 38(3): 895. DOI:10.11772/j.issn.1001-9081.2017071740 |

| [9] |

ULLAH A, AHMAD J, MUHAMMAD K, et al. Action Recognition in video sequences using deep bi-directional LSTM With CNN features[J]. IEEE Access, 2018, 6(99): 1155. DOI:10.1109/ACCESS.2017.2778011 |

| [10] |

UMN: Unusual crowd activity dataset of University of Minnesota[DB/OL]. 2006. http://mha.cs.umn.edu/Movies/CrowdActivity-All.avi

|

| [11] |

Caviar: EC funded caviar project[DB/OL]. 2004. http://homepages.inf.ed.ac.uk/rbf/CAVIAR/

|

| [12] |

The Web Datasets[DB/OL]. 2009. http://www.vision.eecs.ucf.edu/projects/rmehran/cvpr2009/Abnormal_Crowd.html

|

| [13] |

BRUNET D, VRSCAY E R, Wang Zhou. On the mathematical properties of the structural similarity index[J]. IEEE Transactions on Image Processing, 2012, 21(4): 1488. DOI:10.1109/TIP.2011.2173206 |

| [14] |

LUO Yong, GUAN Yepeng. Motion objects segmentation based on structural similarity background modelling[J]. IET Computer Vision, 2015, 9(4): 476. DOI:10.1049/iet-cvi.2014.0261 |

| [15] |

冯宝, 张绍荣, 陈业航, 等. 结合小波能量和汉森形状指数的肺结节分割[J]. 仪器仪表学报, 2018, 39(11): 240. FENG Bao, ZHANG Shaorong, CHEN Yehang, et al. Nodule segmentation combining wavelet energy and hessian shape index[J]. Chinese Journal of Scientific Instrument, 2018, 39(11): 240. DOI:10.19650/j.cnki.cjsi.J1803951 |

| [16] |

FARNEBACK G. Two-frame motion estimation based on polynomial expansion[C]//13th Scandinavian Conference on Image Analysis. Halmstad: Springer, 2003: 363

|

| [17] |

高国琴, 李明. 基于K-means算法的温室移动机器人导航路径识别[J]. 农业工程学报, 2014, 30(7): 25. GAO Guoqin, LI Ming. Navigating path recognition for greenhouse mobile robot based on k-means algorithm[J]. Transactions of the Chinese Society of Agricultural Engineering, 2014, 30(7): 25. DOI:10.3969/j.issn.1002-6819.2014.07.004 |

| [18] |

HARA K, KATAOKA H, SATOH Y. Can spatiotemporal 3D CNNs retrace the history of 2D CNNs and ImageNet?[C]//2018 IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City, UT: IEEE Press, 2018: 6546

|

| [19] |

SOOMRO K, ZAMIR A R, SHAH M. UCF101: A dataset of 101 human action classes from videos in the wild: CRCV-TR-12-01[R]. UCF Center for Research in Computer Vision, 2012

|

| [20] |

KUEHNE H, JHUANG H, GARROTE E, et al. HMDB: a largevideo database for human motion recognition[C]//2011 IEEE International Conference on Computer Vision. Barcelona: IEEE Press, 2011: 2556

|

| [21] |

HARA K, KATAOKA H, SATOH Y. Learning spatio-temporal features with 3D residual networks for action recognition[C]//2017 IEEE International Conference on Computer Vision. Venice: IEEE Press, 2017: 3154

|

| [22] |

Lu Na, Wu Yidan, Feng Li, et al. Deep learning for fall detection: 3D-CNN combined with LSTM on video kinematic data[J]. IEEE Journal of Biomedical and Health Informatics, 2019, 23(1): 314. DOI:10.1109/JBHI.2018.2808281 |

| [23] |

SRIVASTAVA N, HINTON G, KRIZHEYSKY A, et al. Dropout: a simple way to prevent neural networks from over-fitting[J]. Journal of Machine Learning Research, 2014, 15(1): 1929. |

| [24] |

仉长崎, 管业鹏. 基于动态粒子流场的视频异常行为自动识别[J]. 光电子·激光, 2015, 26(12): 2375. ZHANG Changqi, GUAN Yepeng. Dynamic particle flow field based automatic recognition of video abnormal behavior[J]. Journal of Optoelectronics·Laser, 2015, 26(12): 2375. DOI:10.16136/j.joel.2015.12.0563 |

2019, Vol. 51

2019, Vol. 51