2. 武汉理工大学 智能交通系统研究中心, 武汉 430063

2. Intelligent Transportation Systems (ITS) Research Center, Wuhan University of Technology, Wuhan 430063, China

精确实时的车辆定位技术在智能网联汽车、自主导航定位、城市道路交通流估计等领域有重大意义[1-2].目前最为常用的定位方法为GPS定位,但其定位精度较低,且存在信号盲区的缺点,为提高定位精度,通常采用架设差分GPS基站,使用高精度组合惯导系统提高GPS定位精度[3-4],但因成本较高无法普遍使用.近年来,计算机视觉在定位方面展现出非常好的应用前景,并系统性地发展出一些如视觉里程计(visual odometer,VO)以及视觉同时定位与制图(simultaneously localization and mapping,SLAM)等先进的视觉定位技术.例如,文献[5]利用视觉里程计重建出场景的三维结构信息,并对车辆的旋转和速度进行估计,从而确定车辆的运行轨迹,完成车辆定位.文献[6]运用先进的SLAM技术与传统的GPS、惯性导航以及雷达点云数据相结合,实现车辆的精确定位.然而,这些方法仍然存在着计算复杂度高、算法稳定性差等问题.为了解决上述问题,采用“先制图—后定位”的定位策略,提出了基于路面路标的视觉地图表征模型和多尺度融合定位,以视觉地图为基础,有效消除视觉累积误差.同时,与地图三要素相结合实现GPS级、路标级以及度量级的多尺度定位,可充分发挥道路场景的唯一性表达,提高定位精度.此外,路标级定位与其他的路标定位方法不同的是不仅从路标中提取视觉特征,还提取路标背景的视觉特征,从而增强了定位鲁棒性.

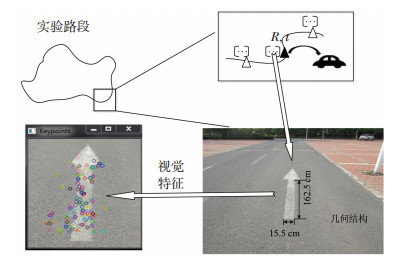

1 定位算法算法流程如图 1所示,主要包含两个基本模块,分别为基于路面路标的高精度视觉地图表征模块和基于路标视觉地图的多尺度定位模块.

|

图 1 定位算法流程图 Fig. 1 Flow chart of the localization method |

其中,高精度视觉地图构建为离线模块,通过事先采集的路面路标车载图像与高精度位置(DGPS结合RTK)等信息来创建.多尺度定位模块是在线模块,主要包含基于GPS匹配的初始定位、基于路面标志检测的路标级定位(landmark-level localization)以及度量级定位(metric localization)等.具体而言,首先根据车辆自身的GPS信息与地图中的惯导数据相匹配,得到一系列候选参照路标,然后对待查询图像进行路标检测,将检测结果与初始定位结果相匹配得到距离当前车辆最近的路标,最后结合地图中的路标几何结构计算车辆的相对位姿.需要指出的是,目前自动驾驶领域在大力推进高精度地图(high definition map,HD MAP)产业[7-8].高精度地图与普通的导航地图不同,包含了道路基础设施(如道路标线、路面路标、交通标志、护栏等)精确的位置坐标信息(精度可达10 cm).这种高精度地图可与视觉地图相结合,即利用高精度地图来提供视觉地图中路面路标的高精度GPS坐标信息[7-8].特别是,高精度地图中普遍采用众包(crowd sourcing)技术来解决了道路环境中地图数据的及时更新等问题,具有很好的实用性[9].

1.1 基于路面路标场景的高精度视觉地图表征与VO[10]或SLAM[11-12]算法不同,多尺度定位算法是在基于路面路标的高精度视觉地图基础之上实现的.高精度视觉地图构建过程中,当路面有路标存在时,一方面通过测量工具计算路标的几何结构信息,另一方面运用车载摄像机进行图像采集,同时运用GPS接收机、组合惯导系统以及DGPS基站采集该路标的高精度位置信息.因此,每个路标均配有一条高精度位置信息、一帧图像(以及从图像提取的视觉特征)及其自身的几何结构信息.

为增强道路场景的唯一性表达,进一步处理所采集到的数据,最终通过3种不同方式实现表征,图 2表示了地图三要素:1)路标视觉特征.该特征不单指路标上的特征,还包括路标所在背景路面的特征,通过ORB局部特征对其进行表征. 2)几何结构信息.该信息为路标的实际规格,通过测量工具(如测绘车)完成测量. 3)视觉特征与几何结构的位置关系.该信息为视觉特征与几何结构间的纽带,它是计算车辆相对或绝对位置的基础.

|

图 2 路标视觉地图 Fig. 2 Landmark-based visual map |

为保证定位精度,高精度视觉地图的数据采集系统使用了一些高成本的传感器,如组合惯导以及DGPS基站等.而在定位时,仅需要一个普通GPS模块以及一台车载摄像机即可,且所生成的视觉地图可多次应用在定位中.此外,考虑到道路环境的变换导致视觉地图更新问题,可以采用经典的众包技术[9],即通过用户定位过程中所产生的实时数据来更新视觉地图,保证算法能适应环境变化,实现更加鲁棒的定位结果.

1.2 基于路标地图的多尺度定位算法为降低成本,定位采用一台车载摄像机以及一个普通的GPS接收机实现定位.定位时,通过车载摄像机拍摄路面图像,当图像中出现路标时,即可实现定位.需要指出的是,本文算法不能实现全路段连续车辆定位.但可与传统的定位算法(如视觉SLAM或者VO技术)相结合,提高系统定位精度与稳定性.例如,传统的视觉SLAM或者VO在定位过程中会产生累积漂移误差,通过结合本文算法,可在车辆经过路标时对定位误差进行校正,产生更准确和稳定的定位结果.

由于GPS接收机的存在,保证每个数据采集点均有一帧图像以及一条GPS数据.以所构建的高精度视觉地图为基础,与地图的三要素相结合,提出了基于路标视觉地图的多尺度定位算法,分为以下3个步骤:基于GPS匹配的初始定位、基于路面标志检测的路标级定位以及基于参考路标的度量级定位.

1.2.1 基于GPS匹配的初始定位GPS接收机具有成本低、使用广的优势,虽然其定位精度较低,但可将其用于初始定位,从而缩小定位范围,即在地图中选择一系列的路标作为接下来定位候选路标.

设地图中第i个路标高精度惯导数据为

| $ D = \min \left\{ {|{\rm{ dist }}\left( {G - {G_i}} \right)|} \right\}. $ | (1) |

由于G和Gi均为经纬度坐标,D为二者在大地坐标系下的弧长距离,因此需要将其转化为欧式距离,转化公式为

| $ \left\{\begin{array}{l}{\operatorname{dist}\left(G, G_{i}\right)=R \cdot \arccos \varphi_{i}}, \\ {\varphi_{i}=\sin b_{i} \sin b+\cos b_{i} \cos b \cos \left(a_{i}-a\right)}.\end{array}\right. $ | (2) |

式中R为地球半径.

由于GPS所得到的位置信息不准确,因此算法将与最近路标相邻的若干节点均视为初始定位结果,初始定位示意图如图 3所示,图中空心正方形表示地图中的路标,以图 3为例,所得到最近的参照路标为G3,初始定位结果为G1~G5.

|

图 3 GPS初始定位 Fig. 3 GPS coarse localization |

经初始定位后,在地图中得到了一系列的候选路标,路标级定位的目的是:在上述候选路标中找到一个距离当前待定位点最近的路标.

HOG特征的核心思想是:在一副图像中,局部目标的表象和形状能够被梯度或边缘的方向密度分布很好地描述,其描述子是在一个网格密集的大小统一的细胞单元上计算的,而且为了提高精度,还采用了重叠的局部对比归一化技术,具有对光照、方向、尺度不敏感等优点.定位选取了直行箭头,右转箭头,井盖等形状轮廓清晰的参照路标,边缘区域梯度幅值变化较大,故能很好地利用HOG特征描述子.为满足HOG特征和检测速度的需求,选用SVM算法[13-14]进行路标的分类检测.对于给定的训练样本集

| $ \begin{array}{l} {\rm{ }}\min \parallel \omega \parallel /2, \\ {\rm{s}}{\rm{.t}}{\rm{. }}{y_i}\left( {{\omega _i} \cdot {x_i} + b} \right) \ge 1, i = 1, 2, \ldots n. \end{array} $ |

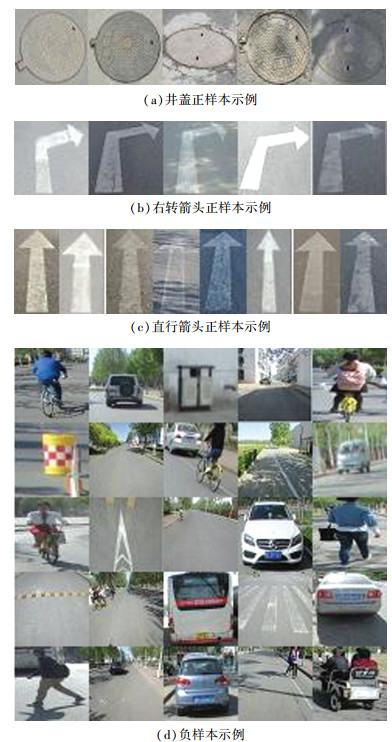

定位选取直行箭头,右转箭头,井盖等作为检测路标,建立正样本数据库如图 4(a)~4(c)所示,为了保证检测精度,以周围景物(如垃圾箱、交通牌、车辆、行人等)为基础,建立了负样本库,如图 4(d)所示.采用HOG+SVM分类算法训练样本数据,得到路标分类模型.当待定位点的数据输入时,为提高检测效率,将车载GPS与候选路标的地图数据相匹配,并设定距离阈值ρ,当二者距离小于ρ时,则对查询图像进行路标检测.若不成功,则定位失败,重新进行数据采集,通过约束路标检测率避免了路标磨损或缺失以及道路变更导致定位精度降低的问题.

|

图 4 训练样本集 Fig. 4 Training sample set |

当检测到路标后,通过视觉特征匹配的方式从初始定位结果中得到一个最近路标.与其他方法不同的是,提取的视觉特征不单纯针对于路标本身,还包括待定位点路标的背景图像,背景图像的加入有利于增强路标的唯一性表达.为保证匹配效率,算法采用ORB特征提取法,其运算速度是SIFT算法的100倍,是SURF算法的10倍,所得到的局部特征描述符为

| $ {f_n}(p) = \sum\limits_{1 \le i \le n} {{2^{i - 1}}} \tau \left( {p;{x_i}, {y_i}} \right). $ | (3) |

n选为默认的参数256,此时特征点对相关性较低,呈最佳性能的高斯分布,因此每个特征点由256位描述符进行描述.提取查询图像的视觉特征,与初始定位结果中的视觉特征进行特征匹配,计算特征点间的汉明距离为

| $ {\mathop{\rm Hamm}\nolimits} (X, Y) = \sum\limits_{i = 1}^{256} {{\rm{XOR}}} \left( {{x_i}, {y_i}} \right), x \in X, y \in Y. $ | (4) |

式中X、Y分别代表两幅图像的256位特征描述符,XOR为异或计算,i为第i个像素点.此外,设定一个阈值σ,当两点间汉明距离小于σ时,为一对匹配上的特征点.经过RANSAC剔除误匹配后,比较匹配特征点的数量即结果,在初始定位结果中选取匹配最准确的路标作为最近路标,从而完成路标级定位.

1.2.3 基于参考路标的度量级定位得到最近路标后,需计算待定位点与最近路标的位置关系,度量级定位即可实现这一目标.首先通过特征匹配计算查询图像与最近路标的平面单应性,其次结合最近路标所对应的路标几何尺寸结构信息,利用PnP模型计算车辆到参考路标的旋转矩阵 R和平移向量 t,从而得到车辆与路标之间的位置关系.

具体而言,首先计算查询图像与最近路标间的单应性矩阵,通过视觉特征匹配实现,计算公式为

| $ {\left[ {\begin{array}{*{20}{l}} {{u_{{\rm{b}}i}}}&{{v_{{\rm{b}}i}}}&1 \end{array}} \right]^{\rm{T}}} = {\mathit{\boldsymbol{H}}_b}{\left[ {\begin{array}{*{20}{l}} {{u_{{\rm{a}}i}}}&{{v_{{\rm{a}}i}}}&1 \end{array}} \right]^{\rm{T}}}, \quad (i \ge 4). $ | (5) |

式中

其次,查询地图数据,提取最近路标所对应的几何特征信息,以及视觉特征与几何特征信息的相对位置关系为

| $ {\left[ {\begin{array}{*{20}{l}} {{u_{{\rm{a}}i}}}&{{v_{{\rm{a}}i}}}&1 \end{array}} \right]^{\rm{T}}} = {\mathit{\boldsymbol{H}}_{\rm{a}}}{\left[ {\begin{array}{*{20}{l}} {{X_{{\rm{a}}i}}}&{{Y_{{\rm{a}}i}}}&1 \end{array}} \right]^{\rm{T}}}, (i \ge 4). $ | (6) |

式中

最后,运用PnP模型建立当前车载摄像机图像坐标平面与路标物理平面之间的关系为

| $ \begin{array}{l} \left[ {{u_{{\rm{b}}i}}} \right.\quad {\left. {{v_{{\rm{b}}i}}\quad 1} \right]^{\rm{T}}} \cong {\mathit{\boldsymbol{H}}_{\rm{b}}}{\mathit{\boldsymbol{H}}_{\rm{a}}}{\left[ {{X_{{\rm{a}}i}}\quad {Y_{{\rm{a}}i}}\quad 1} \right]^{\rm{T}}} = \\ \mathit{\boldsymbol{H}}\left[ {{X_{{\rm{a}}i}}} \right.\quad {\left. {{Y_{{\rm{a}}i}}\quad 1} \right]^{\rm{T}}}. \end{array} $ | (7) |

由摄像机几何关系可知:

| $ \boldsymbol{H}=\left[\begin{array}{lll}{\boldsymbol{h}_{1}} & {\boldsymbol{h}_{2}} & {\boldsymbol{h}_{3}}\end{array}\right]=s \boldsymbol{K}\left[\begin{array}{lll}{\boldsymbol{r}_{1}} & {\boldsymbol{r}_{2}} & {\boldsymbol{t}}\end{array}\right]. $ | (8) |

式中:s为比例因子,K为摄像机内参矩阵,r1, r2分别为旋转矩阵 R的两个列向量,t为平移向量.方程得到

| $ \boldsymbol{R}=\left[\begin{array}{lllll}{\lambda_{1} \boldsymbol{K}^{-1} \boldsymbol{h}_{1}} & {\lambda_{2} \boldsymbol{K}^{-1} \boldsymbol{h}_{2}} & {\boldsymbol{r}_{1}} {\times \boldsymbol{r}_{2}}\end{array}\right], $ | (9) |

| $ t=\lambda_{3} \boldsymbol{K}^{-1} \boldsymbol{h}_{3}. $ | (10) |

式中λi作为比例因子,分别取

为检测算法性能,选取了某校园中部分路段的井盖、右转箭头、直行箭头等作为参照路标做了验证性实验,所选路段在图 5中用粗线条标记,实验路段总长约为3.4 km.车载摄像机的分辨率为640像素× 480像素.通过张氏标定法确定车载摄像机的内参数.实验中车载摄像机俯视向下倾斜约30°、高为123 cm.摄像机对应的焦距为456.6像素,主点位置为[309.1 246.7]T(像素),在以下实验中,相机内参数保持不变.路标地图和视觉表征中记录了各个路标高精度惯导数据和几何结构信息,由于数据量繁多、地形复杂、较为抽象,在此不进行细节展示.

|

图 5 实验路段平面图 Fig. 5 Plot diagram of the experimental section |

首先为路标的高精度视觉地图构建.构建时通过GPS结合组合惯导、GPS差分基站、以及车载摄像机进行数据采集,地图中保证每个路标均有一帧图像以及一条高精度位置信息.采集完毕后,通过1.1节所述的地图构建方法,提取路标视觉地图的三要素,完成构建.

其次为车辆多尺度定位.定位时,首先通过GPS进行初始定位,缩小查询图像的路标检测范围.其次为路标级定位,提取查询图像HOG特征进行SVM分类检测. SVM算法对于小样本训练数据效果较好,当选取的样本数量较大时,容易出现过学习的现象.经试验正负样本比例为1:2.5左右时,获得最佳训练模型,此时路标检测准确率最高.数据样本是在面积约为1.65 km2的校园环境中采集的, 总共有4 650个,与经典的KITTI数据中的典型智能车定位测试环境(一般为1~3 km的测试道路)具有比拟性.训练样本采集了不同时段、不同天气等条件下的图片,使得检测结果受天气、树影的影响较小.值得说明的是,路面上相同类型的路标一般会有一定的间距.而在车载GPS的粗定位范围内(如1~10 m),路标重复出现的几率不大.图 6展示了晴天与雨天环境下路标检测结果,通过该图可知,3种不同的道路标志均能够被准确检测出来,检测数据及结果见表 1,3种路面路标均有较高的检测精度.

|

图 6 路标检测结果 Fig. 6 Results of landmark detection |

| 表 1 路标检测实验数据及结果 Tab. 1 Experimental data and results of landmark detection |

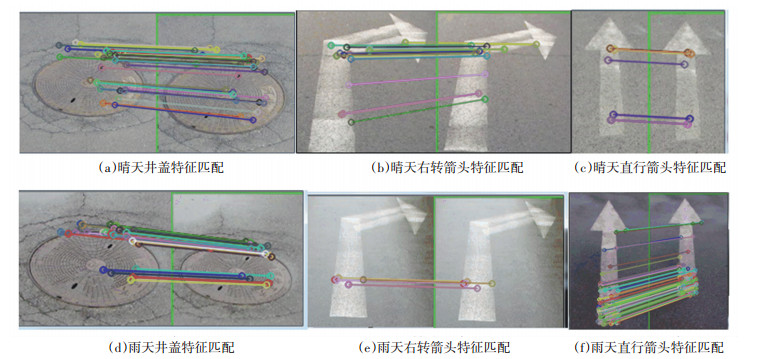

路标检测完毕后,将查询图像路标与初始定位结果进行视觉特征匹配.采用了快速的ORB特征提取法,通过计算两匹配点对间的汉明距离完成匹配,同时采用RANSAC算法剔除误匹配,匹配结果如图 7所示.图 7(a)~7(c)分别为3种不同的路面路标在晴天环境下的匹配结果,7(d)~7(f)分别为3种不同的路面路标在雨天环境下的匹配结果,可以看出,3种路面路标均有足够多的特征点匹配数量,根据匹配结果,选取匹配点对最多且匹配最为准确的结果作为距离当前车辆位置最近的路标,完成路标级定位.

|

图 7 路标级定位结果 Fig. 7 Landmark localization results |

得到最近路标后,进行度量级定位.查询地图中该路标的几何结构信息,建立世界坐标系,图 8分别展示了不同路标世界坐标系的构建.选取路标的4个角点,如图 8中的黑点所示,分别写出对应的世界坐标系下的坐标(单位:cm),同时提取角点对应的像素坐标,计算世界坐标系与图像坐标系间的摄影几何关系.然后根据最近路标与查询图像路标间的特征匹配点对,通过单应性矩阵建立两图像间的相对位置关系,由PnP模型计算当前车辆的相对位姿R,t,从而计算车辆到检测路标的距离,完成度量级定位.计算过程如式(5)~(10)所示.

|

图 8 不同路标世界坐标系的构建 Fig. 8 Construction of world coordinate system for different kinds of landmarks |

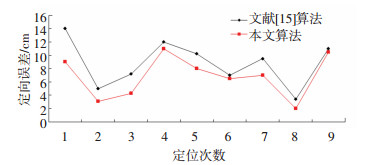

实验拍摄了晴天与雨天两种情况下路面路标的图像数据,分别进行了60次和20次定位实验,定位结果如图 9所示.在晴天环境下的最大定位误差为16.1 cm,平均定位误差为8.4 cm,雨天环境下的最大定位误差为23.3 cm,平均定位误差为12.2 cm.算法在不同的天气环境下进行验证实验,且达到了亚米级定位精度,具有较高的鲁棒性.

|

图 9 车辆定位结果 Fig. 9 Vehicle localization results |

最后,本文算法结果也与文献[15]中算法进行对比,为保证公平性,实验随机选取了晴天情况下的8个定位点作为对比,对比结果如图 10所示.由图可知,文献[15]算法的平均误差为8.8 cm,最大误差为14.0 cm.本文平均定位误差为6.8 cm,最大定位误差为11.0 cm.与文献[15]算法对比,路标级定位过程减小了道路环境中人、车、建筑物等背景的干扰,使得有效特征点的提取率更高,且充分利用了路面路标的几何结构信息,有效解决了部分目标被遮挡的问题,增强了参考位置的稳定性.

|

图 10 车辆定位误差对比结果 Fig. 10 Comparison of vehicle localization error results |

1) 构建了路标高精度视觉地图,以路面路标为核心元素,充分提取路面路标的高精度位置信息、路标的几何结构信息以及视觉特征与结构信息的位置关系.通过上述三要素,实现对道路场景的唯一性表达.

2) 与地图三要素相结合,以高精度视觉地图为基础实现定位,获得精确稳定的定位结果.该算法可与传统的VO或SLAM定位算法结合,有效解决累积漂移误差等问题.同时定位仅使用一个车载GPS和一个车载单目相机完成定位实验,降低了车辆定位技术成本.

3) 提出了多尺度定位方法,为提高了算法的可靠性与鲁棒性,分别在晴天与雨天两种天气环境下做了验证实验,平均误差可达12.5 cm,最大误差仅为23.3 cm.

| [1] |

SINGH I, LEE S W. Self-adaptive requirements for intelligent transportation system: a case study[C]// International Conference on Information and Communication Technology Convergence. Jeju, Korea: IEEE Press, 2017: 520. DOI: 10.1109/ICTC.2017.8191032

|

| [2] |

MENOUAR H, GUVENC I, AKKAYA K, et al. UAV-enabled intelligent transportation systems for the smart city: applications and challenges[J]. IEEE Communications Magazine, 2017, 55(3): 22. DOI:10.1109/MCOM.2017.1600238CM |

| [3] |

张长远. 基于D-GPS/IMU的组合导航方法研究与分析[J]. 中国新通信, 2016, 18(5): 57. ZHANG Changyuan. Research and analysis of integratednavigation system based on D-GPS/IMU[J]. Computer Measurement and Control, 2016, 18(5): 57. DOI:10.3969/j.issn.1673-4866.2016.05.038 |

| [4] |

WANG Huili, SHI Zhongke. GPS/INS integrated navigation filtering algorithm based on uncertain fusion[J]. Control and Decision, 2015. DOI:10.13195/j.kzyjc.2014.0642 |

| [5] |

GAO Mingyang, WANG Meiling, ZHU Hao. Panoramic visual odometry for ground vehicle[C]//35th Chinese Control Conference (CCC). Chengdu, China: IEEE Press, 2016. DOI: 10.1109/ChiCC.2016.7554208

|

| [6] |

GUILLAUME B, ZAYED A, LI Y, et al. Simultaneous localization and mapping: a survey of current trends in autonomous driving[J]. IEEE Transactions on Intelligent Vehicles, 2017, 2(3): 194. DOI:10.1109/TIV.2017.2749181 |

| [7] |

CAI Hao, HU Zhaozheng, HUANG Gang, et al. Integration of GPS, monocular vision, and high definition (HD) map for accurate localization of intelligent vehicles[J]. Sensors, 2018, 18(10): 3270. DOI:10.3390/s18103270 |

| [8] |

ZUIT, PHILIPPE B, VINCENT F, et al. Mapping and localization using GPS, lane markings and proprioceptive sensors[C]// IEEE/RSJ International Conference on Intelligent Robots & Systems. Tokyo, Japan: IEEE Press, 2013. DOI: 10.1109/IROS.2013.6696383

|

| [9] |

DABEER O, GOWAIKER R, GRZECHNIK S K, et al. An end-to-end system for crowd-sourced 3D maps for autonomous vehicles: the mapping component[C]//IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Vancouver, Canada: IEEE Press, 2017. DOI: 10.1109/IROS.2017.8202218

|

| [10] |

SCHREIBER M, KONIGSHOF H, HELLMUND AM, et al. Vehicle localization with tightly coupled GNSS and visual odometry[C]// Intelligent Vehicles Symposium. Gothenburg, Sweden: IEEE Press, 2016. DOI: 10.1109/IVS.2016.7535488

|

| [11] |

王忠立, 赵杰, 蔡鹤皋. 大规模环境下基于图优化SLAM的图构建方法[J]. 哈尔滨工业大学学报, 2015, 47(1): 75. WANG Zhongli, ZHAO Jie, CAI Hegao. A survey of front-end method for graph-based slam under large-scale environment[J]. Journal of Harbin Institute of Technology, 2015, 47(1): 75. DOI:10.3969/j.issn.1009-1971.2015.01.011 |

| [12] |

LATEGAHN H, STILLER C. Vision-only localization[J]. IEEE Transactions on Intelligent Transportation Systems, 2014, 15(3): 1246. DOI:10.1109/TITS.2014.2298492 |

| [13] |

李星, 郭晓松, 郭君斌. 基于HOG特征和SVM的前向车辆识别方法[J]. 计算机科学, 2013, 40(增刊2): 329. LI Xing, GUO Xiaosong, GUO Junbin. HOG-feature and SVM based method for forward vehicle recognition[J]. Computer Science, 2013, 40(S2): 329. |

| [14] |

YAO Chang, WU Feng, CHEN Houjin, et al. Traffic sign recognition using HOG-SVM and grid search[C]// International Conference on Signal Processing. Hangzhou, China: IEEE Press, 2015. DOI: 10.1109/ICOSP.2014.7015147

|

| [15] |

李祎承, 胡钊政, 胡月志, 等. 基于GPS与图像融合的智能车辆高精度定位算法[J]. 交通运输系统工程与信息, 2017, 17(3): 112. LI Yicheng, HU Zhaozheng, HU Yuezhi, et al. Accurate localization based on GPS and image fusion for intelligent vehicles[J]. Journal of Transportation Systems Engineering and Information Technology, 2017, 17(3): 112. DOI:10.16097/j.cnki.1009-6744.2017.03.017 |

2019, Vol. 51

2019, Vol. 51