2. 哈尔滨工程大学 计算机科学与技术学院,哈尔滨 150001

2. Collage of Computer Science and Technology, Harbin Engineering University, Harbin 150001, China

红外视频与普通彩色视频相比易受周围环境的影响,目标的外观常有较大的变化幅度,主要表现为轮廓变化和灰度分布变化,导致跟踪困难[1-3].目前,红外行人跟踪广泛应用的是三维中值滤波、图像差分法、卡尔曼滤波、粒子滤波和mean-shift等方法[4].这些方法往往只能针对图像的某些特征对目标进行识别,由于特征种类的限制,跟踪的效果往往仅在几种属性上有较强效果但不够全面.

深度学习方法具有强大的特征建模能力,近年它在完成目标跟踪任务的准确度上表现出了突出优势.目前主要有两类方法.第一类是将卷积特征与相关滤波器结合.例如,Danelljan等提出了C-COT[5]算法,通过在连续的分辨率序列中学习, 创建时域连续的的相关滤波器, 可以将不同分辨率的特征图作为滤波器的输入, 使得传统特征和深度特征能够深度结合.在下一年Danelljan等又提出了C-COT的改进算法ECO[6],通过构造一组更小的滤波器, 有效地利用矩阵分解操作, 降低了模型的大小,防止过高的维度导致的效率低下和过拟合问题.这一类方法的缺点是跟踪速度较慢,在跟踪数据集上训练易造成过拟合.第二类是使用孪生网络的方法.例如,文献[7]提出了SINT算法,SINT可以说是第一个将孪生网络应用到跟踪领域的通过相似学习解决跟踪问题.Bertinetto等又通过改进SINT算法提出了一种新的、经过端到端训练的、全卷积的孪生网络的跟踪算法SiamFC[8],它也是通过使用相似度学习的方法来解决追踪任意目标的问题.SiamRPN[9]是由Li等提出的基于SiamFC改进来的算法,引入了Faster RCNN[10]中的RPN模块,让网络可以回归位置、形状,省掉多尺度测试,提高算法性能.第二类方法极大地增强了跟踪速度,使待搜索图像大小不受限制,并且避免了在跟踪数据集上训练造成的过拟合.但此类方法的跟踪模版始终为上一帧的被跟踪目标,对被跟踪帧的目标特征没有预判,在处理目标形状快速变化的跟踪任务时仍有欠缺.

本文设计了VPSiamRPN目标跟踪网络.将SiamRPN网络应用到红外目标跟踪任务中,根据红外成像的特点,将视频预测加入到网络中,增强网络对目标快速形变的适应能力,采用Pred Net[11]网络对当前帧目标外观进行预测,用预测出的目标作为模版在被检测帧中进行搜索,完成目标跟踪任务.

1 相关原理介绍 1.1 SiamRPN[8]目标跟踪原理SiamRPN将跟踪问题抽象成单样本检测问题.SiamRPN结合了跟踪中的孪生网络和检测中的区域推荐网络:孪生网络实现对跟踪目标的适应,让算法可以利用被跟踪目标的信息,完成检测器的初始化;区域推荐网络让算法可以对目标位置进行更精准地预测.经过两者的结合,SiamRPN可以进行端到端的训练.SiamRPN结构如图 1所示.

|

图 1 SiamRPN网络结构[9] Fig. 1 Diagram of SiamRPN network structure |

孪生神经网络可计算两个输入的相似度,同时将跟踪模版图像和被检测帧图像由上下两个支路输入,两个支路由一个卷积网络实现,它们共享权值,此网络必须为全卷积网络,以满足平移不变性,该网络的作用是分别提取模板帧和检测帧的图像特征.RPN网络由两部分组成,一是分类分支,用于区分目标和背景,另一个是回归分支,它将候选区域进行微调.网络的卷积基部分本文采用resnet50[12]结构.

网络训练采用COCO、YOUTUBEBB、DET、VID数据集进行训练.

1) 损失函数:cross-entropy loss用于分类,smooth L1用于回归;

2) 训练方法:随机梯度下降;

3) 数据增强:包括affine transformation(仿射变换)在内的数据增强;

4) 正负样本选择策略:设置高低两个阈值,大于0.6的为正样本,小于0.3的为负样本,一个pair中有64个样本,其中正样本最多16个.

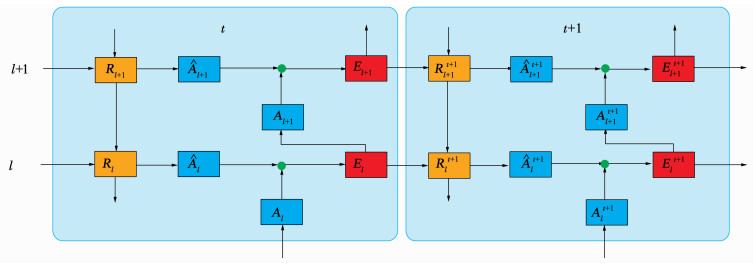

1.2 PredNet[11]视频帧预测原理该网络采用CNN+LSTM[13]思路做视频预测,通过提取前n帧图像特征,预测目标图像.网络包含一系列重复堆叠的模块,每个模块作为一个概念层,每层包含4个基本部分:输入卷积层Al,递归表示层Rl,预测层

1) El:误差表示层,f(Al-

2) Al:输入卷积层,对于第一层,为目标图像;对于更高层,为前一层预测误差E的卷积+Relu.

3) Rl:卷积LSTM层.

4)

图 2为PredNet网络结构,激活函数采用Relu,Al与

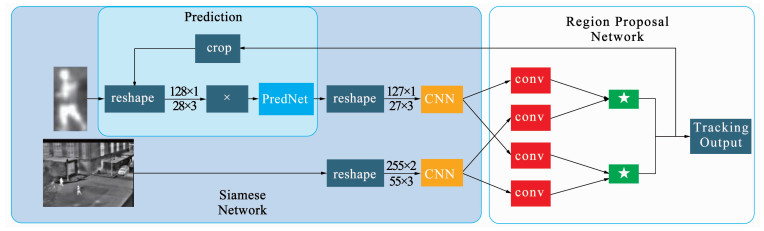

本文设计了一种基于视频预测的红外行人跟踪网络(Video Prediction with Siamese Region Proposal Network,VPSiamRPN),将用于视频预测的PredNet网络添加到SiamRPN网络的模版和与模版图像所对应的卷积网络之间.PredNet采用四层网络,通过5帧目标图像预测下一帧目标外观,为使被预测包含部分视频之初的目标特征,设计一个可以存储5帧图像的序列X,前3帧固定为被跟踪视频的第1~3帧图像中的目标,后两帧将跟踪得到的目标图像做为模版依次存入序列中,序列始终按照时间顺序存储最新的两帧目标图像.跟踪过程最初的前5帧应用SiamRPN网络进行跟踪,从第6帧开始预测,将X中的数据输入PredNet网络,预测和生成下一帧的目标,将生成的目标图像作为SiamRPN网络的模板,在被检测帧中,根据模版搜索目标并输出.由于SiamRPN网络在跟踪时将上一帧目标图像做为模版,这就造成一旦某一帧的跟踪发生偏差,下一帧的模版就会随之出现偏差.如果偏差过大,下一帧目标就会丢失,并再也无法找回目标.为防止由预测误差造成的目标丢失,10帧中的后两帧将第1帧的目标做为模版通过SiamRPN网络进行跟踪,不经过预测网络.

由于孪生网络计算相似度要求两支路所表达的特征必须源自一种网络结构,所以PredNet网络依据前几帧的目标信息预测出待测目标信息,并以输出的目标图像为媒介,将网络所预测的特征信息转换为resnet50网络所表达的特征信息,将得到的特征输入RPN网络进行跟踪.图 3为本文描述的网络和SiamRPN网络的跟踪效果截图,其中绿色框为被跟踪目标的ground truth,红色框为SiamRPN网络的跟踪效果,蓝色框为本文设计网络的跟踪效果.图 4为VPSiamRPN网络的结构.

|

图 3 本文描述的网络和SiamRPN网络的跟踪效果 Fig. 3 Screenshots of tracking effects of the proposed network and SiamRPN network |

|

图 4 VPSiamRPN网络结构 Fig. 4 Diagram of VPSiamRPN network structure |

非预测的网络跟踪过程为:将被检测帧重塑为255×255×3并输入卷积网络作为被检测帧.由于Prednet网络只能输出长宽为偶数的图像,所以首先将第1帧目标图像重塑为128×128×3,将重塑后的图像存放在序列X中,再将图像重塑为127×127×3作为模版帧输入卷积网络,将得到的两组特征输入RPN网络完成跟踪.根据目标位置信息对被检测帧进行裁剪,将裁剪后得到的目标图像重塑为128×128×3存入序列X中替换掉第1帧并将序列X按图像存入的顺序重新排序.

预测的网络跟踪过程为:PredNet网络通过存储在序列X中的8帧图像预测出当前帧的目标图像,输出的图像经重塑后大小为127×127×3作为模版帧.模板帧和被检测帧经过相同的卷积结构分别得到6×6×256,22×22×256的特征,模版帧所产生的特征通过3×3的卷积核分别产生了4×4×(2k×256)和4×4×(4k×256)的特征,k值为RPN网络所需的矩形框数.通过得到的两组特征输入RPN网络得到目标位置信息.根据目标位置信息对被检测帧进行裁剪,将裁剪后得到的目标图像重塑为128×128×3存入序列X中替换掉第1帧并将序列X按图像存入的顺序重新排序.

3 结果分析本实验软件运行环境为Ubuntu18.04,平台为Python3.7+PyTorch0.4.1开源机器学习框架,硬件配置为:Intel i7-8700k 3.7 GHz CPU, 64 GB RAM, single GPU NVIDIA GTX 2 080 Ti.

本研究设计的网络采用非端到端的训练方法,将PredNet网络和SiamRPN网络分开训练,PredNet网络:从OBT50、OBT100、VOT2013、VOT2014、VOT2015、VOT2016和VOT2018数据集中选取129个红外行人视频,将每个被标注的视频序列中的每帧图像依据标注进行裁剪得到一个只有目标没有背景的图像序列做为预测网络的训练集.SiamRPN网络:采用经商汤开源的SiamRPN网络卷积基采用resnet50版本的权重文件.

通过改变预测网络层数、预测过程所需的被选目标图像及图像帧数、预测网络参与跟踪的频率,设计了九组对比试验,以找出性能最佳的网络结构,具体设置如表 1所示.

| 表 1 9种网络具体结构 Tab. 1 Nine network structures |

采用PTB-TIR数据集[14] 对本研究的9种网络与SiamRPN网络进行对比评估,测试网络性能.该数据集包含60组红外行人视频序列,根据每个序列所包含的特性组合出了9种属性(热交叉、强度变化、遮挡、尺寸变化、背景杂波、低分辨率、快速运动、运动模糊和脱离视野)的数据集,评估通过OTB数据集[15]的评价标准计算本研究设计的网络和SiamRPN网络的跟踪成功率和跟踪精度,对网络性能进行评价.

1) 整体数据集.在整体数据集上,45fb网络(PredNet中采用4层网络,通过5帧目标图像预测当前帧目标,其中前3帧固定为视频的第1~3帧中的目标,每8帧的下2帧不预测)在跟踪成功率和跟踪精度上都表现出了较大优势,得分为0.426和0.571,SiamRPN网络的得分为0.419和0.557.

2) 热交叉.热交叉属性指视频中具有相似强度的两个目标相互交叉.在此属性中45fb网络的跟踪成功率的得分为0.407,跟踪精度的得分为0.610;SiamRPN网络跟踪成功率的得分为0.398,跟踪精度的得分为0.581.在这种属性上相对于SiamRPN网络表现出了较明显的优势.48fb网络在此属性跟踪成功率略高于SiamRPN网络,得分为0.403.此项结果表明本文网络对具有热交叉属性的红外视频在跟踪性能上有提高.

3) 强度变化.强度变化属性指由于目标的温度变化,目标区域的强度发生了变化.在此属性中45fb网络的成功率的得分为0.374,SiamRPN网络的得分为0.350;45fb网络跟踪精度的得分为0.328,SiamRPN网络的得分为0.334.网络在此属性中跟踪成功率略高于SiamRPN网络.在此属性中38fq网络在成功率和跟踪精度上都表现出了较大优势,得分为0.551和0.509.此项结果表明本文网络对具有强度变化属性的红外视频在跟踪成功率上有所提高.

4) 遮挡.遮挡属性指目标被部分或完全遮挡.在此属性中45fb网络在跟踪成功率和跟踪精度上都表现出了较大优势,得分为0.380和0.496,SiamRPN网络的得分为0.370和0.486.此项结果表明本文网络对具有遮挡属性的红外视频在跟踪成功率上有所提高.

5) 尺寸变化.尺寸变化属性指第1帧和当前帧中,目标大小的比率超出范围[1/2,2].在此属性中45fb网络在跟踪成功率上高于SiamRPN网络,45fb网络得分为0.408,SiamRPN网络的得分为0.404;在跟踪精度上略低,45fb网络得分为0.508,SiamRPN网络的得分为0.516.此项结果表明本文网络对具有尺寸变化属性的红外视频在跟踪成功率上有所提高.

6) 背景杂波.背景杂波属性指目标附近的背景具有相似的纹理或强度.在此属性中45fb网络的成功率得分为0.411,48fb网络的成功率得分为0.409;45fb网络的跟踪精度得分为0.548,48fb网络的跟踪精度得分为0.551;SiamRPN网络的得分分别为0.398和0.534,本文网络在成功率和跟踪精度上对SiamRPN网络都表现出了较大优势.结果表明本文网络对具有热交叉属性的红外视频在跟踪性能上有提高.

7) 低分辨率.低分辨率属性指目标小于600像素.在此属性中45fb网络在跟踪成功率上的得分比SiamRPN网络低0.016,但在跟踪精度上高0.033.

8) 快速运动.快速运动属性指目标在相邻帧中的移动距离大于20像素.在此属性中45fb网络在跟踪成功率上的得分比SiamRPN网络低了0.014,跟踪精度上高0.049.

9) 运动模糊.运动模糊属性指目标区域由于目标或摄像机运动而变得模糊.在此属性中45fb网络在跟踪成功率上和SiamRPN网络取得了相同的得分0.456,跟踪精度上低了0.001;48fb网络在跟踪精度上的得分比SiamRPN网络高了0.008.

10) 脱离视野.脱离视野属性指目标部分不在图像区域内.在此属性中45fb网络在跟踪成功率和跟踪精度上都强于SiamRPN网络.在此属性中45fb网络的跟踪成功率的得分为0.456,SiamRPN网络的得分为0.453;跟踪精度的得分为0.497,SiamRPN网络的得分为0.466.在两种属性上相对于其他网络(包括SiamRPN网络)都表现出了较明显的优势.此项结果表明本文网络对具有脱离视野属性的红外视频在跟踪性能上有提高.

表 2和表 3分别列出了10种网络在各个属性上的成功率和精度.

| 表 2 10种网络在各个属性上的跟踪成功率 Tab. 2 Success plots of 10 networks in each attribute |

| 表 3 10种网络在各个属性上的跟踪精度 Tab. 3 Precision plots of 10 networks in each attribute |

根据跟踪结果可以看出45fb网络在热交叉、强度变化、遮挡、尺寸变化、背景杂波、脱离视野和总体数据集上相对于SiamRPN网络在跟踪成功率上有很大提高; 在热交叉、遮挡、背景杂波、低分辨率、脱离视野和总体数据集上相对于SiamRPN网络在重叠率上表现出了明显提升,综合性能具有突出优势,表明该方法有效、可行,图 5为45fb网络和SiamRPN在PTB-TIR数据集上的跟踪成功率和跟踪精度的对比.此外,38fb网络在热交叉属性上的成功率和重叠率都表现出了极大优势,表明此网络非常适合跟踪带有热交叉属性的视频.

|

图 5 45fb网络和SiamRPN在PTB-TIR数据集上的跟踪成功率和跟踪精度 Fig. 5 Success plots and precision tracking of 45fb network and SiamRPN on PTB-TIR dataset |

1) 针对红外行人目标的跟踪问题,提出了使用视频预测网络对跟踪模板进行更新,该方法能够提高跟踪模板与被跟踪目标的相似度,增强网络对红外行人目标外观轮廓和灰度分布变化所导致跟踪困难的问题的处理能力,有利于目标跟踪中的模型匹配.

2) 通过改变预测网络层数、预测过程所需的被选目标图像及图像帧数、预测网络参与跟踪的频率,设计了9组对比试验.在PTB-TIR数据集上,与SiamRPN网络客观定量对比和评估,实验结果表明,45fb网络对红外目标的识别在热交叉、强度变化、遮挡和尺寸变化等多种属性上的跟踪成功率和重叠率均较SiamRPN网络有较大提高,显示出对红外行人跟踪的良好性能,在这一领域将有广阔的应用前景.

| [1] |

RAJKUMAR S, CHANDRA M. Pedestrian detection in Infrared Images using local thresholding[C]//2015 2nd International Conference on Electronics and Communication Systems (ICECS). Cairo: IEEE, 2015: 259.DOI: 10.1109/ECS.2015.7124904

|

| [2] |

高小明. 影响红外热像仪测量精度的因素分析[J]. 华电技术, 2008, 30(11): 4. GAO Xiaoming. Analysis of factors affecting the measurement accuracy of infrared thermal imager[J]. Huadian Technology, 2008, 30(11): 4. DOI:10.3969/j.issn.1674-1951.2008.11.002 |

| [3] |

郭永彩, 胡瑞光, 高潮. 红外图像中的行人检测[J]. 重庆大学学报, 2009, 32(9): 1070. GUO Yongcai, HU Ruiguang, GAO Chao. Pedestrian detection in infrared image[J]. Journal of Chongqing University, 2009, 32(9): 1070. DOI:10.11835/j.issn.1000-582x.2009.09.017 |

| [4] |

孟琭, 杨旭. 目标跟踪算法综述[J]. 自动化学报, 2019, 45(7): 1244. MENG Lu, YANG Xu. A survey of target tracking algorithms[J]. Acta Automatica Sinica, 2019, 45(7): 1244. DOI:10.16383/j.aas.c180277 |

| [5] |

DANELLJAN M, ROBINSON A, FELSBERG M, et al. Beyond correlation filters: learning continuous convolution operators for visual tracking[C]//ECCV 2016: Computer Vision-ECCV 2016 Workshops. Amsterdam: IEEE, 2016: 472. DOI: 10.10072978-3-319-46454-1_29

|

| [6] |

DANELLJAN M, BHAT G, FELSBERG M, et al. ECO: efficient convolution operators for tracking[C]//The IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu: IEEE, 2017: 6638. DOI: 10.1109/CVPR.2017.733

|

| [7] |

TAO R, GAVVES E. Siamese instance search for tracking[C]//The IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas: IEEE, 2016: 1420. DOI: 10.1109/CVPR.2016.158

|

| [8] |

BERTINETTO L, VALMADRE J. Fully-convolutional Siamese networks for object tracking[C]//ECCV 2016: Computer Vision-ECCV 2016 Workshops. Amsterdam: IEEE, 2016: 850

|

| [9] |

LI Bo, YAN Jiejun, WU Wei, et al. High performance visual tracking with Siamese region proposal network[C]//The IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Salt Lake City: IEEE, 2018: 8971. DOI: 10.1109/CVPR.2018.00935

|

| [10] |

REN Qingshao, HE Mingkai, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 2805. |

| [11] |

LOTTERW, KREIMAN G, COX D. Deep predictive coding networks for video prediction and unsupervised learning[Z]. arXiv: 1605.08104, 2016

|

| [12] |

HE Mingkai, ZHANG Yuxiang, REN Qingshao, et al. Deep residual learning for image recognition[C]// The IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas: IEEE, 2016: 770. DOI: 10.1109/CVPR.2016.90

|

| [13] |

SHI Jianxing, CHEN Rongzhou, WANG Hao, et al. Convolutional LSTM network: a machine learning approach for precipitation nowcasting[C]// NIPS'15 Proceedings of the 28th International Conference on Neural Information Processing Systems-Volume 1. Montreal: MIT Press, 2015: 802. DOI: 10.1007/9783-319-21233-3_6

|

| [14] |

LIU Qiao, HE Yuzhen, LI Xin, et al. PTB-TIR: A thermal infrared pedestrian tracking benchmark[Z]. arXiv: 1801.05944, 2018

|

| [15] |

WU Y, LIM J, YANG M. Online object tracking: a benchmark[C]// Proceedings of CVPR. Portland: IEEE, 2013: 2411. DOI: 10.1109/CVPR.2013.312

|

2020, Vol. 52

2020, Vol. 52