近年来,自然场景图像中的文本检测成为了计算机视觉领域的一个研究热点。自然场景图像文本检测在图像检索、定位导航、盲人辅助、数据录入等领域具有重要的实用价值。自然场景图像背景千变万化,并且自然场景图像文本具有大小和长宽比变化剧烈、多方向等特点;此外,与一般目标检测不同的是,文本目标框可能使用水平矩形、四边形、旋转矩形,甚至是多边形等形式进行精确表达,所以自然场景图像文本检测一直是一个难点问题。

通用目标检测(generic object detection)[1],定位图像上预先定义类别的目标实例的位置,检测结果通常以外接矩形框的形式呈现,不同于专用目标检测只适用于一种或一些类别,通用目标检测适用于广泛的类别,典型方法有Faster R-CNN[2]、SSD[3]等。随着深度学习技术的迅速发展,通用目标检测性能得到了显著的提升。很多学者在通用目标检测方法的基础上提出了许多自然场景文本检测方法。这些方法可以大致分为两类:间接回归方法与直接回归方法。间接回归方法,通常借鉴Faster R-CNN[2]、SSD[3]等目标检测方法,预先设定一些锚(anchor)或先验框(default box),利用卷积神经网络判定它们是否与文本区域高度重叠并调整它们的大小和位置以准确定位文本。然而自然场景中的文本方向多变,大小、长宽比变化剧烈,为了使预设的锚或先验框能与文本区域高度重叠,很多方法增加了多种方向、多种大小及多种长宽比的预设框,但这无疑增加了方法的复杂度与计算量。

为适应文本的特性,Liao等[4]、Zhong等[5]分别在Faster R-CNN、SSD的基础上增加了不同尺寸与长宽比的预设框。Ma等[6]、Liu等[7]为检测多方向的文本设置了多方向的预设框。为了能够输出四边形的检测结果,Liu等[7]、Liao等[8]直接预测预设框与文本边界四边形4个顶点的坐标差;Jiang等[9]通过预测两个顶点坐标与一条边长得到旋转矩形的检测结果;Zhu等[10]通过预测多个文本边界上的点得到多边形的检测结果。

直接回归方法不需要预设框,相比于间接回归方法,它更加灵活简便。直接回归方法借鉴了DenseBox[11]的思想,这类方法通常采用全卷积网络[12](fully convolutional network,FCN)的架构,在分割出文本区域中的候选点的同时在每个点处预测对应的文本区域边界。为了得到四边形的检测结果,He等[13]在分割出文本区域中像素点的同时预测该点与四边形边界顶点的坐标偏差。为了降低复杂度,Zhou等[14]预测文本区域中的点到文本外接旋转矩形4条边的距离与旋转矩形的角度。Xue等[15]则在此基础上还分割了文本的边界区域以助于区分文本实例。

上述基于回归的文本检测方法或是通过调整预设框得到文本的外接四边形,或是在每个点处直接预测文本的外接四边形,都是直接预测文本的整个边界框。这些方法能检测到目标尺寸与网络的感受野大小成正相关,当检测更长的文本目标时,网络需要更大的感受野。在面对长文本时,由于感受野大小有限,并且相应感受野内背景干扰可能更多,这些直接预测整个文本边界的方法难以得到理想的结果。

针对直接预测整个文本边界的方法在检测长文本时的缺陷,本文设计了一种短边顶点回归网络,该网络不再直接预测文本区域的所有边界。具体来说,本文方法在直接回归方法的基础上,分割出文本的两条短边附近的区域以及中间区域。不同于其他直接回归方法中文本区域中的点需要预测文本整个边界框,本方法中,文本边界框顶点由短边附近区域中的点来预测,并且一条短边区域内的点只预测其附近短边的两个顶点,而不需预测另外一条更远短边的顶点。在检测长文本时,相应感受野内背景干扰相对更少,同时对感受野大小的要求更低,所以检测结果更为准确。为了将预测的两组短边顶点结合,本文设计了一种新的后处理方法,利用中间区域与两短边区域相邻或两短边区域直接相邻的特点将文本的两个短边区域组合,两组预测的短边顶点随之结合,便能得到精确完整的文本检测结果。本文所提方法在多个自然场景文本检测数据集上均取得了不错的效果,结果超过了目前绝大部分方法,并且本方法更快速高效。

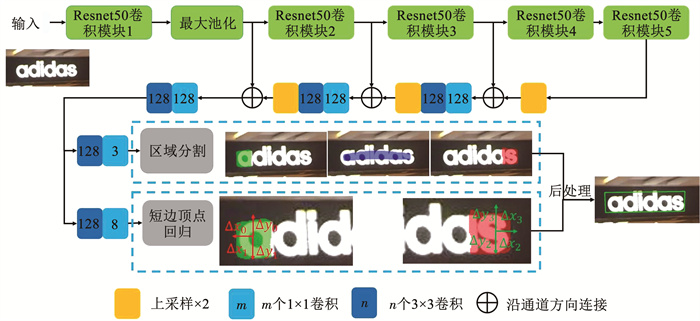

1 短边顶点回归网络的文本检测方法图 1为本文方法的原理流程图,本方法采用了全卷积与多层特征融合的网络架构。图像输入网络后,网络输出3种像素级分类结果,即文本中间区域像素、文本左短边区域像素、文本右短边区域像素。文本短边区域是指文本短边边界附近的区域。如图 1的区域分割结果所示,其中蓝色、绿色、红色区域分别为文本中间区域、左短边区域与右短边区域。在分类短边区域像素的同时,网络还在该点处预测附近一条短边两个顶点的坐标。最后通过后处理,本方法将左短边顶点与右短边顶点的预测结果结合起来,得到最终的检测结果。

|

图 1 基于短边顶点回归网络的文本检测方法流程 Fig. 1 Flowchart of scene text detection with short edge vertices regression network |

本方法的网络结构可以大致分为3个部分:特征提取、特征融合以及分类回归。特征提取部分使用Resnet 50[16]的框架,去除Resnet 50后面的全连接层,图 1中绿色模块为Resnet 50特征提取部分。相比于经典的VGG16/19[17],Resnet 50参数量更少,计算存储花销更小,而且Resnet 50使用了残差结构,能够有效缓解训练时发生梯度消失的情况。

自然场景图像中文本具有尺度变化剧烈的特点,特征提取网络越深,提取到的特征语义范围越广,越有利于大尺度文本的检测,而检测小的文本需要靠浅层局部的特征。为了能够检测不同大小的文本,本方法参考U-Net[18]的架构将Resnet 50提取到的多层特征进行融合。具体来说,高层的特征首先进行上采样,与低一层的特征的长宽维度保持一致,然后沿通道方向将上采样特征与低一层特征进行连接,最后使用一个1×1与一个3×3的卷积操作将特征进行融合。融合后的特征继续融合更低层特征,直至融合的特征长宽为原图像的1/4。

对于最小外接矩形长宽比接近于1的文本区域,它的中间区域、左短边区域、右短边区域会有部分重叠。所以在网络输出的结果中,同一个像素可以同时属于中间区域、左短边区域、右短边区域。在最后分类时,中间区域、左短边区域、右短边区域均与背景进行二分类,这样能够避免类间的竞争。具体来说,在最后融合的特征上分别使用一个1×1的卷积操作与一个sigmoid非线性函数来预测每个像素点属于中间区域、左短边区域、右短边区域的概率。

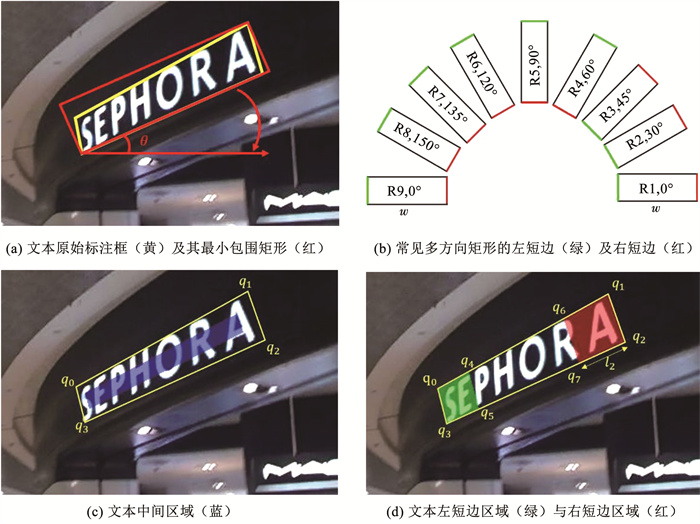

1.2 训练样本标签生成短边顶点回归网络的目标之一在于分割文本的中间区域、左短边区域及右短边区域。文本短边区域是文本短边边界附近的部分区域,在确定文本左、右短边区域前,首先需要规定文本的左短边及右短边。由于文本目标大多使用四边形进行标注,而四边形的两条对边不一定为最短的两条边,所以在此通过寻找四边形最小包围矩形的左短边及右短边来确定文本边界四边形的对应短边。

如图 2(a)所示,黄色四边形是文本区域原始的标注,红色的矩形是该四边形的最小包围矩形R。矩形R顺时针旋转直至长边与水平轴平行,假设此时底部长边为w,转过的角度为矩形R的倾角θ。当θ≤45°时,R旋转后,位于w右侧的短边对应的是R的右短边,位于w左侧的短边为R的左短边,例如图 2(b)中的R1、R2、R3;当θ>45°时,R旋转后,位于w左侧的短边对应的是R的右短边,位于w右侧的短边为R的左短边,例如图 2(b)中的R4、R5、R6、R7、R8。图 2(b)中矩形R绿色短边为左短边,红色短边为右短边。文本四边形的左、右短边与其最小包围矩形R的左、右短边一一对应。

|

图 2 左短边、中间、右短边区域标签生成 Fig. 2 Generation of labels of region near left short edge, middle region, and region near right short edge |

在确定文本的左短边与右短边后,再精确定义文本的中间区域、左短边区域、右短边区域。首先定义四边形Q={q0, q1, q2, q3},其顶点qi(i=0, 1, 2, 3)的参考长度为

| $ l_{i}=\min \left(h_{i,(i+1) \bmod 4}, h_{(i+3) \bmod 4, i}\right) $ | (1) |

式中:hi, j为边qiqj的长度,mod为求余数。将四边形Q的顶点qi沿长边方向、短边方向(指向四边形内部)各缩进0.3li后,4个新顶点包围的区域就是文本的中间区域,如图 2(c)的蓝色区域所示。中间区域的主要作用是确定文本实例,所以不需要将文本区域中所有像素都分割出来,使用缩小的中间区域有助于分离出文本实例,尤其是在检测密集的文本目标时。左短边顶点qi、qj沿长边方向向内分别移动li、lj,新的两个顶点与原短边顶点qi、qj包围的区域便是左短边区域。如图 2(d)所示,q0沿

本方法是基于直接回归的文本检测方法,所以设计损失函数时参考了其他同类的方法[13-15]。本方法损失函数为:

| $ L=L_{\mathrm{cls}}+L_{\mathrm{reg}} $ | (2) |

| $ L_{\mathrm{cls}}=\alpha_{1} L_{\mathrm{m}_{-} \mathrm{cls}}+L_{1_{-} \mathrm{cls}}+L_{\mathrm{r}_{-} \mathrm{cls}} $ | (3) |

| $ L_{\mathrm{reg}}=L_{1_{-} \mathrm{\mathrm{reg}}}+L_{\mathrm{r}_{-} \mathrm{\mathrm{reg}}} $ | (4) |

式中:L为最后总损失; Lcls为3类区域的分类损失和; Lreg为短边区域顶点回归损失和; Lm_cls、Ll_cls、Lr_cls分别为中间区域、左短边区域及右短边区域的像素分类损失; Ll_reg为左短边顶点回归损失; Lr_reg为右短边顶点回归损失。由于中间区域起着确定文本实例的作用,相对更加重要,实验中其分类损失权重α1设置为4。

在自然场景图像中,文本区域往往只占很小一部分,如果分类损失函数使用交叉熵类型的损失函数,很可能由于正负样本不平衡,导致最后分类结果倾向于背景。本方法采用D(dice coefficient)函数[19]作为分类的损失函数,分类损失为:

| $ L_{\mathrm{cls}}=\alpha_{1} D\left(\boldsymbol{P}_{\mathrm{m}}, \boldsymbol{G}_{\mathrm{m}}\right)+D\left(\boldsymbol{P}_{1}, \boldsymbol{G}_{1}\right)+D\left(\boldsymbol{P}_{\mathrm{r}}, \boldsymbol{G}_{\mathrm{r}}\right) $ | (5) |

| $ D(\boldsymbol{P}, \boldsymbol{G})=1-\frac{2 \sum\limits_{x, y} P_{x, y} \times G_{x, y}}{\sum\limits_{x, y} P_{x, y}+\sum\limits_{x, y} G_{x, y}} $ | (6) |

式中: Pm、Pl、Pr分别为中间区域、左短边区域、右短边区域的分类得分预测值; Gm、Gl、Gr为分类得分真实值; Px, y、Gx, y分别为点(x, y)分类得分的预测值与真实值。

假设

| $ \Delta x_{i}^{k}=x_{k}-x_{i} $ | (7) |

| $ \Delta y_{i}^{k}=y_{k}-y_{i} $ | (8) |

式中:

| $ L_{\mathrm{l}_{-} \mathrm{reg}} =\sum\limits_{k=1}^{N_{1}} \sum\limits_{i \in\left\{l_{1}^{*}, l_{2}^{*} \right\}} \sum\limits_{c \in C_{i}^{k}} \frac{f(c-\hat{c})}{4 \times l_{i} \times N_{\mathrm{l}}} $ | (9) |

| $ L_{\mathrm{r}_{-} \mathrm{reg}} =\sum\limits_{k=1}^{N_{\mathrm{r}}} \sum\limits_{i \in\left\{r_{1}^{*}, r_{2}^{*} \right\}} \sum\limits_{c \in C_{t}^{k}} \frac{f(c-\hat{c})}{4 \times l_{i} \times N_{\mathrm{r}}} $ | (10) |

| $ f(x)=\left\{\begin{array}{l} 0.5 x^{2},|x|<1 \\ |x|-0.5,|x| \geqslant 1 \end{array}\right. $ | (11) |

式中:ĉ为网络预测的坐标差值; c为坐标差的真实值; i为四边形顶点索引; li作为一个归一化项; li为式(1)计算得到的顶点qi的参考长度,加入归一化项能使模型对目标的尺度不敏感; Nl、Nr分别为左短边区域、右短边区域所有点的数量; f为smooth L1[2]损失函数。

1.4 后处理从网络的输出中不能直接得到文本区域的检测结果,还需要进行后处理才能得到完整的结果。对于点(x, y),用Sm、Sl、Sr分别表示该点属于文本中间区域、左短边区域、右短边区域的分类得分。Tm、Tl、Tr分别表示中间区域、左短边区域、右短边区域的分类阈值。当Sm>Tm,Sl<Tl,Sr<Tr时,称点(x, y)为有效中间区域点,这类点连接形成的区域称为有效中间区域,当Sm>Tm,Sl≥Tl时,称该点为有效左短边区域点,这类点连接形成的区域称为有效左短边区域,当Sm>Tm,Sr≥Tr时,称该点为有效右短边区域点,这类点形成的区域称为有效右短边区域。舍弃其他短边区域点的原因在于密集的文本实例的短边区域可能存在误连接的情况,容易导致文本边界顶点预测不准确。

整个后处理的流程如图 3(a)所示,具体如下:

|

图 3 后处理流程图及中间结果示例 Fig. 3 Flowchart of post process and illustration of intermediate results |

1) 寻找有效区域。遍历所有的像素点,找到所有的有效中间区域、有效左短边区域及有效右短边区域,分别如图 3(c)中蓝色、绿色、红色区域所示。同时记录下各有效区域的相邻区域。当某个有效区域的点与其他有效区域的点相邻或重叠时,则这两个有效区域相邻,如图 3(d)所示。

2) 确定文本实例及其边界顶点。遍历所有的有效中间区域,当该有效中间区域相邻的有效左短边区域、有效右短边区域数目均不小于1时,则3种区域共同构成一个文本实例。若相邻的有效短边区域数大于1,只选最大的有效短边区域。遍历所有的有效左短边区域,当该有效左短边区域相邻的有效中间区域数为0,相邻的有效右短边区域数大于0时,则两种短边区域同样构成一个文本实例。在确定文本实例后,综合计算左、右短边顶点坐标,计算方式为

| $ x=\frac{\sum\limits_{i=1}^{n} s_{i} \times x_{i}}{\sum\limits_{i=1}^{n} s_{i}} $ | (12) |

式中:xi为由单个有效短边区域点预测的短边顶点坐标;si为该有效短边区域点的短边区域分类得分;n为该短边区域有效点数;x为最后综合计算的短边顶点坐标结果。

3) 去除重复。当同一个连通区域内有多个重叠的检测结果,去除面积较小的。

2 实验比较与分析为了验证本文方法的效果,本文将在常用的3个公开的自然场景文本检测数据集及一个长文本数据集上进行测试比较。

2.1 数据集与评价指标1) 长文本数据集。根据主观经验,当一个文本实例长边与短边之比大于7时,认为该文本实例为长文本。从MLT数据集[20]中选取742张含有长文本实例的图片作为长文本数据集。该数据集的文本实例均为英文。该数据集均为测试集。

2) MSRA-TD 500[21]。MSRA-TD 500包含500张图片,其中训练集有300张,测试集有200张。该数据集包含中文与英文两种类型文本,标注的目标为文本行,标注的类型为旋转矩形。该数据集中的文本具有大小变化剧烈、长宽比变化剧烈、多方向的特点。该数据集中含长文本的图像占40%,长文本实例占总文本实例的27.3%。

3) ICDAR 2015[22]。该数据集来自于ICDAR 2015鲁棒阅读竞赛。该数据集包含1 500张图片,训练集有1 000张,剩余的500张为测试集。该数据集包含的文本为英文,文本实例标注是英文单词的边界四边形。与MSRA-TD 500相比,该数据集的文本同样具有多方向的特点,但大小、长宽比变化相对较小。该数据集中长文本实例只占1.5%。

4) ICDAR 2013[23]。该数据集一共有462张图片,训练集有229张,测试集有233张。该数据集的文本为英文,对每一个词进行标注,标注类型为轴向矩形。其中长文本实例占6%。

当一个文本实例的检测结果与真实目标交占比大于0.5时,该检测结果被认为是正确的检测结果,否则为一个错误的检测结果。文本检测的评价指标有3个,召回率(r, recall),准确率(p, precision),综合得分(f, f-score),其计算方式为:

| $ r=\frac{|\mathrm{TP}|}{|\mathrm{GT}|} $ | (13) |

| $ p=\frac{|\mathrm{TP}|}{|\mathrm{DT}|} $ | (14) |

| $ f=\frac{2 \times r \times p}{p+r} $ | (15) |

式中:| TP |为正确的检测结果数目; | GT |为真实的文本实例数目; | DT |为检测结果数。

2.2 实验实施细节由于各个数据集训练集规模都较小,本方法参考了多种文本检测方法[6, 8-9, 13-14, 24-28]通过加入其他数据与仿射变换的方式增大训练数据量,提高模型的泛化能力。HUST-TR 400数据集是使用文本行标注,与方法[6, 13-14, 25-27]一样,将该数据集加入到MSRA-TD 500训练集中。参考方法[8-9, 13-14, 24-28],在ICDAR 2013训练集中加入其他训练样本,将部分MLT数据集加入到ICDAR 2013训练集中。本方法使用缩放、旋转、随机截取3种方式进行数据扩充。对于ICDAR 2013与ICDAR 2015训练集,在保持长宽比不变的条件下,图片长边被随机缩放到[640, 2 560]之间。然后在[-10°, 10°]之间随机旋转图像。最后随机截取512×512大小的图像块作为训练样本。对于MSRA-TD 500数据集,图片长边被随机缩放到为原始长度的[0.5, 2.0]倍,最后随机截取1 024×512的图像块作为训练样本。

本方法使用Adam[29]作为网络训练优化器,学习率设置为0.000 1。使用多步调整为学习率调整策略,每经过10 000次迭代,学习率衰减为原来的0.94倍。使用在ImageNet[30]上预训练的Resnet 50模型初始化本网络中特征提取部分的模型参数,其余新加入层的参数使用符合均值为0,方差为0.01的高斯分布的随机数进行初始化。

在测试时,将3类区域的分类阈值均设置为0.9。实验的硬件环境是Intel Core 7700 CPU,16 GB RAM,Nvidia GTX 1080显卡,操作系统为Ubuntu 16.04。

2.3 结果及分析表 1为各方法在长文本数据集上测试结果。表中各方法均是在ICDAR 2015训练集上进行训练,在长文本数据集上进行测试。由于训练集与测试集存在一定差异,所以总体指标数据均不高。但是本方法在准确率与召回率均高于其他方法,综合得分至少高于其他方法5%。这充分表明了本方法在长文本检测方面的优势。

| 表 1 各方法在长文本数据集中测试结果比较 Tab. 1 Comparison of performances of different methods on long text dataset |

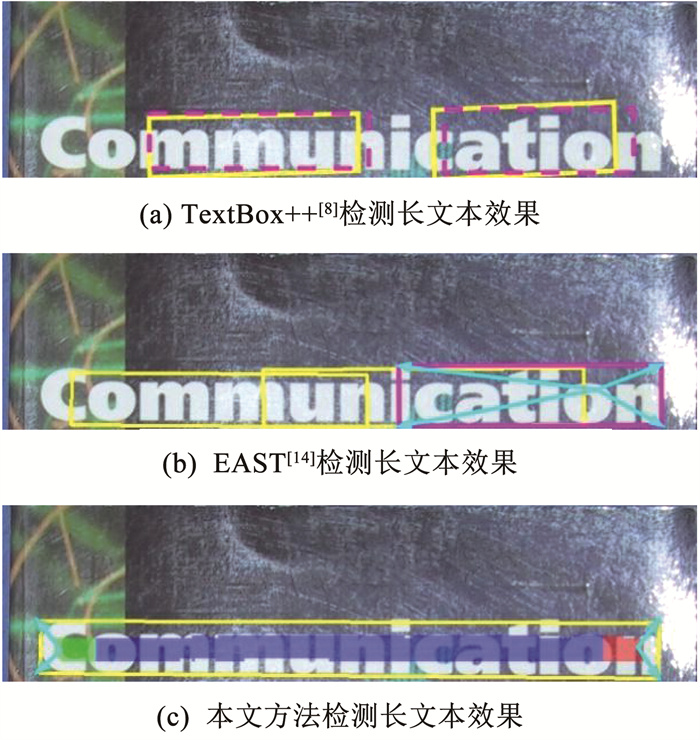

图 4(a)、(b)分别是一种间接回归方法TextBox++[8]与一种直接回归方法EAST[14]检测一个较长文本的效果示例。图 4(a)中品红色的虚线框为预设框,黄色框为最后检测结果,TextBox++[8]只能检测到长文本的一部分。图 4(b)中品红色的四边形是EAST[14]在文本区域中右侧某像素点处预测的检测结果。该点距离文本区域的左侧边界较远,由于该点处的感受野不足导致其预测结果中左侧两个顶点的定位精度非常差,而该点距离右侧边界较近,右侧边界定位较为准确。

|

图 4 长文本测试结果比较示例 Fig. 4 Illustration of comparison of long text test results |

图 4(c)为本文方法检测长文本结果,其中黄色框为最后检测结果,绿色、红色及蓝色区域分别为文本左短边区域、右短边区域及文本中间区域,左短边区域内像素点只预测文本左短边的两个顶点,右短边区域内的点只预测右短边的两个顶点。与其他两种方法比较,在预测文本边界框顶点时,本文方法只需要关注文本短边附近一小块区域,而不用关注整个文本区域,对网络的感受野要求较低。所以在检测长文本时,本文方法检测精度要明显优于预测整个文本边界的方法。

表 2为各方法在MSRA-TD 500数据集上测试结果,其中其他方法的结果来自各自的文献。本方法在MSRA-TD 500测试集上分别使用了单尺度与多尺度图像进行测试,单尺度图像长宽被缩放为原图像的0.6倍,多尺度图像分别被缩放为原来的0.25、0.50、1.00倍。表 2中一些方法的准确率高于本方法的原因在于它们牺牲了一定的召回率。本方法最高综合得分为82.66%, 高于文献[27]中的1%。MSRA-TD 500数据集检测目标是文本行,其中含有许多长文本。表 2的结果再次表明了本方法在长文本检测方面的有效性。

| 表 2 各方法在MSRA-TD 500数据集中测试结果比较 Tab. 2 Comparison of performances of different methods on MSRA-TD 500 |

表 3所示为各方法在ICDAR 2015数据集上的测试结果比较,其中其他方法的结果来自各自的文献。本方法测试图像大小为1 728×972。从表 3数据可以看到,虽然文献[27]准确率高于本方法,但其召回率较低,所以综合性能落后于本方法。与综合得分为第2的方法RRD[26]相比,本方法的综合得分为85.44%,高于其1.6%。

| 表 3 各方法在ICDAR 2015数据集中测试结果比较 Tab. 3 Comparison of performances of different methods on ICDAR 2015 |

表 4所示为多种方法在ICDAR 2013数据集上的测试结果,其中其他方法的结果来自各自的文献。本方法在测试之前,将一些过大的图像缩小为原来的0.5倍。本方法单尺度测试图像大小基本为原图像大小。而多尺度测试时,对于较小的图像,所使用的尺度为0.5、1.0、2.0,对于较大的图像,所使用的尺度为0.25、0.50、1.00。不同于表 4中一些方法,本方法能在获得较高准确率的同时,获得高召回率,所以本方法综合得分能达到90.1%,超过了表 4中其他所有方法。

| 表 4 各方法在ICDAR 2013数据集中测试结果比较 Tab. 4 Comparison of performances of different methods on ICDAR 2013 |

ICDAR 2015数据集、ICDAR 2013数据集的检测目标为词,长文本实例数目不多。相比于文本行,词相对较短,而本方法在这两个数据集上的效果依然超过了目前绝大部分方法。原因在于:1)词通常是以多个密集出现,短边区域能够将密集的文本实例分离开,缩小的中间区域能防止相邻的文本实例误连接; 2)不再直接预测整个文本边界,短边区域内的像素点只预测与之邻近的短边的顶点,这样的任务相对更简单,所以能更精准地预测文本边界顶点。

图 5为本方法在各个数据集上的单尺度测试的一些结果样例。1~4行分别为长文本数据集、MSRA-TD 500数据集、ICDAR 2015、ICDAR 2013数据集测试样例结果。

|

图 5 本方法的测试结果样例 Fig. 5 Samples of test results of the proposed method |

表 5所示为各方法运行速度测试结果。基本上所有基于深度学习的检测方法测试过程都可分为两阶段,网络前向推理阶段与后处理阶段,其中网络前向推理阶段占大部分时间开销,测试图像的大小对速度有直接的影响。各方法测试时,图像大小与实验设备平台不一样。

| 表 5 各方法速度比较 Tab. 5 Speed comparison of different methods |

表 5列出了每种方法测试的图像大小与使用的GPU。在测试图像大小相近的条件下,EAST[14]只比本方法稍快一点,然而其测试所用GPU设备性能要大大强于本方法。本方法能够如此快速,原因在于: 1)本方法网络为单阶段的全卷积网络; 2)网络输出结果边长为原图的1/4,这不仅减少了特征融合部分的卷积运算量,还降低了后处理的运算量。

3 结论1) 针对长文本难以有效检测的问题,本文提出了一种全新的短边顶点回归网络。本方法分割出文本的中间区域、左短边区域、右短边区域,左、右短边区域的点预测各自短边的顶点,再利用区域的相邻关系将两种短边区域连接组合起来,便可得到精确完整的文本检测结果。

2) 在长文本数据集,MSRA-TD 500, ICDAR 2015及ICDAR 2013文本检测数据集上的实验测试结果表明本方法高速有效。

3) 本方法目前主要适用于直线文本,在未来的工作中,将研究如何改善本方法使其具有更强的泛化能力。

| [1] |

LIU Li, OUYANG Wanli, WANG Xiaogang, et al. Deep learning for generic object detection: A survey[J]. International Journal of Computer Vision, 2020, 128: 261. DOI:10.1007/s11263-019-01247-4 |

| [2] |

REN Shaoqing, HE Kaiming, GIRSHICK R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137. DOI:10.1109/TPAMI.2016.2577031 |

| [3] |

LIU Wei, ANGUELOV D, ERHAN D, et al. SSD: Single shot multibox detector[C]//European Conference on Computer Vision. Cham: Springer, 2016: 21. DOI: 10.1007/978-3-319-46448-0_2

|

| [4] |

LIAO Minghui, SHI Baoguang, BAI Xiang, et al. Textboxes: A fast text detector with a single deep neural network[C]//Proceedings of the Thirty-First AAAI Conference on Artificial Intelligence. San Francisco: AAAI Press, 2017: 4161

|

| [5] |

ZHONG Zhuoyao, JIN Lianwen, ZHANG Shuangping, et al. Deeptext: A unified framework for text proposal generation and text detection in natural images[C]//Proceedings of the IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). New Orleans: IEEE, 2017. DOI: 10.1109/ICASSP.2017.7952348

|

| [6] |

MA Jianqi, SHAO Weiyuan, YE Hao, et al. Arbitrary-oriented scene text detection via rotation proposals[J]. IEEE Transactions on Multimedia, 2018, 20(11): 3111. DOI:10.1109/TMM.2018.2818020 |

| [7] |

LIU Yuliang, JIN Lianwen. Deep matching prior network: Toward tighter multi-oriented text detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017: 1962. DOI: 10.1109/CVPR.2017.368

|

| [8] |

LIAO Minghui, SHI Baoguang, BAI Xiang. Textboxes++: A single-shot oriented scene text detector[J]. IEEE Transactions on Image Processing, 2018, 27(8): 3676. DOI:10.1109/TIP.2018.2825107 |

| [9] |

JIANG Yingying, ZHU Xiangyu, WANG Xiaobing, et al. R2CNN: Rotational region CNN for orientation robust scene text detection[EB/OL]. (2015-06-30). https://arxiv.org/abs/1706.09579

|

| [10] |

ZHU Yixing, DU Jun. Sliding line point regression for shape robust scene text detection[C]//Proceedings of the 24th International Conference on Pattern Recognition. Beijing: IEEE, 2018: 3735. DOI: 10.1109/ICPR.2018.8545067

|

| [11] |

HUANG Lichao, YANG Yi, DENG Yafeng, et al. Densebox: Unifying landmark localization with end to end object detection[EB/OL]. (2015-09-19). https://arxiv.org/abs/1509.04874

|

| [12] |

SHELHAMER E, LONG J, DARRELL T. Fully convolutional networks for semantic segmentation[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2017, 39(4): 640. DOI:10.1109/TPAMI.2016.2572683 |

| [13] |

HE Wenhao, ZHANG Xuyao, YIN Fei, et al. Deep direct regression for multi-oriented scene text detection[C]//Proceedings of the IEEE International Conference on Computer Vision. Venice: IEEE, 2017: 745. DOI: 10.1109/ICCV.2017.87

|

| [14] |

ZHOU Xinyu, YAO Cong, WEN He, et al. EAST: An efficient and accurate scene text detector[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017: 2642. DOI: 10.1109/CVPR.2017.283f

|

| [15] |

XUE Chuhui, LU Shijian, Zhan Fangneng. Accurate scene text detection through border semantics awareness and bootstrapping[C]//Proceedings of the European Conference on Computer Vision. Cham: Springer, 2018: 355. DOI: 10.1007/978-3-030-01270-0_22

|

| [16] |

HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016: 770. DOI: 10.1109/CVPR.2016.90

|

| [17] |

SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[EB/OL]. (2015-04-10). https://arxiv.org/abs/1409.1556

|

| [18] |

RONNEBERGER O, FISCHER P, BROX T. U-net: Convolutional networks for biomedical image segmentation[C]//International Conference on Medical Image Computing and Computer-Assisted Intervention. Berlin: Springer, 2015: 234. DOI: 10.1007/978-3-662-54345-0_3

|

| [19] |

MILLETARI F, NAVAB N, AHMADI S A. V-net: Fully convolutional neural networks for volumetric medical image segmentation[C]//Proceedings of the 4th International Conference on 3D Vision. Stanford: IEEE, 2016: 565. DOI: 10.1109/3DV.2016.79

|

| [20] |

NAYEF N, YIN Fei, BIZID I, et al. Icdar2017 robust reading challenge on multi-lingual scene text detection and script identification-RRC-MLT[C]//Proceedings of the 14th IAPR International Conference on Document Analysis and Recognition. Kyoto: IEEE, 2017: 1454. DOI: 10.1109/ICDAR.2017.237

|

| [21] |

YAO Cong, BAI Xiang, LIU Wenyu, et al. Detecting texts of arbitrary orientations in natural images[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Providence: IEEE, 2012: 1083. DOI: 10.1109/CVPR.2012.6247787

|

| [22] |

KARATZAS D, GOMEZ-BIGORDA L, NICOLAOU A, et al. ICDAR 2015 competition on robust reading[C]//Proceedings of the 13th International Conference on Document Analysis and Recognition. Tunis: IEEE, 2015: 1156. DOI: 10.1109/ICDAR.2015.7333942

|

| [23] |

PRATIKAKIS I, GATOS B, NTIROGIANNIS K. ICDAR 2013 document image binarization contest (DIBCO 2013)[C]//Proceedings of the 12th International Conference on Document Analysis and Recognition. Washington DC: IEEE, 2013: 1471. DOI: 10.1109/ICDAR.2013.219

|

| [24] |

DENG Dan, LIU Haifeng, LI Xuelong, et al. Pixellink: Detecting scene text via instance segmentation[C]//Thirty-Second AAAI Conference on Artificial Intelligence. New Orleans: AAAI, 2018: 6773

|

| [25] |

SHI Baoguang, BAI Xiang, BELONGIE S. Detecting oriented text in natural images by linking segments[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017: 3482. DOI: 10.1109/CVPR.2017.371

|

| [26] |

LIAO Minghui, ZHU Zhen, SHI Baoguang, et al. Rotation-sensitive regression for oriented scene text detection[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 5909. DOI: 10.1109/CVPR.2018.00619

|

| [27] |

LYU P, YAO Cong, WU Wenao, et al. Multi-oriented scene text detection via corner localization and region segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 7553. DOI: 10.1109/CVPR.2018.00788

|

| [28] |

TIAN Zhi, HUANG Weilin, HE Tong, et al. Detecting text in natural image with connectionist text proposal network[C]//European Conference on Computer Vision. Cham: Springer, 2016: 56. DOI: 10.1007/978-3-319-46484-8_4

|

| [29] |

KINGMA D P, BA J L. Adam: A method for stochastic optimization[EB/OL]. (2014-12-22). https://arxiv.org/abs/1412.6980

|

| [30] |

DENG Jia, DONG Wei, SOCHER R, et al. Imagenet: A large-scale hierarchical image database[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Miami: IEEE, 2009: 248. DOI: 10.1109/CVPR.2009.5206848

|

2021, Vol. 53

2021, Vol. 53