2. 天津大学 建筑学院,天津 300072;

3. 天津市建筑物理环境与生态技术重点实验室(天津大学),天津 300072

2. School of Architecture, Tianjin University, Tianjin 300072, China;

3. Tianjin Key Laboratory of Architectural Physical Environment and Ecological Technologies (Tianjin University), Tianjin 300072, China

建筑的天然采光性能、室内风环境、室内温湿度分布等是评价室内环境品质的重要指标,同时也对建筑节能优化具有非常重要的意义。在设计方案初期,通常会考虑建筑形体、朝向、各朝向窗墙比等建筑特征对于采光性能、室内风环境、室内温湿度等因素的影响[1-2]。近年来,随着计算机技术的不断发展,建筑性能模拟仿真在建筑设计各阶段的应用愈加广泛,设计师可以根据建筑室内风速风向、采光均匀度、采光系数等量化指标不断对设计方案进行优化[3]。由于单次仿真计算所需时间与网格划分精度、建筑体型复杂程度等因素呈正相关,在设计初期的大量方案寻优过程中往往会消耗大量时间。为此,部分研究人员也提出了基于新型仿真计算模型的建筑性能快速预测方法。文献[4]通过增加算力,采用并行计算方法来减少Radiance的计算时间;文献[5]采取累计替换的方式,统计天空气象数据中各个面单元的全年累计分布,并在此基础上计算对各个建筑网格的贡献量;文献[6]通过引入Kriging地理统计学技术,选用离散观测值进行随机插值,使Radiance的计算速率提升50%以上;文献[7]以矩形平面为例,综合考虑朝向、窗墙比透射率等建筑特征以及不同房间照明需求,提出了一套基于数学模型的采光性能快速预测方法。

同时,随着机器学习技术的发展,深度学习逐渐应用于复杂多变量场景下的数据预测及特征分析任务中,建筑性能预测、形体自动生成等已经成为机器学习在建筑设计领域的潜在应用热点[8]。部分研究人员开始训练针对建筑性能预测的深度学习代理模型,多项研究表明,在建筑性能预测时采用深度学习进行端到端的特征学习可以取得较为准确的模拟结果,并可以显著提高设计效率[9]:文献[10]将BP神经网络作为替代模型进行快速预测,以建筑实测数据作为样本集对模型进行训练,通过输入尺寸、时间以及天气因素等变量得出照度预测结果。文献[11]使用TRNSYS创建案例数据库,以外窗位置及尺寸、墙厚、供暖温度、供冷温度、相对湿度、新风量作为输入来训练人工神经网络(artificial neural network, ANN),并以此预测热舒适和能耗指标。文献[12]利用MARS灵敏度方法确定影响建筑能耗的主要参数为供暖温度、新风量、外墙传热系数和渗透率,并以此作为输入量生成ES代理模型,并利用ES模型来量化输入参数对建筑能耗的影响程度。

上述代理模型在对能耗、采光系数等“单值型”建筑性能数据的预测中取得了良好的效果,但对于照度云图、温湿度场等“矩阵型”数据(即云图),由于其输出端数据维度高、数据间存在相对位置关系,BP神经网络等代理模型预测效果并不佳。因此,亟需一种可进行建筑云图性能数据预测生成的代理模型训练方法。生成式对抗网络(generative adversarial network,GAN)的提出为该问题的解决提供了可能。文献[13]基于生成式对抗网络提出了条件生成式对抗网络模型(conditional generative adversarial network,CGAN),而作为深度学习模型的一种,CGAN模型被广泛应用于图像学习领域[14-17],文献[18]基于CGAN模型提出了pix2pix算法以解决图像映射问题。在建筑领域,文献[19]利用CGAN网络模型取代原有的分析软件来预测风速热力图,进而快速实现基于性能的迭代式设计方法;文献[20]基于GAN网络模型提出了一种已建成建筑窗墙比快速计算方法,神经网络会对输入的真实建筑立面中的墙体和窗体进行自动划分;文献[21]利用CGAN网络模型来自动生成卫星图像、手绘建筑草图及建筑平面功能分区图;文献[22]提出了一种基于CGAN的居住区强排方案设计方法,通过输入建筑轮廓得到强排设计方案总平图。

综上,针对建筑设计初期的方案比选及设计迭代过程,本文提出了一种基于深度学习的建筑矩阵型数据快速预测方法,搭建了相应的代理模型。该方法通过基于CGAN模型的pix2pix算法来获得建筑平面图所对应的风速场云图、采光云图等矩阵型数据,大幅减少逐一枚举的仿真用时消耗,为建筑师提供了一种方便快捷的建筑物理指标预测思路,提高决策优化效率。同时也提出了一套可用于该类型代理模型评价的方法体系,以检验代理模型的计算准确度。

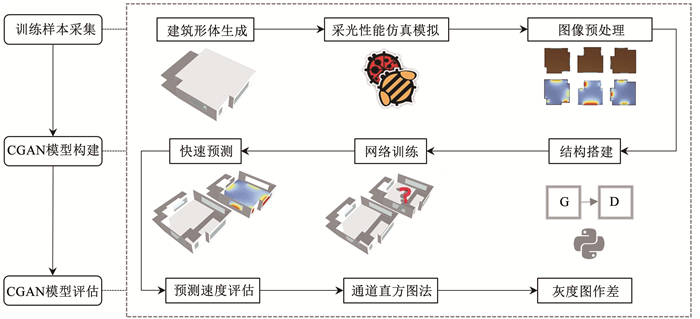

1 基于CGAN的代理模型本研究使用建筑平面图替代了传统预测模型中的数据特征变量,利用pix2pix算法将建筑轮廓图以及对应的照度云图、风速场云图等作为训练样本,使神经网络学习从建筑轮廓图到性能云图之间的映射,从而对指定建筑平面的性能进行快速预测。该预测方法主要包括训练样本采集、CGAN模型构建以及预测模型评估等步骤,适用于建筑中各类矩阵型数据(云图类)的预测,其具体工作流程见图 1。训练后的CGAN模型可以实现输入建筑平面图,快速输出对应的性能预测云图。

|

图 1 基于条件生成式对抗网络(CGAN)的建筑性能预测流程图 Fig. 1 Flow chart of prediction method of building performance based on CGAN |

为保证CGAN模型具有一定的普适性和较高的准确性,样本集中应包含足够数量的建筑形体,且建筑平面应具有较大的差异性和多样性,尽可能的涵盖各种平面类型。本研究仅以小型单个房间为例,采用基于形状语法的生成逻辑进行建筑形体生成,并通过Radiance仿真模拟生成对应的照度云图,通过blueCFD仿真模拟生成对应的风速场云图。而对于面积更大、体型更为复杂的大型建筑,只要提供足够数量的建筑平面及其对应的数据云图作为训练样本,如图 1所示的预测方法及流程同样适用。

由于本文研究重点在于验证基于建筑平面的预测方法的可行性,故在合理范围内对模型进行简化,建筑平面布局示意图见图 2,其具体生成逻辑如下:

|

图 2 建筑形体生成流程示意 Fig. 2 Flow chart of building model generation |

1) 在Rhino & Grasshopper建模软件中绘制12×12的正方形网格,每个网格边长均为1 m;

2) 规定网格4个角点区域为待裁剪区域,区域大小均为4×4,图 2中深色区域;

3) 随机选定一个或多个待裁剪区域进行网格裁剪,各个区域裁剪的网格数量由对应的伪随机生成的4行2列矩阵决定。

4) 完成裁剪后,对网格平面推拉成体,随机选取若干个建筑立面并在该立面上以平面缩放命令生成窗,窗墙比大小在[0, 1)之间随机取值。

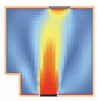

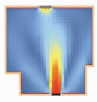

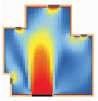

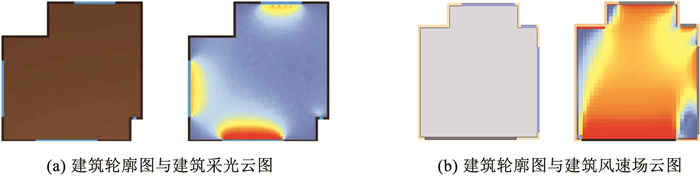

选用Grasshopper作为建模平台,按照上述生成逻辑随机生成2 000个建筑平面作为模拟数据库,之后利用插件Ladybug和Butterfly分别对不同的建筑形体进行采光性能计算和风速场仿真计算,气象数据来源于EnergyPlus官方网站中的天气文件数据库,模拟参数设置详见表 1及表 2。最后,将各建筑轮廓图及仿真计算得到的照度云图和风速场云图按相同比例合并导出,并编制python程序进行后处理:将所有样本像素设置为256×256,并选取其中70%作为训练集,20%作为验证集,其余10%作为测试集,部分模拟结果见图 3。

| 表 1 Radiance仿真参数设置 Tab. 1 Parameter settings of Radiance |

| 表 2 blueCFD仿真参数设置 Tab. 2 Parameter settings of blueCFD |

|

图 3 建筑轮廓与建筑性能云图 Fig. 3 Building outline and cloud map of building performance |

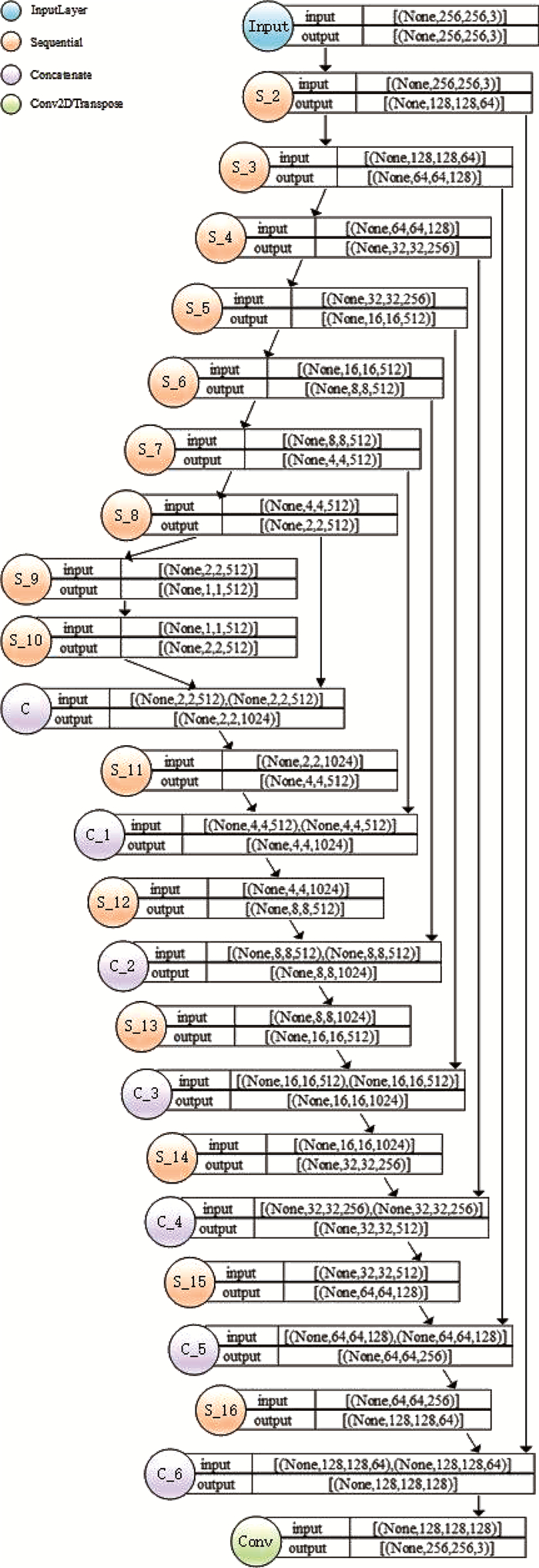

建筑采光CGAN模型包含生成器G与判别器D两部分,其中生成器G的输入端为建筑轮廓图,输出端为建筑采光云图。在实现建筑轮廓图到照度云图的映射过程中,一方面输入图像与输出图像结构基本相同,图像翻译过程中输入与输出结果的低层信息可以共享;另一方面图像位置相对固定,偏移量较少,对网络的平移不变性要求相应较低。所以生成器采用U-Net架构,通过跳层连接(skip-connections)使得不同分辨率条件下低层的细节信息被保留,进而实现训练过程中该部分信息的直接传输,每层均采用convolution-BatchNorm-ReLU的方式进行搭建。整个生成器通过卷积层作为编码器进行下采样,反卷积层作为解码器进行上采样,其网络架构见图 4。

|

图 4 生成器网络结构图 Fig. 4 Network structure of generator |

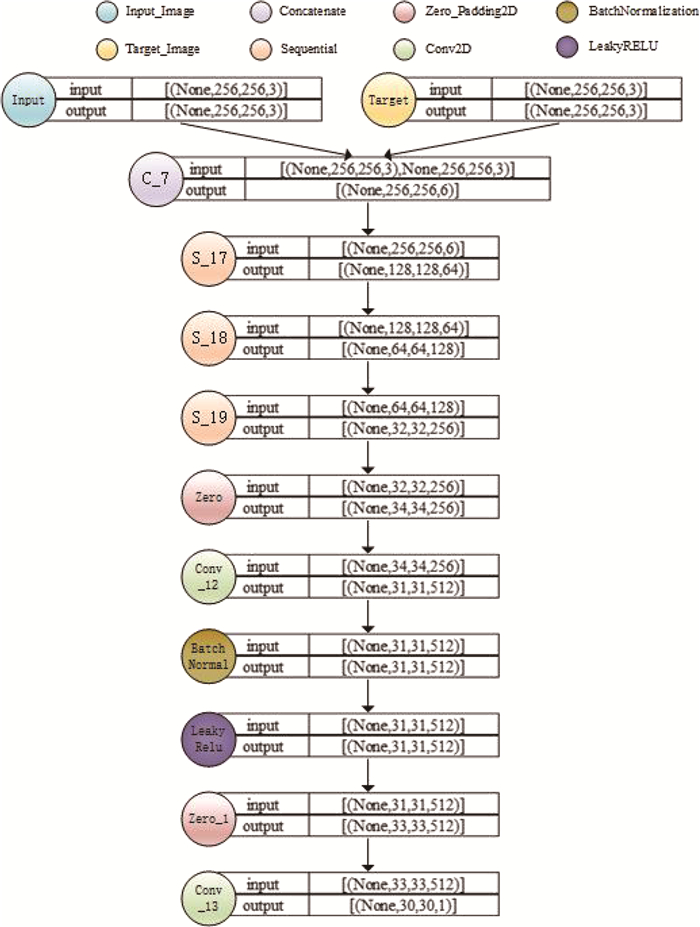

对于判别器而言,其输入端同时包括建筑轮廓图以及与之对应的建筑采光云图,选用PatchGAN对输入图像的每个区域都输出一个预测概率值,并对图像中独立patches的“真伪”进行分类,其网络架构见图 5。根据pix2pix算法原理,优化目标包含2个部分,即损失函数由两部分构成,其中一部分为CGAN损失函数,另一部分为L1损失函数。其中L1损失函数用来约束生成图像和真实图像之间的差异,同时减少生成图像的模糊,进而增加生成照度云图的准确度,最终建筑采光CGAN模型的损失函数为

| $ G^{*}=\arg \min\limits _{G} \max\limits _{D} L_{\mathrm{CGAN}}(G, D)+\lambda L_{{\mathrm{L}} 1}(G) $ | (1) |

|

图 5 判别器网络结构图 Fig. 5 Network structure of discriminator |

其中,

| $ L_{\mathrm{CGAN}}(G, D)=E_{x, y}[\log D(x, y)]+\\E_{x, y}[\log (1-D(x, G(x))] $ | (2) |

| $ L_{{\mathrm{L}} 1}(G)=E_{x, y}\left[\|y-G(x)\|_{1}\right] $ | (3) |

式中:G为建筑采光生成器;D为建筑采光判别器;x为建筑轮廓图;y为仿真得到的照度云图;G(x)为生成器生成的照度云图;λ为权重值。

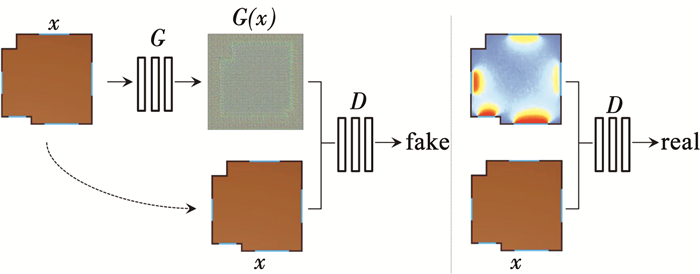

本研究基于TensorFlow深度学习框架,通过交互式编辑工具Pycharm构建建筑采光CGAN模型,以建筑轮廓图作为输入端,以采光云图作为输出端,算法原理见图 6。模型训练参数采用pix2pix算法中的默认参数设置,实验运行环境为Intel(R) Xeon(R) W-2123 8核,16 GB RAM内存,64位Windows 10操作系统,GPU为NVIDIA Quadro P1000。

|

图 6 算法原理流程图 Fig. 6 Algorithm flow chart |

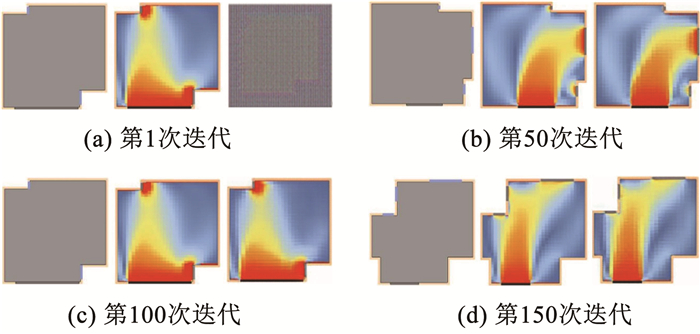

文献[18]的研究表明:在基于pix2pix算法进行图像预测过程中,当迭代次数设置为200次时,CGAN模型已经可以生成与真实图像相似度较高的预测结果。因此,本研究在预训练过程中将迭代次数分别设置为200、150以及80,相应的模型训练耗时分别为5 d 12 h 38 min 53 s、4 d 3 h 1 min 12 s、2 d 5 h 3 min 48 s。因为输入端与输出端图像结构相似度较高,当迭代次数为80次时已经可以生成准确度较高的照度云图,综合考虑预测图像精度与时间成本,最终将迭代次数设置为150次。整个训练过程共包含训练集1 400张,图 7分别为迭代1次、50次、100次、150次的训练结果,训练进行到30代后,模型已能产生相似度较高的预测结果。

|

图 7 建筑采光CGAN模型各迭代次数下的测试结果 Fig. 7 Test results of CGAN model of lighting under different iterations |

建筑风速场CGAN模型同样包含生成器G与判别器D两部分,其中生成器G的输入端为建筑轮廓图,输出端为建筑风速场云图。其生成逻辑与1.2节中建筑采光CGAN模型相同。

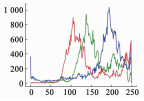

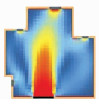

对于风速场云图来说,其输入端与输出端的图像结构也是类似的,迭代次数在80次后也可生成准确度较高的风速场云图,故最终迭代次数也设置为150次,图 8分别为迭代1次、50次、100次、150次的训练结果。

|

图 8 风速场云图CGAN模型各迭代次数下的测试结果 Fig. 8 Test results of CGAN model of wind field under different iterations |

为评价预测效率,首先基于Radiance和blueCFD对200份建筑样本进行采光和风场性能模拟,结果显示低精度模式下平均每个样本计算时间为14.8 s。之后利用CGAN模型对200份建筑样本进行照度和风速预测,整个预测过程共耗时362 s,平均每个样本计算时间约为0.9 s,即采用CGAN模型可大幅提升预测效率。

为进一步评估预测效果,引入图像质量评估指标并构建一套质量评估体系将预测结果与软件仿真结果的相似程度进行量化,即采用通道直方图法和灰度值法分别进行比较分析。

2.1 通道直方图法直方图相似度算法是比较图片相似度经常使用的方法。首先对两张图像进行直方图数据采集,之后分别对采集的直方图进行归一化处理,最后再利用巴氏系数算法对直方图数据进行计算,进而求得图像相似度。巴氏系数计算公式为

| $ \rho\left(p, p^{\prime}\right)=\sum\limits _{i=1}^{N} \sqrt{p(i) p^{\prime}(i)} $ | (4) |

式中p、p′分别代表两张图像的图像直方图数据,对每个相同i的相同数据点乘积开平方以后相加得到的结果即为图像相似度值(巴氏系数因子值),其范围为[0, 1],越接近于1表示越相似。

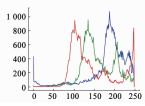

本研究采用灰度直方图及三通道直方图算法进行相似度比较,其中灰度直方图是灰度级的函数,表示图像中每种灰度级像素的个数,反映图像中每种灰度出现的频率,其横坐标是灰度级,纵坐标为像素个数;三通道直方图是把RGB通道图像分解为多个单通道图像,并分别计算其直方图数据,最终再进行相似度的计算。部分三通道验证结果见表 3。

| 表 3 相似度对比结果(直方图法) Tab. 3 Similarity comparison results (channel histogram method) |

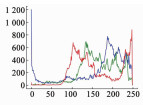

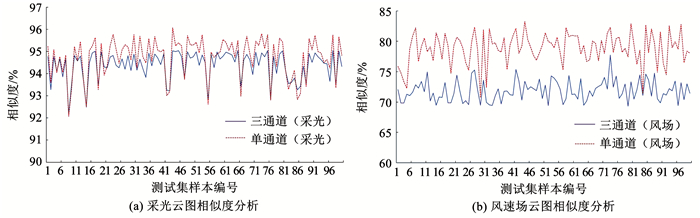

本研究分别对200份测试集样本进行相似度分析,结果见图 9。对于采光预测结果来说,三通道直方图算法所得相似度平均值为94.95%,单通道直方图算法所得相似度平均值为95.43%,表明预测结果与Radiance计算结果高度吻合;对于风速预测结果来说,三通道直方图算法所得相似度平均值为71.88%,单通道直方图算法所得相似度平均值为78.84%,表明预测结果与blueCFD计算结果吻合度较高,证明CGAN模型对于采光和风速场的预测具有较高的准确性。

|

图 9 相似度分析结果(通道直方图法) Fig. 9 Similarity analysis results (channel histogram method) |

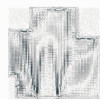

采用灰度值法对预测结果准确性进行进一步验证。对CGAN预测图像与计算图像分别进行灰度化处理并提取各个像素点的灰度值进行相减,之后基于灰度值差值的绝对值绘制灰度图相减结果(以255减去绝对值的结果作为各像素点着色值)。所有像素点灰度值之差的算术平均值即为整张图像的灰度差值,差值越小,表明图像相似度越高,即预测结果越准确。

本文的200份采光测试样本平均灰度值误差为5.95,平均准确率为93.82%,其预测结果与仿真计算结果高度吻合;200份风速场测试样本平均灰度值误差为8.81,平均准确率为82.99%。虽然风速场预测准确率较采光预测低10.83%,但在一定误差范围内仍满足使用需求,部分验证结果见表 4。

| 表 4 相似度对比结果(灰度值法) Tab. 4 Similarity comparison results (grayscale value method) |

由于风速场的动态模拟过程更为复杂,更易出现结果不收敛的问题,因此代理模型对该类型数据的预测难度更大,进而导致CGAN模型在风速场预测中的精确度要稍低于采光预测,但仍可达到70%以上的相似度,且相对差异难以被人眼区分。由于本文研究是为建筑师在设计初期提供快速辅助,因此认为在该模型精度下可满足在该阶段的设计要求,能为设计师提供决策辅助。

3 结论本文提出了一种基于条件生成式对抗网络(CGAN)的室内建筑物理性能指标预测方法,通过学习一定条件下的图像分布规律,预测不同建筑轮廓图下所对应的照度、风速场分布。同时,本文建立了基于计算机图形学原理的评价体系,将预测结果与软件仿真结果进行了对比,探讨了通过建筑平面图进行性能快速预测的可行性,主要结论如下:

1) 本研究基于pix2pix算法构建的建筑性能CGAN模型在迭代150次后能够输出稳定的室内工作面性能云图。通道直方图法验证结果显示采光云图平均相似度高达94.95%,风速场云图平均相似度为78.84%。灰度值法验证结果显示采光云图平均灰度值误差为5.95,风速场云图平均灰度值误差为8.81,均在5%的允许误差范围内,平均准确率分别为93.82%,82.99%。虽然风速场的预测相似度低于采光预测,但预测的趋势都与仿真结果完全相同,在视觉上差异性不大。因此,两项验证结果均证明模型预测图像与仿真计算图像吻合度高,该方法具有一定的可行性。

2) 训练后的建筑CGAN模型可在1 s内生成计算面性能云图,显著提高了预测效率,可以满足建筑师对大量设计方案进行快速筛选或优化调整的需求,为建筑师提供了一种新的性能预测思路。

| [1] |

ECHENAGUCIA T M, CAPOZZOLI A, CASCONE A, et al. The early design stage of a building envelope: multi-objective search through heating, cooling and lighting energy performance analysis[J]. Applied Energy, 2015, 154: 577. DOI:10.1016/j.apenergy.2015.04.090 |

| [2] |

TURRIN M, BUELOW P V, STOUFFS R. Design explorations of performance driven geometry in architectural design using parametric modeling and genetic algorithms[J]. Advanced Engineering Informatics, 2011, 25(4): 656. DOI:10.1016/j.aei.2011.07.009 |

| [3] |

李紫微. 方案初期办公建筑节能和天然采光模拟优化方法研究[D]. 北京: 清华大学, 2018 LI Ziwei. Research on office building energy performance and daylight performance simulation optimization method for early design stage[D]. Beijing: Tsinghua University, 2018. DOI: 10.27266/d.cnki.gqhau.2018.000190 |

| [4] |

ZUO Wangda, MCNEIL A, WETTER M, et al. Acceleration of the matrix multiplication of radiance three phase daylighting simulations with parallel computing on heterogeneous hardware of personal computer[J]. Journal of Building Performance Simulation, 2013, 7(2): 152. DOI:10.1080/19401493.2013.795193 |

| [5] |

ROBINSON D, STONE A. Irradiation modelling made simple: the cumulative sky approach and its applications[C]//Proceedings of the 21st Conference on Passive and Low Energy Architecture. Eindhoven: [s. n. ], 2004: 19

|

| [6] |

YI Y K. Adaptation of Kriging in daylight modeling for energy simulation[J]. Energy and Buildings, 2016, 111: 479. DOI:10.1016/j.enbuild.2015.11.036 |

| [7] |

LO VERSO V R M, PELLEGRINO A. A multivariate non-linear regression model to predict the energy demand for lighting in rooms with different architectural features and lighting control systems[J]. Energy and Buildings, 2014, 76: 151. DOI:10.1016/j.enbuild.2014.02.063 |

| [8] |

马辰龙, 朱姝妍, 王明洁. 机器学习技术在建筑设计中的应用研究[J]. 南方建筑, 2021(2): 121. MA Chenlong, ZHU Shuyan, WANG Mingjie. Applied research of machine learning technique in architectural design[J]. South Architecture, 2021(2): 121. DOI:10.3969/j.issn.1000-0232.2021.02.121 |

| [9] |

GUO Xiaoxiao, LI Wei, LORIO F. Convolutional neural networks for steady flow approximation[C]//Proceedings of the 22nd ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. New York: Association for Computing Machinery, 2016: 481. DOI: 10.1145/2939672.2939738

|

| [10] |

KAZANASMAZ T, GVNAYDIN M, BINOL S. Artificial neural networks to predict daylight illuminance in office buildings[J]. Building and Environment, 2009, 44(8): 1751. DOI:10.1016/j.buildenv.2008.11.012 |

| [11] |

MAGNIER L, HAGHIGHAT F. Multiobjective optimization of building design using TRNSYS simulations, genetic algorithm, and Artificial Neural Network[J]. Building and Environment, 2010, 45(3): 739. DOI:10.1016/j.buildenv.2009.08.016 |

| [12] |

TIAN Wei, CHOUDHARY R. A probabilistic energy model for non-domestic building sectors applied to analysis of school buildings in greater London[J]. Energy and Buildings, 2012, 54: 1. DOI:10.1016/j.enbuild.2012.06.031 |

| [13] |

MIRZA M, OSINDERO S. Conditional generative adversarial nets[Z]. ArXiv: 1411. 1784v1, 2014

|

| [14] |

梁培俊, 刘怡俊. 基于条件生成对抗网络的漫画手绘图上色方法[J]. 计算机应用研究, 2019, 36(1): 308. LIANG Peijun, LIU Yijun. Colorization of manga sketch based on conditional generative adversarial networks[J]. Application Research of Computers, 2019, 36(1): 308. DOI:10.19734/j.issn.1001-3695.2017.07.0891 |

| [15] |

刘玉杰, 窦长红, 赵其鲁, 等. 基于条件生成对抗网络的手绘图像检索[J]. 计算机辅助设计与图形学学报, 2017, 29(12): 2336. LIU Yujie, DOU Changhong, ZHAO Qilu, et al. Sketch based image retrieval with conditional generative adversarial network[J]. Journal of Computer-Aided Design & Computer Graphics, 2017, 29(12): 2336. DOI:10.3724/SP.J.1089.2017.16596 |

| [16] |

NGUYEN V, VICENTE T F Y, ZHAO Maozheng, et al. Shadow detection with conditional generative adversarial networks[C]//Proceedings of 2017 IEEE International Conference on Computer Vision (ICCV). Venice: IEEE, 2017: 4520. DOI: 10.1109/ICCV.2017.483

|

| [17] |

ZHANG He, SINDAGI V, PATEL V M. Image de-raining using a conditional generative adversarial network[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2020, 30(11): 3943. DOI:10.1109/TCSVT.2019.2920407 |

| [18] |

ISOLA P, ZHU Junyan, ZHOU Tinghui, et al. Image-to-image translation with conditional adversarial networks[C]//Proceedings of 2017 IEEE Conference on Computer Vision & Pattern Recognition (CVPR). Honolulu: IEEE, 2017: 1126. DOI: 10.1109/CVPR.2017.632

|

| [19] |

MOKHTAR S, SOJKA A, DAVILA C C, et al. Conditional generative adversarial networks for pedestrian wind flow approximation[C]//Proceedings of the 11th annual Symposium on Simulation for Architecture and Urban Design (SimAUD). San Diego: Society for Computer Simulation International, 2020: 25

|

| [20] |

SHI Xing, WANG Chao, WANG Meng, et al. An innovative approach to determine building window-to-wall ratios for urban energy simulation[C]//Proceedings of the 11th annual Symposium on Simulation for Architecture and Urban Design (SimAUD). San Diego: Society for Computer Simulation International, 2020: 63

|

| [21] |

ZHENG Hao, HUANG Weixin. Understanding and visualizing generative adversarial networks in architectural drawings[C]//Proceedings of the 23rd International Conference on Computer Aided Architectural Design Research in Asia. Beijing: CAADRIA, 2018: 1

|

| [22] |

孙澄, 丛欣宇, 韩昀松. 基于CGAN的居住区强排方案生成设计方法[J]. 哈尔滨工业大学学报, 2021, 53(2): 111. SUN Cheng, CONG Xinyu, HAN Yunsong. Generative design method of forced layout in residential area based on CGAN[J]. Journal of Harbin Institute of Technology, 2021, 53(2): 111. DOI:10.11918/201912143 |

2022, Vol. 54

2022, Vol. 54