2. 中国船舶工业系统工程研究院,北京 100094

2. Systems Engineering Research Institute of CSSC, Beijing 100094, China

随着无人装备的发展以及人工智能技术的兴起,无人集群系统成为当今各国武器装备的发展热点[1],但无人集群对抗领域中无人集群的应用也导致战场态势信息更加繁杂,极大增加了态势感知的难度。在无人集群对抗中,对集群阵型和集群运动趋势等集群态势要素的识别是进一步实现意图判断和决策制定的前提,准确识别集群态势要素,才能进一步认知集群态势,实现准确有效的无人集群对抗智能决策[2],对于无人机集群、无人艇集群等现代战争场景具有至关重要的意义。

为准确识别态势信息,国内、外学者进行了大量的研究。传统的态势识别技术采用了贝叶斯网络[3]、模板匹配[4-5]、专家系统[6]等方法,但面对复杂的无人集群对抗环境,传统的态势识别技术很难从繁杂的集群态势信息中快速准确地识别集群态势要素,因此需要采取更加智能有效的方法来实现无人集群对抗态势要素识别[7]。

人工智能技术的快速发展为复杂数据的处理提供了新方法,深度学习正逐渐被应用于态势识别问题。文献[8]提出了一种基于模糊推理方法的空中目标态势识别特征表示方法。文献[9]提出一种基于径向基神经网络的目标意图识别模型。文献[10]设计了基于深度神经网络的作战识别模型,使用深度神经网络自主学习得到特征状态与意图之间的联系,提高了模型识别效果。文献[8-10]提出的方法都是针对于单个目标的态势感知方法,主要工作集中在对于态势特征和态势分类结果的设计与处理,并应用了一种现有方法(模糊推理、径向基神经网络、深度BP网络等)实现态势分类,缺少对所使用的现有方法的分析与改进。文献[11]使用深度Q网络模型算法作为无人机决策模型,以产生空战时序数据,再基于随机森林模型获取影响空战态势较为本质的特征表达,但也没有对深度Q网络模型进行深入分析和针对性改进。文献[12]使用栈式自编码器提取深层次的战场态势特征,并分析了网络深度对算法性能的影响,但在应用栈式自编码器算法时也未与特定领域相结合,只是将栈式自编码器作为一个通用特征提取方法使用。文献[13]面向多单元态势感知问题,先采用K-均值聚类算法对单元态势信息进行聚类,然后使用由深度学习模型构建的算法架构实现态势理解,但是简单地使用聚类方法对多单元态势信息进行处理,无法有选择性地考虑各单元间的态势关联关系,可能使得关键的态势信息被掩盖。

现有的态势感知方法在应用深度学习方法时,大多只是将深度学习神经网络作为一个黑盒模块使用,缺少对于深度学习方法的深入理解与分析,也很少根据实际应用领域对深度学习神经网络进行相应改进。在将深度学习方法应用到无人集群对抗问题上时,应当结合问题特点改进深度学习方法,充分发挥深度学习方法的能力。在无人集群对抗问题中,多单位多维度时序态势信息相互混合,形成繁杂的无人集群态势信息,使得态势要素识别难度显著提升,但现有的态势感知方法很少针对此问题进行研究,大都只是对所有态势信息进行统一处理,这就将明显提升集群态势要素识别的难度。所以,本文考虑引入注意力机制,在处理集群态势信息时,选择性地关注更重要的信息,降低集群态势信息的复杂程度,提升集群态势感知方法的性能。

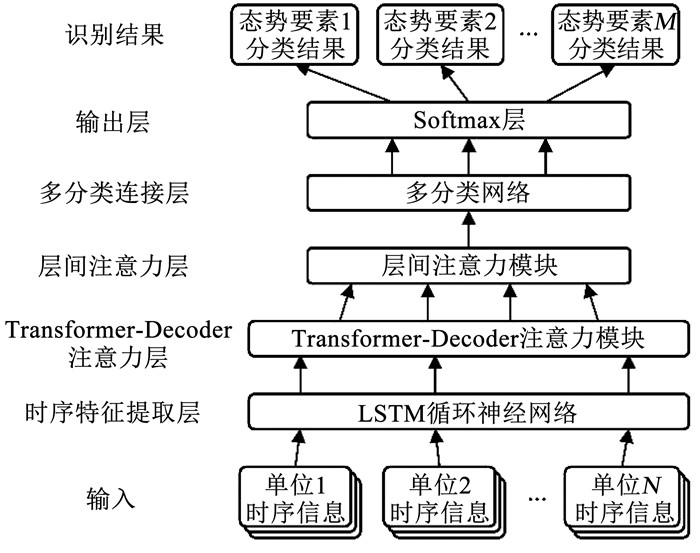

基于上述分析, 为解决对于复杂无人集群对抗态势的态势要素识别问题,实现对于集群态势要素的正确识别分类,本文提出了一种利用Transformer的无人集群对抗态势要素识别方法。首先,利用LSTM循环神经网络将集群态势序列信息编码成态势时序特征,压缩集群态势信息中的时间维度,有效精简集群态势信息;其次,为能有效挖掘和处理集群中多单位态势信息之间的内在关联关系,基于Transformer中的decoder模块设计Transformer-Decoder注意力模块,并设计层间注意力结构以进一步改进其增强特征表达能力,使用改进后的Transformer-Decoder注意力模块对时序特征信息进行处理,提取综合高阶态势信息;然后将综合高阶态势信息输入到多分类网络中,结合softmax层实现对于多类态势要素的分类。最后,与基线方法对比,通过实验仿真验证本文所提出模型的性能。

1 态势认知概念定义及表征在无人集群识别、对抗、情报分析等领域,对集群阵型和集群运动趋势等集群态势要素的准确识别是十分重要的,集群态势要素识别是进一步实现集群作战意图识别的必要前提,集群态势要素识别是否准确将会很大程度上影响集群意图判断和智能决策,进而影响无人集群战场的胜负走向,因此集群态势要素的准确识别对现代无人集群对抗作战至关重要。

为更准确地把握本文的研究内容及研究界限,在综合考虑不同文献中对有关概念解释情况的基础上,本文对相关概念进行定义。

态势认知就是将当前战场的目标信息进行组织分析,将战场目标的运动特点以及相互关系等进行相互关联,从整体出发预测未来的活动动向,并对敌方的兵力配置、作战使命与核心意图做出判断,进而对整体战场局势的变化进行预测。无人集群在执行各类任务时,集群中各单位的整体行动一般不会是杂乱无章的,集群会保持一定形态协同行动,集群中各单位在进行相对运动时也会遵循一定规律。

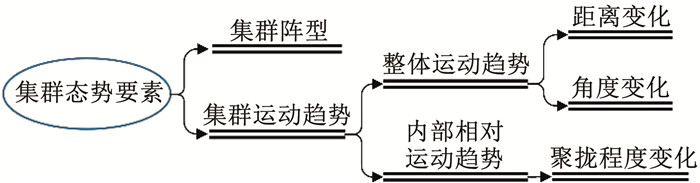

在此基础上,本文把集群态势认知的对象定义为集群阵型和集群运动趋势两大类集群态势要素,集群阵型表征的是集群中各个实体相互间的位置关系的约束关系,而集群运动趋势则表征的是在这种位置约束关系下各个实体位置的总体变化趋势。其中,集群运动趋势又可分为集群整体运动趋势和内部相对运动趋势,集群整体运动趋势表征的是集群中各个实体位置变化趋势中相同或相似的成分,而内部相对运动趋势表征的是集群中各个实体位置变化趋势中不同的成分。本文以目标集群相对于观测主体的距离变化和角度变化共同定义集群整体运动趋势,以目标集群的聚拢程度变化定义内部相对运动趋势。

本文将集群阵型、距离变化、角度变化和聚拢程度变化等4类因素定义为集群态势要素,共同表征集群的总体状态,如图 1所示。本文提出的方法以水面无人艇场景为假定场景,接下来以假定场景为基础,对集群阵型、距离变化、角度变化和聚拢程度变化4类态势要素分别进行详细的定义。

|

图 1 集群态势要素分类 Fig. 1 Classification of swarm situation elements |

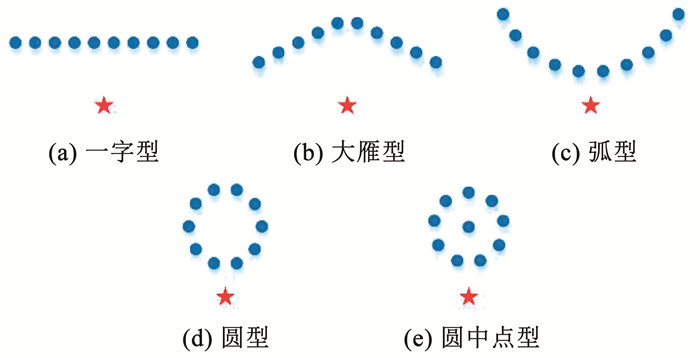

在本文的研究中,集群阵型态势要素共定义了5种状态,分别为一字型、大雁型、弧型、圆型、圆中点型,如图 2所示。一字型集群阵型表征为集群中所有实体排列为一条直线;大雁型集群阵型表征为集群均分为两部分,分别排列为两条形成一定夹角的直线;弧型集群阵型表征为集群中所有实体排列为一个半圆弧;圆型集群阵型表征为集群中所有实体排列为一整个圆形;圆中点型阵型表征为一个实体处于中心,其余实体围绕该实体排列为一个圆形。

|

图 2 集群阵型态势要素 Fig. 2 Swarm formation situation elements |

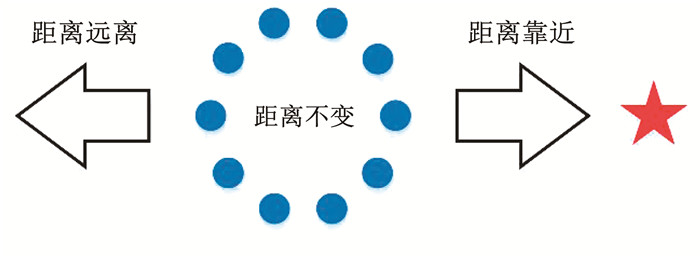

距离变化态势要素分别定义了3种状态,即:距离靠近、距离远离、距离不变,如图 3所示。距离靠近表示目标集群整体向观测主体移动,表征为集群中所有实体与观测主体的平均距离减小;距离远离表示目标集群整体向观测主体方向的反方向移动,表征为集群中所有实体与观测主体的平均距离增加;距离不变表示目标集群整体没有明显的靠近或远离观测主体的趋势,表征为集群中所有实体与观测主体的平均距离基本保持不变。

|

图 3 距离变化态势要素 Fig. 3 Distance variation situation elements |

角度变化态势要素分别定义了3种状态,即:角度顺时针变化、角度逆时针变化、角度不变,如图 4所示。角度顺时针变化表示目标集群整体相对于观测主体的顺时针方向移动,表征为集群中所有实体在以观测主体为中心的极坐标下的平均方位角增大;角度逆时针变化表示目标集群整体相对于观测主体的逆时针方向移动,表征为集群中所有实体在以观测主体为中心的极坐标下的平均方位角减小;角度不变表示目标集群整体相对于观测主体的方位没有明显变化,表征为集群中所有实体在以观测主体为中心的极坐标下的平均方位角基本保持不变。

|

图 4 角度变化态势要素 Fig. 4 Angular variation situation elements |

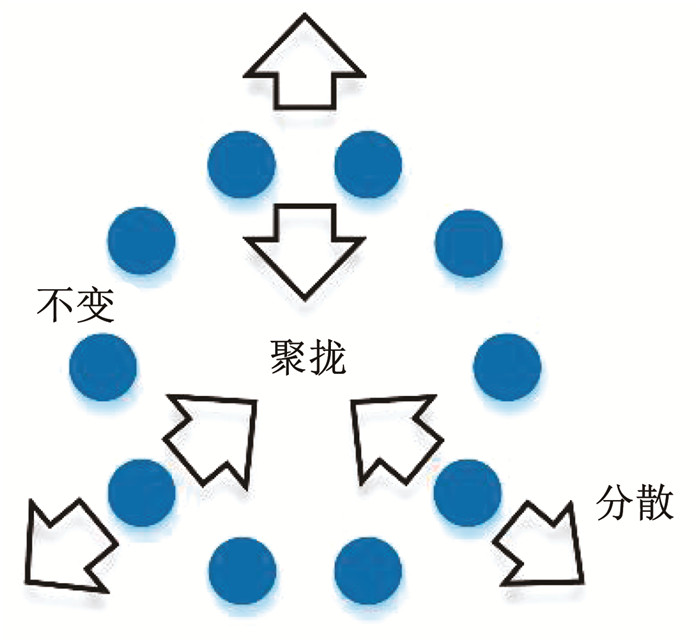

聚拢程度变化态势要素分别定义了3种状态,即:聚拢、分散、聚拢程度不变,如图 5所示。聚拢表示目标集群向阵型中心收拢,表征为集群中所有实体与阵型中心的平均距离减小;分散表示目标集群向阵型中心方向的反方向扩张,表征为集群中所有实体与阵型中心的平均距离增大;聚拢程度不变表示目标集群向阵型中心收拢,表征为集群中所有实体与阵型中心的平均距离减小。

|

图 5 聚拢程度变化态势要素 Fig. 5 Gather degree variation situation elements |

本文提出一种利用Transformer和层间注意力的无人集群对抗态势要素识别方法,核心为层间注意力Transformer模型(Intel-layer attention transformer, IAT),基于Transformer模型中decoder模块的结构,设计了可应用于无人集群对抗态势要素识别的Transformer-Decoder注意力层模型,能够有效处理复杂的无人集群态势信息。还针对Transformer网络结构中对信息利用不充分的问题设计了层间注意力结构,进一步改进Transformer-Decoder注意力层模型并提升模型的特征表达能力,进一步提高无人集群态势要素识别准确率。

首先,利用LSTM循环神经网络将集群态势序列信息中各单位的时序态势信息分别编码为各单位的态势时序特征,压缩无人集群态势信息中的时间维度信息,实现对复杂无人集群态势信息的有效精简;其次,为能有效挖掘和处理集群中多单位态势信息之间的内在关联关系,基于Transformer中的decoder模块设计Transformer-Decoder注意力模块,并设计层间注意力结构以改进增强Transformer-Decoder注意力模块的特征表达能力,使用改进后的Transformer-Decoder注意力模块对集群的时序特征信息进行处理,有效提取综合高阶态势信息;然后将综合高阶态势信息输入到多分类网络中,结合softmax层实现对于多类态势要素的同时分类,实现无人集群对抗态势要素识别。

利用层间注意力和Transformer的集群态势要素识别方法主要包括:时序特征提取层、Transformer-Decoder注意力层、层间注意力层、多分类连接层、输出层。如图 6所示为本文提出方法的模型框架图。

|

图 6 集群态势要素识别模型框架 Fig. 6 Model framework of swarm situation elements recognition |

原始态势序列信息中包含多时刻多单位的多维态势信息,态势信息结构复杂,神经网络模块无法直接有效地处理多时刻多单位态势信息,为能够有效表征集群中多单位之间的态势信息内在关系,需要对原始态势信息进行时序维度上的预处理。

循环神经网络(Recurrent neural network, RNN)将循环结构引入神经网络中,使得RNN可以处理时序相关的数据,但对于距离较远的循环节点,RNN会出现梯度消失和梯度爆炸的问题。为解决此类问题,长短时记忆网络LSTM被提出[14],其利用特殊的门机制在一定程度上缓解了梯度消失和梯度爆炸的问题。

本文使用LSTM循环神经网络模块对原始态势序列信息的时间维度进行降维处理并提取时序态势向量表达,将集群中各单元的态势信息并行输入LSTM时序特征提取层进行计算。其中,处理不同单元的信息所使用的模块是网络结构完全相同的多个LSTM网络模块,这些模块共享参数。这种并行结构使得LSTM时序特征提取层可以学习同时适用于不同单位的时序特征映射空间,并随着集群规模的增加,具备能够加速学习的优点。

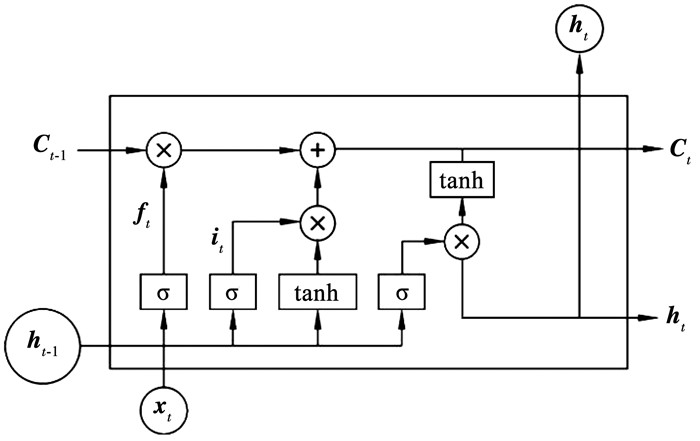

LSTM结构的核心在于细胞状态,其类似于一个信息传送带,能够在水平方向上传递信息,传送带上的信息分别经过LSTM的输入门、遗忘门和输出门,通过记忆或遗忘的方式选择性地进行处理,如图 7所示。

|

图 7 LSTM神经网络模型 Fig. 7 LSTM neural network model |

遗忘门决定对细胞状态的遗忘选择,遗忘门公式为

| $ \boldsymbol{f}_t=\sigma\left(\boldsymbol{W}_f\left[\boldsymbol{h}_{t-1}, \boldsymbol{x}_t\right]+\boldsymbol{b}_f\right) $ | (1) |

式中:ft为遗忘门,σ为sigmoid函数,ht-1为前一个细胞的输出值,xt为当前细胞的输入值。

输入门决定细胞状态的输入选择以及对输入信息进行处理,输入门公式为:

| $ \boldsymbol{i}_t=\sigma\left(\boldsymbol{W}_i\left[\boldsymbol{h}_{t-1}, \boldsymbol{x}_t\right]+\boldsymbol{b}_i\right) $ | (2) |

| $ \widetilde{\boldsymbol{C}}_t=\tanh \left(\boldsymbol{W}_c\left[\boldsymbol{h}_{t-1}, \boldsymbol{x}_t\right]+\boldsymbol{b}_c\right) $ | (3) |

式中tanh为双曲正切激活函数。

把遗忘门和输入门得到的信息相结合,可以得到新的细胞状态为

| $ C_t=f_t \cdot C_{t-1}+i_t \cdot \widetilde{C}_t $ | (4) |

输出门决定细胞状态的输出选择以及对输出信息进行处理,输出门公式为:

| $ \boldsymbol{O}_t=\sigma\left(\boldsymbol{W}_o\left[\boldsymbol{h}_{t-1}, \boldsymbol{x}_t\right]+\boldsymbol{b}_o\right) $ | (5) |

| $ \boldsymbol{h}_t=\boldsymbol{O}_t \cdot \tanh \left(\boldsymbol{C}_t\right) $ | (6) |

式中ht即为当前细胞的输出值。

2.2 Transformer-Decoder注意力层在集群态势识别问题中,目标数量的增加导致了态势信息规模的显著增加,这使得集群态势信息的处理难度急剧上升。在复杂多变的集群态势信息中,每个单位的态势信息应与其他单位相关,但依据各单位间的关联程度的不同,态势信息的相关程度也有所不同;所以观测主体在评估集群态势时,应当适当舍弃相对而言不重要的集群单位的态势信息,更关注于有利于态势评估的集群单位。因此,有效筛选和整合集群中各单元的态势信息是一个至关重要的问题。

注意力(Attention)机制[15]近几年被广泛使用在图像处理、语音识别、自然语言处理等各个领域中,注意力机制模拟了人对于事物投入注意力的特点,对不同的处理区域分配不同的权重,能够对于重要内容投入更多的注意力,对次要或无关的内容减少关注,这样差异化的分配能够有效提高了信息提取的效率。

基于注意力机制,Google于2017年提出了Transformer模型[16],使用注意力机制构造出编码器- 解码器(Encoder-Decoder)框架。由于具有强大的信息压缩能力和相关特征捕获能力,在机器翻译、预训练语言模型、文本摘要等语言理解任务中表现出色。

Transformer模型的特性适用于对复杂信息进行筛选和整合,其主要思想是通过注意力机制提取语句中各单词之间的关联关系,通过筛选和融合相关单词的语义信息,实现更准确可靠的语句层次语义理解。但Transformer模型的框架基于自然语言处理模型,需要编码部分和解码部分两个部分的输入,并且适用于有顺序关系的单元信息处理,整体网络框架与集群态势感知问题并不适配。因此,本文在深入理解与分析Transformer模型的基础上,改进并设计一种可应用于集群态势识别问题的类Transformer模型,使其可接受单部分输入和无顺序关系的单元信息输入,可以通过注意力机制提取集群中各单元之间的关联关系,筛选和融合相关单元的态势信息,实现更准确有效的集群态势感知。

为解决集群单元态势信息的筛选和整合问题,本文基于Transformer模型提出Transformer-Decoder注意力层模型。Transformer-Decoder注意力层模型能够动态地关注有助于集群态势感知的部分集群单元态势信息,能够从复杂的集群态势信息中选择出对于态势感知更加关键的信息,Transformer-Decoder注意力层的结构基于注意力模型,并在其基础上进一步实现了注意力模型的深度堆叠和并行计算,使得模型能够表达更高阶的注意力关系,并提升了计算速度。

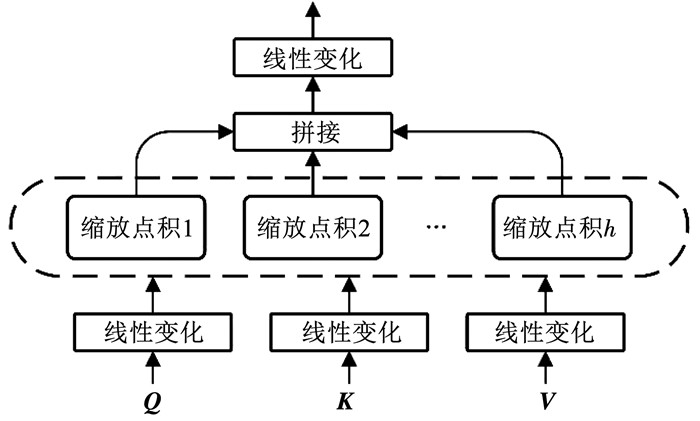

Transformer由编码器和解码器组成,其中解码器主要包含两种子层,分别是基于注意力机制的多头注意力层和前馈网络层,其中每个子层都还加入了残差网络和归一化层。基于这种思想,本文的Transformer-Decoder注意力层由多个注意力单元堆叠而成,如图 8所示,其中每个注意力单元都由一个多头注意力层、一个归一化层和残差连接组成,结构如图 9所示。多头注意力层中的多头注意力模型是由h个缩放点积注意力(Scaled dot-product attention) 单元组成。

|

图 8 Transformer-Decoder注意力层结构 Fig. 8 Transformer-Decoder attention layer structure |

|

图 9 注意力单元结构 Fig. 9 Attention unit structure |

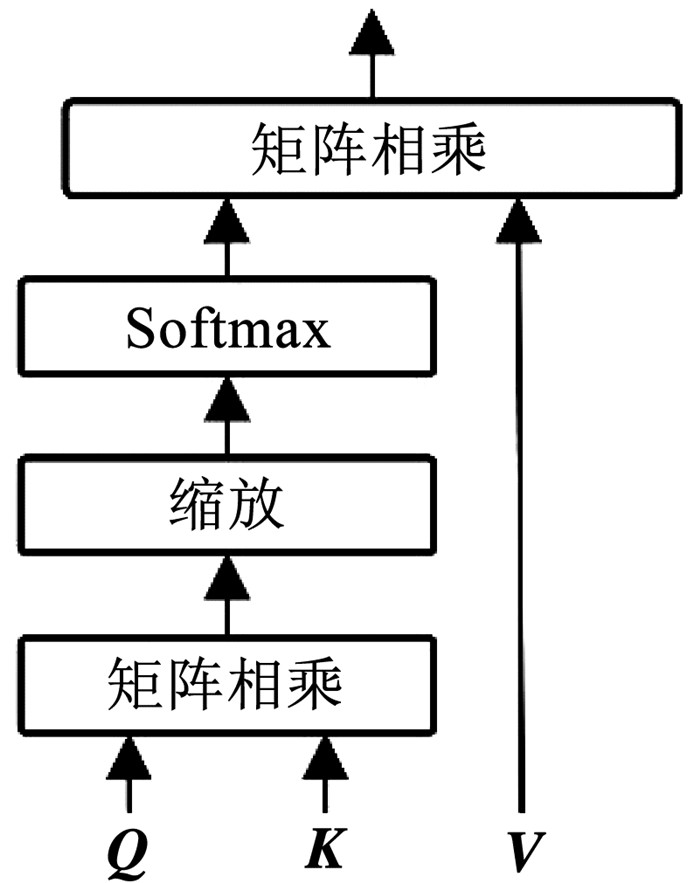

缩放点积注意力结构如图 10所示,其使用点积的形式进行相似度计算,并除以

|

图 10 缩放点积注意力结构 Fig. 10 Scaled dot-product attention structure |

缩放点积注意力的计算公式为

| $ \operatorname{Attention}(\boldsymbol{Q}, \boldsymbol{K}, \boldsymbol{V})=\operatorname{softmax}\left(\frac{\boldsymbol{Q} \boldsymbol{K}^{\mathrm{T}}}{\sqrt{d_k}}\right) \boldsymbol{V} $ | (7) |

多头注意力结构即对矩阵Q、K和V使用不同的线性变换,转换为不同的矩阵,使用h个缩放点积单元进行计算,然后将h个缩放点积单元的计算结果拼接起来,最后通过一个线性映射输出, 如图 11所示。这样的好处是使得模型具备了在不同的表示子空间里学习特征信息的能力。

|

图 11 多头注意力结构 Fig. 11 Multi-head attention structure |

多头注意力的计算公式为:

| $ \boldsymbol{H}_i=\text { Attention }\left(\boldsymbol{Q} \boldsymbol{W}_i^Q, \boldsymbol{K} \boldsymbol{W}_i^K, \boldsymbol{V} \boldsymbol{W}_i^V\right) $ | (8) |

| $ \operatorname{MultiHead}(\boldsymbol{Q}, \boldsymbol{K}, \boldsymbol{V})=\operatorname{Concat}\left(\boldsymbol{H}_1, \cdots, \boldsymbol{H}_h\right) \boldsymbol{W}^0 $ | (9) |

输入值X经过多头注意力计算后得到输出值M,增加残差连接和归一化层,表达式为

| $ \boldsymbol{L}=\text { layernorm }(\boldsymbol{M}+\boldsymbol{X}) $ | (10) |

在原Transformer结构中,多头注意力层和前馈层组成一个解码单元,多个解码单元堆叠形成解码器,对于每个解码单元中的多头注意力层,其输入值中的key和value都是不变的,只有query值在堆叠中会发生改变,相当于在每一个多头注意力层中,注意力客体是相同的,只是不同的注意力主体对其进行注意力感知,因此每个多头注意力层的输出具有一定的并行特性。而原Transformer结构只使用了最后一层输出,虽然其通过残差结构把每一层的输出累加到了下一层,但不断的累加也会弱化每一层学习到的有效表达,降低网络的整体性能。因此,本文考虑提取各多头注意力层的输出,以多层综合注意力输出代替最后一层解码单元的输出,更合理地利用每一层学习到的有效表达。

本文提出层间注意力机制改进Transformer-Decoder注意力层结构,有效利用各注意力子层的输出,如图 12所示。考虑到如果只是单纯拼接各层的输出值,会随层数增多而增加网络计算负担,并且会降低网络的通用性,因此本文把各层注意力单元的输出值进行堆叠并使用多头注意力层进行处理,依据当前态势有选择性地关注于更重要的输出值,以获得集群的综合高阶态势信息。

|

图 12 改进的Transformer解码层结构 Fig. 12 Improved Transformer-Decoder layer structure |

结合Transformer-Decoder注意力层的结构,式(10)可以重写为

| $ \boldsymbol{L}_i=\text { layernorm }\left(\text { MultiHead }\left(\boldsymbol{Q}_i, \boldsymbol{K}, \boldsymbol{V}\right)+\boldsymbol{Q}_i\right) $ | (11) |

式中: K = V为全部单位时序态势信息,Li为第i层Transformer单元提取到的高阶态势信息,也是下一层注意力计算的Q输入。

原Transformer-Decoder注意力层结构只将最后一层信息Ln传递给了后续网络,没有充分利用多层结构中每层输出的有效信息,层间注意力机制综合考虑每一层高阶态势信息,以注意力机制分配权重,融合多层信息得到更有效的综合高阶态势信息,层间注意力计算方法如下:

| $ \boldsymbol{K}^L=\boldsymbol{V}^L=\left[\boldsymbol{L}_1, \boldsymbol{L}_2, \cdots, \boldsymbol{L}_n\right] $ | (12) |

| $ \boldsymbol{L}^L=\operatorname{Attention}\left(\boldsymbol{Q}^L, \boldsymbol{K}^L, \boldsymbol{V}^L\right) $ | (13) |

式中:KL= VL为各层Transformer单元提取到的高阶态势信息的集合,QL为计算注意力权重时参考的向量,在本文中取值为我方主体信息,LL即为提取到的综合高阶态势信息。

2.4 多维度态势分类及输出对于集群态势识别中集群阵型和运动趋势等态势要素的识别,需要解决如何同时对多种态势要素进行识别分类的问题,现有的态势识别方法通常都只针对一个分类组进行分类,对于多个分类组分类的方法较少。一个可能的解决方法是使用多个单独的神经网络分别去学习多种态势要素的分类,但这种方法会显著增加计算资源消耗,并且在面对不同态势要素的分类问题时,相应的神经网络模型在处理时序信息和多单位相关关系等部分所实现的功能是类似的,使用多个单独的神经网络将增加重复无用的计算量。

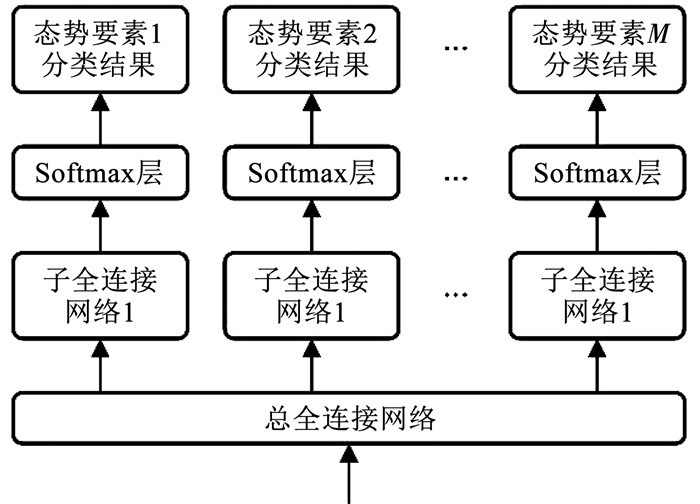

为解决多类态势要素的分类问题,本文使用多维度分类网络和softmax层实现多维度态势分类及输出。如图 13所示,多维度分类网络由一个总全连接网络和多个子全连接网络组成。总全连接网络偏重于对于综合高阶态势信息的整体处理,子全连接网络偏重于对于各类态势要素的分类概率计算。并行的子全连接网络均可以对总全连接网络的网络参数进行反向传播。可以使得各类态势要素的分类概率计算在一定程度上解耦,但又保持相关性,并且在模型的学习能力和训练难度之间寻得平衡。

|

图 13 多维度分类网络及softmax层 Fig. 13 Multi-dimensional classification network and softmax layer |

为验证模型的有效性,构建适用于多态势要素分类的水面无人艇场景,场景样本以无人艇集群在一段时间内的运动轨迹变化作为网络输入,以集群阵型、距离变化、角度变化、聚拢程度变化等共4类态势要素分类作为样本标签。依据不同的态势要素分类的任意组合,无人艇集群都有着不同的相对位置关系和运动轨迹。因此,模型需要实现从多序列态势信息到多态势要素分类结果的映射。各类态势要素的分类见表 1。

| 表 1 水面无人艇场景态势要素 Tab. 1 Situation elements of surface unmanned boat scene |

使用python对数据进行仿真,共生成1 000万组样本数据,其中阵型的5种分类在样本数据中各占20%,距离变化、角度变化、聚拢程度变化的3种分类在样本数据中都各占33%左右。

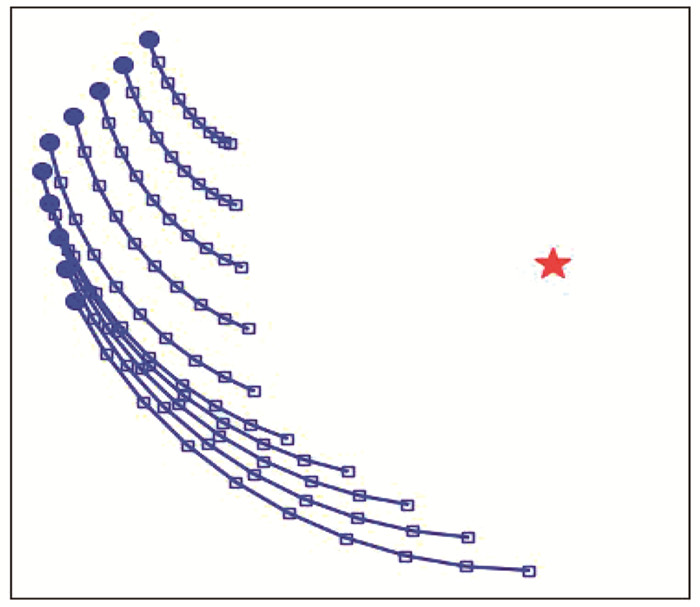

如图 14所示为一个场景示例样本的可视化,其中,五角星为我方观测主体,多条轨迹线分别为无人艇集群中多个单位的运动轨迹,实心圆点为轨迹初始位置,空心正方形为后续时刻位置。在该实例样本中,目标集群的多个单位在多个时刻下的位置状态即为样本数据,作为网络的输入;样本的标签则分别为(阵型)大雁型、(距离变化)靠近、(角度变化)逆时针、(聚拢程度变化)分散。

|

图 14 示例场景样本可视化 Fig. 14 Sample scene visualization |

使用python对实验数据集进行仿真,通过pytorch搭建网络模型,使用交叉熵作为损失函数,计算4类态势要素的分类总误差,对网络进行训练,训练参数和网络参数设置见表 2。仿真实验环境为Windows 10操作系统、Intel i7-8700处理器和NVIDIA RTX 1060显卡。

| 表 2 参数设置 Tab. 2 Parameter settings |

本文通过与基线方法的识别准确率比较,评估IAT模型的有效性。基线方法包括:1) IAT w/o Transformer模型,用全连接网络替换本文方法中的Transformer-Decoder注意力层模块(包含层间注意力结构),用于对比验证Transformer-Decoder注意力层结构的性能;2) IAT w/o inter-layer attention模型,用于对比验证层间注意力结构的性能。

基线方法1(IAT w/o Transformer模型)是常见的全连接深度网络,其与本文方法的区别在于本文提出的可应用于集群态势识别问题的类Transformer模型,其仿真性能对比可以体现Transformer-Decoder注意力层模块的实际效果;基线方法2(IAT w/o inter-layer attention模型)与本文方法的区别在于是否应用了本文提出的层间注意力机制,其仿真性能对比可以体现层间注意力机制的实际效果。

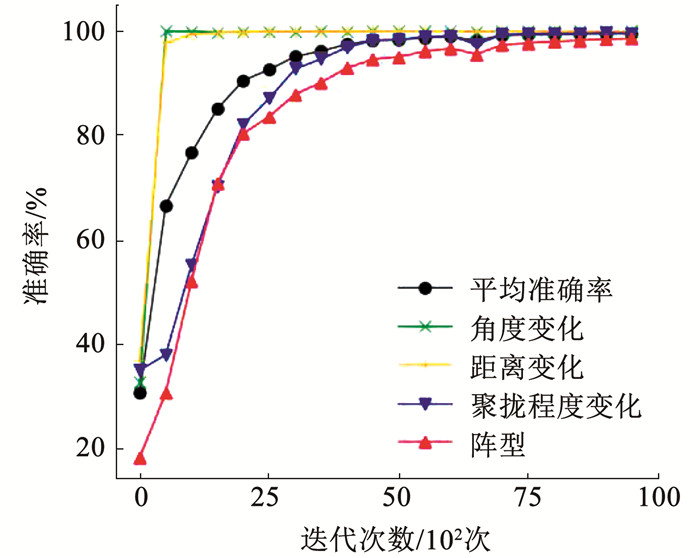

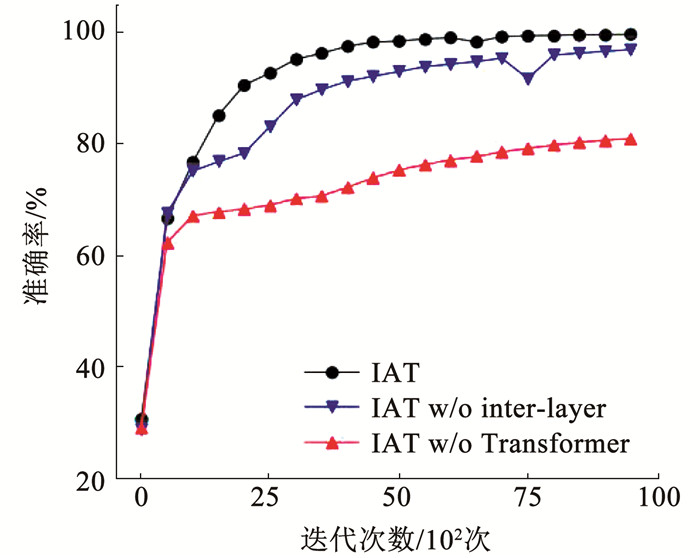

3.3 实验结果及分析实验相关结果如图 15、16及表 3所示。图 15展示了本文提出的IAT模型对于各态势要素的分类准确率以及整体的平均准确率。图 16展示了不同模型对于态势要素整体的平均分类准确率的对比。表 3列出了不同模型在各态势要素下的分类准确率。

|

图 15 IAT模型分类准确率迭代曲线 Fig. 15 Classification accuracy iteration curve of IAT model |

|

图 16 不同模型的分类平均准确率曲线 Fig. 16 Average classification accuracy of different models |

| 表 3 不同模型在各态势要素下的分类准确率对比 Tab. 3 Comparison of classification accuracy of different models for different situation elements |

结合上述实验结果进行分析:

1) IAT模型能够很好地实现多类态势要素分类,在迭代训练过程中各态势要素分类准确率稳定上升并收敛,在经过10 000次迭代后,各态势要素分类准确率都达到98.0%以上,平均分类准确率达到99.2%,验证了IAT模型的有效性。

2) 相比于不包含层间注意力结构的IAT模型,包含层间注意力结构的IAT模型的平均分类准确率上升得更快并收敛于更高的准确率99.2%,比不包含层间注意力结构的模型的最终准确率95.8%提升了3.4%,验证了层间注意力结构的有效性。

3) 相比于IAT模型的平均准确率99.2%,不包含Transformer注意力结构的IAT模型的平均准确率只达到了81.5%,相差了17.7%,性能明显较差。这证明了Transformer注意力结构对于集群态势感知问题有着更好的适用性,能够更加高效地表达和处理集群态势信息,以实现集群态势感知。

4) 可以看出,在距离变化和角度变化两类态势要素上,IAT模型相比于基线方法没有明显的优势,但在阵型和聚拢变化两类态势要素上,IAT模型的性能明显较强,分类准确率分别大幅提升27.0%和44.0%。距离变化和角度变化这两类态势主要表征了集群整体的绝对运动态势,而阵型和聚拢变化这两类态势主要表征了集群内部的相对位置和相对运动态势,因此可以看出,IAT模型在对集群内部相对态势的感知问题上有着明显的优越性,能够有效应用于需要对集群内部相对态势进行感知的问题,并能表现出优异的性能。

4 结论1) 设计了一种利用Transformer的无人集群对抗态势要素识别方法,实现了良好的集群态势要素识别能力。

2) 设计了层间注意力结构以改进Transformer结构在无人集群对抗态势要素识别问题上的性能,进一步提高识别准确率。

3) 利用Transformer和层间注意力的模型在针对集群内部相对趋势的态势要素的分类问题上,表现出了更为突出的性能。

4) 考虑在集群态势感知问题的基础上,加强对机器学习方法的深入分析,进一步探究机器学习方法在无人集群对抗问题中的鲁棒性和可解释性。

| [1] |

张邦楚, 廖剑, 匡宇, 等. 美国无人机集群作战的研究现状与发展趋势[J]. 航空兵器, 2020, 27(6): 7. ZHANG Bangchu, LIAO Jian, KUANG Yu, et al. Research Status and development trend of the United States UAV swarm battlefield[J]. Aero Weaponry, 2020, 27(6): 7. DOI:10.12132/ISSN.1673-5048.2020.0082 |

| [2] |

王祥科, 刘志宏, 丛一睿, 等. 小型固定翼无人机集群综述和未来发展[J]. 航空学报, 2020, 41(4): 023702. WANG Xiangke, LIU Zhihong, CONG Yirui, et al. Miniature fixed-wing UAV swarms: Review and outlook[J]. Acta Aeronautica et Astronautica Sinica, 2020, 41(4): 023702. DOI:10.7527/S1000-6893.2019.23732 |

| [3] |

罗文, 李敏勇, 张晓锐. 基于贝叶斯网络的态势认识[J]. 火力与指挥控制, 2010, 35(3): 89. LUO Wen, LI Minyong, ZHANG Xiaorui. Situation awareness based on bayesian networks[J]. Fire Control & Command Control, 2010, 35(3): 89. DOI:10.3969/j.issn.1002-0640.2010.03.024 |

| [4] |

李曼, 冯新喜, 张薇. 基于模板的态势估计推理模型与算法[J]. 火力与指挥控制, 2010, 35(6): 64. LI Man, FENG Xinxi, ZHANG Wei. Template-based inference model and algorithm for situation assessment in information fusion[J]. Fire Control & Command Control, 2010, 35(6): 64. DOI:10.3969/j.issn.1002-0640.2010.06.018 |

| [5] |

李伟生, 王宝树. 实现态势估计的一种模板匹配算法[J]. 计算机科学, 2006, 33(5): 229. LI Weisheng, WANG Baoshu. A template matching algorithm for implementing situation assessment[J]. Computer Science, 2006, 33(5): 229. DOI:10.3969/j.issn.1002-137X.2006.05.061 |

| [6] |

王成刚. 非协同目标识别专家系统研究与实现[J]. 火力与指挥控制, 2010, 35(5): 132. WANG Chenggang. Research and implementation on non-cooperative target recognition expert system[J]. Fire Control & Command Control, 2010, 35(5): 132. DOI:10.3969/j.issn.1002-0640.2010.05.039 |

| [7] |

刘科. 认知技术在战场态势感知中的应用[J]. 指挥信息系统与技术, 2021, 12(3): 13. LIU Ke. Application of cognition technology in battlefield situation awareness[J]. Command Information System and Technology, 2021, 12(3): 13. DOI:10.15908/j.cnki.cist.2021.03.003 |

| [8] |

徐建平, 张立凡, 韩德强. 基于模糊推理的空中目标意图识别[J]. 指挥信息系统与技术, 2020, 11(3): 44. XU Jianping, ZHANG Lifan, HAN Deqiang. Air target intention recognition based on Fuzzy inference[J]. Command Informatipn System and Technology, 2020, 11(3): 44. DOI:10.15908/j.cnki.cist.2020.03.007 |

| [9] |

魏蔚, 王公宝. 基于径向基神经网络的侦察目标意图识别研究[J]. 舰船电子工程, 2018, 38(10): 37. WEI Wei, WANG Gongbao. Detection and recognition of air targets by unmanned aerial vehicle based on RBF neural network[J]. Ship Electronic Engineering, 2018, 38(10): 37. DOI:10.3969/j.issn.1672-9730.2018.10.009 |

| [10] |

周旺旺, 姚佩阳, 张杰勇, 等. 基于深度神经网络的空中目标作战意图识别[J]. 航空学报, 2018, 39(11): 322468. ZHOU Wangwang, YAO Peiyang, ZHANG Jieyong, et al. Combat intention recognition for aerial targets based on deep neural network[J]. Acta Aeronautica et Astronautica Sinica, 2018, 39(11): 322468. DOI:10.7527/S1000-6893.2018.22468 |

| [11] |

李高垒, 马耀飞. 基于深度网络的空战态势特征提取[J]. 系统仿真学报, 2017, 29(S1): 98. LI Gaolei, MA Yaofei. Feature extraction algorithm of air combat situation based on deep neural networks[J]. Journal of System Simulation, 2017, 29(S1): 98. DOI:10.16182/j.issn1004731x.joss.2017S1014 |

| [12] |

欧微, 柳少军, 贺筱媛, 等. 基于时序特征编码的目标战术意图识别算法[J]. 指挥控制与仿真, 2016, 38(6): 36. OU Wei, LIU Shaojun, HE Xiaoyuan, et al. Tactical intention recognition algorithm based on encoded temporal features[J]. Command Control and Simulation, 2016, 38(6): 36. DOI:10.3969/j.issn.1673-3819.2016.06.008 |

| [13] |

廖鹰, 易卓, 胡晓峰. 基于深度学习的初级战场态势理解研究[J]. 指挥与控制学报, 2017, 3(1): 67. LIAO Ying, YI Zhuo, HU Xiaofeng. Battlefields situation elementary comprehension based on deep learning[J]. Journal of Command and Control, 2017, 3(1): 67. DOI:10.3969/j.issn.2096-0204.2017.01.0067 |

| [14] |

HOCHREITER S, SCHMIDHUBER J. Long short-term memory[J]. Neural Computation, 1997, 9(8): 1735. DOI:10.1162/neco.1997.9.8.1735 |

| [15] |

MNIH V, HEESS N, GRAVES A, et al. Recurrent models of visual attention[C]//Proceedings of the 27th International Conference on Neural Information Processing Systems. Cambridge, MA: MIT Press, 2014: 2204

|

| [16] |

VASWANI A, SHAZEER N, PARMAR N, et al. Attention is all you need[C]//Proceedings of the 31st International Conference on Neural Information Processing Systems. Red Hook, NY: Curran Associates Inc., 2017: 5998

|

2022, Vol. 54

2022, Vol. 54