为了克服传统伪装技术无法适应动态环境变化的缺陷,研究人员正在积极探索热致变色[1-2]、光致变色[3-4]和电致变色[5]等“智能”变色材料的动态伪装技术,以适应复杂多变的背景,但大多数“智能”变色材料存在着变色次数有限、变色速度慢、性能不稳定等缺点。近年来,随着微流控技术的发展,利用微流控技术实现变色伪装成为可能。Kasahara等[6]使用微流控技术混合两种不同的溶液,实现了颜色可调的电致化学发光单元。Kobayash等[7]探究在压力差作用下,将染色液滴和空气隙注入到微流道中,实现了多色显示。Heikenfeld等[8]提出了一种电控微流显示技术,利用电致压强将染色流从可视区域很小的储存室注入到表面通道,实现颜色的显示,在不施加电压时,染色液体在Young-Laplace压力的作用下回流到储存室。Morin等[9]报道了一种具有伪装、显示功能的软体机器人,该装置利用刻蚀技术在机器人的表面制作一层微通道,通过在微流道中通入不同颜色的液体来实现软体机器人的伪装、显示,且整个过程完全可逆。张敏[10]研制了微流控变色太阳镜和微流控滤光镜片,该镜片具有对不同波长光线的过滤功能,结构、原理简单,制作快速、便捷,且能够根据使用者的要求实现快速更换的特点,实现了人眼视力保护。由于整个微流道内微流体体积小、质量轻,所以利用微流控技术实现变色伪装既适用于静态伪装,也适用于动态伪装,但其自身颜色不能随着外界环境颜色变化,需要使用自适应变色驱动系统来实现动态伪装。要实现自适应变色和伪装,利用图像数据采集和处理实现变色系统的自动控制十分关键。随着计算机视觉技术的发展,深度学习已经被应用到各种场景的图像处理中。如图像分类[11-12]、目标检测[13-14]、图像分割[15-16]和图像补全[17]等。然而,目前深度学习的研究成果在伪装领域的应用报道较少。

本文提出一种利用微流控变色系统模拟变色龙皮肤的伪装薄膜。用摄像机获取变色龙周围环境的背景图像,采用深度学习算法和图像处理技术来感知并提取环境背景图像色彩信息,并构造混淆程度高的伪装薄膜的色彩块状分布,将色彩块状分布信息转换成微流控变色系统的信号,驱动有色液体充入薄膜的微流道内,从而实现变色伪装。比较了变色龙皮肤伪装前、后的图像,评价了伪装效果。

1 系统工作原理微流控自适应变色系统主要由有色液体驱动装置(图中未标出)、流体控制阀组、伪装变色薄膜以及控制器等组成。图 1为微流控变色系统原理图。

|

图 1 微流控变色系统原理图 Fig. 1 Working principle of microfluidic color-changing system |

摄像机拍摄背景图像信息,通过深度学习网络以及图像处理技术对环境背景图像进行补全、颜色识别及分类,产生背景图像的色彩信息,并传至微流控变色系统的控制器中,使其发出变色信号,液体驱动装置驱动相应有色液体充入薄膜微流道内,从而使伪装薄膜颜色发生变化,使其与背景图像颜色相同或相近,实现伪装。当环境背景变化时,可以自动自适应地调整伪装薄膜的颜色,使其与背景图像再次融合,实现自适应伪装。可以根据使用者的不同需求设计不同结构的伪装薄膜微流体通道,各个储液池中可以存放绿色、黄色等不同颜色的液体以满足不同的变色伪装目的。

采用具有微流道结构的硅胶(Silica Gel, SIL)与不具有微流道结构的硅胶薄膜通过不可逆封装技术(即在一定的压力范围内封接面不可剥离)构成具有闭合微流道结构的伪装薄膜。伪装薄膜制作主要采用软刻蚀技术,包括打印掩膜、制作微流控模具、固化、揭膜和不可逆封接。将设计好的伪装薄膜微通道图案印在透明膜上,图案通过标准的光刻工艺转移到微流控模具上,然后将液态硅胶倒在微流控模具表面,在干燥箱中加热一段时间后,模具上的液态硅胶固化,通过等离子体清洗机处理,将从模具上剥离的具有微流道结构的固化硅胶与另一层无结构的薄膜不可逆封接,形成封闭的微流道结构。

2 变色控制信号生成原理用摄像机获取含有伪装目标的环境背景图像,并将其传送到计算机中。利用基于Python语言的深度学习算法对伪装体为空白的背景图像进行图像补全,得到补全后的完整图像。为模仿变色龙皮肤,按照变色龙皮肤上的微流道结构进行图像分割,计算每个色块所有颜色的RGB值及对应的像素数,将图像RGB值转换成HSV值,按照预定HSV颜色范围进行颜色分类,并比较分类后的每种颜色总的像素数,获取像素数多的那种颜色代表此色块的颜色。在Spyder编辑器中利用封装的串口通信模块pySerial设置串口地址、波特率和每个位组在串口数据传输的大小等参数,通过串口通信把颜色信息传送到控制器中,控制器将传送过来的颜色信息转换成变色的控制信号并发出,从而完成变色信号控制,达到自适应伪装。生成变色控制信号的流程见图 2。

|

图 2 生成变色信号流程 Fig. 2 Flow chart of color-changing signal generation |

为了使伪装图像与背景图像在颜色、纹理分布上均具有较好的一致性,使人眼或光学照相机无法区分目标与环境,借鉴图像处理中的目标去除方式,本文利用deepfillv1算法[18]对删除的目标区域进行图像补全,并应用于微流控变色系统的变色控制信号中,使伪装薄膜根据环境背景图像的变化能够及时、准确地变色。

利用deepfillv1算法实施图像补全的实验结果如图 3所示,将以变色龙皮肤为模型的伪装薄膜放入到不同背景环境中,图 3(a)为原始图像,图 3(b)为将变色龙模型进行遮盖,图 3(c)为通过deepfillv1算法对遮盖的背景图像进行补全,其中矩形虚框内为图像补全的结果。由图 3可看出,采用deepfillv1算法生成了与环境图像具有高融合度的伪装体图像。

|

图 3 Deepfillv1算法对背景图像进行图像补全 Fig. 3 Background image completion by deepfillv1 algorithm |

伪装体图像处理需要在合适的色彩空间进行,图像一般为标准的RGB图像,但RGB是从硬件角度提出的颜色模型,并不是基于人类视觉特性的色彩空间,而且R、G、B分量之间相关性极高,如果一个颜色的任一个分量发生了变化,很可能改变这个颜色的效果,并且不便设定颜色范围进行颜色识别,所以在对数字图像处理之前需要将图像的RGB色彩空间转换到HSV色彩空间,计算如下:

| ${C_{\max }} = \max (R, G, B), {C_{\min }} = \min (R, G, B)$ | (1) |

| $H = \left\{ {\begin{array}{*{20}{l}} {0, }&{{C_{\max }} = {C_{\min }}}\\ {60 \times \frac{{G - B}}{{{C_{\max }} - {C_{\min }}}} + 0, }&{{C_{\max }} = R, G \geqslant B}\\ {60 \times \frac{{G - B}}{{{C_{\max }} - {C_{\min }}}} + 360, }&{{C_{\max }} = R, G < B}\\ {60 \times \frac{{B - R}}{{{C_{\max }} - {C_{\min }}}} + 120, }&{{C_{\max }} = G}\\ {60 \times \frac{{R - G}}{{{C_{\max }} - {C_{\min }}}} + 240, }&{{C_{\max }} = B} \end{array}} \right.$ | (2) |

| $S = \left\{ {\begin{array}{*{20}{l}} {0, }&{{C_{\max }} = 0}\\ {\frac{{{C_{\max }} - {C_{\min }}}}{{{C_{\max }}}}, }&{{C_{\max }} \ne 0} \end{array}} \right.$ | (3) |

| $V={{C_{\max }}}$ | (4) |

对伪装体图像进行设计并绘制微流道结构,依照微流道结构进行图像分割。对分割后的每个区域进行颜色识别,计算出每个区域图像所有颜色的RGB值及对应的像素数,将图像RGB值转换成HSV值,按照预定HSV颜色范围进行颜色分类,并比较分类后的每种颜色总的像素数,获取像素数多的那种颜色代表此区域图像的颜色。最后生成每个区域的色彩信息。

颜色分类是按照预设HSV颜色范围进行分类的,颜色种类与系统中存储的有色液体的类别有关。由于自然界颜色有许多种,不能一一配出相应的颜色,但可以把自然界彩色系分成几种基本色来代替所有的颜色,所以试验装置的储液池中只需存放这几种基本色的颜料即可。通过实验可以计算出几种基本色对应HSV的3个分量的范围,当更换伪装体的背景环境时,识别背景图像颜色的HSV值,可以得出背景图像是由哪几种颜色组成,从而液体驱动装置驱动相应储液池里面的有色液体完成自适应伪装变色试验。为了使伪装体颜色更加接近背景颜色,使二者很好地融合,可以更细划分色光,分成更多种颜色,储液池中需存放相应颜色的颜料。

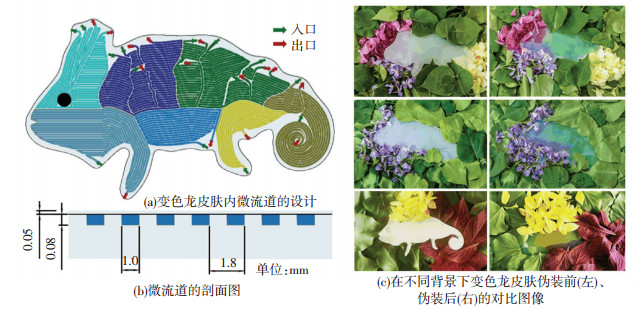

3 变色龙皮肤伪装特性及伪装效果评价设计微流控伪装薄膜的微流道,并充入相应的有色液体,实现背景匹配和伪装功能。变色龙皮肤以硅胶材料为原材料,利用软刻蚀技术,根据使用者的不同需求,可以进行微流道尺寸和形状的多样化设计。图 4(a)为变色龙皮肤上的微流道结构设计图;图 4(b)为图 4(a)中微流道沿红色虚线纵切后的剖面图,变色龙皮肤上微流道的宽度为1 mm, 间隔为0.8 mm,深度为0.08 mm,顶膜厚度为0.05 mm;图 4(c)为在不同背景下的伪装前和伪装后变色龙皮肤的图像。从视觉感知的角度上,伪装后的变色龙皮肤与背景融合度较高,表面轮廓的完整度降低,实现了一定的伪装作用。

|

图 4 伪装变色龙皮肤 Fig. 4 Chameleon skin camouflage |

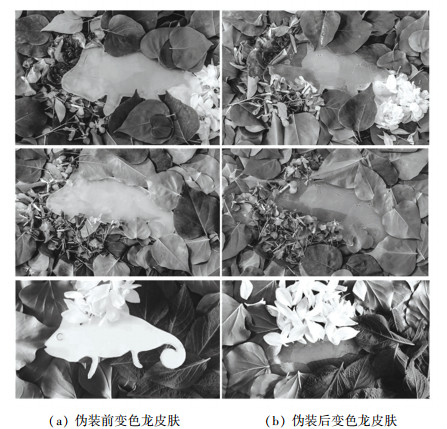

为了确认微流控伪装变色龙皮肤伪装的有效性,并评价其伪装效果,利用”Canny”双阈值边缘检测对伪装前后图像的边界特性进行伪装评价。利用Python语言将图 4(c)的图像转换为灰度图像,如图 5所示,并建立”Canny”双阈值边缘检测模型,对灰度图像进行检测分析,如图 6所示。

|

图 5 微流控伪装变色龙皮肤灰度转换图 Fig. 5 Grayscale images of microfluidic chameleon skin camouflage |

|

图 6 “Canny”双阈值边缘检测算法 Fig. 6 "Canny" double-threshold edge detection |

图 6(a)为变色龙皮肤在不同的背景下伪装前的图像,可以看出,变色龙皮肤的轮廓边缘非常明显;图 6(b)表示变色龙皮肤在不同的背景下伪装后的图像,可以看出,变色龙皮肤边缘被背景图像模糊化,很难提取出目标的边缘轮廓,从而达到了较为理想的伪装效果。

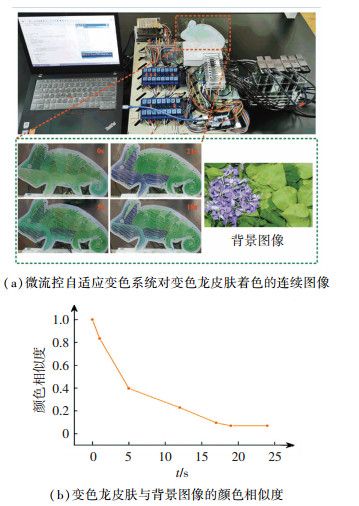

为进一步分析变色龙皮肤的伪装效果,利用颜色直方图和Manhattan距离相结合的方法计算变色龙皮肤控制着色的连续图像的颜色相似度。颜色相似度是计算变色龙皮肤与背景图像在每个颜色区间内颜色特征之间的差异,若变色龙皮肤与背景图像颜色完全相同时,颜色相似度为0;若完全不同,其值为1。微流控变色系统泵送匹配的有色液体冲入变色龙皮肤的微流道内,如图 7(a)所示。随时间变化的变色龙皮肤与背景图像的颜色相似度之间关系曲线如图 7(b)。所示变色龙皮肤的微流道内完成充液所需时间为19 s,此时颜色相似度最小,其值为0.07,由于液体已经充满,此值不再发生变化。在0~5 s颜色相似度增长较快,5 s时颜色相似度为0.397,随着流道内冲入液体量增加,流体流动的阻力增加,在5~19 s颜色相似度增长相对缓慢。随着时间的变化,颜色相似度越来越小,变色龙皮肤在其背景环境下伪装效果越来越好。根据背景图像的颜色信息,变色龙皮肤可以变为与背景图像匹配的任何颜色。与用于变色太阳镜的传统变色固体材料(如卤化银)相比,变色龙皮肤的变色范围更广。变色龙皮肤的充液时间短,而传统的固体感光材料至少需要2 min才能完成着色,因此利用微流控技术进行变色伪装具有较快的变色速度,并且随着系统压力的增加,变色速度迅速提高。

|

图 7 变色龙皮肤伪装及其与背景的颜色相似度 Fig. 7 Chameleon skin camouflage and itscolor similarity with background |

1) 本文设计并研制了一种利用微流控变色系统的伪装薄膜,并进行了测试。采用深度学习算法和图像处理技术构造了混淆程度高的伪装薄膜的色彩块状分布,将色彩块状分布信息转换成微流控变色系统的信号,并驱动有色液体充入伪装薄膜的微流道中,从而实现自适应变色伪装。

2) 采用了“Canny”双阈值边缘检测算法和颜色相似度对伪装效果进行评价,伪装薄膜在响应速度和兼容性方面表现出良好的伪装性能。薄膜伪装可以自适应调节,具有智能化、响应速度快、伪装效果自然的特点,可应用于官兵迷彩服、机器人皮肤、武器装备和军工设施的伪装网等场合。

| [1] |

MJEJRI I, ROUGIER A. Color switching in V3O7·H2O films cycled in Li and Na based electrolytes: novel vanadium oxide based electrochromic materials[J]. Journal of Materials Chemistry C, 2020, 8(11): 3631. DOI:10.1039/c9tc06753a |

| [2] |

RAJYALAKSHMI T, BASHA S J, KHIDHIRBRAHMENDAR V, et al. Synthesis and investigations for white LED material: VO2+ doped calcium cadmium phosphate hydrate nanophosphor[J]. Journal of Molecular Structure, 2020, 1205: 127605. DOI:10.1016/j.molstruc.2019.127605 |

| [3] |

YU Cunjiang, LI Yuhang, ZHANG Xun, et al. Adaptive optoelectronic camouflage systems with designs inspired by cephalopod skins[J]. Proceedings of the National Academy of Sciences of the United States of America, 2014, 111(36): 12998. DOI:10.1073/pnas.1410494111 |

| [4] |

WANG Zelinlan, GUO Zhiguang. Biomimetic photonic structures with tunable structural colours: from natural to biomimetic to applications[J]. Journal of Bionic Engineering, 2018, 15(1): 1. DOI:10.1007/s42235-017-0001-9 |

| [5] |

LING Yuan, XIANG Chunlan, ZHOU Gang. Multicolored electrochromism from benzodipyrrolidone-based ambipolar electrochromes at a fixed potential[J]. Journal of Materials Chemistry C, 2017, 5(2): 290. DOI:10.1039/c6tc04834j |

| [6] |

KASAHARA T, ISHIMATSU R, KUWAE H, et al. Color-tunable microfluidic electrogenerated chemiluminescence cells using Y-shaped micromixer[J]. Japanese Journal of Applied Physics, 2018, 57(12): 128001. DOI:10.7567/JJAP.57.128001 |

| [7] |

KOBAYASH K, ONOE H. Microfluidic-based flexible reflective multicolor display[J]. Microsystems & Nanoengineering, 2018, 4: 17. DOI:10.1038/s41378-018-0018-1 |

| [8] |

HEIKENFELD J, ZHOU K, KREIT E, et al. Electrofluidic displays using Young-Laplace transposition of brilliant pigment dispersions[J]. Nature Photonics, 2009, 3(5): 292. DOI:10.1038/NPHOTON.2009.68 |

| [9] |

MORIN S A, SHEPHERD R F, KWOK S W, et al. Camouflage and display for soft machines[J]. Science, 2012, 337(6093): 828. DOI:10.1126/science.1222149 |

| [10] |

张敏. 基于微流道结构的光学变色系统微流控技术及试验研究[D]. 哈尔滨: 哈尔滨工业大学, 2017 ZHANG Min. Research on microfluidic colour-changing system based on shape memory allay actuator and optical applications[D]. Harbin: Harbin Institute of Technology, 2017 |

| [11] |

SINGHAL V, MAJUMDAR A. Row-sparse discriminativedeep dictionary learning for hyperspectral image classification[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2018, 11(12): 5019. DOI:10.1109/JSTARS.2018.2877769 |

| [12] |

XIAO Youzi, TIAN Zhiqiang, YU Jiachen, et al. A review of object detection based on deep learning[J]. Multimedia Tools and Applications, 2020, 79(33/34): 23729. DOI:10.1007/s11042-020-08976-6 |

| [13] |

WU Xiongwei, SAHOO D, HOI S C H. Recent advances in deep learning for object detection[J]. Neurocomputing, 2020, 396: 39. DOI:10.1016/j.neucom.2020.01.085 |

| [14] |

LIU Li, OUYANG Wanli, WANG Xiaogang, et al. Deep learning for generic object detection: A survey[J]. International Journal of Computer Vision, 2020, 128(2): 261. DOI:10.1007/s11263-019-01247-4 |

| [15] |

HESAMIAN M H, JIA Wenjing, HE Xiangjian, et al. Deep learning techniques for medical image segmentation: achievements and challenges[J]. Journal of Digital Image, 2019, 32(4): 582. DOI:10.1007/s10278-019-00227-x |

| [16] |

GHOSH S, DAS N, DAS I, et al. Understanding deep learning techniques for image segmentation[J]. ACM Computing Surveys, 2019, 52(4): 20. DOI:10.1145/3329784 |

| [17] |

XU Shuzhen, ZHU Qing, WANG Jin. Generative image completion with image-to-image translation[J]. Neural Computing and Applications, 2020, 32(11): 7333. DOI:10.1007/s00521-019-04253-2 |

| [18] |

YU Jiahui, LIN Zhe, YANG Jimei, et al. Generative image inpainting with contextual attention[C]// 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 18347746. DOI: 10.1109/CVPR.2018.00577

|

2022, Vol. 54

2022, Vol. 54