能见度是气象、公路行车、航空等领域中常见的评价指标,其主要受雾霾天气的影响,原因主要有两个:一是雾霾天气下大气中悬浮着大量微小颗粒,会导致目标物反射的光线被吸收,二是反射大气透光进入人眼或者监控设备。雾霾天气对道路事故数量有着重要的影响,在美国,每年因雾霾天气所产生的道路致命事故数量达300~400起[1]。据中国道路交通事故统计年报,近年发生在雨雪雾等恶劣天气条件下的事故数量占到24%[2]。据国外数据统计,在能见度较低的夜间,交通事故占道路事故总数的10%,但是引起了47%的死亡率[3]。能见度降低会造成驾驶员视线模糊,无法合理地控制车辆速度并容易做出误判,而且不同车道和车型也存在速度特性的不同[4],从而引发交通事故,造成严重的财产和人员伤亡。死亡率分析报告系统(FARS)的统计数据显示,雾天期间发生致命事故是一个亟待解决的主要问题[5], 为了减少此环境下的碰撞风险,文献[6]将网联车辆技术应用于不利能见度条件下,试图改善雾状条件下的交通安全,结果表明道路安全得到了改善、车辆平均速度均得到了提高。因此,道路低能见度时的管理对策是高速公路安全领域的重点关注问题。

当下,覆盖全国的高速公路网体系已逐步完善,大部分地区对于不利视觉条件下(雨、雾、霾等)的能见度检测依赖激光能见度仪,但为公路配置大量的激光能见度仪必会给政府产生高额的财政负担。与此同时在当前的技术水平条件下,激光能见度仪本身还存在一些不足,例如,对聚集性雾团的检测精度较低,探测区域有限,设备更新费用较高等。近年来,随着图像处理技术和深度学习算法的广泛应用,视频图像处理领域吸引了越来越多的研究者,也推动了图像去雾和能见度检测技术的发展。文献[7]设计了一种基于最小方差中值引导滤波融合变差函数和颜色衰减先验理论的去海雾图像算法,在雾霾较重的区域处理效果较好,使原始图像的信息熵提高了近30%,得到的图像色彩更加鲜艳。文献[8]设计了基于内置车载外传感器的能见度检测系统,可识别驾驶环境中的障碍物,能见度过低时能快速预警。文献[9]提出一种基于亮度特征的PTZ视频能见度检测算法,先获取能够反映路面亮度变化的对比度曲线的特征点,再通过计算大气消光系数和相机标定得到能见度值。文献[10]通过路面亮度特征来检测能见度,先后计算了路面采样区域的视频亮度,路面的固有亮度以及能见度距离,并对结果进行聚类分析得到的能见度值准确率达94%。文献[11]在对交通视频图像处理算法的研究中逐渐发现,利用道路视频图像的能见度检测方法正朝着更加稳定、精确、高效的方向发展[11]。但现有的能见度检测手段基本为间接计算,很难准确地估算能见度,即使用能见度检测仪误差也很大[12]。特别地,很多图像处理手段大多数只选取少量视频、截取图像中的某些固有特征[13],或基于Koschmieder定律[14]进行估计,并没有充分利用视频的连续信息,所以检测的精度不高,仍有较大的改进空间。

在雾天环境下,暗通道先验算法是一种按雾气浓度局部修复图像各部分颜色的方法,通过这种算法可以达到去雾效果自然,图像的颜色逼真、清晰度高的效果。此方法具有视觉质量好的优点,可提升交通图像处理效果,从而更精确地提高基于视频图像所检测的能见度,有利于对道路交通状况的实时判断。文献[15]通过均值漂移方法将雾天交通图像进行分割,并对得到的非天空区域采用暗通道先验算法进行去雾,从而保证了图像的去雾效果。文献[16]提出一种基于交通视频的雾天识别系统与快速去雾方法,用暗通道先验算法进行去雾处理,有效提升了交通视频的画面质量。当暗通道先验算法在应用于高速公路能见度检测时,检测结果对图像质量十分敏感,例如雾霾环境下摄像机CCD若存在污渍,会导致高速公路视频图像不清晰,此时算法不利于提取图像中的特征信息, 对于检测精度有着很大影响。此外,在有雾霾的天气下,大气中分布着较多的悬浮粒子,光在这些粒子中传输会出现大量散射现象,光晕效应会使摄像机得到的图像较实际效果更白,在这种环境下使用暗通道先验算法等去雾算法要特别注重图像处理过程的优化。

为了更加精确地通过视频图像来检测能见度,需要对图像处理方法进行优化,或开发根据环境不断改善中间变量的计算方法。从目前研究的情况来看,暗通道先验算法存在不足,例如耗时过长,当大气透光强度值的求取在图像中有纯白色物体时,不能得到大气透光强度的准确值,且天空区域的透射率估计值比实际值小等。为了改善处理带有灯光、白色或反光物体区域的图像的缺陷,本文以提高高速公路能见度检测精度为目的,利用能见度检测原理,考虑了大气透光强度、透射率、大气消光系数和图像中某点到摄影机的距离,在传统暗通道先验算法的基础上进行了处理白色区域方面的改进。首先结合矩形区域测距和实际场景物体大小来解决高速公路二维场景到三维场景重构的问题,并利用K-means聚类的方法,并找出聚类后的视频图像中分界线的最小景深点,结合所构建的测距模型得到该点到摄像机的实际距离。其次根据传统暗通道先验理论在求取大气透光强度方面的不足,提出了基于图像分割的局部熵法来求取大气透光强度,再利用暗通道先验理论求出透射率,最后由能见度检测原理计算出能见度。

1 能见度检测的基础理论本文提出的能见度检测方法是在图像去雾研究算法——暗通道先验算法的基础上进行的,首先阐述能见度计算的原理和流程。

在高速公路或机场中,能见度主要受到光在大气中物理传播的影响。要计算能见度,就要对光在相关场景中的传播进行气象学分析,以此来建立模型进行能见度求解。

相关研究表明,能见度检测的理论基础是Koschmieder定律[14],该定律建立了大气消光系数和能见度的联系,表达式为

| $ L=L_0 \mathrm{e}^{-\sigma d}+A\left(1-\mathrm{e}^{-\sigma d}\right) $ | (1) |

| $ I(x)=J(x) t+A(1-t), t \in[0, 1] $ | (2) |

式中:L和L0分别为物体的观测亮度值和固有亮度值,σ为大气消光系数,d为平行光通过大气衰减到原始光通量的0.05时的距离[11],A为大气透光强度,I(x)为原始图像,J(x)为无雾的清晰图像,t(x)为大气透射率。

图像某点到摄像头之间的距离d、该场景的大气消光系数σ、透射率t之间的关系为

| $ \left\{\begin{array}{l} t(x)=\mathrm{e}^{-\sigma(x) d(x)} \\ J(x)=A \rho(x) \end{array}\right. $ | (3) |

式中ρ(x)为反照率。

将式(3)代入式(2)可得

| $ \begin{aligned} I(x)= & A \rho(x) \mathrm{e}^{-\sigma(x) d(x)}+A\left(1-\mathrm{e}^{-\sigma(x) d(x)}\right), \\ & \mathrm{e}^{-\sigma(x) d(x)} \in[0, 1] \end{aligned} $ | (4) |

以上述相关模型为理论基础,国际照明委员会(CIE)定义了能见度的计算公式为

| $ V=-\frac{1}{\sigma} \ln 0.05 \approx \frac{3}{\sigma} $ | (5) |

式中V为能见度。

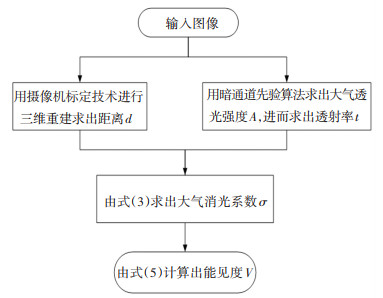

由上述理论基础可知, 大气消光系数σ可通过透射率t和距离d来求取,然后将σ代入式(5)即可计算出能见度V。其中,距离d将采用摄像头标定进行三维重建得到,在暗通道先验算法中,大气透光强度A可以根据暗通道理论求出,进而得到透射率t。应用传统暗通道先验算法检测能见度的具体流程[17]如图 1所示。

|

图 1 应用暗通道先验算法求能见度流程图 Fig. 1 Flow chart of dark channel prior algorithm for visibility |

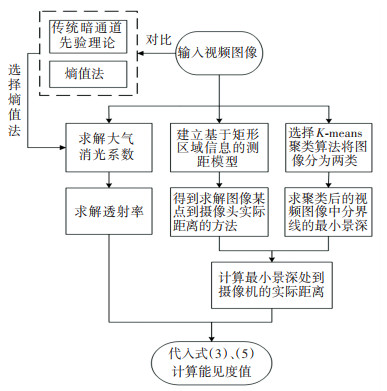

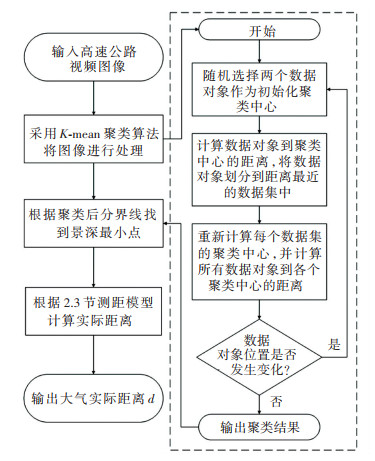

首先,根据传统暗通道先验理论在求取大气透光强度上存在不足,比如暗通道在图像的灯光、白色或反光物体区域会失效,提出了采用基于图像分割的局部熵法来求取大气透光强度,再利用暗通道验算法求出透射率。其次,通过对高速公路矩形区域测距和实际场景物体大小相结合方法,解决了二维场景到三维场景重构的问题,并利用K-means聚类算法,求出聚类后视频图像中分界线的景深,由最小景深和所构建的测距模型得到该点到摄像机的实际距离,之后由式(3)和式(5)计算能见度。算法流程如图 2所示。

|

图 2 基于改进的暗通道先验算法求解能见度的流程图 Fig. 2 Flow chart for solving visibility based on improved dark channel prior algorithm |

暗通道先验理论是He等[18]经过大量的观测实验得出的一个图像统计规律:在户外无雾图像的绝大多数非天空区域内,某些像素总会有至少一个颜色通道具有很低的接近于0的强度值,称之为暗通道。根据此现象,可以用式(6)来描述暗通道:

| $ {J^{{\rm{dark}}}}(x) = \mathop {\min }\limits_{C \in \{ R, G, B\rangle } \left[ {\mathop {\min }\limits_{y \in \mathit{\Omega }(x)} \left( {{J^{\rm{C}}}(y)} \right)} \right] $ | (6) |

式中: JC为图像中3个通道中某一个颜色通道,Ω(x)为图像中以x为中心的一个方形区域;Jdark(x)为该区域暗通道。

图像暗通道求取过程:先求取出图像中各像素点R、G、B三通道中最小值,得到一幅图像,然后对图像在区域Ω(x)进行最小值滤波。

暗通道相关理论[18]指出:

| $ J^{\text {dark }}(x) \rightarrow 0 $ | (7) |

式(7)在高速公路场景中具体表现为道路和来往车辆的阴影。根据式(7),提取高速公路大雾场景某帧图片的暗通道,如图 3所示。

|

图 3 高速公路大雾场景图片暗通道 Fig. 3 Dark passage of image of highway fog scene |

由暗通道原理,将暗通道中亮度为0.1%的像素区域与原始图像对应区域中最高亮度点亮度值作为大气透光强度值[17]。但该计算方法存在缺点:暗通道在图像的灯光、白色或反光物体区域会失效,在天空区域相对面积较小时也会失效。因此,本文采用另外一种计算大气透光强度值的方法——基于局部熵的图像分割方法, 该方法优点是可应对图像灰度分布不均匀的难点,便于在雾气浓度最高处选取大气透光强度值。

对于高速公路有雾图像,除了在深度突变区域外,大气透光强度值在其他区域变化较平缓,本文选择在雾气浓度最高处选取大气透光强度值。具体的步骤如下:

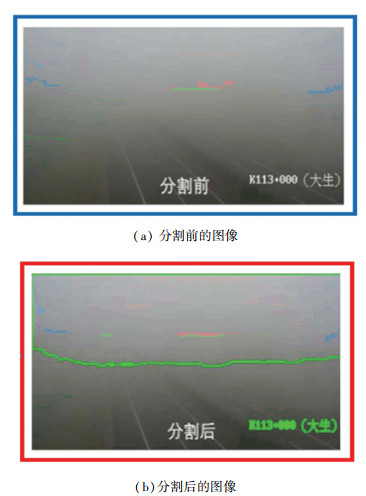

1) 以地平线为界将图像分割成天空和地面两个区域。在对原始图像进行分割时,本文采用OpenCV中的轮廓检测函数FindContours。图 4是对高速公路视频某一帧图像进行分割的结果。

|

图 4 基于轮廓检测的图像分割 Fig. 4 Image segmentation based on contour detection |

2) 对分割出的天空区域利用局部熵法进行大气透光强度值的计算。对于大小为M×M的图像,灰度等级L为256。设f(i, j)为图像(i, j)处的灰度值,设其邻域大小为m×n的方格区域内灰度值l的像素个数为nj,Pj为方格区域内像素灰度值l的概率[19],Pl定义为

| $ P_l=\frac{n_l}{m \times n} $ | (8) |

所以(i, j)处的局部熵的定义为

| $ h(i, j)=-\sum\limits_{l=0}^{L-1} P_l \log _2 P_l $ | (9) |

由式(9)可知熵值越小,该区域的亮度变化越稳定,亦即熵值越小,雾的浓度越高,能见度越低,该区域为浓雾的可能性就越大。所以通过局部熵法可以找到图像局部熵最小处,即雾气浓度最高处,将此处的亮度值作为大气透光强度值。

2.2 透射率的求解由上文2.1节可以知道,雾的浓度不同会影响式(6)中的亮度值,最终使得Jdark(x)也不同,透射率的求解公式[20]为

| $ t(x)=1-\omega \frac{J^{\mathrm{dark}}(x)}{A} $ | (10) |

式中:t(x)为以x为中心的方形区域的透射率;ω的取值为0.8,其含义是即使在无雾的天气下,大气中也会有粉尘颗粒等杂质导致能见度降低。

根据上文计算的A值,可以通过式(10)计算透射率,本文将在实验部分选取天空和地面区域中心点进行计算对比,以验证此方法对能见度检测的适用性。

2.3 基于高速公路矩形区域信息的测距模型对于在高速公路上获取的视频数据,若要从二维图像中获得三维场景的物体,则需要在了解物体的几何模型的基础上,还需从图像中获取一些信息,本文建立了一种基于平面矩形的测量模型, 用高速公路摄像头来测量距离公路能见度范围内某一点或某一矩形区域到摄像头的距离。

如图 5所示,建立相机坐标系,设摄像头的透镜中心O为原点,O′为相机成像平面中心,

| $ \left\{\begin{array}{l} \overrightarrow{O A}=\lambda_a \overrightarrow{O A} \\ \overrightarrow{O B}=\lambda_b \overrightarrow{O B} \\ \overrightarrow{O C}=\lambda_c \overrightarrow{O C} \\ \overrightarrow{O D^{\prime}}=\lambda_d \overrightarrow{O D} \end{array}\right. $ | (11) |

|

图 5 成像平面坐标系和高速公路矩形区域映射图 Fig. 5 Imaging plane coordinate system and highway rectangular area mapping |

式中:λa、λb、λc、λd为不为零的实数,包括其他同类符号。

将O(0,0)和A、B、C、D坐标代入式(11),得

| $ \left\{\begin{array}{l} A^{\prime}=\left(\lambda_a x_a, \lambda_a y_a, \lambda_a \alpha\right) \\ B^{\prime}=\left(\lambda_b x_b, \lambda_b y_b, \lambda_b \alpha\right) \\ C^{\prime}=\left(\lambda_c x_c, \lambda_c y_c, \lambda_c \alpha\right) \\ D^{\prime}=\left(\lambda_d x_d, \lambda_d y_d, \lambda_d \alpha\right) \end{array}\right. $ | (12) |

矩形A′B′C′D′中,设

本文设高速公路在相机成像平面内任意一点为Q, 其在高速公路上对应的实际点为Q′, 假设Q′位于平面A′B′C′D′上,则有

| $ \begin{aligned} & \overrightarrow{A^{\prime} Q^{\prime}} \cdot \vec{n}=\left(\overrightarrow{O A}-\overrightarrow{O Q^{\prime}}\right) \cdot \vec{n}= \\ & \left(\lambda_a \cdot \overrightarrow{O A}-\lambda_q \cdot \overrightarrow{O Q}\right) \cdot \vec{n}=0 \end{aligned} $ | (13) |

其中λq可以表示为

| $ \lambda_q=\frac{\lambda_a \cdot \overrightarrow{O A} \cdot \vec{n}}{\overrightarrow{O Q} \cdot \vec{n}}=\frac{\lambda_a \cdot\left(x_a, y_a, \alpha\right) \cdot \vec{n}}{\left(x_q, y_q, \alpha\right) \cdot \vec{n}} $ | (14) |

由于Q′的坐标为 λqxq, λqyq, λqα,因此Q′到摄像头的距离为

| $ d=\sqrt{\left(\lambda_q x_q\right)^2+\left(\lambda_q y_q\right)^2+\left(\lambda_q \alpha\right)^2} $ | (15) |

因此由式(14)和式(15)可以求取摄像头成像图像中任意一点对应的高速公路实际点到摄像头的距离。

2.4 利用景深计算实际距离上文阐述了距离d的求解方法,但值得注意的是,d仅仅是针对具体一幅图像上的任意一点,而实际场景中,d应为地平线上可以看到合适尺寸的黑色物体的最大距离, 这时使用的d才是更具有实际意义的,因此,需要找出地平线上可以看到合适尺寸的黑色物体的最大距离。在已经确定要聚类个数的情况下,K-means算法具有运算简单、速度快的特点,因此本文采用K-means聚类算法对图像进行聚类,可得到所谓的“亮区”和“暗区”,利用两区分界线处不同景深的点对应的亮度差异来确定此距离, 算法流程如图 6所示。

|

图 6 利用景深求解距离的算法流程 Fig. 6 Flow chart of algorithm for solving distance using depth of field |

聚类前的高速公路视频图像如图 7所示,聚类后图像被分为两类,上部为原来像素较高的区域,下部为原来像素较低的区域,对应地平线上可以看到合适尺寸的黑色物体的最大距离,效果如图 8所示。

|

图 7 聚类前的高速公路视频图像 Fig. 7 Highway video image before clustering |

|

图 8 聚类后的图像分区 Fig. 8 Image partition after clustering |

根据聚类后图像两区域分界线,即原图像所能看到的远处高速公路区域,找到景深最小的点,应用2.3节所构建的测距模型来计算该点到摄像机的实际距离。在已知透射率和物体到摄像机距离的情况下,由式(3)和式(5)可计算此时高速公路的能见度。

3 能见度检测实验 3.1 实验条件本文选择的能见度数据参照值来自能见度检测仪的检测值。实验基于MATLAB-R2019a,计算机处理器为Intel(R) Core(TM)i7-9750H CPU@2.60 GHz,操作系统为Windows 10,实验数据来源于日兰高速公路K113+000处用摄像头拍摄的视频图像和能见度检测仪的数据,共350帧图片,拍摄时间为2016年4月14日,检测时段为6:30—10:00,该时段温度为8~13 ℃,天气状况为雾天。图 9为日兰高速公路K113+000处7:28:45时刻的视频图像。在2.3节中,l和w的值分别为视频图像中的高速公路路面上任意一矩形区域的长和宽,根据中国高速公路建设标准[21],矩形的长l可以选择为两个车道的宽度,即为3.75 m×2=7.5 m,矩形的宽w可取为一段车道分界线长度,即为6 m。

|

图 9 日兰高速公路K113+000处视频图像 Fig. 9 Video image of K113+000 on Rilan Highway |

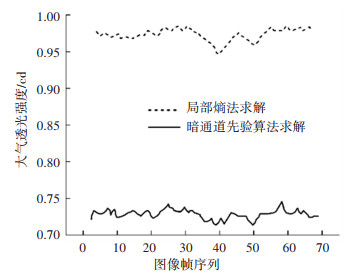

前100帧图像归一化后,通过局部熵法和暗通道先验算法求得的大气透光强度随时间序列的变化曲线如图 10所示,由图可知采用局部熵法所求得的大气透光强度要高于暗通道先验算法,这是由于暗通道先验算法在非天空区域的高光或白色部分失效(高速公路截图中的白色部分为车道分隔线)。因此在大雾天气情况下,用局部熵法求大气透光强效果更佳。

|

图 10 两种方法求大气透光强度随图像帧序列的变化曲线 Fig. 10 Curves of atmospheric transmittance intensity obtained by two methods with image frame sequence |

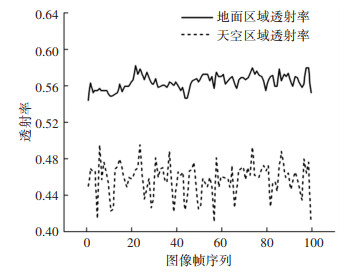

由式(10)和图 10可得到的100帧图像天空和地面的透射率变化如图 11所示,可以看出,天空区域的透射率低于地面的透射率,这正是由于天空区域雾的浓度高而能见度低所导致的。对于高速公路上大雾情况下的图像,在借助局部熵法求取大气透光强度的基础上,可以用式(10)计算透射率。

|

图 11 透射率随图像帧序列的变化曲线 Fig. 11 Curves of transmittance with image frame sequence |

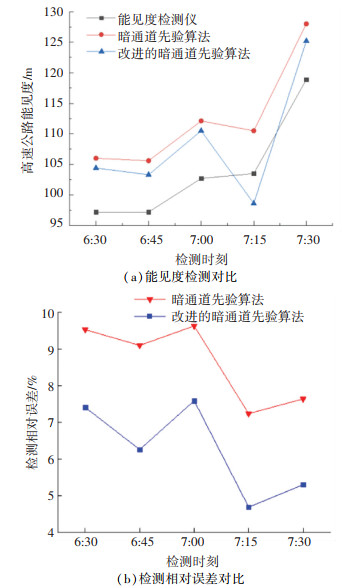

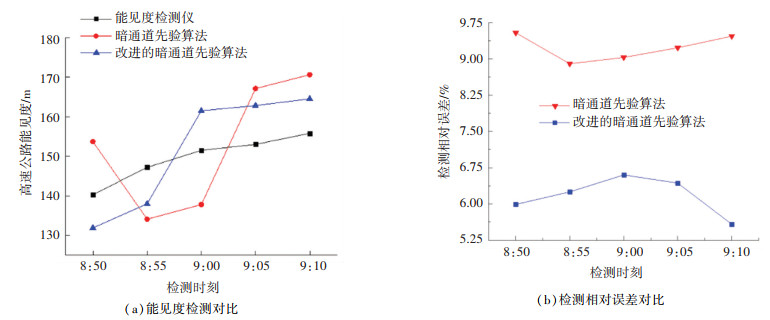

能见度检测仪是从6:30开始检测,第1组检测是从6:30到7:30,每两个检测时间点相隔15 min, 在每个检测时间点1 min内检测5次,并取均值,该时段的高速公路能见度为100 m左右, 5次检测结果分别为97.2、97.2、102.7、103.5、118.9 m。之后根据同一时刻的视频图像,将改进暗通道先验算法与传统暗通道先验算法进行对比实验,结果均和能见度检测仪的检测结果进行对比,能见度检测和误差对比结果分别见图 12(a)和图 12(b)。

|

图 12 第1组实验对比结果 Fig. 12 Comparison of results of the first set of experiments |

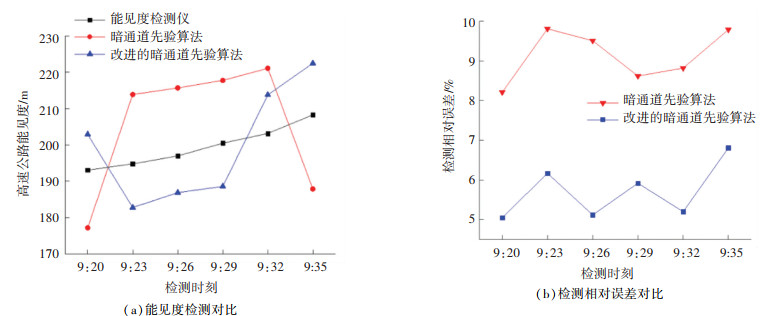

此后由于时间由清晨变为上午,光照逐渐增加,大雾消散的速度逐渐加快,能见度检测仪的检测时间间隔也在不断缩短。能见度检测仪的第2组检测是从8:50到9:10,每两个检测时间点相隔5 min,其余步骤与第1组检测相同,该时段的高速公路能见度为150 m左右,5次检测结果分别为140.3、147.2、151.5、153.0、155.8 m,实验对比结果如图 13(a)和图 13(b)所示。能见度检测仪的第3组检测是从9:20到9:35,每两个检测时间点相隔3 min,其余步骤与第1组检测相同,该时段的高速公路能见度为200 m左右,6次检测结果分别为193.1、194.8、197.0、200.5、203.2、208.3 m,实验对比结果如图 14所示。根据图 12(b)、13(b)和图 14(b),可以得到改进的暗通道先验算法在7:00左右、9:00左右、9:30左右检测的平均相对误差(MRE)分别为6.25%、6.17%、5.71%,同时也可以得到3组实验中改进算法与传统算法相对误差减小值(RER)对比结果,在7:00左右,即6:30—7:30期间,实际能见度在100 m左右,改进算法的5次检测的RER分别为2.12%、2.84%、2.04%、2.55%、2.34%;在9:00左右,即8:50—9:10,实际能见度为150 m左右,改进算法的5次检测的RER分别为3.55%、2.65%、2.43%、2.80%、3.89%;在9:30左右,即9:20—9:35,实际能见度在200 m左右,改进算法的6次检测的RER分别为3.16%、3.64%、4.39%、2.70%、3.62%、2.98%。因此,在7:00左右、9:00左右、9:30左右3个时刻改进算法的平均相对误差减小值(MRER)分别为2.38%、3.06%、3.41%。总体上改进暗通道先验算法的检测相对误差平均要比传统暗通道先验算法减小3%左右,即改进算法的精度有了一定提升,由此可证明改进暗通道法的精确性和实用性。

|

图 13 第2组实验对比结果 Fig. 13 Comparison of results of the second set of experiments |

|

图 14 第3组实验对比结果 Fig. 14 Comparison of results of the third set of experiments |

从第1组检测到第3组检测,时间从清晨7:00左右到上午10:00左右,光照不断地增强,每组检测的精度相比传统暗通道先验算法也在不断地提高,说明改进的暗通道算法对于日间时分比较适应。

5 结论1) 对传统暗通道法进行了如下改进:利用局部熵值法对大气透光强度值A进行了求取,能排除图像中灯光、白色或反光物体区域的干扰;再利用暗通道先验理论求出透射率t;采用K-means聚类算法,求出聚类后的视频图像中分界线的景深,由最小景深和所构建的测距模型得到该点到摄像机的实际距离,之后由能见度检测原理计算出能见度。

2) 在日间不同时段即不同梯度的能见度下,对改进暗通道先验算法与传统暗通道先验算法求取出的能见度进行了3组对比实验,分析表明:在二者检测精度都为10%以下的情况下,使用改进的暗通道先验算法求取出的能见度比使用传统算法的求取结果精确度仍能提高3%左右,这说明改进的暗通道先验算法能够更好地应用于雾霾环境下的高速公路。同时,通过对比3组实验的视频图像拍摄时刻可以发现,光照越强、能见度越高、检测精度提高越明显,说明所提出的算法在日间的雾天环境下的有效性更好。

3) 由于目前本研究只获得了日间雾天环境下的视频图像数据,因此所提出的能见度检测方法只是说明了在日间环境下的适用性。后续的研究应进一步考虑到高速公路全天的安全性,尤其是复杂多变的夜间环境。

| [1] |

WU Yina, ABDEL-ATY M, LEE J. Crash risk analysis during fog conditions using real-time traffic data[J]. Accident Analysis and Prevention, 2018, 114: 4. DOI:10.1016/j.aap.2017.05.004 |

| [2] |

THAKURIAH P, TILAHUN N. Incorporating weather information into real-time speed estimates: comparison of alternative models[J]. Journal of Transportation Engineering, 2013, 139(4): 379. DOI:10.1061/(ASCE)TE.1943-5436.0000506 |

| [3] |

GALLEN R, CORD A, HAUTIÈRE N, et al. Nighttime visibility analysis and estimation method in the presence of dense fog[J]. IEEE Transactions on Intelligent Transportation Systems, 2015, 16(1): 310. DOI:10.1109/TITS.2014.2331177 |

| [4] |

李长城, 刘小明, 荣建, 等. 不同能见度条件下高速公路车辆速度特性研究[J]. 交通运输系统工程与信息, 2014, 14(6): 213. LI Changcheng, LIU Xiaoming, RONG Jian, et al. Characteristics of vehicle speed for expressway under different visibility condition[J]. Journal of Transportation Systems Engineering and Information Technology, 2014, 14(6): 213. DOI:10.3969/j.issn.1009-6744.2014.06.035 |

| [5] |

AHMED M A, ABDEL-ATY M, LEE J, et al. Real-time assessment of fog-related crashes using airport weather data: a feasibility analysis[J]. Accident Analysis and Prevention, 2014, 72: 309. DOI:10.1016/j.aap.2014.07.004 |

| [6] |

RAHMAN M S, ABDEL-ATY M, WANG Ling, et al. Understanding the highway safety benefits of different approaches of connected vehicles in reduced visibility conditions[J]. Transportation Research Record: Journal of the Transportation Research Board, 2018, 2672(19): 91. DOI:10.1177/0361198118776113 |

| [7] |

黄鹤, 胡凯益, 郭璐, 等. 改进的海雾图像去除方法[J]. 哈尔滨工业大学学报, 2021, 53(8): 81. HUANG He, HU Kaiyi, GUO Lu, et al. Improved defogging algorithm for sea fog[J]. Journal of Harbin Institute of Technology, 2021, 53(8): 81. |

| [8] |

HAUTIERE N, LABAYRADE R, AUBERT D. Detection of visibility conditions through use of onboard cameras[C]// IEEE Proceedings of Intelligent Vehicles Symposium. Las Vegas: IEEE. 2005: 193

|

| [9] |

张潇, 李勃, 陈启美. 基于亮度特征的PTZ视频能见度检测算法及实现[J]. 仪器仪表学报, 2011, 32(6): 381. ZHANG Xiao, LI Bo, CHEN Qimei. PTZ visibility detection algorithm based on luminance characteristic and its implementation[J]. Chinese Journal of Scientific Instrument, 2011, 32(6): 381. |

| [10] |

杨娴, 李勃, 丁文, 等. 基于路面亮度特征估算的视频能见度检测系统[J]. 上海交通大学学报, 2013, 47(8): 1257. YANG Xian, LI Bo, DING Wen, et al. Visibility detection based on estimating characteristic luminance of road surface[J]. Journal of Shanghai Jiaotong University, 2013, 47(8): 1257. |

| [11] |

陆思文. 交通场景中基于深度学习的视频图像处理算法及应用研究[D]. 南京: 东南大学, 2019 LU Siwen. Research on video image processing algorithms and applications based on deep learning in traffic scene[D]. Nanjing: Southeast University, 2019 |

| [12] |

陈梅. 不利视觉下能见度检测及道路信息恢复方法研究[D]. 吉林: 吉林大学, 2019 CHEN Mei. Research on visibility detection and road information restoration method under unfavorable vision conditions[D]. Jilin: Jilin University, 2019 |

| [13] |

TAN R T. Visibility in bad weather from a single image[C]//2008 IEEE Conference on Computer Vision and Pattern Recognition. Anchorage: IEEE, 2008: 1

|

| [14] |

HAUTIÈRE N, TAREL J P, LAVENANT J, et al. Automatic fog detection and estimation of visibility distance through use of an onboard camera[J]. Machine Vision and Applications, 2006, 17(1): 8. DOI:10.1007/s00138-005-0011-1 |

| [15] |

徐喆, 陈美竹. 改进的雾霾天气交通标志图像去雾算法[J]. 计算机应用, 2017, 37(8): 2329. XU Zhe, CHEN Meizhu. Modified image dehazing algorithm of traffic sign image in fog and haze weather[J]. Journal of Computer Applications, 2017, 37(8): 2329. DOI:10.3969/j.issn.1001-3695.2017.08.021 |

| [16] |

宋洪军, 陈阳舟, 郜园园. 基于交通视频的雾天检测与去雾方法研究[J]. 控制工程, 2013, 20(6): 1156. SONG Hongjun, CHEN Yangzhou, GAO Yuanyuan. Research on the method for fog detection and removal based on traffic video[J]. Control Engineering of China, 2013, 20(6): 1156. DOI:10.3969/j.issn.1671-7848.2013.06.039 |

| [17] |

郭庚山. 基于视频图像的能见度检测算法的研究[D]. 长沙: 长沙理工大学, 2015. GUO Gengshan. Research on algorithms of video image visibility detection[D]. Changsha: Changsha University of Science & Techno-logy, 2015. |

| [18] |

HE Kaiming, SUN Jian, TANG Xiaoou. Single image haze removal using dark channel prior[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 33(12): 2341. DOI:10.1109/TPAMI.2010.168 |

| [19] |

CHENG Zhao, ZHANG Tianxu, YAN Luxin. Thresholding using two-dimensional histogram based on local entropy[C]//2010 2nd International Asia Conference on Informatics in Control, Automation and Robotics (CAR 2010). Wuhan: IEEE, 2010: 357

|

| [20] |

王泽胜, 董宝田, 赵芳璨, 等. 基于改进暗通道先验的交通图像去雾新方法[J]. 控制与决策, 2018, 33(3): 486. WANG Zesheng, DONG Baotian, ZHAO Fangcan, et al. Improved dehazing method for traffic images based on dark channel prior[J]. Control and Decision, 2018, 33(3): 486. |

| [21] |

中华人民共和国交通运输部. 公路工程技术标准: JTG B01—2014[S]. 北京: 人民交通出版社, 2014 Ministry of Transport of the People's Republic of China. Technical standard of highway engineering: JTG B01—2014[S]. Beijing: China Communications Press, 2014 |

2023, Vol. 55

2023, Vol. 55