地表裂缝,也称地裂缝,主要是由于地表岩石层、土体在自然因素(地震、山体滑坡、地面塌陷等)或人为因素(抽水、灌溉、开挖等)作用下产生开裂,并在地面形成一定长度和宽度裂缝的一种宏观地表破坏现象[1]。如果发生在有人类活动的地区时,便可成为地质灾害。地表裂缝是全世界普遍存在的潜在危害,快速检测出地表裂缝,可以有效减少地质灾害带来的损失,并起到预测作用。

传统的地裂缝识别方法是人工调查,劳动成本高,很多地方不易到达。随着科技技术的发展,出现了GPS[2-3]或GNSS[4]、InSAR[2-3, 5]、三维激光扫描[6]、卫星遥感[7]等先进检测技术。这些技术可以进行大面积、精准的扫描,易获密集的、海量的观测数据,工作人员可以全面直观的知道地面裂缝分布情况,但是上述仪器设备价格昂贵,检测成本相对较高,不适合地表裂缝常规排查。随着深度学习的快速发展,特别是卷积神经网络(Convolutional neural networks, CNN)在计算机视觉任务中取得的巨大成功,基于图像的目标辨识得到越来越广泛的应用。卷积神经网络由计算机自动进行视觉特征挖掘,在语义抽象能力上有大幅提升。文献[8-9, 11]分别提出了基于CNN的裂缝检测算法。Peng等[8]在CNN的基础上提出了DCNN-Inception网络,对于裂缝分类正确率98.2%,但是模型训练时间较长。Mao等[9]提出ME-Faster R-CNN,对Faster R-CNN(Fast region-based CNN)[10]进行改进,提高了模型的准确率,但是检测速度较慢。Cha等[11]利用CNN搭建了一个5层的网络,后面跟着全连接层对裂缝进行分类,该模型对图像光照要求较高。

目前,目标检测算法按照是否提前生成候选区域,可分为单阶段目标检测算法和双阶段目标检测算法两类。双阶段目标检测算法主要是以Fast R-CNN为主,由于需要提前生成候选区域,尽管准确度较高,但检测速度慢。单阶段目标检测算法主要是以YOLO(you look only once)系列和SSD(single shot multi box detector)[12]为主,两者都是基于网格与锚点实现,不需要二次回归[13],相对于双阶段目标检测算法,检测速度较快,准确率略低。YOLOv3[14]是YOLO系列较优的目标检测算法,框架采用Darknet-53,输出采用特征金字塔(Feature pyramid networks, FPN)的方式,进行了深层语义特征与浅层语义特征的多尺度融合[15],能够同时检测大目标、中目标、小目标,大大提高了目标检测的正确率,特别是小目标。地表裂缝目标小,且图形复杂,因此可以选用YOLOv3作为地表裂缝识别的检测算法。

由于YOLOv3模型参数计算量大,模型复杂,对于硬件要求高,因此不适合用于野外作业的小体积低功耗低算力移动端运算。本文提出的轻量化模型,采用移动端网络PeleeNet网络框架[16]代替Darknet-53,并结合特征注意力模块(Convolution block attention module, CBAM)[17]、改进的感受野模块(Receptive field block, RFB)[18]、深度可分离卷积(Depthwise separable convolutions, DSC)[19]和CIoU(Complete intersection over union)[20]损失,提高了目标检测的正确率,减少了运算计算量和参数量,提高了模型检测速率。

1 PeleeNet_yolov3裂缝检测 1.1 YOLOv3模型YOLOv3是一种端到端的物体检测模型,直接对锚框进行回归和分类,检测速率有大幅提升。YOLOv3的网络结构包含特征提取网络和检测网络。特征提取网络采用的框架是Darknet-53,包含了5个残差网络(Residual network, ResNet)[21],全部由3×3,1×1的卷积核组成。每个卷积核都是由卷积、批量归一化(Batch normalization, BN)、激活函数(Leaky ReLU, LR)组成。Darknet-53将3个尺度特征图输出到检测网络的3个分支,形成FPN。最后对FPN的输出进行边界框和类别预测。

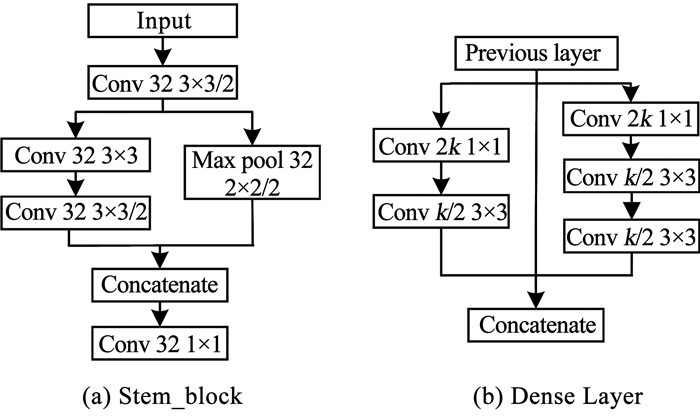

1.2 PeleeNet_yolov3网络PeleeNet是一种基于DenseNet[22]轻量化的变体,主要面向的是移动端应用。现有研究表明对于COCO数据集,PeleeNet不仅比SSD+ MobileNet更准确,也比YOLOv2更准确,算法速度相比YOLOv3提升5.6倍[16],因此本文选择PeleeNet代替Darknet-53框架。PeleeNet在模型的开始,设计了一种高效率的Stem模块,Stem结构如图 1(a)所示。密集单元Dense Layer的设计采用了两种尺度的卷积核同时进行特征挖掘,可以以最小的计算资源有效的提取特征,Dense Layer模块如图 1(b)所示。

|

图 1 Stem_block和Dense_layer结构图 Fig. 1 Structure of Stem_block and Dense_layer |

针对原始YOLOv3的模型参数量、计算量大,模型复杂,对于硬件要求高等问题,本文结合YOLOv3和PeleeNet两种框架的特点,提出了轻量级的实时目标检测网络,本文将其称为PeleeNet_yolov3,整体结构如图 2所示。在PeleeNet_yolov3特征提取网络中,使用PeleeNet的密集连接单元代替Darknet-53的残差单元,在密集单元内,增长率设为32,即每个密集单元都会被压缩到32个特征图,然后将32个新的特征图加入到全局特征。随着网络层数的加深、特征图的尺寸减小,需要更多的特征图来保持图像的特征,因此在整个网络中,采用了4级骨干网络,分别是3、4、8、16,过渡层(Transition_layer)通过1×1的卷积核进行特征融合,平均池化层进行下采样。PeleeNet通过密集单元,可以同时进行小目标和大目标的语义特征挖掘,为了进一步的提高模型准确率而不增加较多计算量的前提下,在第1个密集单元和检测网络的3个输入端添加CBAM模块,让模型在训练过程中更加关注特征图信息丰富的通道和图像区域,加快训练速度,提高模型的准确率。在特征提取网络输出特征图的大小为13×13的支路加入针对裂缝特征的RFB模块,模拟人类视觉机制,多尺度挖掘特征图的语义特征,让丰富的语义特征进行上采样,弥补浅层网络高级语义特征的不足,以完成裂缝目标识别的任务需求。为满足模型的检测速度而不过多的损失模型的准确率,在模型的检测网络中加入DSC。下面对网络的各个模块做出简要介绍。

|

图 2 PeleeNet_yolov3结构图 Fig. 2 Structure of PeleeNet_yolov3 |

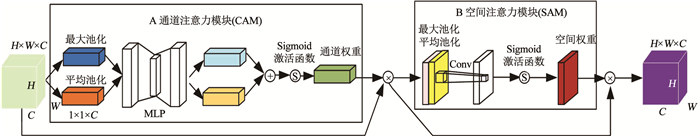

CBAM是一个有效的前馈神经网络特征注意力模块,包含通道注意力模块CAM(channel attention module)和空间注意力模块SAM(spatial attention module)。CAM关注通道方向上的信息权重,SAM关注空间方向上的信息权重。CBAM如图 3所示。

|

图 3 CBAM结构图 Fig. 3 Structure of CBAM |

CAM如图 3中A部分所示。输入H×W×C的特征图,经过最大池化层(Max pooling, MaxPool)和平均池化层(Average pooling, AvgPool)对特征图进行压缩,然后会形成两个1×1×C的通道描述,将两个通道描述经过多层感知机MLP(Multi-layer perception)两次全连接后相加,经过sigmoid函数转换为权重系数,与原来的特征相乘即可得权重占比不同的特征图。SAM如图 3中B部分所示。SAM沿着深度C方向进行最大池化和平均池化,得到两个不同的背景描述,对两个描述进行拼接,使用7×7卷积生成一个特征注意力卷积图,经过sigmoid激活函数,得到空间维度上的权重系数,将该生成的权重系数与输入相乘可得到空间区域占比不同的特征图。

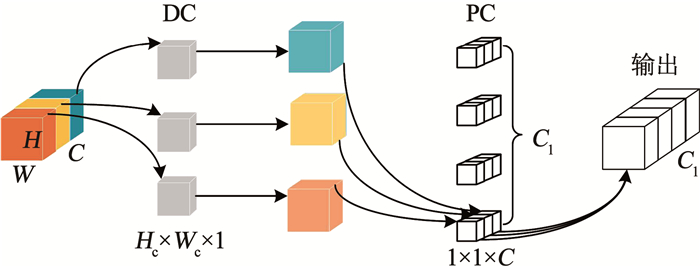

1.2.2 深度可分离模块为了进一步减少模型的计算量,在模型的检测网络中,使用MobileNet的DSC,如图 4所示,将模型的标准卷积分为深度卷积(Depthwise convolution, DC)和逐点卷积(Pointwise convolution, PC),以减少模型的参数量和大小。DSC首先进行DC,DC对于每个通道分别独立使用一个深度为1的卷积核进行特征提取,解决模型参数量冗余的问题。经过DC的各通道特征之间使用1×1的卷积核进行相互融合。现有研究结果表明,虽然加入DSC正确率略有降低,但模型参数大大减少且检测速度得到较大提升。例如,对于一个深度为C的特征图,若用Hc×Wc的标准卷积去得到一个深度为C1的特征图,需要的计算量为

| $ a=H_{\mathrm{c}} \times W_{\mathrm{c}} \times C \times C_1 $ | (1) |

|

图 4 DSC结构图 Fig. 4 Structure of DSC |

如果使DSC完成同样的工作,需要的计算量为

| $ b=H_{\mathrm{c}} \times W_{\mathrm{c}} \times C+C \times C_1 $ | (2) |

最后可以推出DSC与标准卷积之间的计算量比值为

| $ \frac{b}{a}=\frac{H_{\mathrm{c}} \times W_{\mathrm{c}} \times C+C \times C_1}{H_{\mathrm{c}} \times W_{\mathrm{c}} \times C \times C_1}=\frac{1}{C_1}+\frac{1}{H_{\mathrm{c}} \times W_{\mathrm{c}}} $ | (3) |

由此可见,利用DSC,计算量和参数相比标准卷积会大幅度下降,这样的改进能够显著地提高检测速度。

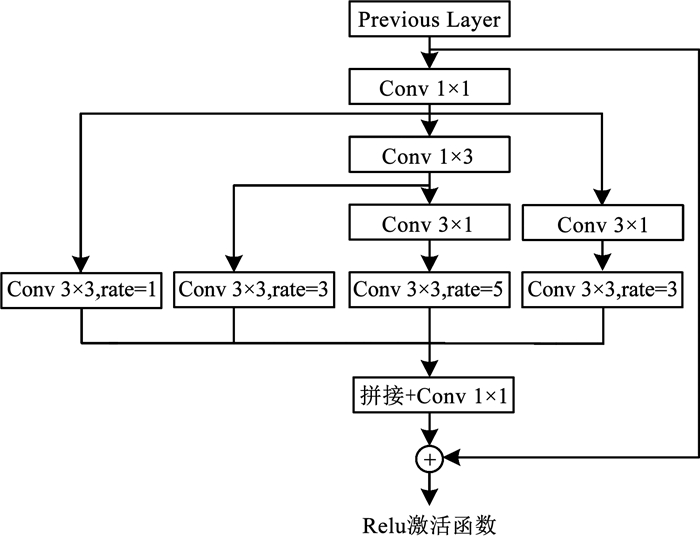

1.2.3 针对裂缝特征的RFB卷积核的多路复用不会改变RFB对不同目标尺度的感知,为了进一步减少模型的参数和运算量,针对裂缝特征,本文对RFB进行了改进。将RFB分支2的3×3卷积核,分支3的5×5卷积核利用1×3,3×1的卷积核代替,大膨胀率的非对称卷积[23]适用于多尺度的裂缝形态分布,可以捕获其非局部特征,并让1×1的卷积核进行多路复用,由于P_RFB输入通道数和输出通道数一致,故文献[24]可以选择直接相连,最终可训练参数相对于RFB减少了38%,同时使模型有更好的非线性表达能力,且从信息传输的角度来看,P_RFB的多分支结构已经通过不同的视觉大小获取信息,故文献[24]选择直接相连,让信息的传输变得更加流畅,增加了P_RFB模块中信息的多样性,提高了模型在浅层中提取高级语义特征的能力,显著提高裂缝检测的性能。改进后的P_RFB如图 5所示。

|

图 5 P_RFB结构图 Fig. 5 Structure of P_RFB |

YOLOv3的损失函数使用的均方差(MSE)去判断候选框和真实框之间的匹配程度,但是均方差对于预测框位置的敏感性不够,候选框在不同位置时,其损失值可能相同,导致损失函数不能收敛到最小。本文选用CIoU来代替均方差损失。CIoU是在DIoU(Distance IoU loss)上改进而来的,DIoU损失函数考虑了预测框与真实框之间的重叠比、中心点距离等因素的影响,使候选框时刻保持梯度回传,更好的优化了边界框的位置信息。DIoU的计算公式为

| $ L_{\mathrm{DloU}}=1-\frac{|A \cap B|}{|A \cup B|}+\frac{\rho^2\left(b, b^{\mathrm{gt}}\right)}{c^2} $ | (4) |

式中:c为能够同时包围候选框A和真实框B的最小框的对角线距离,d为两个框中心点的距离,b、bgt分别为候选框与真实框的中心点,ρ2为求其距离,如图 6所示。

|

图 6 DIoU示意图 Fig. 6 Schematic diagram of DIoU |

CIoU相对DIoU引入了一个对于候选框与真实框长宽比的惩罚项,CIoU的计算公式如式(5)所示。裂缝属于小目标,为了深入加强对于小目标的检测,在位置回归损失部分,加上一个惩罚项(2-w×h), 其中w、h分别为真实框的宽、高,当真实框较小,其惩罚项系数较大,加强对于小目标的检测,提高模型的准确率。

| $ L_{\mathrm{CloU}}=L_{\mathrm{DloU}}+\alpha v $ | (5) |

式中:v为衡量长宽比一致性的参数,α为正权衡参数。v、α的计算公式如下:

| $ v=\frac{4}{\pi^2}\left(\arctan \frac{w^{\mathrm{gt}}}{h^{\mathrm{gt}}}-\arctan \frac{w}{h}\right)^2 $ | (6) |

| $ \alpha=\frac{v}{\left(1-\left|\frac{A \cap B}{A \cup B}\right|\right)+v} $ | (7) |

式中:w、h分别为候选框的宽、高,wgt、hgt分别为真实框的宽、高。最终模型候选边界框与真实边界框的位置部分损失函数为

| $ L_{\text {coord }}=\sum\limits_{i=0}^{s^2} \sum\limits_{j=0}^k\left(2-w_i \times h_i\right) \times L_{\mathrm{CloU}} $ | (8) |

式中:wi、hi分别为第i个真实框的宽、高,s为划分网格的数目,输出特征图的网格大小为s×s,k为候选框的数量。

2 实验 2.1 配置与训练实验室平台配置如下:Intel Core i5-9600F@2.40 GHz×4 CPUs,NVIDIA GeForce GTX 960。主要工作内容包括数据集的制作、代码编写等。模型训练采用的是谷歌云平台:Colab,分配的GPU:Tesla T4,深度学习框架:tensorflow 1.5,python版本为3.7。

训练时,一个批次包含16幅416×416的图像,动量参量为0.99,采用随机梯度下降(SGD),设置的最大epoch为140,最大的迭代次数为19 458,衰减系数为0.005。为防止梯度爆炸,使用学习率预热的方式,在276次迭代后将学习率提升到初始学习率0.001大小,预热时学习率较小模型慢慢趋于稳定,加快模型的训练速度。随后的训练学习率采用余弦衰减(cosine_decay)的衰减方式,余弦衰减根据迭代的次数进行学习率的衰减,如图 7(a)所示。在迭代的初期,训练的学习率与学习步长较大,模型的收敛速度较快。在迭代的后期,训练的学习率接近设置的最小学习率,有助于模型的收敛,逐步逼近最优点。改进后的模型损失函数下降如图 7(b)所示。由图 7可知,模型最终在迭代17 500次以后,损失值趋于稳定,最终收敛在0.45左右。

|

图 7 训练过程可视化 Fig. 7 Visualization of training process |

实验数据来源于无人机在中国易于发生地质灾害的某地进行飞行拍照,共采集到200张分辨率为5 472×3 078的图片,并将图片中含裂缝的区域裁剪成256×256的大小,并且通过水平、垂直、90°和180°随机翻转增加数据集的数量,同时加入部分无缺陷的地面图像,提高数据的鲁棒性。数据集的格式采用xml对地表裂缝进行标记和定位。图片最终数量为2 460张,按照比例为7∶ 3划分为训练集和测试集。

地表裂缝数据集匮乏,且具有连续性、延长性的特点,导致标签的制作没有规则,会造成模型预测困难,易导致模型损失函数震荡,且部分地表裂缝的背景颜色复杂,造成模型训练困难。本文,先将图片剪切成256×256的大小,基于裂缝走向变换和出现裂缝分支,重新绘制标签框并让标签框包含较少的背景色占比,从而可以减少模型训练的困难和模型预测结果的重复性。标签制作如图 8所示。

|

图 8 标签制作 Fig. 8 Label making |

为了验证本文改进算法的有效性,本文在制作的数据集上进行了各类方法的消融实验。各类方法的消融实验结果见表 1。其中AP(average precision)为一类的MAP(mean average precision); AR(average recall)为平均召回率; AR50、AP50分别为当IOU=0.50时的平均检测精度和平均召回率; AR75、AP75分别为当IOU=0.75时的平均检测精度和平均召回率; GFLOPs为模型的浮点计算量; 模型大小给出了模型的参数量; F1(50) 为当IOU=0.50时的调和均值。

| 表 1 在裂缝数据集上消融实验结果 Tab. 1 Results of ablation experiments on the fracture data set |

由表 1可知,编号2使用PeleeNet作为主体框架,与主体框架为Darknet-53的编号1对比可知,模型的平均精度、平均召回率、F1均有下降,但模型的参数只有编号1的40%,检测速度提高了64%,达到了41帧/s; 编号3在编号2的基础上,将模型的边界框损失函数换为CIoU,AP50、AP75和召回率方面均有提高,说明引入CIoU损失对于裂缝检测的各项指标有较为明显的提高,有效解决了训练过程中对于锚框的不敏感性; 编号4将检测网络中3×3的标准卷积换为DSC,模型的参数量进一步减少,各项指标与编号1基本能保持,检测速度达到了46帧/s; 编号5是在模型4的基础上,添加了改进的P_RFB, 各项评价指标均得到了提升,表明P_RFB有效融合了不同尺度的语义信息,提高检测网络的深层语义信息挖掘能力,但也导致模型的参数量小幅增加,使得检测速度降低了3帧/s; 编号6在编号5的基础上添加了CBAM模块,与之前编号为1、2、3、4、5模型对比可知,改进效果提升显著,与编号1相比,参数量减少69.78%,检测速度提高5帧/s,AP50提升6.76%,AP75提升9.67%,验证了加入CBAM的有效性。综合表 1中各组实验对比数据,可以验证本文算法的各项改进能有效提高对于地面裂缝的检测。改进网络的部分检测结果如图 9所示。

|

图 9 部分裂缝的检测结果 Fig. 9 Detection results of some cracks |

为了验证特征注意力模块CBAM位置对于网络框架的影响,在上述编号5的基础上,本文对于CBAM位置进行了以下研究。CBAM在特征提取网络位置见表 2。表中√为加入CBAM,√*为检测网络输入端加入CBAM,×为不加入CBAM。

| 表 2 CBAM不同位置 Tab. 2 Different locations of CBAM |

编号1将CBAM加在模型特征提取网络过渡层最大池化层后。编号2将CBAM位置加在过渡层在模型检测网络的3个输入端,如图 2中①,②两点所示。编号3是将CBAM位置插入到密集层,如图 2的Dense_cbam所示。编号4是在编号1,3的基础上进行组合。由表 3可知,编号1、2、3、4在加入特征注意力CBAM后,模型的平均召回率、检测精度都有提升,编号4地面裂缝检测的各项指标提升最大,但是模型的检测速度比YOLOv3低了40%,说明在密集层加入CBAM对于地面裂缝的检测效果有大幅提升,模型的浮点计算量GFLOPs和参数量略有增加,但是网络层数大幅增加,使得检测速度下降了约20帧/s; 编号1和编号2的各项指标检测效果近似,为了维持模型的检测速度,提高平均召回率、平均精确度和F1,在编号1、2模型的第1个密集块插入CBAM,通过对比可知,编号6比编号5的AP50提升了1.51%,AR50提升2.00%,AR75和AP75相对编号1、2、3、5提升最大且能保证模型的检测速度。本文最终选择在第1个密集块和检测网络的3个输入端插入CBAM。上述实验表明,加入CBAM的位置,对于模型浮点计算量GFLOPs和参数数量影响较小,对于检测速度具有较大影响。CBAM不仅能给网络性能带来实质性的提升,而且增加的计算量和参数量很少,全连接层和卷积层带来的计算开销可以忽略不计。

| 表 3 在裂缝数据集CBAM不同位置实验结果 Tab. 3 Experimental results at different positions of CBAM in the fracture data set |

为了验证本网络在地表裂缝识别上的优异性,选择经典的模型进行对比,分别选择了SSD,Faster-RCNN以及YOLOv3及其改进算法,包括YOLOv3-spp,YOLOv3-IouLoss。实验配置采用相同的配置,在裂缝数据集上进行了对比。结果见表 4。

| 表 4 在裂缝数据集上不同模型对比实验结果 Tab. 4 Comparison of experimental results of different models on the fracture data set |

YOLOv3,SSD是单目标检测的代表作,这里SSD选择的SSD300,选择VGG16作为骨干网络,在6个层次特征图上进行多尺度检测,直接对8 732个不同尺度的默认框对应的目标位置和类别信息进行预测。Faster-RCNN是二阶段目标检测的代表性著作,使用区域性生成网络(Region proposal network,RPN)代替了选择性搜索算法,然后在目标区域上进行边框回归和分类,得到目标位置和类别信息。

由表 4可知,本文提出的平均召回率、平均精度均高于SSD300、Faster-RCNN、YOLOv3及其改进算法。本文提供的模型旨在用于无人机地表裂缝检测,模型参数量小、浮点运算量小、准确度高,有益于用于小体积低功耗移动端的地表裂缝辨识。

2.3.4 地表裂缝移动端部署为了验证本网络在移动端对于地表裂缝的识别效果,本文选择Google的TensorFlow Lite框架进行模型部署。TensorFlow Lite是一种在设备端运行TensorFlow模型的开源深度学习框架,是一个轻量、快速、跨平台的专门针对移动和IoT应用场景的机器学习框架, 是开源机器学习平台TensorFlow的重要组成部分[25]。开发者可以在此基础上进行移动端部署,开发出APP,将算法在移动端运行。

首先将在TensorFlow环境下训练的本文网络模型的PeleeNet_yolov3.ckpt文件转换为tflite数据格式的PeleeNet_yolov3.tflite文件。然后搭建Android地表裂缝识别项目工程,将模型载入VIVO S6手机。地表裂缝识别算法在VIVO S6手机测试结果如图 10所示。由图 10可知,本文算法在移动端可以正确识别到地表裂缝,且一张地表裂缝图在VIVO S6的CPU、GPU上检测时间约为145、65 ms,其检测速度约为7、15帧/s,可以达到移动端实时检测识别的效果。

|

图 10 移动端地表裂缝检测结果 Fig. 10 Mobile terminal surface crack detection results |

1) 经典的YOLOv3网络对地表裂缝缺陷检测的准确度较高,但是模型参数量大,硬件资源要求高,不适合移动端的部署,难以满足实际需求。

2) 采用轻量级网络PeleeNet作为特征提取网络,结合特征注意力模块CBAM和改进的P_RFB,加入深度可分离卷积进一步对网络结构进行优化调整,并通过CIoU对损失函数进行改进,最终模型的准确率AP50达到97.68%,AP75达到77.87%,可以解决裂缝目标检测问题。

3) 实验表明,PeleeNet_yolov3在地表裂缝数据集上取得了较优的结果,检测精度和检测速度均优于YOLOv3与部分已有的公共目标检测算法,且本文模型在VIVO S6移动端可识别图像检测速度约为15帧/s,说明本文提出算法的准确率高,模型参数量和计算量小,适用于小体积低功耗低算力运算平台。

| [1] |

卢全中, 李聪, 刘聪, 等. 地裂缝分类及地面沉降区构造地裂缝防治对策[J]. 地球科学与环境学报, 2021, 43(2): 366. LU Quanzhong, LI Cong, LIU Cong, et al. Classification of ground Fissures and Prevention Measures of Tectonic Ground fissuresin Land subsidence area[J]. Journal of Earth Sciences and Environment, 2021, 43(2): 366. DOI:10.19814/j.jese.2020.11050 |

| [2] |

张勤, 赵超英, 丁晓利, 等. 利用GPS与InSAR研究西安现今地面沉降与地裂缝时空演化特征[J]. 地球物理学报, 2009, 52(5): 1214. ZHANG Qin, ZHAO Chaoying, DING Xiaoli, et al. Research on recent characteristics of spatio-temporal evolution and mechanism of Xi'an land subsidence and ground fissure by using GPS and InSAR techniques[J]. Chinese Journal of Geophysics, 2009, 52(5): 1214. DOI:10.3969/j.issn.0001-5733.2009.05.010 |

| [3] |

FERGASON K C, RUCKER M L, PANDA B B. Methods for monitoring land subsidence and earth fissures in the Western USA[J]. Proceedings of the International Association of Hydrological Sciences, 2015, 372(12): 361. DOI:10.5194/piahs-372-361-2015 |

| [4] |

许强, 董秀军, 李为乐. 基于天-空-地一体化的重大地质灾害隐患早期识别与监测预警[J]. 武汉大学学报·信息科学版, 2019, 44(7): 957. XU Qiang, DONG Xiujun, LI Weile. Integrated space-air-ground early detection, monitoring and warning system for potential catastrophic geohazards[J]. Geomatics and Information Science of Wuhan University, 2019, 44(7): 957. DOI:10.13203/j.whugis20190088 |

| [5] |

QIU Zhiwei, JIANG Tingchen, ZHOU Li, et al. Study of subsidence monitoring in Nanjing City with small-baseline InSAR approach[J]. Geomatics Natural Hazards & Risk, 2019, 10(1): 1412. DOI:10.1080/19475705.2019.1572660 |

| [6] |

曾庆鲁, 张荣虎, 卢文忠, 等. 基于三维激光扫描技术的裂缝发育规律和控制因素研究——以塔里木盆地库车前陆区索罕村露头剖面为例[J]. 天然气地球科学, 2017, 28(3): 397. ZENG Qinglu, ZHANG Ronghu, LU Wenzhong, et al. Fracture development characteristics and controlling factors based on 3D laser scanning technology: An outcrop case study of Suohan village, Kuqa foreland area, Tarim Basin[J]. Natural Gas Geoscience, 2017, 28(3): 397. DOI:10.11764/ji.ssn.1672G1926.2017.02.004 |

| [7] |

侯恩科, 张杰, 谢晓深, 等. 无人机遥感与卫星遥感在采煤地表裂缝识别中的对比[J]. 地质通报, 2019, 38(2/3): 443. HOU Enke, ZHANG Jie, XIE Xiaoshen, et al. Contrast application of unmanned aerial vehicle remote sensing and satellite remote sensing technology relating to ground surface cracks recognition in coal mining area[J]. Geological Bulletin of China, 2019, 38(2/3): 443. DOI:10.12097/j.issn.1671-2552.2019.2-3.025 |

| [8] |

PENG Guili, TUO Xianguo, SHEN Tong, et al. Recognition of rock micro-fracture signal based on deep convolution neural network inception algorithm[J]. IEEE Access, 2021, 9(99): 89390. DOI:10.1109/ACCESS.2021.3086630 |

| [9] |

MAO Yingchi, PING Ping, CHEN Jing, et al. Crack detection with multi-task enhanced faster R-CNN model[C]//Proceedings of the 6th International Conference on Big Data Computing Service and Applications (BigDataService). Oxford, UK: IEEE, 2020: 193. DOI: 10.1109/BigDataService49289.2020.00044

|

| [10] |

REN Shaoqing, HE Kaiming, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2017, 39(6): 1137. DOI:10.1109/TPAMI.2016.2577031 |

| [11] |

CHA Y J, CHOI W, BVYVKÖZTVRK O. Deep learning-based crack damage detection using convolutional neural networks[J]. Computer-Aided Civil and Infrastructure Engineering, 2017, 32(5): 361. DOI:10.1111/mice.12263 |

| [12] |

LUI Wei, ANGUELOV D, ERHAN D, et al. SSD: Single shot multibox detector[C]//European Conference on Computer Vision. Cham: Springer, 2016: 21. DOI: 10.1007/978-3-319-46448-0_2

|

| [13] |

姜维, 张重生, 殷绪成. 基于深度学习的场景文字检测综述[J]. 电子学报, 2019, 47(5): 1152. JIANG Wei, ZHANG Chongsheng, YIN Xucheng. Deeplearning based scene text detection: A survey[J]. Acta Electronica Sinica, 2019, 47(5): 1152. DOI:10.3969/j.issn.0372-2112.2019.05.024 |

| [14] |

REDMON J, FARHADI A. YOLOv3: An incremental improvement[C]. Computer Vision and Pattern Recognition. arXiv Preprint, 2018, arXiv: 1804.02767. DOI: 10.48550/arXiv.1804.02767

|

| [15] |

罗会兰, 陈鸿坤. 基于深度学习的目标检测研究综述[J]. 电子学报, 2020, 48(6): 1230. LUO Huilan, CHEN Hongkun. Survey ofobject detection based on deep learning[J]. Acta Electronica Sinica, 2020, 48(6): 1230. DOI:10.3969/j.issn.0372-2112.2020.06.026 |

| [16] |

WANG R J, LI Xiang, LING C X. Pelee: A real-time object detection system on mobile devices[C]//Proceedings of the 32nd International Conference on Neural Information Processing Systems. Montréal Canada: Curran Associates Inc., 2018: 1967

|

| [17] |

WOO S, PARK J, LEE J Y, et al. CBAM: Convolutional block attention module[C]//Proceedings of the European Conference on Computer Vision. Munich, Germany: Springer Verlag, 2018: 3. DOI: 10.1007/978-3-030-01234-2_1

|

| [18] |

LIU Songtao, HUANG Di, WANG Yunhong. Receptive field block net for accurate and fast object detection[C]//Proceedings of the European Conference on Computer Vision. Cham: Springer International Publishing, 2018: 385. DOI: 10.48550/arXiv.1711.07767

|

| [19] |

HOWARD A G, ZHU Menglong, CHEN Bo, et al. MobileNets: Efficient convolutional neural networks for mobile vision applications[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Hawaii: IEEE, 2017: 1704. DOI: 10.48550/arXiv.1704.04861

|

| [20] |

ZHENG Zhaohui, WANG Ping, LIU Wei, et al. Distance-IoU loss: Faster and better learning for bounding box regression[C]// Proceedings of the AAAI Conference on Artificial Intelligence. [S. l.]: AAAI, 2020. DOI: 10.48550/arXiv.1911.08287

|

| [21] |

HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV: IEEE Computer Society, 2016: 770. DOI: 10.1109/CVPR.2016.90

|

| [22] |

HUANG Gao, LIU Zhuang, VAN Der MAATEN L, et al. Densely connected convolutional networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI: IEEE Computer Society, 2017: 4700. DOI: 10.1109/CVPR.2017.243

|

| [23] |

YU F, KOLTUN V, FUNKHOUSER T. Dilated residual networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI: IEEE, 2017: 636. DOI: 10.1109/CVPR.2017.75

|

| [24] |

SZEGEDY C, LIU Wei, JIA Yangqing, et al. Going deeper with convolutions[C]//Proceedings of the Computer Vision and Pattern Recognition. Boston, MA: IEEE Computer Society, 2015: 1. DOI: 10.1109/CVPR.2015.7298594

|

| [25] |

李双峰. TensorFlow Lite: 端侧机器学习框架[J]. 计算机研究与发展, 2020, 57(9): 1839. LI Shuangfeng. TensorFlow lite: On-device machine learning framework[J]. Journal of Computer Research and Development, 2020, 57(9): 1839. DOI:10.7544/issn1000-1239.2020.20200291 |

2023, Vol. 55

2023, Vol. 55