2. 西安市智慧高速公路信息融合与控制重点实验室(长安大学), 西安 710064

2. Xi'an Key Laboratory of Intelligent Expressway Information Fusion and Control (Chang'an University), Xi'an 710064, China

无人机航拍图像是交通信息获取、路况勘察预警以及城市计算的重要手段,而雾霾天气严重影响无人机有用图像信息的获取,因此,图像去雾对提升视觉系统的可靠性尤为重要。目前的主流方法是基于物理模型的图像去雾,通过求解不同模型参数复原图像。文献[1]提出了一种基于深度关系的图像去雾算法,文献[2]在此基础上改进了对场景深度信息的获取。但以上两种方法都需要借助外界设备来实现场景测距获取场景深度,实际应用中过于复杂。文献[3]提到的大气散射模型目前被广泛应用,可以通过反推雾霾图像成像的过程,得出清晰图像。其中,场景深度的获取是求解大气光模型参数的关键,这也是目前的研究热点。景深未知时,则无法进行求解。为了解决这一问题,国内外学者分析雾霾图像特征,提出了诸多先验理论,文献[4]提出了最大化局部对比度先验理论用于图像去雾,文献[5]提出了目前图像去雾领域应用最广的暗通道先验理论(dark channel prior,DCP),采用暗通道前0.1%像素作为大气光值,并提出软抠图法细化初始透射率,取得较好的效果。但以上两种方法的计算量较大且天空区域易失真。文献[6]提出了引导滤波,之后又提出了快速引导滤波[7]提高计算效率,但无法有效解决天空区域失真。文献[8]提出用大气光图改进DCP算法,在图像亮度上得到很大提升,但失真问题依然存在。文献[9]通过分析HSV颜色空间下的图像,提出颜色衰减先验理论(color attenuation prior,CAP),提高了运算效率,不受天空区域限制,但对浓雾区域去雾效果不佳,且透射率准确度低。文献[10-11]通过分析含雾图像在RGB颜色空间的像素分布规律,提出了雾霾线先验理论(haze-lines prior, HLP),通过雾霾线估计大气光值和透射率,有效避免了局部先验理论造成的光晕和伪影效应,提高了透射率估计精度,但仍存在天空区域失真的现象,需要进一步修正。另外,近年不少研究者将深度学习应用到图像去雾中。文献[12]首次提出了基于卷积神经网络的图像去雾方法DehazeNet,但采用人工合成雾图训练,缺少真实的含雾数据库,复原户外含雾图像时对于场景深度变化较大的图像复原效果有待提高。而实际应用中,无人机航拍图像通常含有大量天空区域,以上算法对天空区域的处理都存在失真。因此,本文提出一种融合大气光值-图估计的无人机航拍图像去雾方法,获取更精确的大气光图,能够提高图像亮度,有效地减少天空区域失真造成的影响。并结合修正的雾霾线先验理论来实现去雾,从而获得清晰的复原图像。

1 大气散射模型及其改进 1.1 大气散射模型雾霾在成像过程中会阻挡光线传播,对不同波长的光线造成等量散射,使天空区域呈白灰色,还会造成图像对比度、色彩饱和度及能见度较低。文献[13-14]分析了大气散射对图像降质的影响,提出了大气散射模型,从成像角度描述了光线进入采集设备参与成像的过程,是理解雾霾图像降质过程、复原无雾图像的重要依据[15],见图 1。

|

图 1 大气散射模型 Fig. 1 Atmospheric scattering model |

根据大气散射模型,参与成像的光线可分成大气光和反射光两部分,大气光部分是由光源经由空气中悬浮微粒散射后进入图像采集设备,反射光部分是场景内物体表面反射的光线,经过光路上的悬浮微粒散射后进入图像采集设备。光线经散射衰减的程度随离采集设备距离增大而增大。对上述过程,建立大气散射模型见下式:

| $ \boldsymbol{E}(d, \lambda)=\boldsymbol{E}_d(d, \lambda)+\boldsymbol{L}(d, \lambda) $ | (1) |

式中:d为成像像素坐标对应的景深; E(d, λ)为到达图像采集设备的总光强; Ed及L分别为经物体表面反射光散射和大气光散射的光强。假设有雾和无雾时物体表面反射光和大气光的光强都相等,通过估计雾霾环境下光线的透射效率t(x),可得到含雾降质图像I(x)与无雾清晰图像J(x)关系见式(2):

| $ \boldsymbol{I}(x)-\boldsymbol{A}=[\boldsymbol{J}(x)-\boldsymbol{A}] \boldsymbol{t}(x) $ | (2) |

式中A为无穷远处的大气光强。由此得到雾天图像降质模型见式(3):

| $ \boldsymbol{I}(x)=\boldsymbol{J}(x) \boldsymbol{t}(x)+\boldsymbol{A}(1-\boldsymbol{t}(x)) $ | (3) |

可以看出,基于物理模型的图像去雾算法的核心就是对透射率t(x)及大气光A的求解。

1.2 对大气散射模型的改进式(3)中,大气光值A是单一的,将太阳光理解为一束能量相同平行光源,但在实际传播过程中,不同像素点的大气光值会经过不同程度衰减。因此,可以通过将大气光值设计为大气光图来提升大气光估计的准确度,见图 2。

|

图 2 改进的大气散射模型 Fig. 2 Improved atmospheric scattering model |

为进一步提高大气光的准确性和复原图像质量,结合图 2提出一种融合大气光值-图估计的无人机航拍图像去雾方法,根据颜色衰减先验获得最小偏差的大气光值估计,通过自适应随机游走(adaptive random walk,ARW)进行大气光图估计。算法流程见图 3。

|

图 3 算法总流程图 Fig. 3 Overall flow chart of algorithm |

算法具体步骤如下:

1) 获取含雾图像I;

2) 利用CAP的最小偏差对大气光值估计,根据颜色衰减先验,求取图像最小偏差区域作为大气光所在区域,将该区域取均值作为大气光Acap;

3) 基于ARW聚类对大气光图进行估计,根据图像特征提取图像的种子点,利用ARW将图像聚类成N个子区域,求取各子区域前0.1%作为该区域大气光,利用引导滤波将图像大气光图ARW进一步优化;

4) 将LDCAP获得的大气光值Acap与基于随机游走聚类的大气光图ARW融合,获得新的大气光图A;

5) 根据HLP求解透射率;

6) 根据暗通道图像求解暗补偿,并根据补偿域对透射率进行补偿优化;

7) 将新的大气光图和补偿优化后的透射率估计代入雾天图像退化模型求解复原图像。

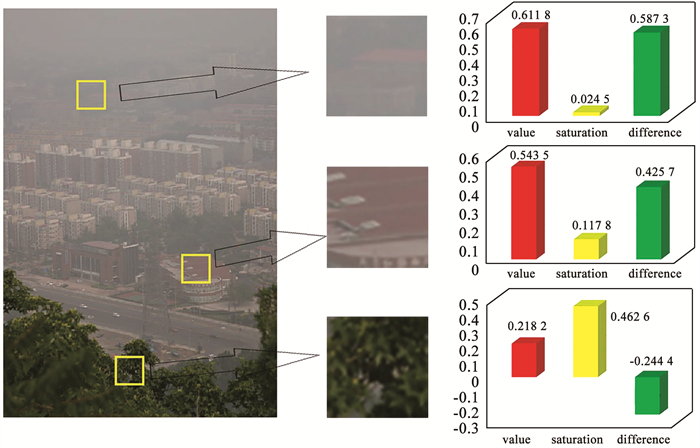

3 求解大气光值-图的融合估计 3.1 基于LDCAP的大气光值估计 3.1.1 CAP原理CAP是一种基于局部统计的先验理论。2015年,Zhu等[9]通过对多幅含雾图像在HSV色彩空间下的特征信息分析发现,随场景深度和雾霾浓度变化,含雾图像局部区域内像素点对应的亮度及色彩饱和度也发生显著变化,见图 4。

|

图 4 不同景深位置上亮度与色彩饱和度变化 Fig. 4 Changes in brightness and color saturation at different depth-of-field positions |

图中左侧选取了3个场景深度不同及雾霾浓度相差巨大的局部区域,右侧从下至上依次为对应HSV颜色空间下的3个区域——亮度(图中的value)通道、色彩饱和度(saturation)通道及两通道差值(difference)的变化情况。结合大气散射模型分析可知: 一方面,设备采集图像的场景光线由于雾天空气中的悬浮微粒散射衰减严重,导致色彩饱和度显著降低;另一方面,天空中未反射的大气光直接参与成像,使天空区域亮度明显提高。同时,空气中悬浮微粒数量越多,大气光对图像成像效果的影响越严重,图像亮度v(x, y)与色彩饱和度s(x, y)之差越大。根据这一规律,Zhu等[9]认为,随雾霾浓度及场景深度增大,图像局部区域亮度与色彩饱和度之差增大,如下所示:

| $ \boldsymbol{d}(x, y) \propto \boldsymbol{c}(x, y) \propto \boldsymbol{v}(x, y)-\boldsymbol{s}(x, y) $ | (4) |

式中:d(x, y)为像素点(x, y)的景深,c(x, y)为像素点(x, y) 的雾霾浓度。

3.1.2 LDCAP的大气光值估计CAP将景深最大处作为大气光值,这会受到图像中极值和噪声影响。因此,提出一种基于CAP的最小偏差大气光值估计(least deviations color attenuation prior,LDCAP)。首先,根据CAP求取景深图

| $ \boldsymbol{I}_d(x, y)=\boldsymbol{I}_{\mathrm{v}}(x, y)-\boldsymbol{I}_{\mathrm{s}}(x, y) $ | (5) |

式中Iv(x, y)和Is(x, y) 分别为图像在HSV空间中对应的V通道和S通道。对图像中任意点附近区域的景深图进行比较,求取偏差最小的区域,将此定为图像大气光所在区域,如下所示:

| $ \boldsymbol{M}_{\boldsymbol{A}}(i, j)=\min\limits_{\boldsymbol{\varOmega}(i, j) \in I_d(i, j)}\{\delta[\boldsymbol{\varOmega}(i, j)]\} $ | (6) |

式中:MA(i, j) 为大气光值所在的中心区域,Ω(i, j)为景深图Id中以(i, j)为中心的局部区域。为了避免部分场景深度值过大对大气光估计的影响,求解该区域像素点的均值,作为大气光取值Acap,公式表示如下:

| $ \boldsymbol{A}_{\text {cap }}=\underset{\varOmega}{\operatorname{average}}\left[\boldsymbol{M}_{\boldsymbol{A}}(i, j)\right] $ | (7) |

此方法考虑周围像素间的影响,能减少区域内噪声的影响,但不能反映整幅图像各点大气光的差异。因此,需要与大气光图融合获得更精确的大气光估计。

3.2 基于随机游走聚类的大气光图估计 3.2.1 随机游走随机游走(random walk, RW)是由Karl Pearson提出的一种类似于布朗运动的不规则运动,属于理想的数学状态[16]。它将图像作为离散对象,把图像问题转换为带权图的问题来求解。为方便叙述,对图进行统一定义。将处理的图像映射成一个图G=(U, E, W),由节点ui∈ U、边界e∈E⊆U×U以及权重值w组成,其中权值亦记为w(eij)或(wij)。eij为两个顶点ui和uj组成的边,对应每条边都有一定的权值,表示两个顶点之间的相似程度。定义任意顶点vi的度为fi=∑w(eij),是所有经过节点ui的边的权值和。同时,假设wij>0, 且wij=wji。通过这种方法,在处理图像的同时,充分考虑图像各点,各边权重及其相互影响。有利于提高处理结果的准确性。但随机游走前需要人为给定种子点(亦称标记点),缺少自适应,需进一步改进。

3.2.2 自适应随机游走ARWRW处理时需要交互式人工选取种子点,易受主观影响从而得不到更准确的种子点。因此,提出了一种自适应随机游走的方法ARW,通过提取图像特征点作为种子点进行随机游走处理。首先,获取图像对应的暗通道图像Idark,见下式:

| $ \boldsymbol{I}_{\mathrm{dark}}=\min\limits_{c \in\{\mathrm{R}, \mathrm{G}, \mathrm{B}\}}\left(\boldsymbol{I}_c\right) $ | (8) |

式中c为RGB通道中任意通道。对暗通道图求和,选取峰值波动最大的N个峰值行见下式:

| $ \boldsymbol{S}_r=\boldsymbol{f}_{\mathrm{p}}\left(\boldsymbol{s}_{\mathrm{r}}\left(\boldsymbol{I}_{\mathrm{dark}}\right)\right) $ | (9) |

式中:Sr为峰值所对应行数,fp()为取峰值的函数,sr()为行求和函数。然后,遍历峰值行,求得峰值行中峰值点对应列数,如式(10)所示:

| $ \boldsymbol{S}_c=\boldsymbol{f}_{\mathrm{p}}\left(\boldsymbol{I}_{\mathrm{dark}}\left(\boldsymbol{S}_r\right)\right) $ | (10) |

式中:Sc为峰值象素点列坐标,Idark(Sr)为暗通道图像中Sr行对应像素。通过上述方法,求解得到图像的峰值种子点,Sr为种子点横坐标,Sc为种子点纵坐标。

3.2.3 ARW聚类策略ARW聚类根据图的无规则游走及其各种子点对应势能理论之间的关系,求得各点归类的概率。比较非种子点首次到达种子点概率,将各点聚类至各种子点。首先,根据图像特征,自适应选取种子点。然后对每个种子点计算,得到由其他非种子点出发到达该种子点的概率。对于非种子点,选出对应种子点概率中的最大概率,作为该非种子点的标签。最后,将具有相同标签的非种子点划分为一类。以此实现将整个图像聚类在以种子点为中心的多个子区域中。相对其他聚类方法,ARW能够减少聚类时的迭代运算,大大节省运算时间。

3.2.4 大气光图估计单一大气光值易受极值影响,且缺乏适用性,处理时无法兼顾对远景和近景。因此,提出一种基于随机游走聚类的大气光图求解方法,通过大气光图来兼顾对图像不同位置的处理。具体步骤如下:

1) 获取景深图Id,根据DCP原理,将暗通道图像作为景深图;

2) 在景深图中均匀选取N个种子点,记作d1~dN;

3) 计算各点到种子点的概率,比较各点到种子点概率,将各点聚类至概率最大的种子点得到N个子区域Q1~QN。

4) 对每个子区域Q1~QN取前0.1%的平均值作为该区域大气光值,各子区域大气光值组合得到大气光图ARW,见式(11)~(12):

| $ \boldsymbol{A}_{\text{q}i}=\underset{0.1 \gamma_o}{\operatorname{averge}}\left(\boldsymbol{Q}_i\right), i=1, 2, \cdots, N $ | (11) |

| $ A_{\mathrm{RW}}=\boldsymbol{A}_{\mathrm{q} 1} \cup A_{\mathrm{q} 2} \cup \cdots \cup \boldsymbol{A}_{\mathrm{q} N} $ | (12) |

此时,求解大气光图的每个子块边缘处存在明显边界,因此,采用引导滤波根据图像特征进一步优化处理大气光。暗通道图像Idark为引导图像,以随机游走聚类求取的大气光图Aq为待滤波图像进行引导滤波。如图 5(a)所示,经过引导滤波后,大气光值图中的一些细节更加突出,大气纹理更加清晰,但整体值还是偏低,大气光图偏暗,仍需进一步融合。

3.3 大气光值-图估计融合基于LDCAP求解的大气光值不能反映全局各点的大气光值,而基于ARW聚类的大气光图能更好地反映不同景深不同位置像素点的大气光强度。因此,需对基于CAP的最小偏差大气光值估计进行融合补偿,来提高大气光估计的准确性。如图 5所示,定义CAP大气光值估计为Acap,经计算图 5(a)的Acap为[0.858 3 0.890 3 0.907 5],基于ARW聚类的大气光图估计为ARW,见图 5(b),定义融合大气光值公式如下:

| $ \lg \boldsymbol{A}=\lg \boldsymbol{A}_{\text {cap }}+\lg \left(1-\boldsymbol{A}_{\mathrm{RW}}\right) $ | (13) |

由图 5(c)可以看出,融合后的大气光值图在保存融合前大气光图细节的同时,整体亮度也得到了提升。

|

图 5 大气光图 Fig. 5 Atmospheric light map |

HLP是由Berman等[10]提出的一种非局部先验理论。在RGB颜色空间中,清晰图像中颜色相似的像素点会被聚类为同一簇,其像素点散布在图像中不同景深区域。当这些像素点受雾霾影响时,其衰减降质后像素值大小仅与透射率t有关,见式(14):

| $ \begin{aligned} \boldsymbol{I}(x)= & \boldsymbol{t}(x) \boldsymbol{J}(x)+(1-\boldsymbol{t}(x)) \boldsymbol{A}= \\ & \boldsymbol{t}(x)(\boldsymbol{J}(x)-\boldsymbol{A})+\boldsymbol{A} \end{aligned} $ | (14) |

式中:J(x)与I(x) 分别为x处清晰图像及含雾图像像素值,A为大气光估计值。可以看出,I(x) 大小由t(x) 来决定,且对于同一簇内,不同t(x) 对应的I(x) 的值会近似聚类在同一直线上,见坐标图 6(a)。因此,清晰图像中同一簇内像素点在受到雾霾影响时,这些像素点在RGB空间中近似沿同一直线分布,将该条直线定义为雾霾线。图 6(b)中,圈点与横线标记表示两束像素簇的像素点在图像中的分布,图 6(c)~(d)中分别为这两簇像素点在RGB颜色空间的分布,可以看出像素点大致呈线形分布。

|

图 6 含雾图像像素点在RGB颜色空间的分布 Fig. 6 Distribution of pixel points in RGB color space of hazy image |

根据HLP,雾天本应归属同一色彩簇的像素,由于距离图像采集设备位置的不同而导致光强衰减,以至于呈现出不同颜色。也就是说清晰图像中在RGB颜色空间聚集成簇的像素点,对应在雾霾图像中聚类以线形分布的形式存在。与经典的暗通道先验和颜色衰减先验等局部先验理论相比,雾霾线先验理论提出的非局部特征,能够避免局部先验理论仅依赖区域像素进行透射率估计的缺陷,为透射率估计引入全局相关性。透射率求解方法关键是找出图像中存在的雾霾线。由于在坐标系中通过聚类求解雾霾线时运算复杂,为了减少计算量,将图像转换到以大气光为中心的球面坐标系。假设大气光已知,定义IA(x) 为

| $ \boldsymbol{I}_{\boldsymbol{A}}(x)=\boldsymbol{I}(x)-\boldsymbol{A} $ | (15) |

式中:I为含雾图像,A为估计大气光值,IA(x) 为含雾像素值与大气光强度的差值。将大气散射模型代入式(15),可见下式:

| $ \boldsymbol{I}_A(x)=\boldsymbol{t}(x) \cdot(\boldsymbol{J}(x)-\boldsymbol{A}) $ | (16) |

为方便计算,将IA(x) 转换到球面坐标系下为

| $ \boldsymbol{I}_A(x)=[r(x), \theta(x), \varphi(x)] $ | (17) |

定义r(x)为球面坐标系中像素点对应去除大气光亮度后的半径距离,即向量IA(x)的模;θ(x)和φ(x)分别为球面坐标系下IA(x)的俯仰角和方位角。由式(16)~(17)知,在球面坐标系下,透射率t的改变并不影响θ(x)和φ(x)。因此,对于同一场景,向量IA(x)的模值仅与透射率t(x)的取值相关。假设在球面坐标系中存在像素点x1、x2满足θ(x1)≈θ(x2)和φ(x1)≈φ(x2),则其在清晰图像中也应该具有相似的RGB值,见式(18):

| $ \left\{\theta\left(x_1\right) \approx \theta\left(x_2\right), \varphi\left(x_1\right) \approx \varphi\left(x_2\right)\right\}, \forall t \Rightarrow \boldsymbol{J}\left(x_1\right) \approx \boldsymbol{J}\left(x_2\right) $ | (18) |

在球面坐标系下,具有相似的方位角和俯仰角的像素点,在空间上沿同一直线分布,属于同一条雾霾线。因此,可以对俯仰角θ(x)及方位角φ(x)的相似性进行像素聚类。为了简化聚类过程,将球面坐标系按角度提前划分成1 000等份,运用构建临近查找树的方法,通过计算图中像素点与这些位置的相似性,将像素点划分成不同簇类。进一步地,为了便于描述,将向量IA(x)的模r(x)称为像素点x的辐射度。由式(15)可得,辐射度r(x)与场景深度d(x)关系如下:

| $ r(x)=t(x)\|\boldsymbol{J}(x)-\boldsymbol{A}\|=\frac{1}{\mathrm{e}^{-\beta d(x)}}\|\boldsymbol{J}(x)-\boldsymbol{A}\| $ | (19) |

根据HLP,同一簇内的像素点受大气散射的影响,散布在图像中不同景深位置上。即使簇内像素点数量足够大时,总存在着受雾霾影响较小甚至不受影响的像素点。假设存在簇内不受雾霾影响的像素点xm,其对应的透射率t(x)为1。代入式(18)可得出,像素x的辐射度和无雾图像与大气光之差的模相等,见式(20),将其记作簇内最大辐射度rmax。

| $ r_{\max }=\left\|\boldsymbol{J}\left(x_m\right)-\boldsymbol{A}\right\| $ | (20) |

将式(19)代入式(18)可知,对于簇内其他的像素点,透射率可以用该点的辐射度r(x)与簇内最大辐射度rmax的比值表示,见式(21):

| $ t(x)=r(x) / r_{\max } $ | (21) |

根据上述过程粗估计透射率,见图 7。显然,基于HLP求得的透射率粗估计与簇内最大辐射度的像素位置密切相关,且求解过程未考虑图像内容的局部相关性,导致透射率图中局部区域存在噪点,需进一步优化。

|

图 7 基于雾霾线理论的透射率估计 Fig. 7 Transmittance estimation based on haze-line theory |

HLP求得的透射率普遍存在着数值偏大的问题,后期图像处理会偏暗。尤其在簇内像素数量较少时,透射率估计准确性明显下降,导致处理后色彩失真,甚至透射率中含有大量噪点,特别是远处天空区域表现尤为明显。为了解决这些问题,提出了一种暗补偿的方法,对基于HLP求得的透射率进行优化。定义暗补偿式(22)如下:

| $ \boldsymbol{t}_{\mathrm{b}}(x) \approx 1-w \cdot\left(\boldsymbol{I}_{\mathrm{dark}}(x) / \boldsymbol{A}\right) $ | (22) |

式中w为调节系数; 暗补偿tb(x)包含丰富的场景深度信息和物体的纹理信息,能够更有效提高透射率的精确性。透射率的大小与景深相关,所以要用透射率t的均值作为补偿阈来区分近景区域和远景区域。由于景深越大,透射率越小,因此对透射率补偿时应该尽量增大近景透射率,减小远景透射率,见式(23):

| $ \hat{\boldsymbol{t}}(x)=\left\{\begin{array}{l} \max \left(\boldsymbol{t}(x), \boldsymbol{t}_{\mathrm{b}}(x)\right), \boldsymbol{t}(x)<g \\ \boldsymbol{t}(x)+\mathrm{d} t, \boldsymbol{t}(x)>g \end{array}\right. $ | (23) |

式中:

|

图 8 暗补偿优化透射率 Fig. 8 Dark compensation optimization of image transmittance |

将优化后的透射率及求得的大气光估计代入大气散射模型,得到复原后的清晰图像,见式(24):

| $ \boldsymbol{J}(x)=\frac{\boldsymbol{I}(x)-\boldsymbol{A}}{\hat{\boldsymbol{t}}(x)}+\boldsymbol{A} $ | (24) |

式中:I(x)为含雾图像,J(x)为复原的清晰图像, A为融合后的大气光图。

5 实验效果评价实验中与DCP[5]、改进DCP[8]、FVID[18]、Haze-Line[11]、DehazeNet[12]方法进行对比,其中改进DCP是利用大气光图改进的去雾方法。采用主观与客观评价结合的方法进行分析。针对航拍图像处理的一般需求,这里设定去雾的主观评价准则:首先保证近景地面目标建筑细节复原清晰;其次保证中远景图质量;在此基础上,尽量保证天空清晰。客观评价则通过计算客观评价指标来分析算法处理后图片的质量。对图像中信息和纹理的丰富程度使用信息熵和平均梯度来评价,并采用模糊系数[19]表示相对原图像的模糊程度,通过对比度表示图像的色彩丰富程度。

5.1 主观评价图 9为无人机航拍江边大桥的含雾及复原图像,包含近景绿化区域、河对岸的建筑群以及大桥主体建筑。DCP较好地复原出图中信息,河对岸的建筑细节相对比较清晰,但整体较暗,浓雾区域处理效果不明显;改进DCP在亮度和对比度上有一定的提升,天空区域变暗;FVID[18]的复原图像亮度有所提升,但远处建筑的细节处理比DCP差;Haze-Line较好地处理了建筑细节,但部分区域存在明显失真,尤其是阴影部分,如河对岸绿化区域、桥底阴影部分以及河中的货船等; DehazeNet在亮度和对比度上都有所提升,但整体效果并不突出,对远处的处理也不明显; 本文算法明显优于其他算法,亮度和对比度有明显提升,对建筑细节信息的处理也更好,尤其是河对岸的建筑群清晰可见,桥底及货船也更明显。

|

图 9 图像去雾效果1 Fig. 9 Image dehazing effect 1 |

图 10为城市高楼区域的含雾及复原图像,含有近景高楼和远景的建筑群及右上方的河畔桥梁。DCP方法去雾后,近景区域楼宇轮廓更清晰,但整体明显亮度低,特别是天空区域更加昏暗;改进DCP方法去雾后远处区域更加清晰,但天空区域出现阴影;FVID方法去雾后,近处建筑细节得到优化,但远处区域并没有明显效果;Haze-Line方法去雾后图像纹理更加清晰,但远处区域出现较黑和明显失真区域,近处建筑也模糊不清;DehazeNet方法对中远景的去雾处理不及其他算法,去雾不彻底;本文算法并没有受阳光直射影响,近处建筑的细节信息得到很好的复原,对远处河对岸区域的建筑物明显更清晰。

|

图 10 图像去雾效果2 Fig. 10 Image dehazing effect 2 |

图 11为城市建筑群含雾及复原图像,以远处高楼为界可分为近景建筑区域和远景建筑区域。DCP去雾后整体亮度偏暗,且对于远景去雾效果明显不佳,尤其是远处天空区域;改进DCP去雾后亮度有所提升,远处区域更加清晰,但天空区域有些失真;FVID对远处去雾效果有所提升,但高楼建筑附近的建筑变暗,整体色彩饱和度较低;Haze-Line去雾后建筑物纹理较好,但存在明显失真,原本偏暗的区域进一步变暗;DehazeNet相对其他方法效果并不突出,处理后整个图像依然存在一定薄雾;本文算法还原图像的色彩和纹理信息更加丰富清晰,对于远处建筑物的处理效果也明显优于其他算法,远景高楼纹理更加明显。同时,图像的亮度和饱和度也明显得到提升。

|

图 11 图像去雾效果3 Fig. 11 Image dehazing effect 3 |

图 12为江边航拍含雾及复原图像,包含近处的建筑群区域、江面及桥梁区域以及远处河畔区域。DCP对近景有一定复原效果,但对远处处理效果明显不佳;改进DCP对远处处理明显提升,整体亮度也得到改进;FVID的处理效果优于DCP方法,但是整体亮度低,图像较暗;Haze-Line虽然纹理更加清晰,但整体发蓝,存在明显颜色失真,视觉效果较差;DehazeNet对远景去雾效果不明显,桥底阴暗区域则更暗;本文算法的复原图像纹理更清晰,对远处建筑物及近处桥洞的轮廓等信息处理都明显优于其他算法,色彩饱和度等信息更丰富,同时不受黄昏光线影响,色温一直呈暖色调,视觉效果优于其他算法。

|

图 12 图像去雾效果4 Fig. 12 Image dehazing effect 4 |

图 13和表 1为去雾图像客观评价结果,表中加粗部分为最优值。根据图 13及表 1的结果,DCP处理后图像的信息熵和平均梯度都有所提升,但是处理后图像亮度低,色彩不够丰富,对比度明显降低;改进DCP在平均梯度和模糊系数上明显提升,信息熵和对比度上没有表现出明显的优势;FVID平均梯度明显提升,但处理效果并不明显,信息熵、对比度并没有提升;Haze-Line对纹理细节的处理明显更好,各客观指标都很高,但是由于处理存在明显失真, 部分参数明显过高;DehazeNet由于其训练数据集为人工室内合成雾霾图像,针对真实雾效果不明显,因此各参数均不够突出; 本文算法由于大气光值图融合,大气光估计质量优于其他算法,处理后图像色彩更加丰富,对比度、平均梯度和模糊系数数据都最高,信息熵也有所提升,复原图像的雾霾浓度明显降低,去雾效果较好。

|

图 13 客观评价指标 Fig. 13 Objective evaluation index |

| 表 1 去雾图像客观评价指标 Tab. 1 Objective evaluation index of image dehazing |

针对无人机航拍图像去雾后亮度低、天空区域明显色彩失真等问题,提出了一种融合大气光值-图的求解方法,融合LDCAP估计的大气光值和ARW聚类估计的大气光图,获取新的大气光图;同时,利用暗补偿优化的雾霾线理论估计透射率;将二者代入大气散射模型,得到复原后的清晰图像。本文方法相对于其他去雾算法,主观上复原图像更加自然清晰,亮度饱和度得到了明显提升,失真问题也得到明显改善。客观评价指标中信息熵、平均梯度、模糊系数及对比度相比其他算法分别提升1.1%、6.3%、8.5%、6.4%。因此,本文所提方法对改善雾霾环境下无人机航拍图像的质量有着重要的研究意义。

| [1] |

OAKLEY J P, SATHERLEY B L. Improving image quality in poor visibility conditions using a physical model for contrast degradation[J]. IEEE Transactions on Image Processing, 1998, 7(2): 167. DOI:10.1109/83.660994 |

| [2] |

NAYAR S K, NARASIMHAN S G. Vision in bad weather[C]//Proceedings of the Seventh IEEE International Conference on Computer Vision (ICCV). Kerkyra: IEEE, 1999: 820. DOI: 10.1109/ICCV.1999.790306

|

| [3] |

黄鹤, 胡凯益, 郭璐, 等. 改进的海雾图像去除方法[J]. 哈尔滨工业大学学报, 2021, 53(8): 81. HUANG He, HU Kaiyi, GUO Lu, et al. Improved defogging algorithm for sea fog[J]. Journal of Harbin Institute of Technology, 2021, 53(8): 81. DOI:10.11918/202008105 |

| [4] |

TAN R T. Visibility in bad weather from a single image[C]//Proceedings of the 2008 IEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR). Anchorage: IEEE, 2008: 1. DOI: 10.1109/CVPR.2008.4587643

|

| [5] |

HE Kaiming, SUN Jian, TANG Xiaoou. Single image haze removal using dark channel prior[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2011, 33(12): 2341. DOI:10.1109/TPAMI.2010.168 |

| [6] |

HE Kaiming, SUN Jian, TANG Xiaoou. Guided image filtering[C]//Proceedings of the European Conference on Computer Vision (ECCV). Heraklion: Springer, 2010: 1. DOI: 10.1007/978-3-642-15549-9_1

|

| [7] |

HE Kaiming, SUN Jian. Fast guided filter[J]. Computer Science, 2015, 6: 89. |

| [8] |

杨寻, 郑京镐, 张叶, 等. 利用大气光图改进暗原色去雾效果[J]. 光电工程, 2015, 42(8): 73. YANG Xun, ZHENG Jinggao, ZHANG Ye, et al. Improvement of image haze removal based on dark channel prior with airlight map[J]. Opto-Electronic Engineering, 2015, 42(8): 73. DOI:10.3969/j.issn.1003-501X.2015.08.012 |

| [9] |

ZHU Qingsong, MAI Jiaming, SHAO Ling. A fast single image haze removal algorithm using color attenuation prior[J]. IEEE Transactions on Image Processing, 2015, 24(11): 3522. DOI:10.1109/TIP.2015.2446191 |

| [10] |

BERMAN D, TERIBITZ T, AVIDAN S. Non-local image dehazing[C]//Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas: IEEE, 2016: 1674. DOI: 10.1109/CVPR.2016.185

|

| [11] |

BERMAN D, TERIBITZ T, AVIDAN S. Air-light estimation using haze-lines[C]//Proceedings of the 2017 IEEE International Conference on Computational Photography (ICCP). Stanford: IEEE, 2017: 1. DOI: 10.1109/ICCPHOT.2017.7951489

|

| [12] |

CAI Bolun, XU Xiangmin, JIA Kui, et al. DehazeNet: an end-to-end system for single image haze removal[J]. IEEE Transactions on Image Processing, 2016, 25(11): 5187. DOI:10.1109/TIP.2016.2598681 |

| [13] |

吴迪, 朱青松. 图像去雾的最新研究进展[J]. 自动化学报, 2015, 41(2): 221. WU Di, ZHU Qingsong. The latest research progress of image dehazing[J]. Acta Automatica Sinica, 2015, 41(2): 221. DOI:10.16383/j.aas.2015.c131137 |

| [14] |

HUANG He, SONG Jing, GUO Lu, et al. Haze removal method based on a variation function and colour attenuation prior for UAV remote-sensing images[J]. Journal of Modern Optics, 2019, 66(12): 1. DOI:10.1080/09500340.2019.161514 |

| [15] |

黄鹤, 胡凯益, 宋京, 等. 雾霾线求解透射率的二次优化方法[J]. 西安交通大学学报, 2021, 55(8): 130. HUANG He, HU Kaiyi, SONG Jing, et al. A twice optimization method for solving transmittance with haze-lines[J]. Journal of Xi'an Jiaotong University, 2021, 55(8): 130. DOI:10.7652/xjtuxb202108016 |

| [16] |

夏敏. 基于随机游走的迭代分割算法[J]. 数字技术与应用, 2019, 37(9): 120. XIA Min. Iterative segmentation algorithm based on random walk[J]. Digital Technology & Application, 2019, 37(9): 120. DOI:10.19695/j.cnki.cn12-1369.2019.09.62 |

| [17] |

王卫星, 肖翔, 陈良琴. 结合最小滤波和引导滤波的暗原色去雾[J]. 光学精密工程, 2015, 23(7): 2100. WANG Weixing, XIAO Xiang, CHEN Liangqin. Image dark channel prior haze removal based on minimum filtering and guided filtering[J]. Optics and Precision Engineering, 2015, 23(7): 2100. DOI:10.3788/OPE.20152307.2100 |

| [18] |

GALDRAN A, VAZQUEZ-CORRAL J, PARDO D, et al. Fusion-based variational image dehazing[J]. IEEE Signal Processing Letters, 2017, 24(2): 151. DOI:10.1109/LSP.2016.2643168 |

| [19] |

黄文辉, 陈仁雷, 张家谋. 数字视频图像质量客观测量方法的改进与实现[J]. 北京邮电大学学报, 2005, 28(4): 87. HUANG Wenhui, CHEN Renlei, ZHANG Jiamou. Improvement and implementation of objective digital video quality measurement[J]. Journal of Beijing University of Posts and Telecommunications, 2005, 28(4): 87. |

2023, Vol. 55

2023, Vol. 55