2. 西安邮电大学 陕西省法庭科学电子信息实验研究中心,西安 710121;

3. 西安邮电大学 陕西省无线通信与信息处理技术国际联合研究中心,西安 710121;

4. 陕西师范大学 计算机科学学院,西安 710119;

5. 新加坡XsecPro公司,新加坡 787820

2. Electronic Information Experimental Research Center for Forensic Science of Shaanxi Province, Xi'an University of Posts and Telecommunications, Xi'an 710121, China;

3. International Joint Research Center for Wireless Communication and Information Processing Technology of Shaanxi Province, Xi'an University of Posts and Telecommunications, Xi'an 710121, China;

4. School of Computer Science, Shaanxi Normal University, Xi'an 710119, China;

5. XsecPro Pte. Ltd., Singapore 787820, Singapore

当前视频监控系统已经深度参与到刑事侦查、司法取证、防恐反恐等领域,为社会的安全稳定提供了关键保障。但是近年来,随着图像编辑软件功能的日益强大和深度篡改技术的飞速发展,对监控视频进行篡改越来越容易。保障监控视频数据安全性已经成为社会的普遍共识。相应地,检测视频内容是否被篡改的视频取证技术被广泛关注[1-2]。

在视频监控系统中,摄像头采集到的原始监控视频只需要编码压缩一次就通过网络传输给用户。编码压缩后的视频码流在网络传输时及在用户端存储时都有可能被篡改者盗取。篡改者将盗取的视频码流解码并篡改视频内容,然后必须将篡改视频再次编码压缩后才能得到包含篡改信息的视频码流从而完成整个篡改操作。所以编码压缩次数成为判定监控视频是否经过篡改的重要依据,以检测视频码流编码压缩次数为目的的视频重压缩取证技术应运而生。

视频重压缩取证方法的一个关键是提取视频码流中与压缩次数密切相关的特征。所以视频重压缩取证方法与具体的视频编码标准密切相关。当前在视频监控系统中被广泛应用的国际视频编码标准是2003年发布的H.264/AVC标准[3]和2013年发布的H.265/HEVC标准[4]。文献[5-9]面向H.264/AVC分别提出了有效的视频重压缩取证方法,考虑的视频码流特征包括块效应强度、量化信息、离散余弦变换系数、宏块类型、运动矢量信息等。文献[10-19]面向H.265/HEVC提出了有效的视频重压缩取证方法,考虑的视频码流特征包括变换单元类型、预测单元模式、环路滤波特征、图像组结构信息等。文献[20]面向2020年发布的最新一代国际视频编码标准H.266/VVC[21]提出了考虑亮度域编码单元(coding unit, CU)预测模式和分区模式的重压缩取证方法。当前提出的重压缩取证方法还存在以下不足:

1) 大部分方法都是面向早期的视频编码标准,不适用于最新的H.266/VVC标准。相比于之前标准,H.266/VVC采用了更加先进的编码技术,在显著提高编码压缩效率的同时,也改变了视频码流的语法语义与基础特征。

2) 在构建重压缩特征时只考虑了亮度域编码信息,忽视了色度域编码信息。色度域信息反映了监控视频中颜色内容变化,对于理解监控视频内容,例如嫌疑人着装、嫌疑车辆涂装信息等,具有重要影响。H.266/VVC中也采用了很多专门针对色度域信息的编码技术。这导致相比于亮度域,色度域会提供一些不同的编码信息,可以有效提升重压缩取证效率。

3) 复杂度较高,不适于在视频监控系统应用。例如文献[8-9, 16-17, 20]提出的方法需要对待取证的视频码流重新编码压缩超过1次,这显著增加了取证复杂度。视频监控系统是典型的7 d+24 h全天候工作系统,与案件相关的视频片段动辄达到百、千的级别。大数量视频片段和案件破获时效性决定了视频监控应用对视频重压缩取证方法有低复杂度的需求。

针对以上不足,本文提出了面向H.266/VVC标准,结合考虑色度域与亮度域编码信息的低复杂度重压缩取证方法。

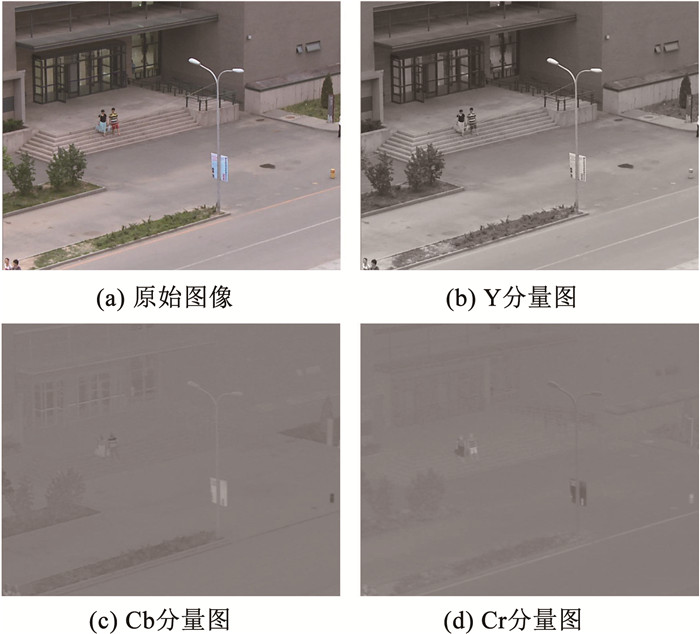

1 H.266/VVC相关编码原理 1.1 YCbCr颜色空间视频编码通常压缩的是YCbCr颜色空间视频。Y是亮度分量,Cb和Cr是色度分量,分别表征亮度域和色度域上的视频信息。图 1所示为标准监控视频Classover序列第1帧的原始图像及3个分量图Y、Cb、Cr。Y分量图对应的是原始图像的灰度图,反映像素亮度值的变化。在Y分量基础上添加Cb和Cr分量信息即可得到原始彩色图像。

|

图 1 Classover序列的第1帧 Fig. 1 First frame of Classover sequence |

编码视频采用YCbCr颜色空间的主要原因是人眼对视频亮度分量和色度分量的感知敏感度不同[22]。采用YCbCr颜色空间易在编码时将亮度分量和色度分量信号分开用不同的技术处理以提升各自的编码效率。亮度分量和色度分量不同的内容特性及采用的不同编码技术最终导致了其不同的编码压缩特性。

1.2 编码单元划分类型H.266/VVC采用基于块的编码框架。根据是否使用帧间预测技术, 将视频中的帧分为以下几种类型:只使用帧内预测技术不使用帧间预测技术的I帧和同时使用帧内预测技术和帧间技术的P帧与B帧。然后,将视频帧划分为编码树状单元(coding tree unit, CTU),再将CTU划分为CU。H.266/VVC摒弃了H.265/HEVC中预测单元和变换单元的概念,而是统一为CU。同时,为了适应更加丰富的视频内容,H.266/VVC新采用了融合使用二叉树、三叉树和四叉树的多类型树划分技术以支持更灵活的CU划分方式,并且在帧内预测(intra prediction)帧中支持长宽不等的矩形CU。考虑视频色度和亮度分量具有不同的内容特性,H.266/VVC新采用了色度分离树技术支持I帧中的色度和亮度分量独立地进行CU划分类型选择,支持的CU划分类型分别见表 1、2。

| 表 1 H.266/VVC支持的I帧色度分量CU划分类型 Tab. 1 I frame chroma component CU partitioning type supported by H.266/VVC |

| 表 2 H.266/VVC支持的I帧亮度分量CU划分类型 Tab. 2 I frame luminance component CU partitioning type supported by H.266/VVC |

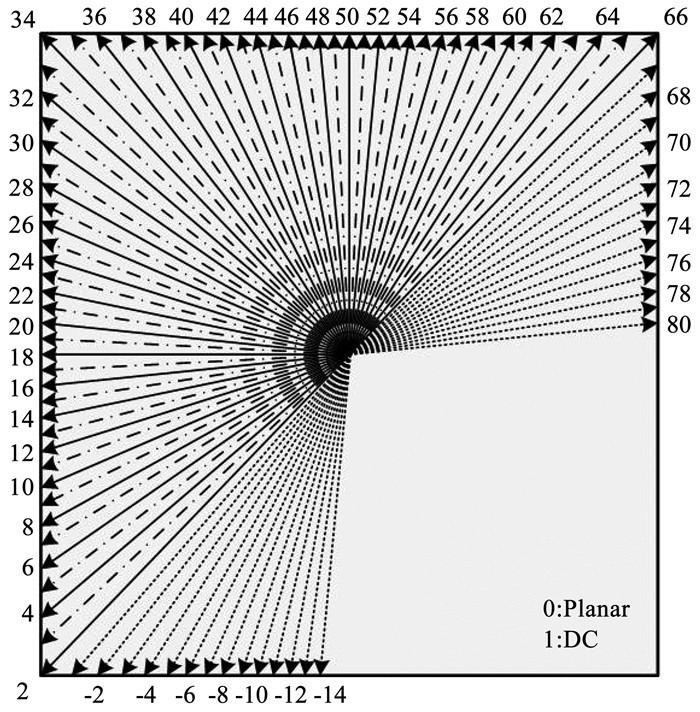

预测模式是H.266/VVC预测模块中CU需要选择的关键信息,其决定了预测值的来源。为了适应丰富的视频类型及纹理,H.266/VVC支持了更多种类的帧内预测模式。图 2所示为H.266/VVC亮度分量支持的帧内预测模式。

|

图 2 H.266/VVC亮度分量支持的帧内预测模式 Fig. 2 Intra prediction mode supported by H.266/VVC luminance component |

图 2中实线表示H.265/HEVC支持的33种角度预测模式。在此基础上H.266/VVC将角度模式由33种扩展到了65种,新增加的模式由点划线表示。H.266/VVC同时保留了Planar模式和DC模式,并且为了提高非正方形CU的预测效率,H.266/VVC新采用了宽角度帧内预测技术[21],扩展了更多的预测方向,见图 2中虚线。对于色度分量,除了角度模式、Planar模式和DC模式外,H.266/VVC还增加了有效考虑色度分量与亮度分量之间相关性的跨分量线性模型(cross-component linear model, CCLM)模式[21]。

2 重压缩特征构建 2.1 基础码流特征确定 2.1.1 色亮度域CU划分类型与压缩次数关系H.266/VVC采用拉格朗日率失真优化方法[21, 23]从支持的CU划分类型中给每一个CTU选择一组最优的CU划分类型。最优的CU划分类型对应最小的拉格朗日率失真代价J,具体表示为

| $ \min J, J=\sum D_{i, j}+\hat{\lambda} \sum\left(\bar{R}_{i, j}+\hat{R}_{i, j}\right) $ | (1) |

式中:

H.266/VVC采用基于预测、变换、量化、熵编码的混合帧内编码技术。预测是通过CU划分类型选择、CU预测模式选择等子技术给当前编码CTU中的原始像素寻找最相关的预测像素,然后定义它们的差值为残差值并将其作为变换的输入。变换是将像素域的残差值转换为频域的变换系数,其中低频系数对应视频的结构信息,而高频系数对应视频的细节信息。通常变换系数具有较大的动态范围,需要对其进行量化,以减小变换系数的取值空间, 提高熵编码去除熵冗余的能力,最终保证视频编码的效率。在上述过程中,一方面,H.266/VVC采用多对一的量化映射机制,在减少变换系数取值空间的同时也会显著降低视频细节信息的表达能力,导致视频清晰度降低, 视频内容变模糊; 另一方面,考虑人类视觉系统对于视频细节信息感知不敏感,H.266/VVC进一步采用了量化矩阵技术对高频系数使用更大的量化步长,这易导致高频信息的丢失,从而使得视频内容进一步变模糊。综上,原始监控视频随着压缩次数的增加,其视频内容清晰度会逐渐降低,视频内容会逐渐模糊。

模糊的视频内容对应模糊的CTU,其包含的色度域或亮度域信息间的空域相关性增强。此时选择大尺寸CU划分类型或者小尺寸CU划分类型都能给原始像素找到相关性强的预测像素,对应残差值都很小,残差值分布近似趋近于零均值的拉普拉斯分布。残差值是后续变换量化熵编码的输入,直接决定了Di, j和

将表 1和表 2所示的CU划分类型按包含的像素数划分为小尺寸CU和大尺寸CU两类。包含像素数少于等于256的CU划分类型属于小尺寸CU,其他的属于大尺寸CU。用H.266/VVC参考软件VTM11.0[24]编码Classover序列3次。档次为main_10,其他编码参数参照配置文件encoder_lowdelay_P_vtm.cfg中的默认设置。图 3所示为Classover序列所有I帧中色度域和亮度域大尺寸及小尺寸CU占比随压缩次数的变化。

|

图 3 色度域亮度域CU划分类型占比随压缩次数的变化 Fig. 3 Variation in CU partitioning type proportion of the chroma and luminance domain with compression times |

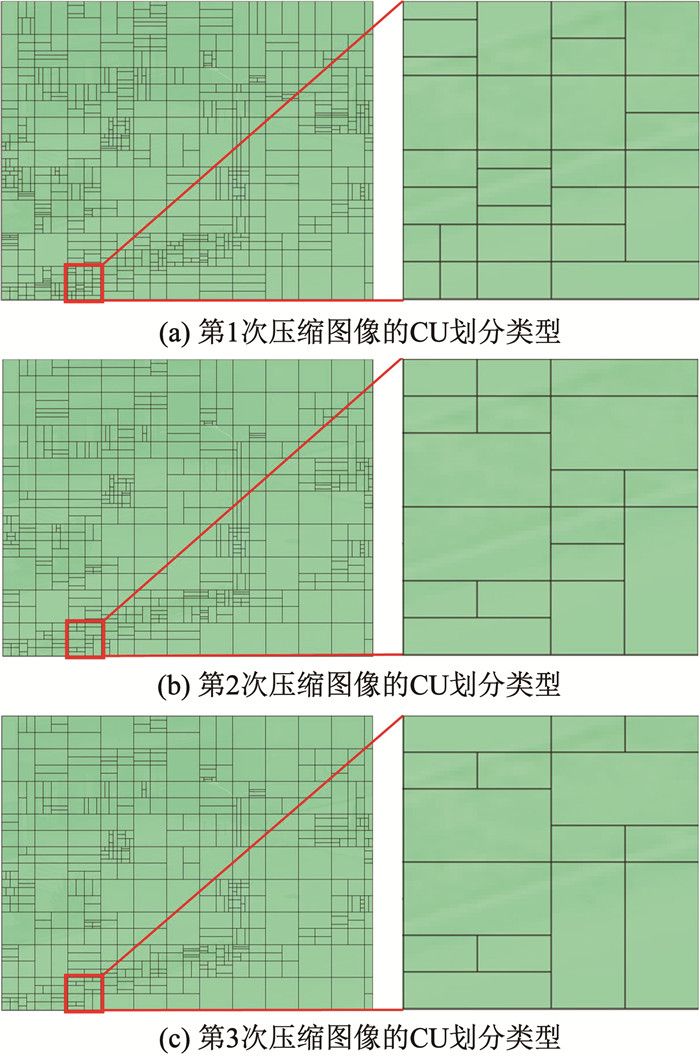

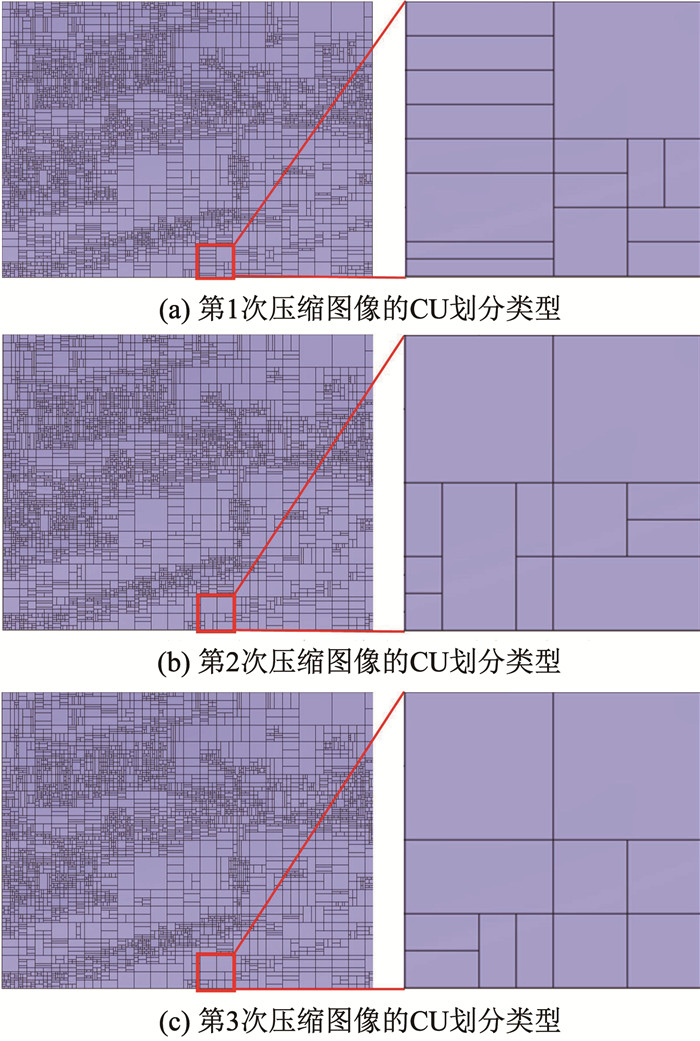

由图 3看出,随着压缩次数的增加,色度域和亮度域大尺寸CU占比逐渐增加,而小尺寸CU占比逐渐降低,并且前2次压缩对应的CU划分类型占比变化要比后2次压缩对应的CU划分类型占比变化更加剧烈。综上可以得到以下结论:视频压缩次数影响色度域亮度域CU划分类型的选择,且压缩次数越靠前影响越大。为了直观地展示上述结论,图 4、5分别给出了Classover序列第1帧图像随着压缩次数增加其中色度域和亮度域CU划分类型的变化。图中不同尺寸的块表示不同的CU划分类型。由图中数据易看出, 随着压缩次数增加,大尺寸CU在增加而小尺寸CU在减少。为了更加直观地观察这一现象,也将左图中框线所示区域放大如右图展示。

|

图 4 色度域CU划分类型随压缩次数的变化 Fig. 4 Variation in the chroma domain CU partitioning type with compression times |

|

图 5 亮度域CU划分类型随压缩次数的变化 Fig. 5 Variation in the luminance domain CU partitioning type with compression times |

H.266/VVC也是采用拉格朗日率失真优化方法给每一个CU选择最优的预测模式[21]。最优的预测模式对应最小的拉格朗日率失真代价J,具体表示为

| $ \min J, J=D_g+\bar{\lambda}\left(\bar{R}_g+\hat{R}_g\right) $ | (2) |

式中:

如图 2所示,任一角度模式是利用特定一个方向的参考像素给当前编码像素确定预测值。Planar模式则是利用当前编码像素正上方和平行左方的参考像素获得预测值,所以Planar模式可以认为是一种利用了2个角度信息的特殊角度模式。DC模式是利用当前编码像素上方及左方的所有参考像素的平均值作为预测值。而CCLM模式是利用了色度与亮度分量之前的相关性确定预测值。前文已经从编码原理角度分析得到了原始监控视频随着压缩次数的增加,其视频内容清晰度会逐渐降低,视频内容会逐渐模糊。模糊的视频内容即意味着纹理方向信息的丢失,视频内容变的平坦,而相应的色度与亮度分量之间的相关性也会越强。所以,相比角度模式,DC模式和CCLM模式更易找到优化的预测值。优化的预测值对应着更小的残差值,即对应着更小的Dg和Rg。而选择角度模式、DC模式或者CCLM模式主要影响了头比特语法元素的取值,对于

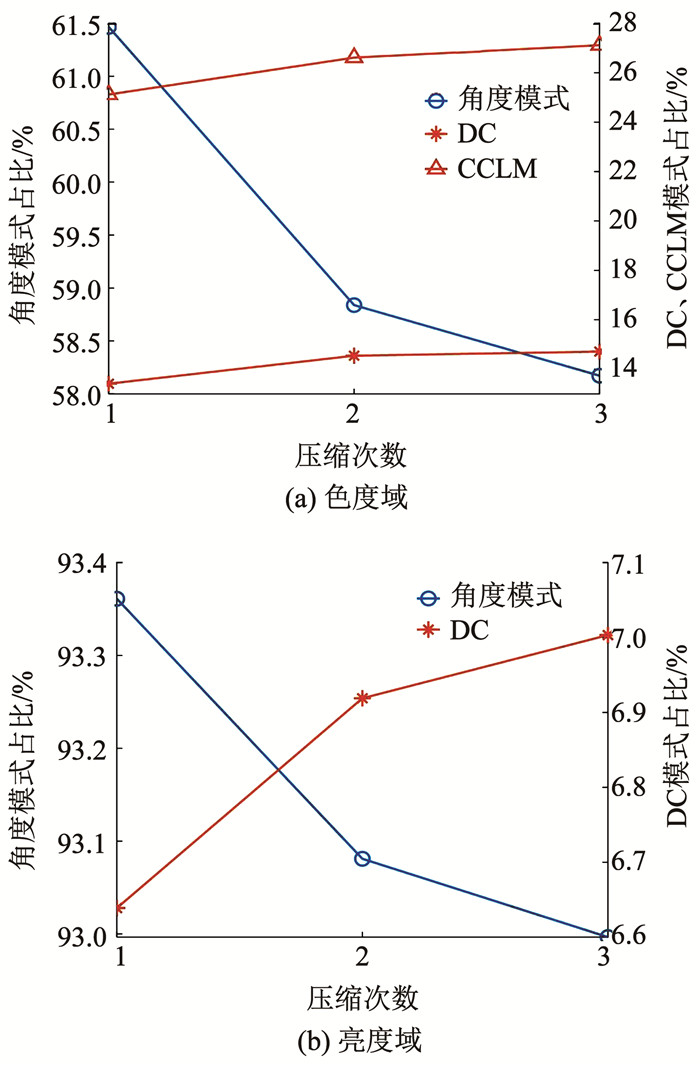

使用VTM11.0编码Classover序列3次,其他编码参数设置与前文实验设置一致。图 6所示为Classover序列所有I帧中色度域和亮度域CU预测模式占比的变化。

|

图 6 色度域亮度域CU预测模式占比随压缩次数的变化 Fig. 6 Variation in CU prediction mode proportion of chroma and luminance domain with compression times |

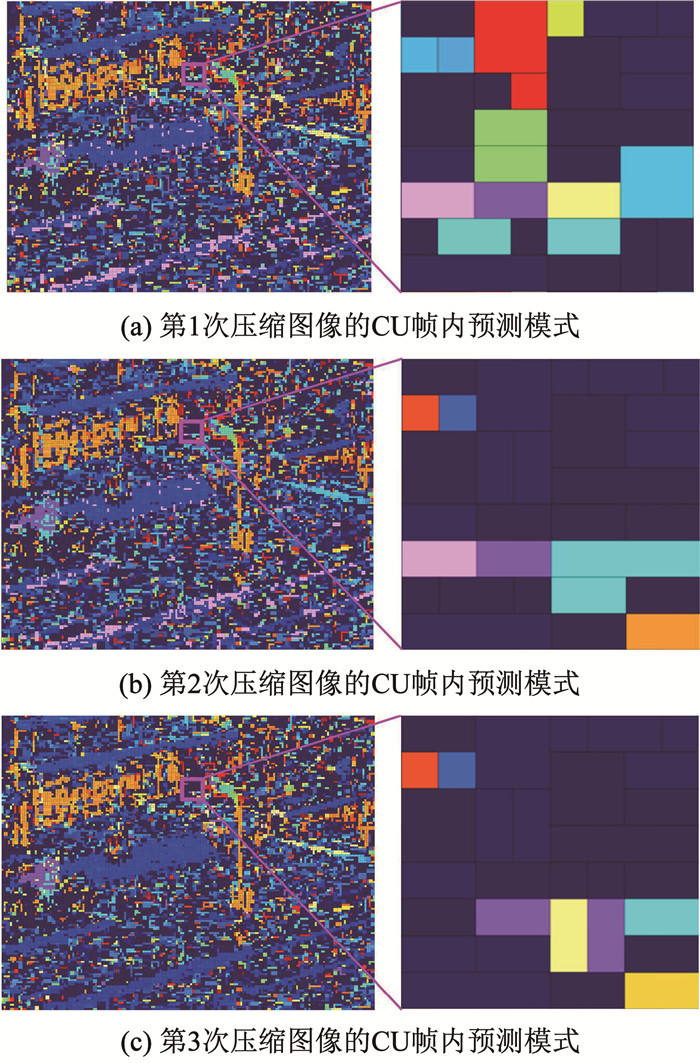

由图 6中数据易看出,随着视频压缩次数的增加角度模式(包括Planar模式)的占比降低,而DC和CCLM模式的占比增加。并且前2次压缩对应的预测模式占比变化要比后2次压缩对应的预测模式占比变化更加剧烈。综上可以得到以下结论:视频压缩次数影响色度域亮度域CU预测模式的选择,且压缩次数越靠前影响越大。为了更加直观地展示上述结论,图 7、8分别给出了Classover序列第1帧图像随着压缩次数的增加其中色度域和亮度域CU帧内预测模式的变化。图中不同深度的色块表示不同的CU帧内预测模式。由图中数据易看出压缩次数对于CU帧内预测模式的选择具有显著影响。

|

图 7 色度域CU预测模式随压缩次数的变化 Fig. 7 Variation in chroma domain CU prediction mode with compression times |

|

图 8 亮度域CU预测模式随压缩次数的变化 Fig. 8 Variation in luminance domain CU prediction mode with compression times |

在构建高级码流特征时考虑了以下因素:1)色度域亮度域CU划分类型和预测模式与视频压缩次数具有明显关系,并且其会被写入到H.266/VVC视频码流的头信息中,所以CU划分类型和预测模式可以作为检测视频压缩次数的基础码流特征;2)压缩次数越靠前,压缩次数对于CU划分类型和预测模式的影响越大。且在实际取证中考虑的压缩次数越多,高级码流特征计算通常会越复杂。当前一些重压缩取证代表性方法在进行本部分涉及的高级码流特征构建时考虑的是亮度域多次压缩信息[16]。而本文只考虑前2次压缩对应的色度域和亮度域CU划分类型和预测模式构建高级码流特征。特别说明, 这里的前2次指的是下文中的第n次和第n+1次。

定义Cn, i, x为视频经过第n次压缩后第i个I帧第x个色度域CU包含划分类型和预测模式的信息矩阵,具体表示为

| $ \boldsymbol{C}_{n, i, x}=\left[a_{n, i, x}, b_{n, i, x}\right] $ | (3) |

式中an, i, x、bn, i, x分别为第n次压缩视频第i个I帧第x个色度域CU选择的划分类型及预测模式编号。它们的取值范围为

| $ a_{n, i, x} \in\{1, 2, \cdots, \varphi\} $ | (4) |

| $ b_{n, i, x} \in\{1, 2, \cdots, \varepsilon\} $ | (5) |

式中φ和ε分别为H.266/VVC标准支持的色度域CU可选的划分类型和预测模式总数。

视频经过第n+1次压缩后第i个I帧第x个色度域CU对应信息矩阵Cn+1, i, x的定义与Cn, i, x的定义类似,将式(3)~(5)中的n替换为n+1即可,不再赘述。式(6)为色度域相同信息CU判别公式,具体表示为

| $ \boldsymbol{C}_{n, i, x}=\boldsymbol{C}_{n+1, i, x} $ | (6) |

对于第n次压缩视频第i个I帧第x个色度域CU,假如其满足式(6),则判定其为相同信息CU,否则为不同信息CU。

然后根据式(7)统计第n次压缩视频第i个I帧第x个色度域CU的信息标记βn, i, x, α,具体表示为

| $ \beta_{n, i, x, \alpha}= \begin{cases}1 & \boldsymbol{C}_{n, i, x} \neq \boldsymbol{C}_{n+1, i, x} \text { 且 } a_{n, i, x}=\alpha \\ 0 & \text { 其他 }\end{cases} $ | (7) |

式中α∈{1, 2, …, φ}。最终根据式(8)计算第n次压缩视频所有I帧色度域CU中选择第α种划分类型且属于不同信息CU的占比Wn, α,具体表示为

| $ W_{n, \alpha}=\frac{1}{I_n} \sum\limits_{i=1}^{I_n}\left[\left(\sum\limits_{x=1}^{G_{n, i}} \beta_{n, i, x, \alpha}\right) / H_{n, i, \alpha}\right] $ | (8) |

式中: In、Gn, i分别为第n次压缩视频包含的I帧数目和第i个I帧包含的色度域CU数目,Hn, i, α为第n次压缩视频第i个I帧中选择第α种划分类型的色度域CU数目。

下面针对亮度域CU的处理与式(3)~(8)所示针对色度域CU的处理类似。定义Ln, i, t为第n次压缩视频第i个I帧第t个亮度域CU的信息矩阵,具体表示为

| $ \boldsymbol{L}_{n, i, t}=\left[k_{n, i, t}, m_{n, i, t}\right] $ | (9) |

式中kn, i, t、mn, i, t分别为第n次压缩视频第i个I帧第t个亮度域CU选择的划分类型及预测模式。它们的取值范围为

| $ k_{n, i, t} \in\{1, 2, \cdots, \theta\} $ | (10) |

| $ m_{n, i, t} \in\{1, 2, \cdots, \omega\} $ | (11) |

式中θ和ω分别为H.266/VVC标准支持的亮度域CU可选的划分类型和预测模式总数。

式(12)为亮度域相同信息CU的判别公式,具体表示为

| $ \boldsymbol{L}_{n, i, t}=\boldsymbol{L}_{n+1, i, t} $ | (12) |

对于第n次压缩视频第i个I帧第t个亮度域CU,假如其满足式(12),则定义其为相同信息CU,否则为不同信息CU。然后根据式(13)统计第n次压缩视频第i个I帧第t个亮度域CU的信息标记

| $ \delta_{n, i, t, \vartheta}= \begin{cases}1 & \boldsymbol{L}_{n, i, t} \neq \boldsymbol{L}_{n+1, i, t} \text { 且 } k_{n, i, t}=\vartheta \\ 0 & \text { 其他 }\end{cases} $ | (13) |

式中

| $ V_{n, \vartheta}=\frac{1}{I_n} \sum\limits_{i=1}^{I_n}\left[\left(\sum\limits_{y=1}^{U_{n, i}} \delta_{n, i, t, \vartheta}\right) / S_{n, i, \vartheta}\right] $ | (14) |

式中Un, i、

| $ \boldsymbol{F}=\left[W_{n, \alpha}, V_{n, \vartheta}\right] $ | (15) |

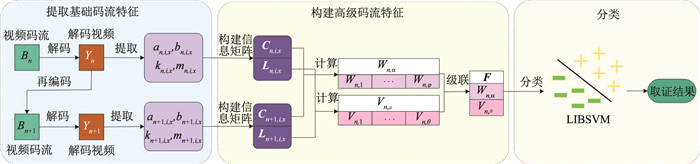

CLF-SVRF方法框架见图 9,步骤为:

|

图 9 CLF-SVRF方法框架 Fig. 9 Framework of CLF-SVRF |

1) 对输入的待检测视频码流Bn,提取所有I帧色度域和亮度域CU对应的划分类型及预测模式。并分别根据式(3)、(9)构建Bn对应的信息矩阵Cn, i, x、Ln, i, t。

2) 将Bn解码,得到解码视频Yn。然后再编码压缩1次Yn,得到对应的视频码流Bn+1。

3) 提取Bn+1中所有I帧色度域和亮度域CU对应的划分类型及预测模式。并构建Bn+1对应的信息矩阵Cn+1, i, x、Ln+1, i, t。

4) 根据Cn, i, x、Ln, i, t、Cn+1, i, x、Ln+1, i, t,结合式(7)、(8)得到Wn, α,结合式(13)、(14)得到

5) 将F输入SVM中得到最终的检测结果。

在上述步骤中,为了兼顾取证准确率与复杂度,CLF-SVRF方法只对视频码流编码压缩1次,利用第n次和第n+1次对应的视频码流信息即可完成重压缩取证。另外,第5步涉及的SVM模型在实际使用前需要提前训练。

4 实验结果 4.1 实验设置文献[16]提出的方法是当前视频重压缩取证领域代表性的先进方法。本节将CLF-SVRF方法与文献[16]方法进行性能比较与分析。选择68个包含不同场景内容的YCbCr 4 : 2 : 0格式的监控视频作为测试视频,视频的空间分辨率最小为720×576,最大为3 840×2 160。使用VTM11.0编码测试视频,编码帧数为100帧,量化参数(quantization parameter, QP)取值如表 3第1列所示,对应于当前视频监控系统普遍使用的码率段。其他编码设置与前节实验的设置一致。首先编码每一个测试视频1次生成单压缩视频码流,并标记其为正样本。然后将单压缩视频码流用VTM11.0解码得到解码视频,并使用VTM11.0将解码视频再编码1次得到重压缩视频码流,并将其标记为负样本。

| 表 3 不同方法的重压缩取证准确度 Tab. 3 Accuracy of recompression forensic of different methods |

随机选择41个测试视频对应的正负样本作为训练集,其他的正负样本作为测试集。训练集用于训练CLF-SVRF方法中使用的SVM模型。本文采用LIBSVM分类器[25-26],选择径向基函数作为核函数,确定测试集最优取证准确度意义下内核的最佳参数。重压缩取证准确度A表示为

| $ A=\left(\frac{N_{\kappa, \kappa}}{N_{\kappa, \kappa}+N_{\kappa, \tau}}+\frac{N_{\tau, \tau}}{N_{\tau, \tau}+N_{\tau, \kappa}}\right) / 2 \times 100 \% $ | (16) |

式中:Nκ, κ、Nκ, τ分别为正样本被判定单压缩视频和重压缩视频的数量;Nτ, τ、Nτ, κ分别为负样本被判定为重压缩视频和单压缩视频的数量。

4.2 重压缩取证准确度使用训练集测试文献[16]方法和CLF-SVRF方法的重压缩取证准确度,具体结果见表 3。相比于文献[16]方法,CLF-SVRF方法可以显著提高重压缩取证准确度,对于所有测试视频,重压缩取证准确度平均可以提高13.53%。为了更深入分析性能,表 4给出了8个代表性视频对应的重压缩取证准确度数据。由表中数据易看出,相比于文献[16]方法,CLF-SVRF方法对于大部分监控视频具有更高的重压缩取证准确度,但对于个别视频取证准确度未有提升。下面以City和Campus序列为例分析深层次原因。

| 表 4 代表性视频的重压缩取证准确度 Tab. 4 Accuracy of recompression forensic of representative videos |

对于CLF-SVRF方法,高级码流特征Wn, α和

|

图 10

City和Campus序列的Wn, α与 |

对于City序列,对比图 10(a)、(b)易得出以下结论:1)相比于

文献[16]方法和CLF-SVRF方法都包括视频编码步骤和其他步骤。一方面,相比于视频解码、构建重压缩特征及分类器检测等步骤,视频编码步骤显著复杂,其占了重压缩取证的大部分时间; 另一方面,视频编码是计算机系统独立进行的操作不受人为操作干预。所以本节选择对比文献[16]方法和CLF-SVRF方法的编码时间以公正反映其取证复杂度。采用ψ衡量相比于文献[16]方法,CLF-SVRF方法节省编码时间百分比,具体表示为

| $ \psi=(|d-\hat{d}| / d) \times 100 \% $ | (17) |

式中d、

表 5为8个代表性监控视频的ψ数据。由表中数据易看出, 相比于文献[16]方法,CLF-SVRF方法可以显著降低取证复杂度,对于正样本及负样本,编码时间分别可以节省47.97%和46.86%。这主要是因为文献[16]方法需要将待取证的视频码流重新压缩2次才能构建出高级码流特征,而CLF-SVRF方法只需要将待取证的视频码流重新压缩1次即可构建所需的高级码流特征。

| 表 5 CLF-SVRF方法节省的编码时间 Tab. 5 Coding time saved by CLF-SVRF |

面向最新的H.266/VVC标准,提出了有效融合监控视频色度域和亮度域CU划分类型及预测模式信息的视频重压缩取证方法。实验结果证明提出方法具有较高的取证准确度和较低的取证复杂度,更加适用于视频监控应用场景。

由本文研究得出的重要结论包括:对于H.266/VVC标准,色度域和亮度域CU的划分类型及预测模式信息与视频压缩次数都具有密切关系;监控视频色度域编码信息的应用可以有效提升重压缩取证的准确度;更丰富CU划分类型及预测模式的应用可以有效提升重压缩取证方法的普适性;SVM可以在最新的H.266/VVC标准视频重压缩取证中被有效应用。本文只考虑了帧内编码信息,后续考虑帧间编码信息构造基础与高级码流特征是有意义的研究点。

| [1] |

任洪昊, 朱新山, 卢俊彦. 深度图像修复的动态特征融合取证网络[J]. 哈尔滨工业大学学报, 2022, 54(11): 47. REN Honghao, ZHU Xinshan, LU Junyan. Dynamic feature fusion forensics network for deep image inpainting[J]. Journal of Harbin Institute of Technology, 2022, 54(11): 47. DOI:10.11918/202201081 |

| [2] |

VERDOLIVA L. Media forensics and deepfakes: an overview[J]. IEEE Journal of Selected Topics in Signal Processing, 2020, 14(5): 910. DOI:10.1109/JSTSP.2020.3002101 |

| [3] |

WIEGAND T, SULLIVAN G J, BJONTEGAARD G, et al. Overview of the H.264/AVC video coding standard[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2003, 13(7): 560. DOI:10.1109/TCSVT.2003.815165 |

| [4] |

SULLIVAN G J, OHM J R, HAN W J, et al. Overview of the high efficiency video coding (HEVC) standard[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2012, 22(12): 1649. DOI:10.1109/TCSVT.2012.2221191 |

| [5] |

林敏, 林庆毫, 翁晓雨, 等. 应用于H.26X的通用无损帧内编码优化算法[J]. 哈尔滨工业大学学报, 2021, 53(8): 7. LIN Min, LIN Qinghao, WENG Xiaoyu, et al. Improved universal lossless intra-frame coding algorithm for H.26X[J]. Journal of Harbin Institute of Technology, 2021, 53(8): 7. DOI:10.11918/202104004 |

| [6] |

HE Peisong, JIANG Xinghao, SUN Tanfeng, et al. Detection of double compression in MPEG-4 videos based on block artifact measurement[J]. Neurocomputing, 2017, 228: 84. DOI:10.1016/j.neucom.2016.09.084 |

| [7] |

BAKAS J, BASHABOINA A K, NASKAR R. MPEG Double compression based intra-frame video forgery detection using CNN[C]//2018 International Conference on Information Technology. Bhubaneswar: IEEE, 2018: 221. DOI: 10.1109/ICIT.2018.00053

|

| [8] |

ZHANG Zhenzhen, HOU Jianjun, ZHANG Yu, et al. Detecting multiple H.264/AVC compressions with the same quantisation parameters[J]. IET Information Security, 2017, 11(3): 152. DOI:10.1049/iet-ifs.2015.0361 |

| [9] |

FERNÁNDEZ E G, OROZCO A L S, VILLALBA L J G. Digital video manipulation detection technique based on compression algorithms[J]. IEEE Transactions on Intelligent Transportation Systems, 2021, 23(3): 2596. DOI:10.1109/TITS.2021.3132227 |

| [10] |

FANG Qianan, JIANG Xinghao, SUN Tanfeng, et al. Detection of HEVC double compression with different quantization parameters based on property of DCT coefficients and TUs[C]//2019 12th International Congress on Image and Signal Processing, BioMedical Engineering and Informatics. Suzhou: IEEE, 2019: 1

|

| [11] |

LI Qian, WANG Rangding, XU Dawen. Detection of double compression in HEVC videos based on TU size and quantised DCT coefficients[J]. IET Information Security, 2019, 13(1): 1. DOI:10.1049/iet-ifs.2017.0555 |

| [12] |

ELROWAYATI A A, ABDULLAH M F L, ABD MANAF A, et al. Tampering detection of double-compression with the same quantization parameter in HEVC video streams[C]//2017 7th IEEE International Conference on Control System, Computing and Engineering. Penang: IEEE, 2017: 174

|

| [13] |

JIA Ruishi, LI Zhaohong, ZHANG Zhenzhen, et al. Double HEVC compression detection with the same QPs based on the PU numbers[C]// ITM Web of Conferences. [S. l. ]: EDP Sciences, 2016, 7: 1

|

| [14] |

XU Qiang, JIANG Xinghao, SUN Tanfeng, et al. Detection of HEVC double compression with non-aligned GOP structures via inter-frame quality degradation analysis[J]. Neurocomputing, 2021, 452: 99. DOI:10.1016/j.neucom.2021.04.092 |

| [15] |

UDDIN K, YANG Y, OH B T. Double compression detection in HEVC-coded video with the same coding parameters using picture partitioning information[J]. Signal Processing: Image Communication, 2022, 103: 1. DOI:10.1016/j.image.2022.116638 |

| [16] |

JIANG Xinghao, XU Qiang, SUN Tanfeng, et al. Detection of HEVC double compression with the same coding parameters based on analysis of intra coding quality degradation process[J]. IEEE Transactions on Information Forensics and Security, 2020, 15: 250. DOI:10.1109/TIFS.2019.2918085 |

| [17] |

潘鹏飞, 姚晔, 王慧. 相同编码参数HEVC视频重压缩检测[J]. 中国图像图形学报, 2020, 25(5): 879. PAN Pengfei, YAO Ye, WANG Hui. Detection of double compression for HEVC videos with the same coding parameters[J]. Journal of Image and Graphic, 2020, 25(5): 879. DOI:10.11834/jig.190381 |

| [18] |

YOUSSEF S, SHANABLEH T. Detecting double and triple compression in HEVC videos using the same bit rate[J]. SN Computer Science, 2021, 2: 406. DOI:10.1007/s42979-021-00800-8 |

| [19] |

WU Qiyuan, SUN Tanfeng, JIANG Xinghao, et al. HEVC double compression detection with non-aligned GOP structures based on a fusion feature with optical flow and prediction units[C]//2019 12th International Congress on Image and Signal Processing, BioMedical Engineering and Informatics. Suzhou: IEEE, 2019: 1

|

| [20] |

XU Qiang, XU Dongmei, WANG Hao, et al. Detecting double H.266/VVC compression with the same coding parameters[J]. Neurocomputing, 2022, 514: 231. DOI:10.1016/j.neucom.2022.09.153 |

| [21] |

BROSS B, WANG Yekui, YE Yan, et al. Overview of the versatile video coding (VVC) standard and its applications[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2021, 31(10): 3736. DOI:10.1109/TCSVT.2021.3101953 |

| [22] |

WU Hongren, REIBMAN A R, LIN Weisi, et al. Perceptual visual signal compression and transmission[J]. Proceedings of the IEEE, 2013, 101(9): 2025. DOI:10.1109/JPROC.2013.2262911 |

| [23] |

冯磊, 戴明, 孙丽娜, 等. 利用信息熵判定HEVC预测单元尺寸快速算法[J]. 哈尔滨工业大学学报, 2016, 48(9): 164. FENG Lei, DAI Ming, SUN Lina, et al. An algorithm of fast HEVC PU size decision using information entropy[J]. Journal of Harbin Institute of Technology, 2016, 48(9): 164. DOI:10.11918/j.issn.0367-6234.2016.09.028 |

| [24] |

ITU ISO/IEC. VTM reference software for VVC[EB/OL]. [2020-10-16]. https://vcgit.hhi.fraunhofer.de/jvet/VVCSoftware_VTM/-/tags

|

| [25] |

CHANG Chihchung, LIN Chihjen. LIBSVM: A library for support vector machines[J]. ACM Transactions on Intelligent Systems and Technology, 2011, 2(3): 1. DOI:10.1145/1961189.1961199 |

| [26] |

HSU Chihwei, CHANG Chihchung, LIN Chihjen. A practical guide to support vector classification[EB/OL]. [2022-10-03]. http://www.csie.ntu.edu.tw/~cjlin/papers/guide/guide.pdf

|

2024, Vol. 56

2024, Vol. 56