2. 武汉理工大学 智能交通系统研究中心, 武汉 430063;

3. 武汉理工大学重庆研究院, 重庆 401120

2. Intelligent Transportation Systems Research Center, Wuhan University of Technology, Wuhan 430063, China;

3. Chongqing Research Institute of Wuhan University of Technology, Chongqing 401120, China

随着人工智能的应用领域不断扩大,移动机器人扮演着越来越重要的角色。作为避免碰撞和进行运动的先决条件,障碍物检测在其更智能地完成任务方面发挥着重要作用[1]。目前,障碍物检测方法按照获取环境信息的方式可以分为两类。一类为基于距离传感器对障碍物进行感知和定位。其中超声波雷达价格低廉,但其二维的扫描范围盲区较大[2]; 毫米波雷达具有更大的作用范围[3],其缺点是视野有限和价格高昂; 同样的,激光雷达[4-5]也由于其高昂的价格,难以广泛应用于移动设备上。第二类则为基于视觉传感器的方法。单目视觉主要使用基于特征的方法对目标进行检测[6]。文献[7]使用基于边缘特征的障碍物检测,通过边缘算子检测边缘特征来检测障碍物。但是单目视觉存在视场小、无法获取目标准确的距离信息等问题。基于立体视觉的方法一般利用双目相机获取深度信息。文献[8]使用密集立体匹配进行三维重建,并通过改进的半全局匹配算法以细化视差图,实现障碍物检测; 文献[9]提取目标角点和边缘信息对左右目图像进行立体匹配来深度重建,从而实现检测和测距,但基于立体视觉的方法计算量大,实时性不足,且离相机越近盲区越大。基于环视的方法即利用环视系统生成全景图进行障碍物检测,文献[10-11]通过生成全景鸟瞰图,并在其中检测道路和障碍物特征,可直观的判断周围障碍物情况。但该方法仍存在计算量大,实时性差的问题。除了传统检测方法,深度学习也被广泛应用于障碍物检测。文献[12]基于YOLO(you only look once)[13]网络,提出一种Tiny-YOLO的改进算法,并通过剪枝技术实现了精准的目标检测; 文献[14]提出一种改进的MDNet(multi-domain convolutional neural network)网络结合长短期记忆神经网络对行人、车辆等目标实现了检测和跟踪效果。虽然基于深度学习的方法对于特定目标的检测与识别效果较好,但对不在数据集中的目标难以检测。

同时,上述传感器和算法对于距离非常近的障碍物检测效果不佳。大多数雷达传感器都有约1 m的近距离盲区,视觉传感器由于比例尺异常,也难以检测超近目标。实际上,超近距离障碍物检测对于移动设备的安全至关重要,应以更准确可靠的方式进行检测。基于此,提出了一种基于环视系统进行逆投影差分的新型障碍物检测算法,能够快速检测移动机器人上每两个相邻相机视野公共区域中是否存在障碍物,并精准定位。

1 本文算法算法流程见图 1。主要包括以下步骤:1)以水平地面为参考平面,使用逆投影算法将环视系统各相机拍摄的图像逆投影到参考平面,并统一各逆投影图像到同一坐标系下;2)对相邻视角逆投影图像进行差分操作,并通过二值化与形态学滤波等后处理实现移动机器人的障碍物检测;3)通过像素坐标系、局部坐标系以及机器人自身坐标系的转换实现基于机器人自身坐标系的障碍物精准定位。

|

图 1 算法流程图 Fig. 1 Algorithm flow chart |

逆投影变换主要使用相机固有参数与外部参数把原始图像重新映射到一个新的二维域(即世界坐标系下参考平面图像)来去除透视形变,通过该方式可以消除原始图像与世界坐标中距离的非线性,用于障碍物检测与定位任务。

对于所使用的鱼眼相机,拍摄的图片具有明显的畸变,所以在使用前,需要使用相机固有参数中的畸变系数对原始图像进行畸变校正[15],校正后的图像去除了畸变,适用于相机针孔成像模型,后续的外参标定、逆投影变换皆在校正图上进行操作,以消除鱼眼相机畸变带来的影响。

由于关注的是地面以及区别于地面的障碍物,所以将水平地面π0作为参考平面,以π0上任意某点P作为原点,设n为π0的单位法向量,Z轴和法线重合,移动机器人正前方为Y轴,正右方为X轴,构建合适的世界坐标系,见图 2。设I(u, v)为环视系统某一路相机拍摄,并经过畸变校正后的校正图像,I(x, y)为与之对应的逆投影图像,则I(x, y)可由I(u, v)逆投影到π0得到:

| $ \left[ {\begin{array}{*{20}{l}} x\\ y\\ 1 \end{array}} \right] \simeq \mathit{\boldsymbol{H}}\left[ {\begin{array}{*{20}{l}} u\\ v\\ 1 \end{array}} \right] = \left( {\begin{array}{*{20}{l}} {{h_1}}&{{h_2}}&{{h_3}}\\ {{h_4}}&{{h_5}}&{{h_6}}\\ {{h_7}}&{{h_8}}&{{h_9}} \end{array}} \right)\left[ {\begin{array}{*{20}{l}} u\\ v\\ 1 \end{array}} \right] $ | (1) |

|

图 2 基于逆投影差分的障碍物检测原理 Fig. 2 Obstacle detection principle based on inverse perspective mapping difference |

式中:[u v 1]T为图像I(u, v)上对应点的坐标,[x y 1]T为I(x, y)上的点,H为包含相机内在和外在参数的单应性矩阵见式(2):

| $ \boldsymbol{H}=\boldsymbol{K}\left[\begin{array}{lll} \boldsymbol{r}_{1} & \boldsymbol{r}_{2} & \boldsymbol{t} \end{array}\right] $ | (2) |

式中: K为摄像机的固有参数,旋转矩阵R和平移向量t为摄相机的外部参数。r1和r2为R的前两个列向量,满足式(3):

| $ \left\{\begin{array}{l} \boldsymbol{r}_{1}^{\mathrm{T}} \boldsymbol{n}=\boldsymbol{r}_{2}^{\mathrm{T}} \boldsymbol{n}=0 \\ \boldsymbol{r}_{1}^{\mathrm{T}} \boldsymbol{r}_{2}=0 \\ \left\|\boldsymbol{r}_{1}\right\|=\left\|\boldsymbol{r}_{2}\right\|=1 \end{array}\right. $ | (3) |

上述畸变系数、相机内参数均通过张正友标定法获得[16-17]。

对于环视系统的四路图像,在逆投影时选取同一世界坐标系和参考平面即可把四路逆投影图像统一于同一坐标系下,便于后续的差分操作。由于逆投影变换消除了透视形变,则在障碍物定位阶段可以通过逆投影图像来直接测量障碍物到摄像机的距离。

1.2 基于逆投影差分的障碍物检测基于逆投影差分的障碍物检测,用于移动机器人环视系统中每两个相邻相机公共视野中障碍物的检测和定位。其原理就是通过环视系统两个不同视角的图像差分来去除噪声和背景部分以对障碍物进行检测。但是,很难通过传统的图像差分法对静止的目标进行识别。由于障碍物上的点在不同视角下的逆投影平面所处的位置不同,而参考平面上的点在不同视角下的逆投影平面处于同一位置,因此,可以将任意两个相邻相机的逆投影图像进行差分处理,以区分障碍物和参考平面,实现检测。

图 2为算法原理,假设图中为环视系统中某相邻的两个相机,其光心分别位于点C1和点C2,虚线框π0表示参考地平面,由图可知,对于π0上一点Q2,在C1与C2处的成像逆投影到π0平面上均为Q2,像素值相同;而对于高于π0的点Q1和低于π0的点Q3,在C1和C2处的成像逆投影到π0分别为Q4、Q5以及Q6、Q7,像素值不同。

这里以环视系统的前视和右视相机为例来说明检测障碍物的过程。以π0为参考平面,设If(x, y)与Ir(x, y)为坐标统一之后的前视和右视逆投影图像,则两者之间的逆投影差分图像d(x, y)为

| $ \boldsymbol{d}(x, y)=\boldsymbol{I}_{\mathrm{f}}(x, y)-\boldsymbol{I}_{\mathrm{r}}(x, y) $ | (4) |

但是,由于不同视角的摄像机捕获的图像具有不同的视角和位置,不同图像中位于地面的点像素值可能也有些许差异,相减可能并不刚好为零,为了突出障碍物区域,可对上述逆投影差分图设置阈值进行二值化分割:

| $ \boldsymbol{B}(x, y)= \begin{cases}1, & \boldsymbol{d}(x, y)>\tau \\ 0, & \boldsymbol{d}(x, y) \leqslant \tau\end{cases} $ | (5) |

式中:B(x, y)为对应的二值图,τ为二值操作的阈值,B(x, y)=1表示高出于参考平面的障碍物上点,B(x, y)=0表示位于参考平面的点。这里通过大津算法[18]来选取最佳阈值τ,设通过τ分割后前景的像素点数占全部像素点的比例为ω0,平均灰度为μ0;同理背景像素点数占全部像素点的比例为ω1,平均灰度为μ1。将图像总平均灰度记为μ,类间方差记为g则有:

| $ \mu=\omega_{0} \times \mu_{0}+\omega_{1} \times \mu_{1} $ | (6) |

| $ g=\omega_{0}\left(\mu_{0}-\mu\right)^{2}+\omega_{1}\left(\mu_{1}-\mu\right)^{2} $ | (7) |

由于式(7)计算量较大,将式(6)带入式(7)即可得到其等价公式:

| $ g=\omega_{0} \omega_{1}\left(\mu_{0}-\mu_{1}\right)^{2} $ | (8) |

采用遍历的方法得到使g最大的阈值τ,即为所求。

为了能够更清晰的分离参考平面点和障碍物上的点,这里使用形态学开运算的方法来滤除二值化产生的噪声点,见式(9):

| $ \boldsymbol{F}(x, y)=(\boldsymbol{B}(x, y) \Theta \mathrm{SE}) \oplus \mathrm{SE} $ | (9) |

式中: F(x, y)为滤波后图像,Θ为形态学中的腐蚀操作,⊕为形态学中的膨胀操作,SE为开运算操作的核函数。开运算操作可以很好的消除图像中离散的噪声。

由式(5)、(9)可得F(x, y)=0为参考平面上的点,F(x, y)=1为平面外障碍物上的点。则可通过二值图中非平面点的占比来判断移动机器人附近区域障碍物占用情况。

将机器人附近想要检测的区域设置为感兴趣区域(region of interest, ROI),可以使用式(10)计算感兴趣区域中非平面的比率:

| $ t=\frac{\sum \boldsymbol{F}(x, y)}{\sum \boldsymbol{F}(x, y)+\sum(1-\boldsymbol{F}(x, y))} $ | (10) |

式中F(x, y)=1,(x, y)为ROI内的点。可以通过对t设置阈值来判断ROI内是否存在障碍物,即当非平面的比率大于某一阈值时,则认定检测区域内存在障碍物。

1.3 基于移动机器人自身坐标系的障碍物定位提出的算法除了障碍物检测功能外还能够实现障碍物的精准定位。用二值化后的逆投影差分图来进行障碍物定位,通过障碍物在机器人自身坐标系下的方向和到原点的距离来描述障碍物的状态。

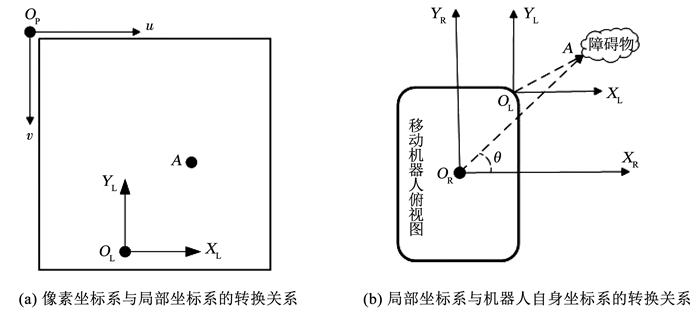

为了更好的说明障碍物状态估计的过程,同样以前视相机与右视相机为例,所使用的坐标系配置见图 3,其中像素坐标系(pixel coordinate system, PCS)为OP-uv,坐标原点位于图像左上角;障碍物局部坐标系(local coordinate system, LCS)为OL-XLYL,坐标原点位于移动机器人右前角;机器人自身坐标系(robot coordinate system, RCS)为OR-XRYR,坐标原点位于移动机器人中心点。

|

图 3 障碍物状态估计的坐标系配置 Fig. 3 Coordinate system for obstacle state estimation |

如图 3(b)所示,以障碍物在RCS中离其原点最近的点A的坐标来表示其的位置,障碍物的方向由θ表示。图 3(a)说明了PCS与LCS之间的转换关系,由于逆投影变换是把图像逆映射在了世界坐标系中z为0的参考平面(地平面)上,因此PCS与LCS之间的转换关系可以仅通过二维变换来求得。

令(uA, vA)为障碍物上的最近点A在PCS中的坐标,而(uOL, vOL)来表示LCS的原点OL在PCS中的坐标。则点A在LCS中的坐标可以推导为

| $ \left\{\begin{array}{l} x_{\mathrm{L}}=s\left(u_{\mathrm{A}}-u_{\mathrm{O}_{\mathrm{L}}}\right) \\ y_{\mathrm{L}}=s\left(v_{\mathrm{O}_{\mathrm{L}}}-u_{\mathrm{A}}\right) \end{array}\right. $ | (11) |

式中: (xL, yL)为障碍物上最近点A在LCS中的坐标,s为通过标定获得的像素坐标与真实世界坐标之间的比例因子。

图 3(b)显示了LCS和RCS之间的转换关系。由于两个坐标系的轴是平行的,因此只需通过平移来进行坐标系之间的转换,可以表示如下:

| $ \left\{\begin{array}{l} x_{\mathrm{R}}=x_{\mathrm{L}}+x_{\mathrm{O}_{\mathrm{L}}} \\ y_{\mathrm{R}}=y_{\mathrm{L}}+y_{\mathrm{O}_{\mathrm{L}}} \end{array}\right. $ | (12) |

式中: (xR, yR)为点A在RCS中的坐标,(xOL, yOL)为LCS的原点OL在RCS中的坐标,可以通过实际测量获得。由于已经通过式(11)和式(12)计算出了障碍物在RCS中的坐标,因此可以通过式(13)、(14)估算障碍物在RCS中的方位。

| $ D=\sqrt{\left(x_{\mathrm{R}}^{2}+y_{\mathrm{R}}^{2}\right)} $ | (13) |

式中D为障碍物上最近点A与RCS原点连线的长度,用来表示障碍物离机器人的距离。

| $ \theta=\arctan \left(y_{\mathrm{R}} / x_{\mathrm{R}}\right) $ | (14) |

式中θ为点A和RCS原点的连线与其X轴的夹角,用来表示障碍物方向。

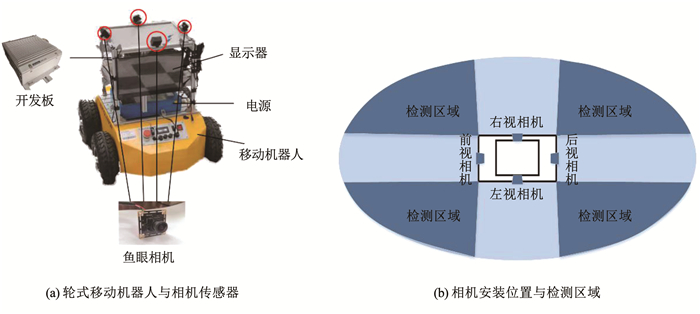

2 实验结果与分析图 4为实验所用的移动机器人与传感器安装示意。如图 4(a)所示,选用轮式移动机器人为载体,角度可调节的广角鱼眼相机为感知设备,前后左右四路相机固定在移动机器人前后左右的中间约75 cm高度处组成机载环视系统;障碍物检测范围由两相邻相机的视场角以及安装的位置和角度决定,实验中每个摄像机水平视场为180°,分辨率为1 920×1 080像素,两个相邻相机之间的旋转角度约为90°,俯仰角不做限制,以相机视野中刚好出现机器人底部为佳,有效检测区域为视场相交区域的范围约为80°。

|

图 4 移动机器人与传感器安装示意 Fig. 4 Diagram of mobile robot and sensor installation |

由于成像原理的限制,距离相机越远的地方一个像素所代表的距离越大,导致逆投影图中越远区域图像拉伸变形越严重,检测效果越差,根据多次实验结果,定义距离范围为0~5 m,能满足应用于低速场景的移动机器人需求。图 4(b)所示为相机的安装位置和有效检测区域。

实验结果以移动机器人环视系统中的前视和右视相机进行障碍物检测为例进行分析,前视相机和右视相机相关参数见表 1。

| 表 1 前视相机和右视相机参数 Tab. 1 Parameters of front-view and right-view cameras |

由于相机内外参数没有真值只能通过标定得到,因此对于利用棋盘格标定得到的标定精度数据,我们用棋盘格上角点在所设世界坐标系中的坐标通过内参数、畸变系数、外参数重投影到原图上的误差来表示,可同时衡量标定所得的内外参精度。如图 5所示,左边为拍摄的棋盘格置于参考平面的原始图片,右边为棋盘格上角点通过标定数据重投影到图像中的位置。24个角点中,最大重投影误差为0.32个像素,最小重投影误差为0.18个像素,平均重投影误差为0.24个像素。

|

图 5 重投影图 Fig. 5 Reprojection images |

实验过程分为:障碍物检测、障碍物定位与对比算法三部分。在检测阶段,选取500 cm×500 cm的ROI区域来限制检测范围,以减少数据处理负荷和检测异常的情况。使用3×3的核函数对二值图像进行滤波消除离散的噪声点,最后,通过计算ROI中非平面点的比率来判断检测区域是否存在障碍物。在障碍物定位阶段,将障碍物上离相机最近的点设置为位置计算的起点,获取各个障碍物相对移动机器人中心的距离。对比算法部分把本文算法与目前常见的三维重建以及深度学习的目标检测方法进行性能对比,来说明所提出算法的优越性。

实验分别在室内和室外两种环境采集数据进行测试,且均在相同的软硬件环境下进行,其CPU为:Intel Core i7-9750H 2.6 GHz,16 GB内存,编程环境为VS2019/C+ +。

2.1 障碍物检测实验结果与分析1) 室外场景实验结果和分析

实验一选取武汉理工大学余家头校区航海楼的室外环境为实验场景。相对于室内场景,室外场景的环境更为复杂多变,使得障碍物检测与室内场景相比具有更大的难度。

在实验中,控制移动机器人随意行进,并使用本文算法对不同距离的障碍物进行检测。选取具有代表性的动、静态障碍物检测过程见图 6。图 6中第1行为前视和右视相机拍摄的原始图像经过畸变校正得到的校正图,第2行为两者所对应的逆投影图像,第3行左边为两逆投影图像经差分生成的逆投影差分图,第3行右边为差分图通过二值化、形态学滤波和ROI提取等后处理之后得到的最终的检测图,图中地平面为黑色,高于地面的障碍物部分则显示为白色,可检测区域为两相邻视角图像的公共区域。

|

图 6 室外场景障碍物检测 Fig. 6 Obstacle detection in outdoor scenes |

实验中,共检测障碍物107次,其中38次汽车,47次路缘石,7次路障,15次花坛。最终的检测结果见表 2,其中第3列给出了错测次数,第4列显示了检测的准确率。可以看出,本文算法成功检测障碍物104次,检测精度为97.2%。

| 表 2 室外场景障碍物检测结果 Tab. 2 Obstacle detection results in outdoor scenes |

2) 室内场景实验结果和分析

实验二选取武汉理工大学余家头校区航海楼室内走廊为实验场景,室内环境相对于室外存在空间小、光线暗等限制。在实验中,控制移动机器人沿室内过道行进,并使用所提出的算法进行障碍物检测。共检测障碍物113次,其中检测行人48次,台阶19次,垃圾桶25次,墙壁21次。部分检测结果见图 7,分别为动态障碍物和静态障碍物检测情况。

|

图 7 室内场景障碍物检测 Fig. 7 Obstacle detection in indoor scenes |

最终的结果统计见表 3,在室内总共113次障碍物检测实验中,本文算法成功检测110次,检测精度为97.3%。

| 表 3 室内场景障碍物检测结果 Tab. 3 Obstacle detection results in indoor scenes |

障碍物定位实验中,检测远近不同目标距离共20次,以验证算法对障碍物定位的效果,以及障碍物实际距离对于定位精度的影响。由于从机器人中心到障碍物的真实距离不方便测量,难以评定误差,实验结果由在LCS下的定位结果给出,部分结果见表 4。表 4列出了5 m范围内由近及远的10次障碍物定位结果,其中,前5次实验为针对于距离在1 m以内的超近障碍物的定位;表中第1列为实验次数编号,第2列为通过本文算法所计算的障碍物距离,第3列为障碍物上最近点到移动机器人的真实距离,第4列为误差率。

| 表 4 障碍物定位实验结果 Tab. 4 Obstacle location experimental results |

由表 4可知,本文提出的算法对于超近距离障碍物定位有较好效果,定位误差在0.87%左右,随着障碍物的距离增加测距的误差变大,但5 m内的相对误差都小于1.5%,平均相对误差为1.1%。

2.3 对比实验结果和分析为体现本文算法的优越性,与目标检测常用的两种算法进行对比,包括基于三维重建的目标检测方法和基于深度学习的目标检测方法,在相同环境下,使用与本文算法相同的数据集,检测结果见表 5,分别列出了3种算法在检测耗时、检测准确性与定位误差的优异。

| 表 5 各方法对比结果 Tab. 5 Comparison of results of different methods |

以文献[8]为代表的立体视觉方法耗时较长,对于障碍物的检测有一定局限性,不能满足实时检测的要求。检测的准确性仅为93.2%,其原因是小物体的三维重建精度较差,立体相机基线长短以及与障碍物的距离也会对检测精度造成影响。文献[12-14]使用深度学习进行目标检测,本文使用文献[13]提出的YOLO系列最新的YOLO-V5网络来进行对比实验,由结果可知,深度学习在固定类别的目标检测和识别上准确率高,但在检测固定类别之外的障碍物方面存在缺陷。当场景中目标较多时,检测耗时也会随之增大,且生成包围盒的位置会对障碍物检测与定位的精度造成波动。

从表 5给出的结果可以看出,相对于目前常见的算法,本文提出的算法在耗时以及检测和定位精度方面均有较大提升。

3 结论1) 障碍物检测模块,通过相邻视角图像的逆投影差分,来检测其视野公共区域的障碍物,检测准确率为97.3%。

2) 障碍物定位模块,通过坐标系的转换,获取障碍物相对于移动机器人的准确位置信息,定位误差随着距离的增加而增大,在5 m内定位平均相对误差为1.1%。

3) 提出的算法有效改善了传统方法对于超近距离障碍物的检测效果不佳的问题,可以检测出1 m以内的超近障碍物,且定位误差稳定在0.87%左右。

4) 提出的算法无需经过耗时的三维重建与目标识别,提高了运算速度,检测时间为46 ms/帧,能够满足移动系统对算法实时性的要求, 实现障碍物快速检测。

| [1] |

HOU Zhaolei, JIANG Yong, LIU Guodong, et al. Obstacle detection in the surrounding environment of manipulators based on point cloud data[C]//Proceedings of 2019 IEEE 9th Annual International Conference on CYBER Technology in Automation, Control, and Intelligent Systems (CYBER). Suzhou: IEEE, 2019: 1058. DOI: 10.1109/CYBER46603.2019.9066621

|

| [2] |

XU Wenyuan, YAN Chen, JIA Weibin, et al. Analyzing and enhancing the security of ultrasonic sensors for autonomous vehicles[J]. IEEE Internet of Things Journal, 2018, 5(6): 5015. DOI:10.1109/JIOT.2018.2867917 |

| [3] |

LÓPEZ-TAPIA S, MOLINA R, DE LA BLANCA N P. Deep CNNs for object detection using passive millimeter sensors[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2019, 29(9): 2580. DOI:10.1109/TCSVT.2017.2774927 |

| [4] |

胡钊政, 李招康, 陶倩文. 基于分布式二维激光测距仪的室内行人检测与跟踪[J]. 吉林大学学报(工学版), 2020, 50(2): 719. HU Zhaozheng, LI Zhaokang, TAO Qianwen. Indoor pedestrian detection and tracking from distributed two-dimensional laser range finders[J]. Journal of Jilin University (Engineering and Technology Edition), 2020, 50(2): 719. DOI:10.13229/j.cnki.jdxbgxb20181043 |

| [5] |

SAHBA R, SAHBA A, JAMSHIDI M, et al. 3D object detection based on LiDAR data[C]//Proceedings of 2019 IEEE 10th Annual Ubiquitous Computing, Electronics & Mobile Communication Conference (UEMCON). New York: IEEE, 2019: 0511. DOI: 10.1109/UEMCON47517.2019.8993088

|

| [6] |

蒋林, 方东君, 雷斌, 等. 单目视觉移动机器人导航算法研究现状及趋势[J]. 计算机工程与应用, 2021, 57(5): 1. JIANG Lin, FANG Dongjun, LEI Bin, et al. Research status and trend of navigation algorithm for mobile robot with monocular vision[J]. Computer Engineering and Applications, 2021, 57(5): 1. DOI:10.3778/j.issn.1002-8331.2011-0119 |

| [7] |

BHOITE A, BEKE N, NANDURI S, et al. Advanced situational awareness and obstacle detection using a monocular camera[C]//Proceedings of 2010 Western New York Image Processing Workshop. Rochester: IEEE, 2010: 30. DOI: 10.1109/WNYIPW.2010.5649763

|

| [8] |

HUANG Le, WU Gongping, LIU Jiayang, et al. Obstacle distance measurement based on binocular vision for high-voltage transmission lines using a cable inspection robot[J]. Science Progress, 2020, 103(3): 1. DOI:10.1177/0036850420936910 |

| [9] |

JIANG Chengfu, GAO Yuanlou, YANG Pingfa. Research on target ranging of mobile robot based on binocular vision[C]//Proceedings of 2021 3rd International Conference on Robotics and Computer Vision (ICRCV). Beijing: IEEE, 2021: 1. DOI: 10.1109/ICRCV52986.2021.9546971

|

| [10] |

LEE S, HYEON D, PARK G, et al. Directional-DBSCAN: parking-slot detection using a clustering method in around-view monitoring system[C]//Proceedings of 2016 IEEE Intelligent Vehicles Symposium (IV). Gothenburg: IEEE, 2016: 349. DOI: 10.1109/IVS.2016.7535409

|

| [11] |

HSU C M, CHEN Jianyu. Around view monitoring-based vacant parking space detection and analysis[J]. Applied Sciences, 2019, 9(16): 3403. DOI:10.3390/app9163403 |

| [12] |

O'KEEFFE S, VILLING R. Evaluating pruned object detection networks for real-time robot vision[C]//Proceedings of 2018 IEEE International Conference on Autonomous Robot Systems & Competitions. Torres Vedras: IEEE, 2018: 91. DOI: 10.1109/ICARSC.2018.8374166

|

| [13] |

REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once: unified, real-time object detection[C]// Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas: IEEE, 2016: 1063. DOI: 10.1109/CVPR.2016.91

|

| [14] |

王殿伟, 方浩宇, 刘颖, 等. 一种基于改进RT-MDNet的全景视频目标跟踪算法[J]. 哈尔滨工业大学学报, 2020, 52(10): 152. WANG Dianwei, FANG Haoyu, LIU Ying, et al. Improved RT-MDNet for panoramic video target tracking[J]. Journal of Harbin Institute of Technology, 2020, 52(10): 152. DOI:10.11918/201910175 |

| [15] |

KAKANI V, KIM H. Adaptive self-calibration of fisheye and wide-angle cameras[C]//Proceedings of TENCON 2019—2019 IEEE Region 10 Conference (TENCON). Kochi: IEEE, 2019: 976. DOI: 10.1109/TENCON.2019.8929339

|

| [16] |

ZHANG Zhengyou. A flexible new technique for camera calibration[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2000, 22(11): 1330. DOI:10.1109/34.888718 |

| [17] |

HU Zhaozheng, LI Na. Vision-based position computation from in-vehicle video log images for road sign inventory[J]. IET Intelligent Transport System, 2016, 10(6): 414. DOI:10.1049/iet-its.2015.0078 |

| [18] |

OTSU N. A threshold selection method from gray-level histograms[J]. IEEE Transactions on Systems, Man, and Cybernetics, 1979, 9(1): 62. DOI:10.1109/TSMC.1979.4310076 |

2022, Vol. 54

2022, Vol. 54