2. 江苏省食品先进制造装备技术重点实验室(江南大学),江苏 无锡 214122

2. Jiangsu Key Laboratory of Advanced Food Manufacturing Equipment and Technology (Jiangnan University), Wuxi 214122, Jiangsu, China

在自然环境中,声音是传递信息的重要媒介,也是人类听觉感知系统的重要组成部分。在对复杂环境中的声音事件进行感知方面,人类的固有能力使其不仅能同时捕捉多个声源的信息,且能有选择地屏蔽周围的背景噪音。当前,随着智能技术的快速发展,许多智能设备虽能高效地识别语音信息和声纹信息[1],但对复杂环境中的声音事件进行分类识别时,往往会因为背景噪音的影响而导致分类识别的准确率不高[2-3]。

针对声学场景分类研究,国内外诸多学者大都采用特征融合、特征补偿等方法对特征图中的信息进行增强处理[3-8]。其中,文献[3]提出了一种将梅尔频谱、短时能量、声学似然特征和静音时间4个特征通过拼接以实现特征间融合的方法,该模型在Dcase2017数据集上的平均准确率达到了71.1%;文献[4]提出了一种将梅尔倒谱系数和伽马通倒谱系数通过线性叠加处理进行融合的方法,并基于卷积神经网络开展了特征融合实验,其模型的分类准确率达到了87.7%;文献[5]提出了一种梅尔倒谱系数和Teager能量算子混合的特征融合方法,在一定程度上起到了抑制背景噪声的作用,其在血管声学分类任务中精度达到了99.5%;文献[6-8]采用CNN和DCNN作为分类模型开展了声学场景分类研究。

综上所述,针对声学场景分类研究中的特征处理方法虽然已经有较为深入的研究,但不难发现:1) 已有研究成果中,并未对背景噪音进行针对性处理,这会导致模型将正确的音频类别错误地识别成背景噪音的音频类别或与背景噪音相近的其他音频类别,从而降低模型的分类准确率;2) 现有声学模型相对单一,未能对特征图中的频域信息进行关注,导致了模型的分类准确率不高,泛化性能不强等问题。

基于上述问题,本文提出了一种基于梅尔频谱特征分离和长距离自校正卷积神经网络(long-distance self-calibration convolutional reural network, LSCNet)的声学场景分类方法。首先,基于谐波打击源分离原理提出了一种梅尔频谱分离算法,将梅尔频谱分离出谐波分量、打击源分量和残差分量,其中梅尔频谱的残差分量针对性地降低了背景噪音对模型的影响;然后,设计了一种长距离自校正神经网络,该模型采用频域自校正算法以及长距离增强机制,可在特征提取的同时保留特征图原始信息,并结合多尺度特征融合模块,以进一步保留模型训练中输出层的有效信息;最后,基于LSCNet模型利用Urbansound8K和ESC50数据集开展了声学场景分类实验,结果验证了所提方法及模型的有效性。

1 声学特征分离 1.1 频谱的谐波打击源分离频谱的谐波打击源分离是将频谱中的混合信号分离出谐波分量和打击源分量。频谱是一种由时间和频率两个维度构成的图片,可通过分帧后的音频信号经过短时傅里叶变换转换而来。将中值滤波器应用于频谱分离即可获得频谱的谐波分量和打击源分量[9],下面介绍其具体的工作原理。

首先,通过短时傅里叶变换将音频信号转化成频谱信号S,频谱的时域分量S(t)=[t1, t2, …, tm]和频域分量S(f)=[f1, f2, …, fn],其中m为时间帧的数量,n为频率帧的数量。

其次,定义中值滤波计算如下:

| $ \begin{gathered} y(a)=\operatorname{median}\{x(a-j, a+j), \\ j=(l-1) / 2\} \end{gathered} $ | (1) |

式中:x(a)为输入信号序列,l为滤波器的长度,y(a)为输出信号序列,median{}为中值滤波器函数。基于式(1)将频谱S的时域分量S(t)和频域分量S(f)的绝对值作为输入信号,则输出信号为频谱S的谐波增强部分H和打击源增强部分P:

| $ \boldsymbol{P}=\operatorname{median}\left\{|\boldsymbol{S}(t)|, l_{\mathrm{P}}\right\} $ | (2) |

| $ \boldsymbol{H}=\operatorname{median}\left\{|\boldsymbol{S}(f)|, l_{\mathrm{H}}\right\} $ | (3) |

式中: lP为打击源增强部分的滤波器长度,lH为谐波增强部分的滤波器长度。

然后,基于频谱的谐波增强部分和打击源增强部分,可计算出其各自的相对分量MH和MP如下:

| $ \boldsymbol{M}_{\mathrm{H}}=\frac{\boldsymbol{H}^{p}}{\boldsymbol{H}^{p}+\boldsymbol{P}^{p}} $ | (4) |

| $ \boldsymbol{M}_{\mathrm{P}}=\frac{\boldsymbol{P}^{p}}{\boldsymbol{H}^{p}+\boldsymbol{P}^{p}} $ | (5) |

式中:Hp为谐波增强部分的能量,Pp为打击源增强部分的能量,上标p为能量系数。

最后,基于频谱并结合谐波增强部分和打击源部分的相对分量得到频谱谐波分量(spectrogram harmonic component, CSH)和频谱打击源分量(spectrogram percussive-source component, CSP),定义如下:

| $ C_{\mathrm{SH}}=\boldsymbol{S} \otimes \boldsymbol{M}_{\mathrm{H}} $ | (6) |

| $ \boldsymbol{C}_{\mathrm{SP}}=\boldsymbol{S} \otimes \boldsymbol{M}_{\mathrm{P}} $ | (7) |

式中⊗表示两矩阵对应位置元素相乘,结果为同型矩阵。选取绵羊叫声和水滴声两个不同场景下,音频的频谱与其谐波分量和打击源分量进行对比,见图 1。

|

图 1 频谱分离前后特征对比 Fig. 1 Comparison of features before and after spectrogram separation |

由图 1可知:CSH表现为平行于时间轴的水平线,CSP表现为平行于频率轴的垂直线,且分离后得到的CSH和CSP特征中背景亮斑(通常由背景噪音产生)更少。

1.2 梅尔频谱的分离频谱分离方法虽在一定程度上减少了特征图中的背景亮斑,但仍存在以下问题:1)频谱是赫兹尺度的特征矩阵,其包含的有效声学信息较少;2)不同音频样本中背景噪音的表现形式存在差异,频谱分离方法未能实现对背景噪音的针对性处理。有鉴于此,本文提出了一种梅尔频谱分离方法。

由于人耳的听觉范围与赫兹尺度的频率呈非线性关系,这导致了人耳对不同频率声音的感知灵敏度不同。基于这种特性,将声音频带从低到高按临界带宽由密到疏设置三角滤波器,即梅尔滤波器组[10],其中心频率即为梅尔频率,梅尔频率Mel(f)与频率f间的转换关系为

| $ \operatorname{Mel}(f)=\frac{1\ 000}{\log 2} \log \left(\frac{f}{1\ 000}+1\right) $ | (8) |

首先,将频谱S通过上述梅尔滤波器组得到梅尔频谱Sm,并将梅尔频谱的时域分量Sm(t)和频域分量Sm(f)的绝对值作为输入信号输入中值滤波器,其输出信号为梅尔频谱的谐波增强部分Hm和打击源增强部分Pm。

其次,将梅尔频谱的残差部分Rm定义为

| $ \boldsymbol{R}_{\mathrm{m}}=\left|\boldsymbol{S}_{\mathrm{m}}\right|-\left(\boldsymbol{P}_{\mathrm{m}}+\boldsymbol{H}_{\mathrm{m}}\right) $ | (9) |

然后,基于梅尔频谱的谐波增强部分Hm、打击源增强部分Pm和残差部分Rm,计算出其各自的相对分量MHm、MPm和MRm如下:

| $ \boldsymbol{M}_{\mathrm{Hm}}=\frac{\boldsymbol{H}_{\mathrm{m}}^{p}}{\boldsymbol{H}_{\mathrm{m}}^{p}+\boldsymbol{P}_{\mathrm{m}}^{p}+\boldsymbol{R}_{\mathrm{m}}^{p}} $ | (10) |

| $ \boldsymbol{M}_{\mathrm{Pm}}=\frac{\boldsymbol{P}_{\mathrm{m}}^{p}}{\boldsymbol{H}_{\mathrm{m}}^{p}+\boldsymbol{P}_{\mathrm{m}}^{p}+\boldsymbol{R}_{\mathrm{m}}^{p}} $ | (11) |

| $ \boldsymbol{M}_{\mathrm{Rm}}=\frac{\boldsymbol{R}_{\mathrm{m}}^{p}}{\boldsymbol{H}_{\mathrm{m}}^{p}+\boldsymbol{P}_{\mathrm{m}}^{p}+\boldsymbol{R}_{\mathrm{m}}^{p}} $ | (12) |

最后,利用梅尔频谱结合谐波增强部分、打击源增强部分和残差部分的相对分量得到梅尔频谱谐波分量CMSH(Mel-spectrogram harmonic component)、梅尔频谱打击源分量CMSP(Mel-spectrogram percussive-source component)和梅尔频谱残差分量CMSR(Mel-spectrogram residual component)分别为:

| $ \boldsymbol{C}_{\mathrm{MSH}}=\boldsymbol{S}_{\mathrm{m}} \otimes \boldsymbol{M}_{\mathrm{Hm}} $ | (13) |

| $ \boldsymbol{C}_{\mathrm{MSP}}=\boldsymbol{S}_{\mathrm{m}} \otimes \boldsymbol{M}_{\mathrm{Pm}} $ | (14) |

| $ \boldsymbol{C}_{\mathrm{MSR}}=\boldsymbol{S}_{\mathrm{m}} \otimes \boldsymbol{M}_{\mathrm{Rm}} $ | (15) |

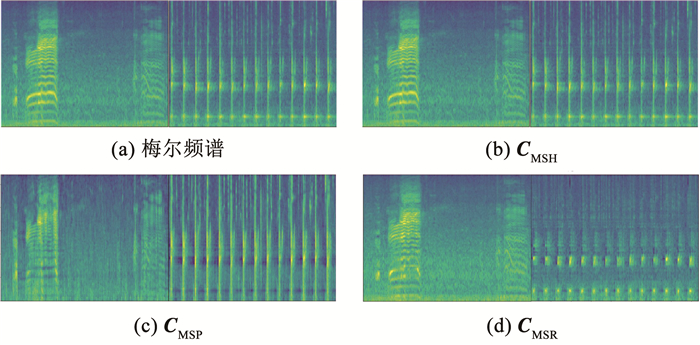

为更直观地阐述梅尔频谱分离和频谱分离间的差别,同理选取上述4个不同场景下音频的梅尔频谱与其谐波分量、打击源分量和残差分量进行对比,见图 2。

|

图 2 梅尔频谱分离前后特征对比 Fig. 2 Comparison of features before and after Mel-spectrogram separation |

对比图 1(a)和图 2(a)可知:1)相较于频谱,梅尔频谱中的亮斑更清晰,说明其中包含更多的声学信息;对比图 2可知:2)梅尔频谱中的亮斑最清晰,但其包含有效特征信息和背景噪音信息;3)CMSH中水平亮斑表现得更清晰,其虽增强了梅尔频谱中的谐波部分,但背景噪音的谐波部分同样也得到了增强; CMSP中垂直亮斑表现得更清晰,其虽然增强了梅尔频谱中的打击源部分,但背景噪音的打击源部分同样也得到了增强;4)CMSR中的亮斑较清晰,其不仅最大限度保留了有效特征信息,且针对性地减弱了背景噪音造成的亮斑; 相比文献[3-5]中的特征融合或特征补偿方法,CMSR针对性地抑制了背景噪音的影响。

2 长距离自校正神经网络近年来,利用卷积神经网络对声学信息进行提取已成为声学领域的重要研究方法之一[11-12],必须指出的是:1)文献[6-8]仅采用单一的模型提取特征图中的有效信息,而减少了对特征图中浅层特征的关注;2)声学特征图中的关键信息主要包含在频域中[13],故增加对频域信息的关注,对特征图信息的提取有显著优势。

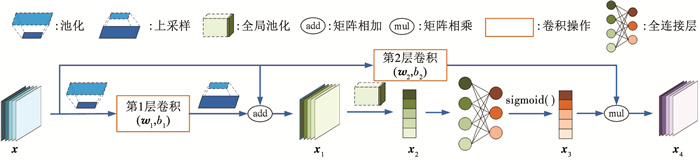

2.1 频域自校正算法在图像识别领域,自校正结构常被应用为分组卷积的一个分支,该结构通过对图像的两个维度进行尺寸变换来间接扩大卷积核的感受野,故能更高效地提取图像中的上下文信息[14]。在声学场景分类领域,频谱常用来表示音频在时间和频率两个维度上的信息,且频域部分包含音频的大量关键信息,故提出一种频域自校正算法以期实现频域信息的高效采集,频域自校正算法的工作原理见图 3。

|

图 3 频域自校正结构示意 Fig. 3 Schematic diagram of frequency domain self-calibration structure |

首先,通过池化运算将输入特征图x的频率维度压缩,再通过卷积层提取特征信息,从而间接扩大卷积核在频域上的感受野;其次,将输出结果通过上采样恢复成原始特征图的维度并与原始特征图求和得到x1,以保留输入层特征图中的有效信息;然后,将结果通过全局池化压缩成一维向量x2并通过全连接层和sigmoid函数将每个通道权值重新标定得到x3;最后,将卷积后的原始特征图与权值向量x3在通道维做乘积运算得到输出特征图x4,以实现通道间的注意力增强。频域自校正结构的算法流程如下:

| $ \boldsymbol{x}_{1}=U\left[\boldsymbol{w}_{1} D[\boldsymbol{x}]_{1 \times r}+b_{1}\right]_{1 \times r}+\boldsymbol{x} $ | (16) |

| $ \boldsymbol{x}_{2}=F_{\mathrm{sq}}\left(\boldsymbol{x}_{1}\right)=\frac{1}{H \times W} \sum\limits_{i=1}^{H} \sum\limits_{j=1}^{W} \boldsymbol{x}_{1}(i, j) $ | (17) |

| $ \boldsymbol{x}_{3}=\sigma\left[\boldsymbol{w}_{4} f\left(\boldsymbol{w}_{3} \boldsymbol{x}_{2}\right)\right] $ | (18) |

| $ \boldsymbol{x}_{4}=\left(\boldsymbol{w}_{2} \boldsymbol{x}+b_{2}\right) \cdot \boldsymbol{x}_{3} $ | (19) |

式中:D[·]1×r为池化运算,U[·]1×r为上采样运算,其中1×r为池化核和上采样核的大小;w1和b1为第1层卷积的权重矩阵和偏置值;Fsq(·)为挤压激励函数,其将尺寸为H×W×C的特征图(H为时域维度,W为频域维度,C为通道数)压缩为一维向量;σ[·]为sigmoid函数;f(·)为ReLU激活函数;w3和w4分别为两个全连接层的权重矩阵;w2和b2为第2层卷积的权重矩阵和偏置值。

基于上述分析,频域自校正算法通过压缩频率维度,提升了卷积核在频域的感受野,并通过残差结构和通道注意力增强机制,加强了深层特征与浅层特征间的关联度,故更有利于模型对有效信息的采集。

2.2 长距离增强结构为进一步保留模型训练初期采集到的浅层特征信息并与之后采集到的深层特征信息互补偿,从而达到特征增强的作用,提出了一种长距离增强结构,下面介绍其具体工作原理。

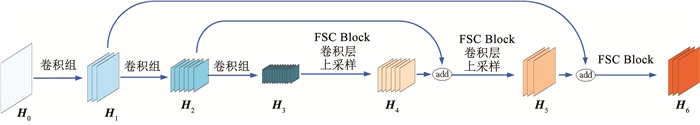

首先,设置n组卷积组用于采集特征图中的浅层特征信息(n为大于1的整数);其次,基于频域自校正结构设置n组频域自校正模块(frequency-domain self-calibration block, FSC Block)用于采集特征图中的深层特征信息;最后,利用残差操作将第n-1个卷积组的输出特征与第1个FSC Block的输出特征进行叠加融合,第n-2个卷积组的输出特征与第2个FSC Block的输出特征进行叠加融合,以此类推,直到第1个卷积组的输出特征与第n-1个FSC Block的输出特征进行叠加融合,以实现网络模型的长距离增强,期间分别采用卷积运算和上采样运算使二者的通道数及分辨率保持一致。当n=3时,长距离增强结构示意见图 4。

|

图 4 长距离增强结构示意 Fig. 4 Schematic diagram of long-distance reinforcement structure |

图 4中,H0为输入层,H1、H2和H3为经过卷积组操作的输出层,H4、H5为经过FSC Block、卷积层和上采样操作的输出层,H6为经过FSC Block的输出层。卷积组中均包含两个卷积层和一个2×2池化层。当n设置为不同值时,长距离增强结构的各项参数设置见表 1。

| 表 1 长距离增强结构参数设置 Tab. 1 Parameter setting of long-distance reinforcement structure |

由表 1可知,当设置n组卷积组时,第i个残差操作的输出层HiRes定义为

| $ \boldsymbol{H}_{i}^{\mathrm{Res}}=\boldsymbol{H}_{i}+\boldsymbol{H}_{2 n-i}, i=1,2, \cdots, n-1 $ | (20) |

由于FSC Block操作输出的特征图具有不同的分辨率,且不同分辨率的特征图中包含的特征信息均存在一定的差异。为实现不同分辨率特征信息的互补偿自适应,并提高对小目标的检测精度,利用多尺度特征融合方法[15],将FSC Block操作的输出层尺寸通过池化操作进行统一,并将结果在通道维度进行合并。

综上所述,长距离增强结构将模型采集到的浅层信息和深层信息通过叠加融合的方式进行互补偿,并利用多尺度特征融合方法将不同分辨率的特征进行通道合并,以实现不同分辨率信息之间的互补偿。

3 实验 3.1 实验数据集为进一步验证基于梅尔频谱分离和LSCNet的声学场景分类方法的有效性,利用城市声音标准数据集Urbansound8K[16]和环境音频数据集ESC-50[17]开展声学场景分类研究。其中,Urbansound8K数据集包含8 732个长度不同的音频样本,共分为10个类别。ESC-50数据集包含2 000个长度均为5 s的音频样本,共分为50个类别(每个类别包含40个样本)。

3.2 网络框架与参数配置实验中根据特征图的尺寸分别搭建了3组参数不同的网络模型,网络模型参数见表 2。参数配置为:训练时,设置批处理尺寸(batch-size)为40时模型分类效果最优,采用Adam为优化器,设置初始学习率为0.01,且训练轮次(epoch)设置为300时,模型的收敛效果最佳。

| 表 2 网络模型参数 Tab. 2 Parameters of network models |

模型训练的过程中,模型深度会对其提取特征的能力产生影响,从而在一定程度上影响模型的分类准确率。为探究最佳网络深度,并比较LSCNet与已有自校正网络(self-calibration network,SCNet)的分类性能,构建了表 2中LSCNet-13、LSCNet-19和LSCNet-25网络模型,设置了相同层数的SCNet-13、SCNet-19和SCNet-25模型作为对照组;采用梅尔频谱特征并基于Urbansound8K数据集开展声学场景分类实验,具体实验结果见表 3。

| 表 3 不同深度模型的分类准确率对比 Tab. 3 Classification accuracy comparison of different deep models |

由表 3可知: 1)相较于相同层数的SCNet模型,LSCNet-13、LSCNet-19和LSCNet-25模型的分类准确率分别提高了1.7%、1.8%和1.3%;2)当设置19层卷积层时,LSCNet模型取得最高的分类准确率为88.6%,故当设置3组卷积组时,模型的分类性能最优。

3.3.2 特征分离对比实验为验证梅尔频谱分离方法相较于频谱分离方法能针对性地减少背景噪音的影响并提高模型的分类准确率,采用7种特征作为输入特征图,并采用LSCNet-19作为训练模型,分别基于Urbansound8K数据集和ESC-50数据集开展实验,实验结果见表 4。

| 表 4 不同特征的分类准确率对比 Tab. 4 Classification accuracy comparison of different features |

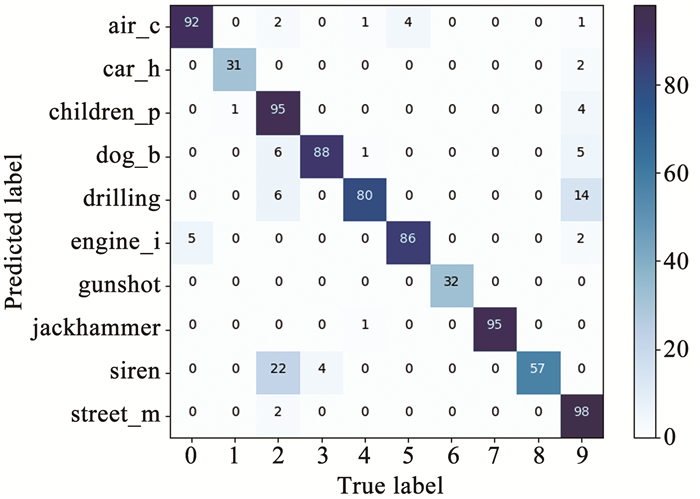

由表 4、图 5、6可得出以下结论:1)相较于频谱,利用梅尔频谱输入LSCNet-19模型进行训练时,模型的分类准确率在Urbansound8K和ESC-50数据集上分别提高了2.9%和1.1%;2)相较于频谱,将频谱分离后得到的CSH和CSP输入模型进行训练时,模型的分类准确率在Urbansound8K数据集上分别降低了2.4%和1.4%,在ESC-50数据集上分别降低了5.4%和2.3%;3)相较于梅尔频谱,将梅尔频谱分离后得到的CMSH、CMSP和CMSR输入模型进行训练时,模型的分类准确率在Urbansound8K数据集上分别提高了0.8%、1.4%和1.5%,在ESC-50数据集上分别提高了2.7%、1.7%和4.7%;4)相较于频谱分离后得到的CSH和CSP,将梅尔频谱分离后得到的CMSH、CMSP、和CMSR输入模型进行训练时,模型的分类准确率在两个数据集上平均提高了5.7%和7.9%;5)相较于其他声学特征,CMSR在含背景噪音较多的空调、儿童玩耍和街头音乐等多个类别的子分类准确率达到最高,进一步验证了其可以针对性地减少背景噪音的影响。

|

图 5 不同特征的子分类准确率雷达图 Fig. 5 Sub-classification accuracy radar chart of different features |

|

图 6 CMSR准确率为90.1%的混淆矩阵 Fig. 6 Confusion matrix of CMSR with 90.1% accuracy |

上述结论也进一步验证了梅尔频谱分离方法相较于频谱分离方法得到的特征具有良好的分类性能,且CMSR特征能够针对性地减少背景噪音对模型分类性能的影响,具有最优的分类性能。

3.3.3 分类准确率对比实验为了验证基于梅尔频谱分离和LSCNet的声学场景分类方法的有效性,基于Urbansound8K和ESC-50数据集开展了声学场景分类实验,并与已有声学场景分类模型进行比较,具体结果见表 5。

| 表 5 不同声学场景分类模型的准确率对比 Tab. 5 Accuracy comparison of different acoustic scene classification models |

由表 5可得出以下结论:1)利用CMSR特征输入LSCNet-19网络模型,模型的分类准确率在两个数据集下分别达到了90.1%和88.0%;2)相较于基线系统,本文提出的LSCNet-19模型在CMSR特征下,基于ESC-50数据集的分类准确率提高了35.7%;3)相较于文献[6-8]提出的系统,基于ESC-50数据集,本文提出的LSCNet-19模型在CMSR特征下分类准确率分别提高了4.1%、1.5%和2.4%;4)相较于文献[6, 8]提出的系统,基于Urbansound8K数据集,本文提出的LSCNet-19模型在CMSR特征下分类准确率分别提高了6.4%和0.8%;5)相较于文献[6-8]提出的系统,本文模型包含的参数量较少,即模型的复杂度较低。

综合实验结果表明:1)相较于频谱分离方法,梅尔频谱分离方法分离出的CMSR特征能够针对性地减少背景噪音的影响,从而提高模型的分类准确率;2)本文提出的LSCNet既实现了对特征图中频域信息的关注,又将模型训练中采集到的浅层特征信息和深层特征信息相互补偿,使模型具有良好的分类性能。

4 结论通过对Urbansound8K和ESC-50数据集开展声学场景分类实验与分析,得出主要结论:

1) 相较于频谱分离后得到的CSH和CSP,将梅尔频谱分离后得到的CMSH、CMSP、和CMSR输入模型进行训练时,模型的分类准确率在两个数据集上平均提高了5.7%和7.9%;且CMSR在含背景噪音较多的空调、儿童玩耍和街头音乐等多个类别的子分类准确率达到最高,验证了其可以针对性地减少背景噪音的影响。

2) 相较于自校正网络,LSCNet实现了对特征图中频域信息的关注,在Urbansound8K数据集下,模型准确率平均提升了1.6%,且当模型层数设置为19时分类效果达到最佳,LSCNet-19在两个数据集下的准确率分别达到90.1%和88%,进一步验证了该方法的有效性。

3) 相较于文献[6-8]提出的系统,基于ESC-50数据集,本文提出的LSCNet-19模型在CMSR特征下分类准确率分别提高了4.1%、1.5%和2.4%,相较于文献[6, 8]提出的系统,基于Urbansound8K数据集,本文提出的LSCNet-19模型在CMSR特征下分类准确率分别提高了6.4%和0.8%,且模型的复杂度更低。

| [1] |

易江燕, 陶建华, 刘斌, 等. 基于迁移学习的噪音鲁棒语音识别声学建模[J]. 清华大学学报, 2018, 58(1): 56. YI Jiangyan, TAO Jianhua, LIU Bin, et al. Transfer learning for acoustic modeling of noise robust speech recognition[J]. Journal of Tsinghua University, 2018, 58(1): 56. DOI:10.16511/j.cnki.qhdxxb.2018.21.001 |

| [2] |

刘亚荣, 黄昕哲, 谢晓兰, 等. 美尔谱系数与卷积神经网络相组合的环境声音识别方法[J]. 信号处理, 2020, 36(6): 1022. LIU Yarong, HUANG Xinzhe, XIE Xiaolan, et al. Environmental sound recognition method combining Meir spectral coefficients and convolutional neural network[J]. Journal of Signal Processing, 2020, 36(6): 1022. DOI:10.16798/j.issn.1003-0530.2020.06.025 |

| [3] |

赵薇, 靳聪, 涂中文, 等. 基于多特征融合的SVM声学场景分类算法研究[J]. 北京理工大学学报, 2020, 40(1): 70. ZHAO Wei, JIN Cong, TU Zhongwen, et al. Support vector machine for acoustic scene classification algorithm research based on multi-features fusion[J]. Transactions of Beijing Institute of Technology, 2020, 40(1): 70. DOI:10.15918/j.tbit1001-0645.2018.171 |

| [4] |

张科, 苏雨, 王靖宇, 等. 基于融合特征以及卷积神经网络的环境声音分类系统研究[J]. 西北工业大学学报, 2020, 38(1): 164. ZHANG Ke, SU Yu, WANG Jingyu, et al. Environment sound classification system based on hybrid feature and convolutional neural network[J]. Journal of Northwestern Polytechnical University, 2020, 38(1): 164. DOI:10.1051/jnw-pu/20203810162 |

| [5] |

CAO G, AKBAS C E, CETIN A E. Recognition of vessel acoustic signatures using non-linear teager energy based features[C]//2016 International Workshop on Computational Intelligence for Multimedia Understanding. Reggio Calabria: IEEE, 2016: 2. DOI: 10.1109/IWCIM.2016.7801190

|

| [6] |

ZHANG Zhichao, XU Shugong, CAO Shan, et al. Deep convolutional neural network with mixup for environmental sound classification[C]//Chinese Conference on Pattern Recognition and Computer Vision (PRCV). Guangzhou: Springer, 2018: 362. DOI: 10.1007/978-3-030-03335-431

|

| [7] |

ZHANG Zhichao, XU Shugong, ZHANG Shunqing, et al. Learning attentive representations for environmental sound classification[J]. IEEE Access, 2019(7): 130337. DOI:10.1109/ACCESS.2019.2939495 |

| [8] |

SU Yu, ZHANG Ke, WANG Jingyu, et al. Performance analysis of multiple aggregated acoustic features for environment sound classification[J]. Applied Acoustics, 2020, 158: 107050. DOI:10.1016/j.apacoust.2019.107050 |

| [9] |

FITZGERALD D. Harmonic/Percussive separation using median filtering[C]//13th International Conference on Digital Audio Effects (DAFX10). Graz: [s. n. ], 2010

|

| [10] |

VIRTANEN T, PLUMBLEY M D, ELLIS D. Computational analysis of sound scenes and events[M]. [S. l. ]: Springer, 2018: 77

|

| [11] |

程艳芬, 陈垚鑫, 陈逸灵, 等. 嵌入注意力机制并结合层级上下文的语音情感识别[J]. 哈尔滨工业大学学报, 2019, 51(11): 100. CHENG Yanfen, CHEN Yaoxin, CHEN Yiling, et al. Speech emotion recognition with embedded attention mechanism and hierarchical context[J]. Journal of Harbin Institute of Technology, 2019, 51(11): 100. DOI:10.11918/j.issn.0367-6234.201905193 |

| [12] |

HUANG Zilong, LIU Chen, FEI Hongbo, et al. Urbansound classification based on 2-order dense convolutional network using dual features[J]. Applied Acoustics, 2020, 164: 107243. DOI:10.1016/j.apacoust.2020.107243 |

| [13] |

PHAYE S S R, BETENYOS E, WANG Ye. SubSpectralNet-using sub-spectrogram based convolutional neural networks for acoustic scene classification[C]//ICASSP 2019-2019 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Brighton: IEEE, 2019: 828. DOI: 10.1109/ICASSP.2019.8683288

|

| [14] |

LIU Jiangjiang, HOU Qibin, CHENG Mingming, et al. Improving convolutional networks with self-calibrated convolutions[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020: 10096. DOI: 10.1109/CVPR42600.2020.01011

|

| [15] |

YANG Liping, TAO Lianjie, CHEN Xinxing, et al. Multi-scale semantic feature fusion and data augmentation for acoustic scene classification[J]. Applied Acoustics, 2020, 163: 107238. DOI:10.1016/j.apacoust.2020.107238 |

| [16] |

SALAMON J, JACOBY C, BELLO J P. A dataset and taxonomy for urban sound research[C]//Proceedings of the 22nd ACM International Conference on Multimedia. Orlando: Association for Computing Machinery, 2014: 1043. DOI: 10.1145/2647868.2655045

|

| [17] |

PICZAK K J. ESC: Dataset for environmental sound classification[C]//Proceedings of the 23rd ACM International Conference on Multimedia. New York: Association for Computing Machinery, 2015: 1015. DOI: 10.1145/2733373.2806390

|

2022, Vol. 54

2022, Vol. 54